引言

对于这种案例,你们的处理思路是怎么样的呢,是否真正的处理过,如果遇到,你们应该怎么处理。

我想大多数人都没有遇到过。

最后有相关的学习群,有兴趣可以加入。

开始

引言:监控盲区的“隐形危机”

想象一下,深夜接到紧急告警电话,却发现故障服务竟从未被监控覆盖;或在数百条“狼来了”的无效告警中,漏掉了真正致命的警报。

监控盲区如同黑暗森林中的陷阱,轻则延长故障恢复时间,重则导致业务雪崩。本文将揭示监控盲区的典型现象,并提供一套 “精准观测 + 智能降噪” 的解决方案,让系统的每一处角落都沐浴在可观测性的阳光下。

一、监控盲区的典型现象与影响

1. 关键服务无监控指标:黑暗中的“沉默杀手”

• 现象描述:

新上线微服务未配置监控,故障时只能靠用户投诉发现。

第三方依赖(如支付网关)的可用性未被追踪,连环故障后无从定位。

• 真实案例:某电商平台的推荐服务因 Redis 连接池耗尽崩溃,但未监控连接数指标,导致 2 小时后才从日志中发现问题,损失千万级订单。

2. 警报疲劳:当“狼来了”成为日常

• 现象描述:

每天收到数百条“CPU 使用率 85%”的告警,但实际均为短暂峰值,无实质影响。

关键告警(如数据库主从延迟 >30s)被淹没在噪音中,运维团队逐渐麻木。

• 真实代价:某金融公司因忽略一条“证书 7 天后过期”的告警(混在 200 条其他告警中),导致全站 HTTPS 服务中断 4 小时。

二、精准观测:用 SLO 点亮黑暗角落

1. 定义 SLO(Service Level Objectives)

SLO 是服务的“健康体检表”,需聚焦业务核心指标。

示例:电商订单服务的 SLO

指标 | 目标 | 监控方式 |

订单创建 API 成功率 | 99.9% (滚动窗口 28 天) | Prometheus 采集 HTTP 状态码 |

支付网关延迟 | P99 < 1s | Istio 采集服务间调用延迟 |

库存缓存命中率 | > 95% | Redis 导出器监控 keyspace 命中率 |

SLO 声明代码示例(OpenSLO 格式)

2. 基于 SLO 配置精准告警

Prometheus Alertmanager 规则示例

告警分级策略

级别 | 触发条件 | 通知方式 |

P0(紧急) | SLO 违反且影响核心业务流程 | 电话 + 短信 + 邮件 |

P1(高) | SLO 违反但可自动恢复 | 邮件 + 钉钉 |

P2(中) | 潜在风险(如容量预测不足) | 邮件 |

三、细粒度观测:Service Mesh 的“显微镜”

1. 使用 Istio 采集黄金指标

Istio 的 Sidecar 代理(Envoy)天生具备观测能力,可自动采集四大黄金指标:

• 流量(Traffic):请求量、错误率

• 延迟(Latency):P50/P90/P99 延迟

• 错误(Errors):4xx/5xx 状态码分布

• 饱和度(Saturation):资源利用率(CPU、内存、连接池)

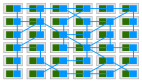

2. 追踪服务依赖拓扑

自动生成服务依赖地图,识别“沉默的依赖杀手”:

四、降噪实践:让告警回归“信号本质”

1. 告警聚合与抑制

• 场景:某节点宕机触发 50 条关联告警(Pod 状态、存储卷、网络等)。

• 方案:

2. 动态灵敏度调节

• 峰值时段:自动放宽阈值(如大促期间允许 CPU 使用率升至 90%)。

• 低峰时段:恢复严格检测(如夜间检测到 1 次失败登录即告警)。

示例:随时间变化的告警阈值

五、案例研究:从“盲区危机”到“全栈可观测”

1. 故障场景

某社交平台的私信服务突发大面积延迟,但未监控服务间 gRPC 调用状态,运维团队耗时 3 小时才定位到 Kafka 消费者组堆积问题。

2. 解决方案

• Step 1:通过 Istio 采集 gRPC 方法级指标(成功率、延迟)。

• Step 2:定义 SLO(私信发送 P99 延迟 < 2s)。

• Step 3:配置告警关联(Kafka 堆积 → 私信延迟 → 用户投诉)。

3. 成果

- • 故障平均恢复时间(MTTR)从 3 小时降至 15 分钟。

- • 无效告警减少 80%,团队信任度显著提升。

六、工具链推荐:构建观测驱动的 DevOps 文化

工具 | 用途 | 关键特性 |

Prometheus + Alertmanager | 指标采集与告警管理 | 灵活的查询语言、丰富的集成生态 |

Grafana | 可视化分析 | 模板化仪表板、多数据源支持 |

Istio + Kiali | 服务网格观测 | 自动生成拓扑图、协议级指标采集 |

OpenSLO | SLO 声明与管理 | 标准化 YAML 格式、多后端兼容 |

Cortex/SLOTH | SLO 计算与错误预算追踪 | 自动生成告警规则、可视化错误预算消耗 |

结语:观测不是终点,而是持续进化的起点

监控盲区的本质是系统复杂性与认知局限性的博弈。通过 SLO 聚焦业务核心、Service Mesh 穿透协议细节、智能告警过滤噪音,我们不仅能照亮黑暗角落,更能让监控体系从“成本中心”进化为“业务护航者”。

记住:每一次告警都应是一次精准的手术刀,而非无差别的噪音轰炸。