引言

对于这种案例,你们的处理思路是怎么样的呢,是否真正的处理过,如果遇到,你们应该怎么处理。

我想大多数人都没有遇到过。

开始

事故背景

某电商平台在2025年3月的一次常规滚动更新中,触发了一场持续2小时的全集群雪崩事故。核心交易服务的API成功率从99.99%骤降至63%,直接导致数百万美元的经济损失。事故根源最终锁定在一个看似“优雅”的preStop钩子配置上。这场事故暴露了Kubernetes生命周期管理的深层风险,本文将深度解析其技术细节和修复方案。

一、故障现象:从平静到雪崩的全链路崩塌

1. 初期异常信号

• Pod终止耗时异常

Pod从标记删除到完全终止的时间陡增16倍,但terminationGracePeriodSeconds仍保持30秒默认值,暗示存在资源争抢。

• 服务网格流量泄漏

服务网格未及时更新Endpoint,导致请求持续路由到已终止的Pod。

2. 雪崩级联反应

时间线推演

关键指标异变

指标 | 正常值 | 故障峰值 |

节点内存使用率 | 40%~60% | 95% |

etcd请求延迟 | 10ms~50ms | 1200ms |

kubelet PLEG健康检查失败率 | 0% | 82% |

服务网格503错误率 | 0.01% | 37% |

二、根因分析:preStop钩子的三重致命缺陷

1. 问题配置还原

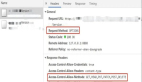

原始preStop钩子定义

2. 缺陷链式反应

缺陷1:服务注销的竞态条件

• 问题本质

服务注销(deregister)请求与Endpoint控制器存在时序竞争:

若步骤3在步骤2之前完成,deregister请求可能发往已下线的注册中心实例。

• 数学建模

假设注册中心集群有N个实例,单个实例处理请求的失败率为P,则整体失败风险:

当N=5且滚动更新期间M=3时,即使P=5%,整体失败率也会升至14.26%。

缺陷2:阻塞式连接检查

- 资源消耗分析

netstat命令在连接数较多时会产生显著开销:

- 在500个并发Terminating Pod的场景下,仅

netstat就会消耗:

• 雪崩放大器

当节点内存不足时,OOM Killer会优先杀死资源消耗大的进程,但preStop进程因属于静态Pod的一部分,受到kubelet保护,反而导致用户容器被优先终止,形成恶性循环。

缺陷3:无超时控制的死循环

• Grace Period机制失效

Kubernetes的优雅终止流程:

若preStop钩子未在terminationGracePeriodSeconds内退出,SIGTERM信号将无法发送,直接进入强制终止阶段,导致残留TCP连接。

三、生产级修复方案

1. preStop钩子安全改造

优化后的配置

关键改进点

- 超时分层控制将总grace period划分为:

- 防止单阶段操作耗尽所有时间预算。

- • 非阻塞式连接检测使用

ss替代netstat(性能提升50倍),结合inotifywait监听Kubernetes自动挂载的ServiceAccount令牌删除事件(Pod终止时自动触发),实现高效等待。

2. 集群参数调优

Kubelet关键参数

Pod级别配置

3. 动态grace period调整

基于负载的算法实现

四、防御体系构建

1. 静态配置校验

Datree策略规则示例

2. 运行时监控

eBPF追踪preStop执行

3. 混沌工程测试方案

故障注入场景

故障类型 | 注入方法 | 预期防御动作 |

注册中心超时 | 使用toxiproxy模拟500ms延迟 | preStage超时跳过,进入连接等待 |

节点内存压力 | stress-ng --vm 100% | 提前触发Pod驱逐 |

控制平面隔离 | iptables阻断kube-apiserver通信 | 本地缓存元数据支撑优雅终止 |

五、架构演进方向

1. 服务网格增强

Istio终止握手协议

解释下上面的配置文件:

• 这个 EnvoyFilter 配置的目的是为了在 Istio 环境中配置 Envoy 代理的 优雅关闭(graceful shutdown) 行为。当 Envoy 被关闭时,配置会确保:

等待现有连接处理完毕,最多等待 30 秒(drain_time)。

在关闭过程中,确保至少有 10 秒的时间来清理和结束未完成的工作(min_shutdown_duration)。

通过启用 tls_inspector 过滤器,确保 Envoy 能够正确地处理 TLS 加密的流量。

2. 面向终态的SLO框架

Pod终止SLO定义

解释下上面的配置文件:

• 这个 SLO 配置的目的是确保 Kubernetes 集群中的 Pod 在 终止 时能够满足以下目标:

99.99% 的 Pod 在 30 秒内完成终止。

六、事故启示录

1. Kubernetes生命周期管理的“不可能三角”

• 完备性:执行所有清理逻辑

• 时效性:严格遵循grace period

• 可靠性:确保操作原子性

现实选择需根据业务场景动态权衡,例如:

• 支付系统:偏向可靠性(容忍更长的grace period)

• 实时计算:偏向时效性(牺牲部分清理完整性)

2. 运维监控新范式

Pod终止黄金指标

指标名称 | 计算公式 | 告警阈值 |

Zombie Connection Rate | (残留连接数 / 总连接数) × 100% | > 1% |

Grace Period Utilization | 实际终止时间 / terminationGracePeriod | > 80% |

PreStop Failure Rate | 失败preStop次数 / 总Pod终止次数 | > 5% |

结语

此次事故揭示了云原生架构中一个深层矛盾:越是精心设计的优雅退出机制,越可能成为分布式系统的“沉默杀手”。解决方案需要从防御性编码、动态资源调度、可观测性增强三个维度协同发力。正如Kubernetes设计哲学所言:“不是避免故障,而是拥抱故障设计”,只有将故障场景视为常态,才能在云原生的复杂迷局中破茧而出。