在软件开发的快节奏世界里,效率与质量始终是开发者们追求的核心目标。单元测试作为保障代码质量的关键环节,却往往耗费开发者大量的时间与精力。近年来,随着人工智能技术的飞速发展,AI辅助编程工具如雨后春笋般涌现,其中GitHub Copilot以其强大的代码生成能力备受瞩目。那么,它在C#单元测试编写方面究竟表现如何?是否真能如传闻般颠覆我们对编程的认知?今天,就让我们通过一系列实战测评来一探究竟。

GitHub Copilot简介

GitHub Copilot是由OpenAI和GitHub联合开发的一款AI编程助手,它基于海量的代码数据进行训练,能够理解开发者输入的自然语言描述,并据此生成相应的代码。无论是函数定义、算法实现,还是复杂的逻辑结构,Copilot都能给出颇具参考价值的代码建议。其在各类编程语言中均有出色表现,尤其是在热门语言如C#的开发场景中,为开发者带来了全新的编程体验。

实战测评:C#单元测试编写

准备测试项目

为了全面评估GitHub Copilot在C#单元测试编写方面的能力,我们准备了一个具有代表性的C#项目。该项目包含多个类和方法,涵盖了常见的业务逻辑,如数据处理、算法运算以及对象操作等。例如,其中有一个用于计算数学表达式的类,包含加、减、乘、除等基本运算方法;还有一个处理用户信息的类,涉及信息的验证、存储和检索等操作。这些类和方法为我们测试Copilot生成单元测试的能力提供了丰富的场景。

生成单元测试用例

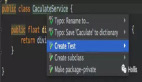

在Visual Studio中安装好GitHub Copilot插件后,我们开始尝试利用它生成单元测试。以计算数学表达式类中的加法方法为例,我们在测试文件中输入自然语言描述:“Write a unit test for the Add method in the MathCalculator class that takes two integers and returns their sum.” 几乎瞬间,Copilot便给出了如下代码建议:

可以看到,Copilot准确地理解了需求,生成了一个完整且结构合理的单元测试方法。它不仅创建了测试类和测试方法,并按照标准的单元测试结构(Arrange - Act - Assert)进行了代码组织,还正确地实例化了被测试类,设置了测试数据,并使用断言验证了方法的返回值。

复杂场景测试

接下来,我们挑战一个更复杂的场景,测试用户信息处理类中的用户信息验证方法。该方法需要验证用户输入的姓名、邮箱和密码是否符合特定格式要求,并且密码强度要达到一定标准。我们输入描述:“Generate unit tests for the ValidateUserInfo method in the UserInfoProcessor class considering all possible validation scenarios including valid and invalid inputs.” Copilot生成的代码涵盖了多种测试用例,包括有效输入的验证、姓名格式错误、邮箱格式错误、密码强度不足等情况,代码如下:

Copilot能够根据方法的功能和常见的验证场景,自动生成多个测试用例,全面覆盖了可能出现的情况,极大地节省了开发者手动编写测试用例的时间和精力。

代码生成效率对比

为了更直观地感受GitHub Copilot在生成C#单元测试代码方面的效率提升,我们进行了一组对比实验。选取了项目中的10个具有代表性的方法,分别由开发者手动编写单元测试和使用GitHub Copilot生成测试代码,并记录所需时间。 手动编写单元测试时,开发者需要仔细分析每个方法的功能、输入输出参数以及可能的边界情况,然后按照测试框架的规范编写测试代码。平均每个方法的测试编写时间约为15分钟,10个方法共耗时150分钟。 而使用GitHub Copilot时,输入需求描述后,平均每个方法在1 - 2分钟内就能得到完整的测试代码建议,经过简单检查和微调(主要是针对一些特殊情况或个人习惯的调整),即可完成测试编写。10个方法总共花费时间约为20分钟,效率提升了近7倍。

从代码行数来看,手动编写的测试代码平均每个方法约为30 - 50行,而Copilot生成的代码在保证功能完整性的前提下,行数相对精简,平均每个方法约为20 - 40行。这不仅减少了代码量,也降低了维护成本。

优势与不足

优势

- 高效快速:GitHub Copilot能够在短时间内生成大量高质量的单元测试代码,大大提高了开发效率,使开发者能够将更多时间投入到核心业务逻辑的开发和优化中。

- 覆盖全面:对于复杂的方法,Copilot能够自动分析可能的输入输出情况,生成全面的测试用例,避免了人工编写时可能出现的测试遗漏,有助于提高代码的可靠性和稳定性。

- 规范标准:生成的单元测试代码遵循常见的测试框架规范和最佳实践,结构清晰,可读性强,为团队开发提供了统一的测试代码风格,降低了代码审查的难度。

不足

- 理解局限性:虽然Copilot在大多数情况下能够准确理解自然语言描述,但对于一些模糊或复杂的需求,可能会生成不符合预期的代码。例如,当需求描述中涉及多个相互关联的复杂业务规则时,Copilot可能无法完全把握其逻辑关系,导致生成的测试代码不准确。

- 缺乏业务深度:对于一些涉及特定业务领域知识的方法,Copilot生成的测试代码可能只关注了方法的表面功能,而无法深入考虑业务场景中的特殊情况和潜在风险。例如,在一个金融业务系统中,对于计算利息的方法,Copilot可能无法考虑到不同利率政策、计息周期等业务细节,需要开发者进一步完善测试代码。

总结与展望

通过本次对GitHub Copilot在C#单元测试编写方面的实战测评,我们深刻感受到了AI编程工具为软件开发带来的巨大变革。它在提高代码生成效率、保障测试覆盖全面性等方面表现出色,无疑是开发者在单元测试工作中的得力助手。然而,我们也应清醒地认识到其存在的不足,在实际应用中需要开发者结合自身的专业知识和业务理解,对Copilot生成的代码进行审查和完善。

展望未来,随着人工智能技术的不断发展和完善,我们有理由相信像GitHub Copilot这样的AI编程工具将在软件开发领域发挥更为重要的作用。它们将不断突破现有的局限性,更加深入地理解开发者的需求和业务逻辑,为软件开发的各个环节提供更强大、更智能的支持,助力开发者打造出更高质量、更高效的软件产品。