译者 | 李睿

审校 | 重楼

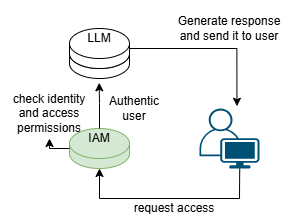

在人工智能时代,大型语言模型(LLM)的应用正在迅速增长。这些模型提供了大量的机会,但同时也带来了新的隐私和安全挑战。应对这些挑战的基本安全措施之一是保护对LLM的访问,以确保只有经过授权的人员才能访问数据和执行任何操作的权限。这可以通过身份和访问管理(IAM)来实现。

身份和访问管理(IAM)就像关键数据和系统的安全卫士。这种方法就像大厦的保安,可以决定谁可以进入,谁又能访问安全摄像头等敏感区域。当某人试图进入大厦时,保安会仔细询问其身份、住址等详细信息。一旦发现任何可疑行为,保安便会密切关注他在大厦内外的一举一动。同样,IAM确保只有经过授权的个人才能进入和访问大型语言模型。IAM还保存用户活动日志,以识别可疑行为。

那IAM是大型语言模型安全问题的解决方案吗?本文将探讨IAM在保护LLM方面的作用,但首先需要了解LLM是什么以及它们的用途。

语言建模

学习一门新语言并非易事。人类必须学习词汇、语法规则和表达,才能完全学习一门语言。然而,对于机器来说,学习一门新语言并不难,只要给机器提供大量正确的文本数据。通过这些数据,机器可以学习语言的语法规则以及词汇和表达方式。

教授机器一门语言被称为语言建模。语言建模主要有两种类型:

- 统计语言模型。这些模型是基于概率和统计进行训练的。在大型数据集中,他们观察单词的模式以及它们如何做出预测。

- 神经语言模型。这些模型使用人工神经连接(像人类大脑一样)来学习一门新语言。他们不仅要学习单词和句型,还学习整个句子的表达方式和含义。

神经语言模型还可以细分为多个其他类别,其中一个被称为基于Transformer的模型或简称为Transformer模型。这些模型非常擅长理解人类语言,因为它们不是逐字处理信息,而是使用并行处理,这使得处理速度更快。当处理句子时,这些系统可以理解表达并使用并行处理。它们最适合用于机器翻译、理解查询和生成响应。

什么是LLM?

LLM基于Transformer神经语言模型。LLM是一种在大型数据集上训练的人工智能,因此它可以理解人类语言(自然语言处理)并根据查询(问答)生成响应。如今,人们不仅将大型语言模型用于研究目的,还将其用于日常任务。LLM最著名的例子是聊天生成预训练转换器(ChatGPT)。

LLM是如何工作的?

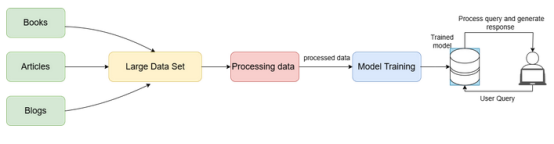

来自书籍、文章和研究论文等来源的数据被收集成一个大型数据集。然后将这些数据集处理成精细数据。LLM在这些数据集上进行训练,并通过观察语法、含义等来学习人类互动。

一旦对LLM进行了训练,就可以将其作为服务嵌入,以处理用户查询并生成适当的响应。这些用户交互产生更多的数据,这些数据用于进一步训练模型,以获得更好和增强的语言模型。

LLM的安全风险

LLM的工作方式与其他产品或服务不同,因此面临不同的安全挑战。以下讨论LLM面临的一些安全风险:

- 命令注入。这也被称为提示黑客攻击或输入操纵。由于LLM是在包含敏感信息的大型数据集上训练的,攻击者可以操纵输入以获取敏感信息或获得未经授权的访问。

- 数据损坏。因为LLM在数据集上进行训练,如果攻击者破坏了这些数据集中的数据,他们可能会导致模型为用户输入生成不准确的响应。

- 服务中断。攻击者可以通过提交一个非常复杂的输入来使用模型的大部分资源,从而使服务对其他用户不可用或速度变慢。这可能会给合法用户带来糟糕的用户体验。这也称为拒绝服务,因为LLM将拒绝为实际用户提供服务。

- 易受攻击的插件结构。LLM使用第三方插件,使其容易受到数据泄露或通过这些插件远程运行的恶意代码等风险的影响。

- 知识产权盗窃。当有人未经授权访问LLM的专有信息时,他们可以窃取数据集以及新的用户输入和算法。然后,他们可以使用这些来创建自己的模型,从而访问其他敏感信息。

以上这些是LLM面临的一些关键安全风险。现在讨论如何使用IAM来降低这些风险。

IAM在保护LLM安全中的作用

想象一下,一个家庭将食谱秘方记录在一本日记本中,为了确保只有家庭成员或亲朋好友能够查看,他们为日记本配备了一把锁,并为每位成员提供了一把独一无二的钥匙。这样,这些食谱秘方就得到了妥善保护,只有持有唯一钥匙并经过认证的人员才有权查阅这本日记。

IAM对数字数据起着同样的作用。它为受信任的用户分配一个身份,并且只允许这些用户进行访问,它允许系统保证数据的安全。

以下深入地了解一下身份和访问管理在LLM中的含义:

- 身份管理。这有助于系统通过创建帐户、分配唯一的用户名和密码以及添加其他个人数据来建立个人身份,以便在整个系统中进行跟踪。它还可以在需要时删除帐户。

- 访问管理。在每个系统中,都有多种类型的用户。并非所有用户都可以访问所有资源。访问管理有助于验证用户身份以及所述用户是否对其试图访问的资源具有访问权限。这保证了只有授权用户才能访问敏感信息并执行特定操作。

确保LLM的安全

以上讨论了LLM所面临的各种安全风险。当IAM在LLM的安全策略中实现时,它有助于最大限度地降低这些安全风险。这些风险可以通过以下方式得到解决:

- 通过身份检查:当用户请求使用LLM时,IAM检查用户是否可信。它可以使用多种方法来检查,例如生物识别或多因素身份验证。

- 通过提供访问控制:当用户尝试访问资源或执行操作时,IAM将检查该用户是否具有访问资源或执行特定操作的权限。IAM还可以根据用户的角色分配权限。例如,管理员将拥有比普通用户或访客更多的访问权限。

- 观察和发现:IAM记录用户访问的内容以及访问任何资源的时间。然后分析这些记录,发现并报告任何可疑活动。

IAM框架与LLM的工作流程

IAM框架与LLM的工作流程

- 部署挑战。在系统中部署IAM并不总是那么容易。对于没有多余资源的系统尤其如此,因为IAM可能会消耗大量资源,并且可能很耗时。

- 用户体验。用户体验对于任何基于用户的产品都是至关重要的。IAM将添加额外的步骤来标识用户,这有时会加重某些用户的负担。

- 成本高昂。使用IAM可能成本高昂,因为它需要额外的技术(软件或硬件)和训练。它还需要维护才能有效工作,这可能很耗时。

- 技术挑战。用户可能需要一些时间来适应新的身份识别系统。与已经工作的系统的集成也可能是棘手的。

IAM可以保护LLM。IAM确保只有经过授权的人员才能访问和使用这些模型。这一安全策略和其他安全策略是安全和负责任地使用人工智能技术的必要条件。如果成功实施,这些策略将促进这些创新LLM的安全有效使用。

原文标题:Identity and Access Management Solution to Safeguard LLMs,作者:Anant Wairagade