译者 | 核子可乐

审校 | 重楼

随着AI与机器学习的发展,银行欺诈检测能力也迎来了显著进步。然而,欺诈判决的可解释性仍是一大现实难题——即怎样证明某笔交易因何被标记为欺诈?

本文将探讨DeepSeek AI如何通过以下方式增强欺诈预防能力:

- 使用深度学习模型进行AI驱动的欺诈检测

- 使用SHAP与LIME实现AI可解释性

- 使用Streamlit与Tableau建立实时仪表板

- 欺诈检测模型比较

- 流程图、图表与可视化技术

银行欺诈检测:AI为何意义重大?

银行欺诈可分为:

- 信用卡欺诈:使用被盗或复制的卡进行未授权交易。

- 账户接管欺诈:网络犯罪分子控制客户账户。

- 合成身份欺诈:使用真假凭证创建的虚假身份。

交易欺诈:洗钱、未授权电汇或非法消费。

传统欺诈检测面临的挑战

- 误报率高:很多合法交易被错误标记为欺诈。

- 欺诈模式不断演变:欺诈者会不断调整策略。

- 缺乏透明度:黑盒AI模型导致欺诈决策难以解释。

为了解决这些问题,DeepSeek AI将深度学习模型与可解释性技术相结合,以更好地检测欺诈。

欺诈检测模型的实现

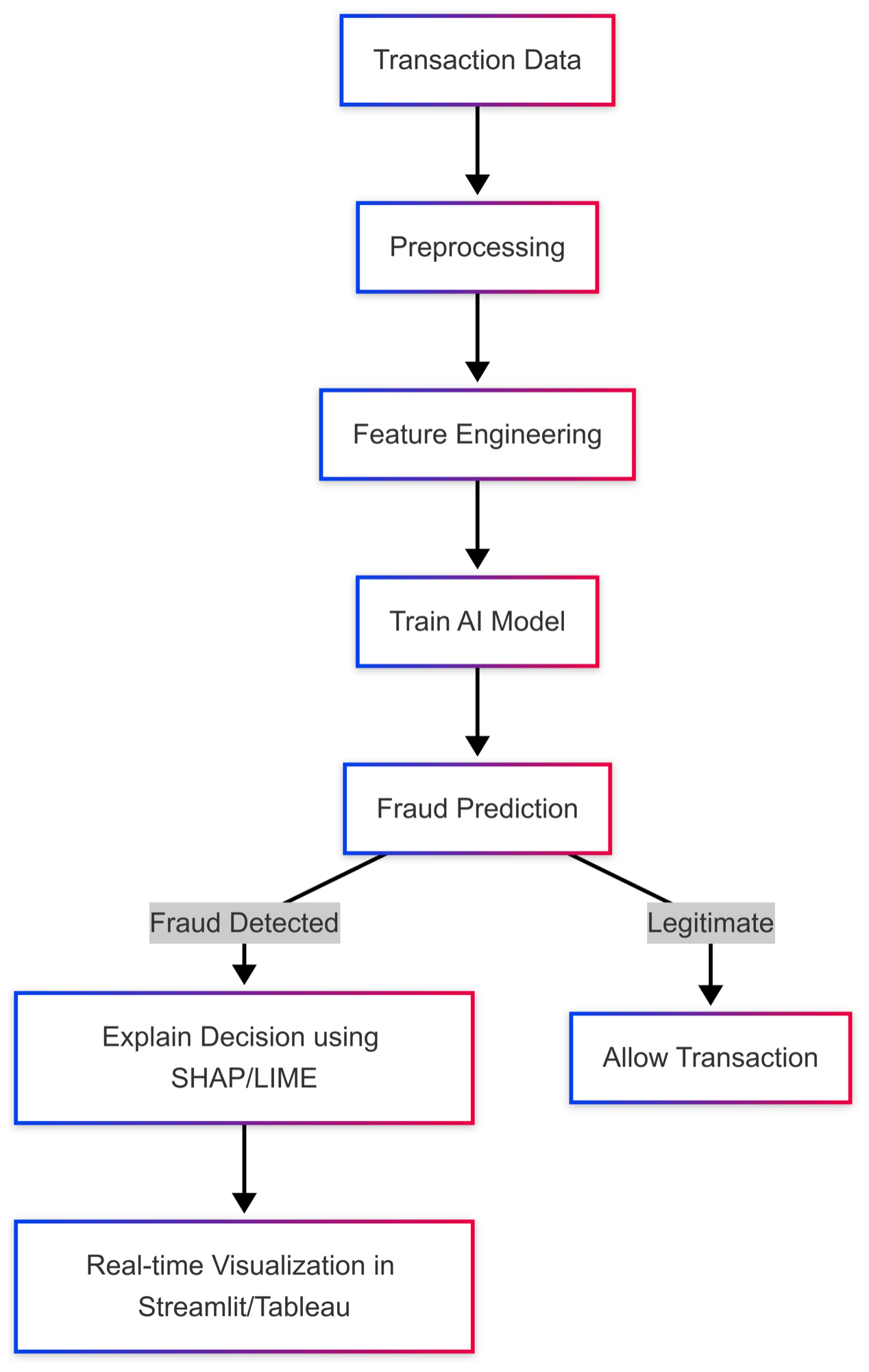

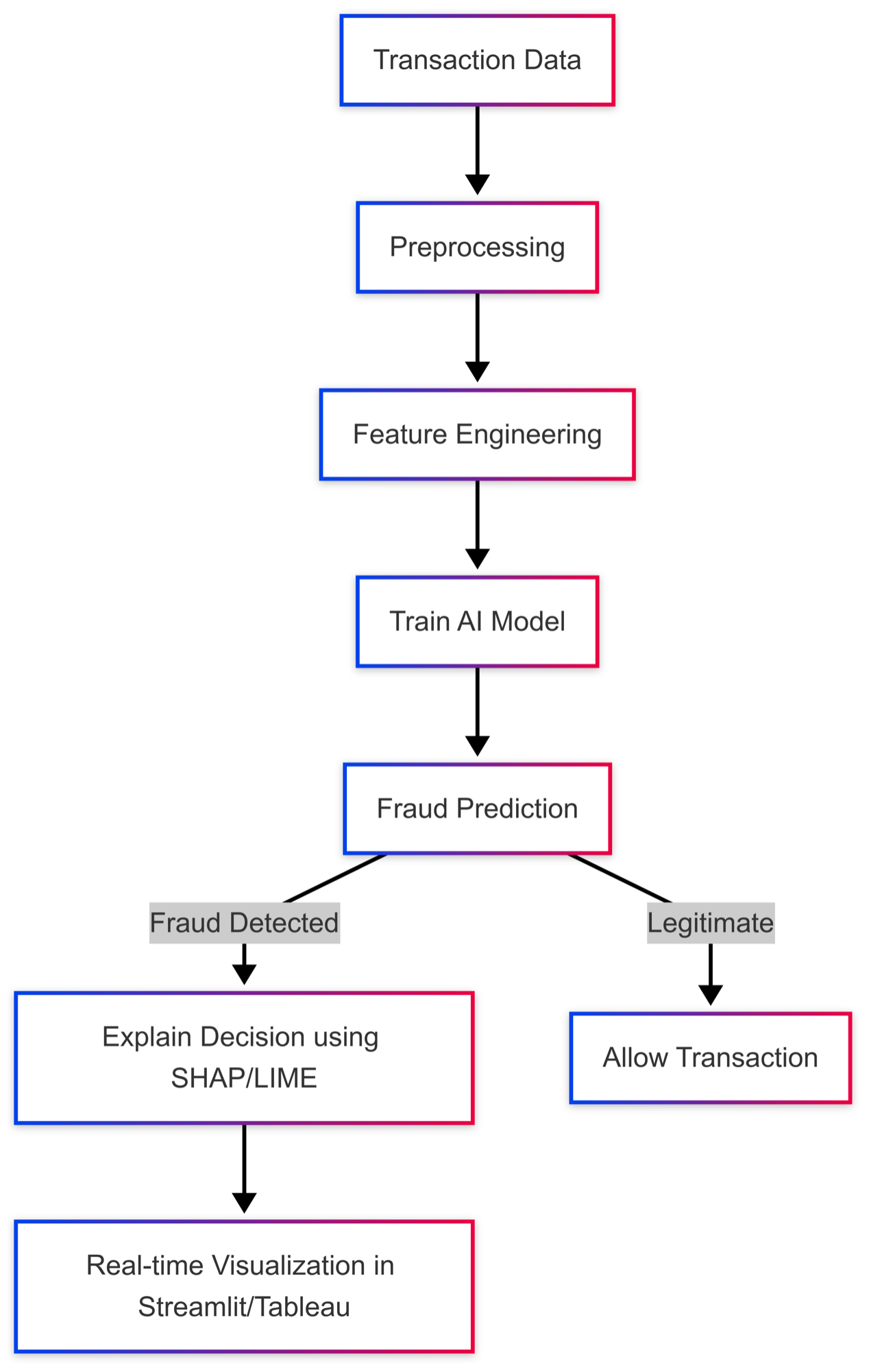

典型的欺诈检测流程遵循以下步骤:

欺诈检测工作流程

- 步骤1:数据收集(银行交易)

- 步骤2:数据预处理(清洗与特征工程)

- 步骤3:训练深度学习模型(Autoencoders、XGBoost)

- 步骤4:模型评估(准确率、精度、召回率)

- 步骤5:AI可解释性(SHAP、LIME)

- 步骤6:实时监控(Streamlit与Tableau)

欺诈检测流程图

欺诈决策的AI可解释性

欺诈检测的一大挑战,在于确切把握交易被标记为欺诈的原因。

解决方案:使用SHAP(Shapley附加解释)与LIME(模型中立的本地可解释说明)。

SHAP对欺诈检测的解释

SHAP可帮助确定哪些交易特征对欺诈决策贡献最大。

import shap

# Initialize SHAP explainer

explainer = shap.Explainer(model, X_train)

# Compute SHAP values

shap_values = explainer(X_test)

# Plot SHAP summary

shap.summary_plot(shap_values, X_test)SHAP摘要图

在选择可视化交易属性(如金额、频率、位置)时,选择对欺诈检测结果影响最大的条目。

LIME提供局部可解释性说明

LIME能够为单一欺诈预测提供解释。

from lime.lime_tabular import LimeTabularExplainer

# Initialize LIME explainer

explainer = LimeTabularExplainer(X_train, feature_names=["Amount", "V1", "V2"], mode='classification')

# Explain a specific transaction

exp = explainer.explain_instance(X_test[0], model.predict)

# Display explanation

exp.show_in_notebook()LIME说明

细分哪些特征影响到特定的欺诈决策。

流程图:AI欺诈检测的可解释性

实时欺诈仪表板(Streamlit与Tableau)

为实时监控欺诈,我们使用Streamlit与Tableau构建仪表板。

Streamlit欺诈监控仪表板

- 上传银行交易

- 查看标记的欺诈交易

- 可视化基于SHAP的欺诈解释

Python实现(Streamlit仪表板)

import streamlit as st

import pandas as pd

import shap

import joblib

# Load fraud model & SHAP explainer

model = joblib.load("fraud_model.pkl")

explainer = shap.Explainer(model)

# Streamlit UI

st.title("Real-Time Fraud Detection Dashboard")

uploaded_file = st.file_uploader("Upload Transactions (CSV)", type=["csv"])

if uploaded_file:

df = pd.read_csv(uploaded_file)

st.dataframe(df.head())

# Fraud detection

predictions = model.predict(df)

df["Fraud Prediction"] = predictions

# Display fraud cases

st.subheader("Fraudulent Transactions:")

st.dataframe(df[df["Fraud Prediction"] == 1])

# SHAP Explanation

fraud_case = df[df["Fraud Prediction"] == 1].iloc[0:1]

shap_values = explainer(fraud_case)

st.subheader("SHAP Explanation:")

shap.waterfall_plot(shap.Explanation(values=shap_values.values[0],

base_values=shap_values.base_values[0]))比较各欺诈检测模型

模型 | 准确性 | 精确度 | 召回率 | 可解释性 |

自动编码器 (深度学习) | 95% | 88% | 92% | 低 |

随机森林 | 91% | 85% | 89% | 中 |

XGBoost | 93% | 90% | 94% | 高(支持SHAP) |

最佳模型:配合SHAP欺诈检测可解释性的XGBoost。

总结:AI欺诈预防的未来

随着数字银行与在线交易的兴起,欺诈检测必须不断发展才能始终领先于欺诈者。传统基于规则的系统已不再可靠,AI驱动的欺诈检测讲成为新的、最强大的解决方案。

要点回顾

- AI欺诈检测能够显著提高准确性并减少误报。

- 使用SHAP与LIME的AI可解释性机制,有助于增强欺诈决策的透明度与信任度。

- 实时仪表板(Streamlit与Tableau)为欺诈预防团队提供可操作见解。

- 比较不同模型可帮助组织根据准确性、召回率和可解释性选择最佳方案。

探索方向

- 使用Kafka与Spark Streaming实现实时欺诈警报。

- 图神经网络(GNN)检测复杂欺诈模式。

- 强化学习自适应改进欺诈检测能力。

银行机构可集成DeepSeek AI、可解释AI(XAI)与实时仪表板,建立起更透明、更准确且更具动态性的欺诈检测系统。

原文标题:Banking Fraud Prevention With DeepSeek AI and AI Explainability,作者:Swapnil Patil