阿里巴巴的Qwen团队近日正式推出了其最新研究成果——QwQ-32B大语言模型。这款模型拥有320亿参数,却能在性能上与拥有6710亿参数的DeepSeek R1相媲美,展现出极高的效率和优化能力。

QwQ-32B的核心优势在于其通过强化学习实现了性能的显著提升,仅用DeepSeek R1约1/21的参数量便达到了类似的推理能力。此外,阿里还在模型中集成了与Agent相关的能力,使其能够进行批判性思考,并根据环境反馈动态调整推理过程。这种能力使得QwQ-32B不仅是一个语言模型,更是一个具备智能决策能力的推理系统。

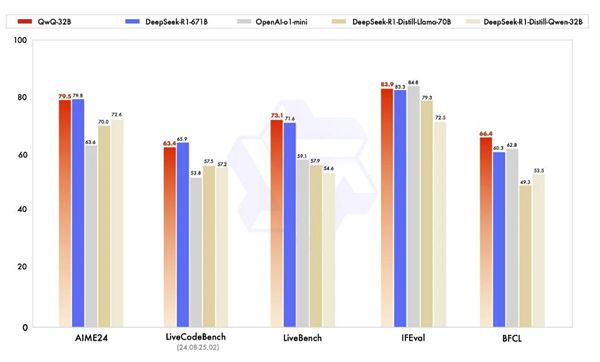

在一系列基准测试中,QwQ-32B展现了强大的数学推理、编程能力和通用能力。在数学能力测试的AIME24评测集以及代码能力测试的LiveCodeBench中,QwQ-32B的表现与DeepSeek R1相当,甚至在某些方面超越了后者。此外,在由Meta首席科学家杨立昆领衔的LiveBench、谷歌提出的指令遵循能力评测集IFEval,以及加州大学伯克利分校提出的BFCL测试中,QwQ-32B均取得了优异的成绩,超越了DeepSeek R1。

下载.jpg

下载.jpg

值得注意的是,QwQ-32B已经在Hugging Face和ModelScope上开源,用户可以通过Qwen Chat直接体验这一模型的强大能力。

分析认为,这一成果不仅展示了阿里在大语言模型领域的技术实力,也表明了其在推理模型优化方面的领先地位。QwQ-32B的推出,为人工智能领域的研究和应用提供了新的思路和方向,尤其是在如何通过更少的参数实现更高效推理方面,为行业树立了新的标杆。