计算机最高奖图灵奖揭晓!

强化学习先驱Andrew Barto与Richard Sutton共同获奖,他们被评价为“引领基础AI技术开发的研究人员”。

值得一提的是,两位是师徒关系,Richard Sutton是Andrew Barto他第一位博士生。

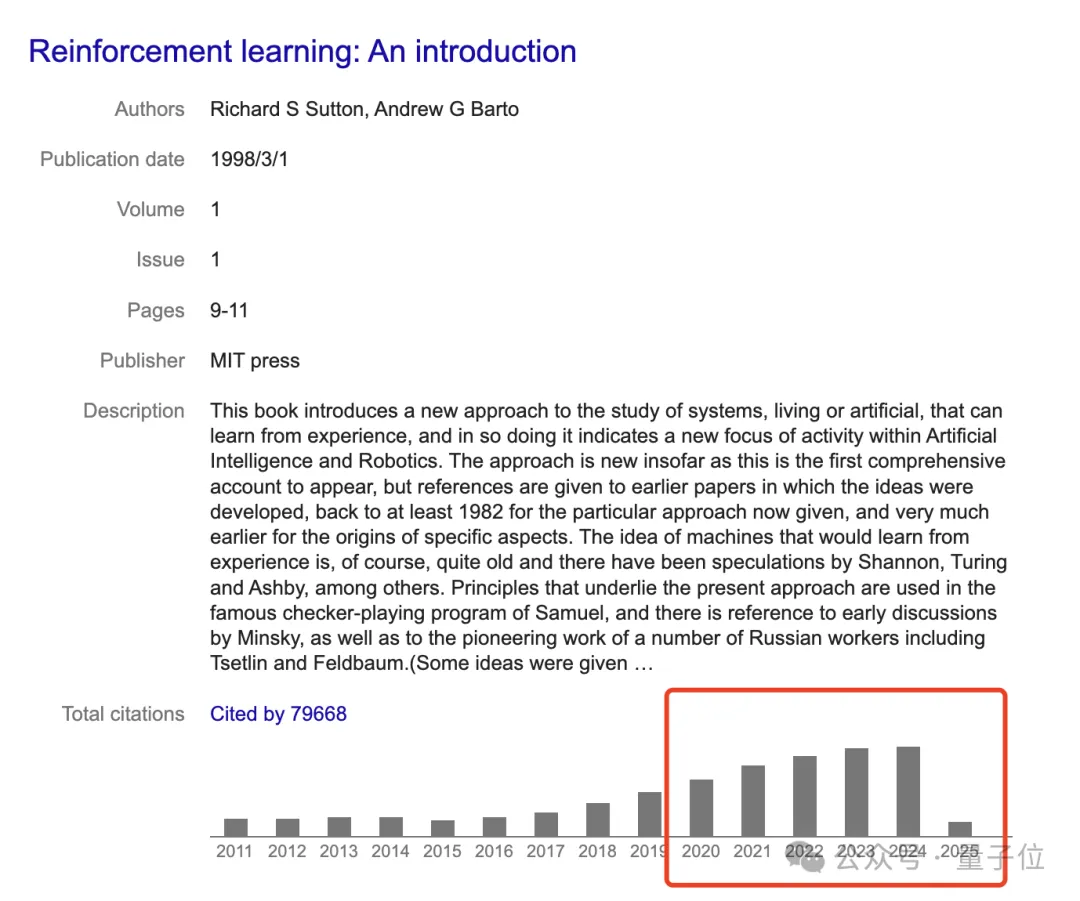

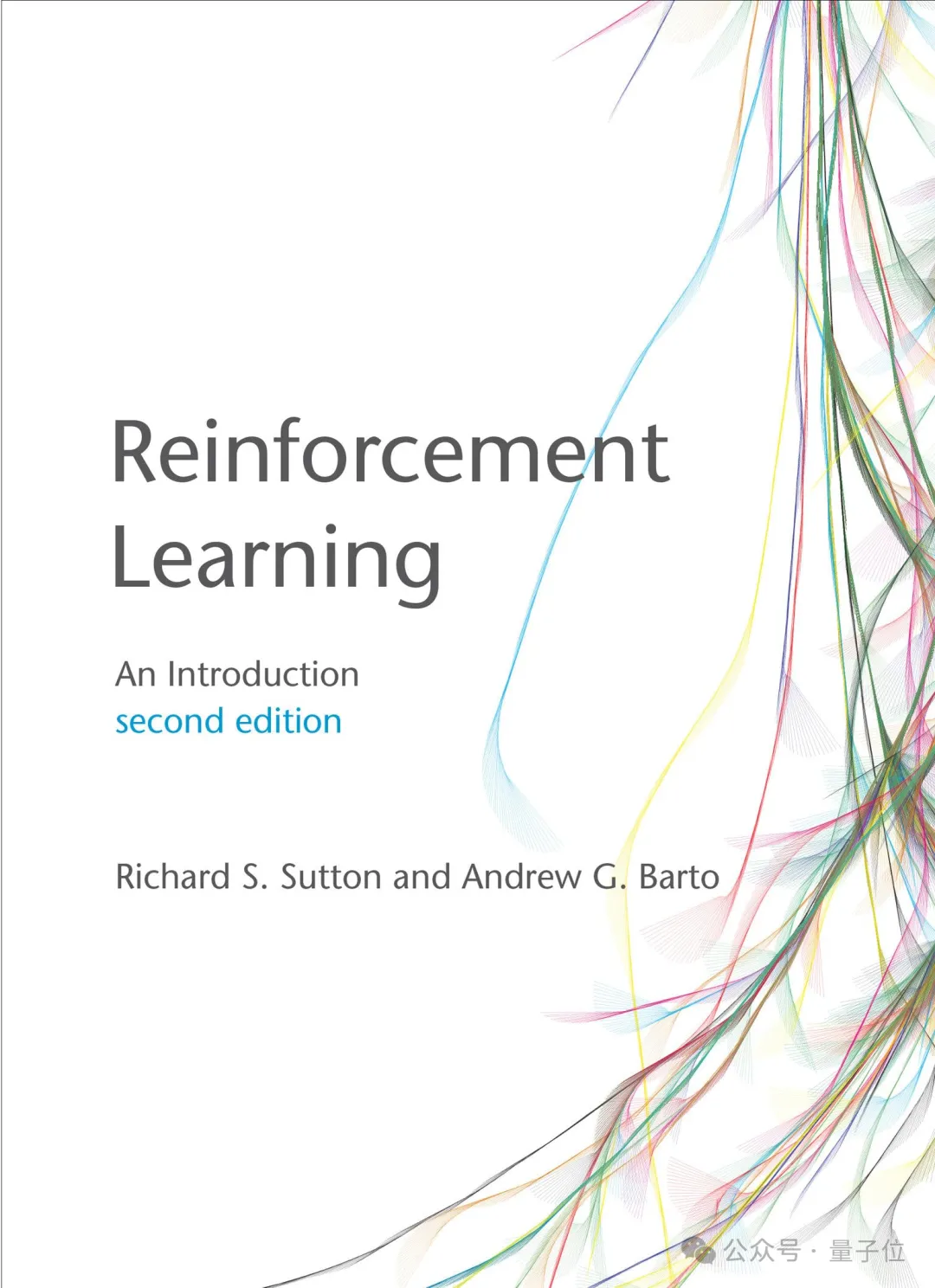

两人1998年合著的《强化学习:导论》,时至今日也是强化学习的标准教材,引用数接近8万,尤其在最近五年也仍在持续攀升。

最近几年来AI的重大进展,从AlphaGo到ChatGPT,都与他们开创的强化学习技术密切相关。

师徒拉开了强化学习大门

先来看Andrew Barto,是马萨诸塞大学阿默斯特分校信息与计算机科学系荣誉教授,年纪在76岁左右。

他是IEEE Fellow,曾获马萨诸塞大学神经科学终身成就奖、IJCAI 研究卓越奖(Research Excellence Award)和 IEEE 神经网络学会先驱奖。

Barto本科毕业于密歇根大学数学专业,此前他主修的是船舶建筑与工程专业。在阅读了迈克尔·阿比布、麦卡洛克和皮茨的著作后,他开始对使用计算机和数学来模拟大脑产生了兴趣。

五年后,他以一篇关于细胞自动机的论文获得了计算机的博士学位。

《细胞自动机作为自然系统的模型》

1977 年,他作为博士后研究助理在马萨诸塞大学阿默斯特分校开始职业生涯,此后担任过多个职位,包括副教授、教授和系主任。

任职期间,Barto 共同领导了自主学习实验室(最初为自适应网络实验室),该实验室提出了强化学习的几个关键思想。

直到Richard Sutton来到他的实验室,他们正式拉开了强化学习的大门。

2012年他官宣退休,再也不再招收学生。

再来看看他的学生Richard Sutton,时至今日仍然AGI探索积极分子。

目前,他是是阿尔伯塔大学计算机科学教授、Keen Technologies(一家总部位于德克萨斯州达拉斯的通用人工智能公司)的研究科学家,以及阿尔伯塔机器智能研究所(Amii)的首席科学顾问。

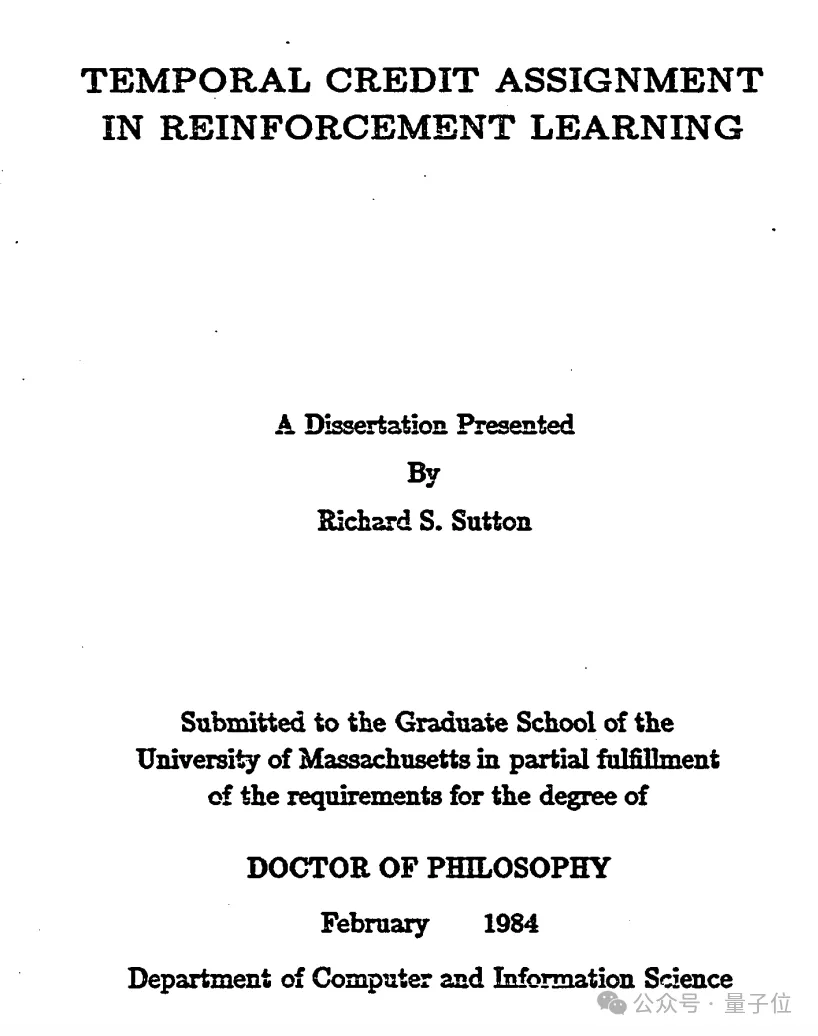

1978年,他从斯坦福大学心理学专业毕业,随后在Andrew Barto的指导下,先后获得了硕博学位。

他的博士论文《Temporal Credit Assignment in Reinforcement Learning》(强化学习中的时间学分分配),介绍了行为批判架构和时间学分分配,足足有210页。

而要说兴趣转向强化学习的缘由,他是受到Harry Klopf在 20 世纪 70 年代的研究成果的影响,该成果提出监督学习不足以用于人工智能或解释智能行为,而由“行为的享乐方面”驱动的试错学习才是必要的。

而要说兴趣转向强化学习的缘由,他是受到Harry Klopf在 20 世纪 70 年代的研究成果的影响,该成果提出监督学习不足以用于人工智能或解释智能行为,而由“行为的享乐方面”驱动的试错学习才是必要的。

Sutton 从 2017 年到 2023 年是 DeepMind 的杰出研究科学家。在加入阿尔伯塔大学之前,他曾于 1998 年至 2002 年在新泽西州 Florham Park 的 AT&T 香农实验室人工智能部门担任首席技术人员。

2019年,他曾撰文《痛苦的教训》痛批当前AI的发展,表示“未能吸取惨痛教训,即从长远来看,建立我们的思维方式是行不通的”。

他认为“70 年的人工智能研究表明,利用计算的通用方法最终是最有效的,而且领先优势很大”,打败了在计算机视觉、语音识别、国际象棋或围棋等特定领域基于人类知识的努力。

2023年,他官宣与John Carmack合作,共同开发AGI,也就是Keen Technologies。

图灵奖官方科普强化学习

强化学习的起源

强化学习是怎么来的?图灵奖官网在颁奖公告中介绍到:

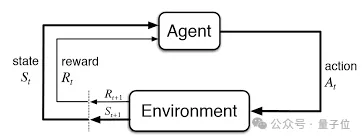

人工智能(AI)领域通常涉及构建智能体——即感知和行动的实体。

更强的智能体选择更好行动方案。因此,人工智能的核心是某些行动方案比其他方案更好的观念。奖励——一个从心理学和神经科学借用的术语——表示提供给智能体与其实际行为质量相关的信号。强化学习(RL)是在此信号下学习如何更成功行为的进程。

奖励学习的理念对动物培训师来说已经存在了数千年。

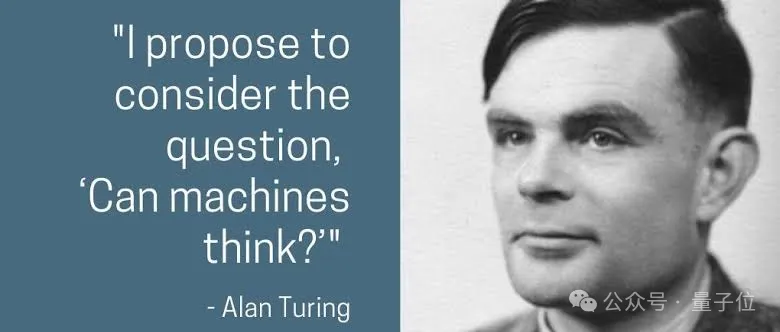

后来,艾伦·图灵在1950年的论文《Computing Machinery and Intelligence》中提出了“机器能思考吗?”的问题,并提出了基于奖励和惩罚的机器学习方法。

虽然图灵报告称已经使用这种方法进行了一些初步实验, 且Arthur Samuel在20世纪50年代末开发了一个通过自我对弈学习的国际象棋程序,但在接下来的几十年里,人们在这条道路上进步甚微。

直到20世纪80年代初,Barto和他的博士研究生Sutton受到心理学观察的启发,开始将强化学习构想为一个通用的问题框架。

他们借鉴了马尔可夫决策过程(MDPs)提供的数学基础。在马尔可夫决策过程中,智能体在随机环境中做出决策,每次状态转移后都会收到一个奖励信号,并旨在最大化其长期累积奖励。标准的马尔可夫决策过程理论假设智能体知晓关于马尔可夫决策过程的一切信息,而强化学习框架则允许环境和奖励未知。强化学习所需的最少信息,再加上马尔可夫决策过程框架的通用性,使得强化学习算法能够应用于广泛的问题,如下文将进一步解释。

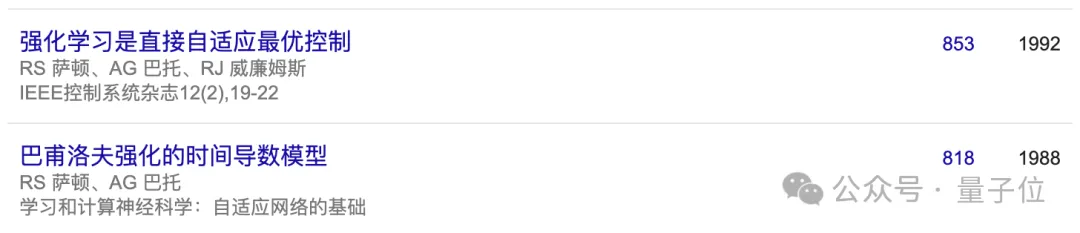

Barto和Sutton共同以及与其他人一起,开发了许多强化学习的基本算法方法。其中包括他们最重要的贡献——时序差分学习(在解决奖励预测问题上取得了重大进展),还有策略梯度方法以及将神经网络用作表示学习函数的工具。

他们还提出了将学习与规划相结合的智能体设计,展示了获取环境知识作为规划基础的价值。

或许同样具有影响力的是他们的教科书《Reinforcement Learning: An Introduction》(1998),这本书至今仍是该领域的标准参考文献,被引用次数超过7.5万次。它让数千名研究人员得以理解这一新兴领域并为之做出贡献,直至今日仍激励着计算机科学领域许多重要的研究活动。

深度强化学习的应用

尽管Barto和Sutton的算法是几十年前开发的,但强化学习在实际应用中的重大进展却是在过去十五年中通过将强化学习与深度学习算法(由2018年图灵奖得主Bengio、Hinton和LeCun 创)相结合而实现的,这催生了深度强化学习技术。

强化学习最著名的例子是AlphaGo在2016年和2017年战胜了最顶尖的人类围棋选手。近期的另一项重大成就是ChatGPT。

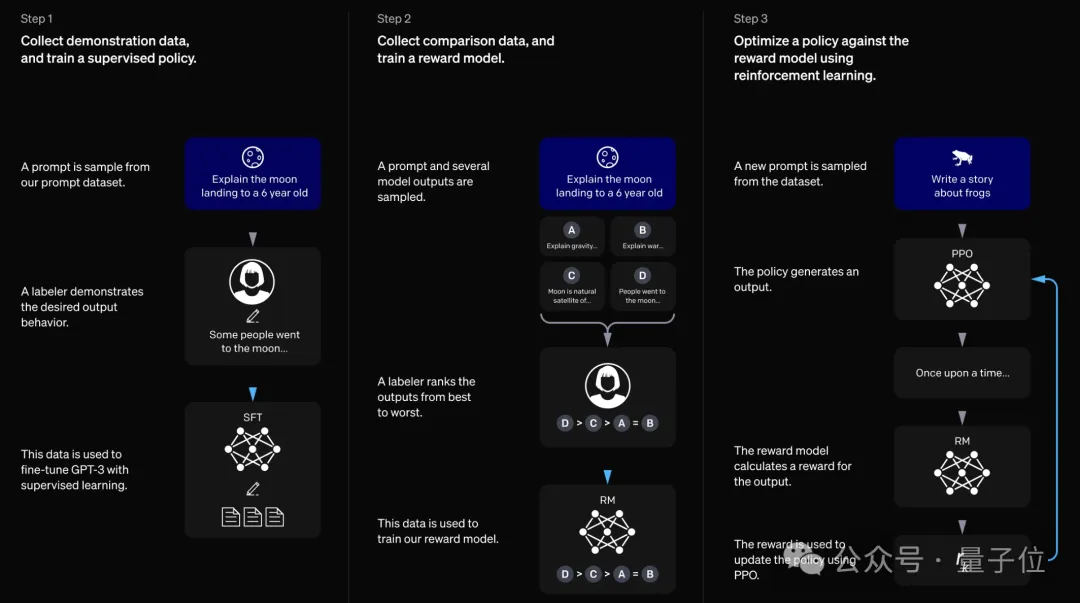

ChatGPT是一个分两个阶段训练的大语言模型,其中第二阶段采用了一种名为基于人类反馈的强化学习(RLHF)的技术,以捕捉人类的期望。

强化学习在许多其他领域也取得了成功。一个备受瞩目的研究实例是机器人在手中操作技能学习以及解决实体魔方问题,这表明在模拟环境中进行所有强化学习,最终在差异显著的现实世界中也能取得成功。

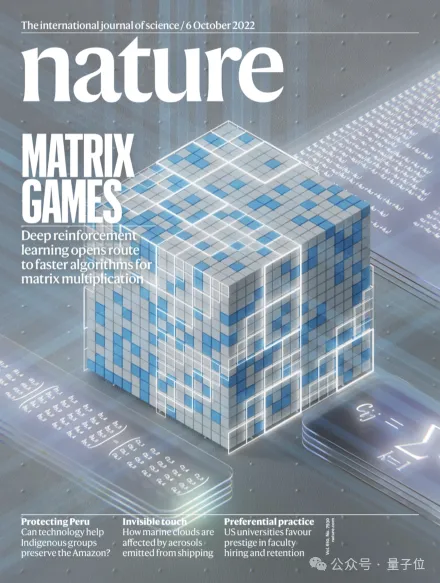

其他领域包括网络拥塞控制、芯片设计、互联网广告、优化、全球供应链优化、提升聊天机器人的行为和推理能力,甚至改进计算机科学中最古老问题之一——矩阵乘法的算法。

最后,一项部分受神经科学启发的技术也反过来带来了启发。近期的研究(包括Barto的工作)表明,人工智能领域的特定强化学习算法能够很好地解释关于人类大脑中多巴胺系统的一系列研究发现。

美国计算机协会(ACM)主席Yannis Ioannidis称“Barto和Sutton的工作展示了运用多学科方法应对我们领域长期存在的挑战所蕴含的巨大潜力”。

从认知科学、心理学到神经科学等研究领域都启发了强化学习的发展,强化学习为人工智能领域一些最重要的进展奠定了基础,也让我们对大脑的工作方式有了更深入的了解。

Barto和Sutton的工作并非我们可以抛在身后的垫脚石。强化学习仍在不断发展,为计算机科学和许多其他学科的进一步发展提供了巨大潜力。我们用本领域最负盛名的奖项来表彰他们是恰如其分的。”

谷歌高级副总裁Jeff Dean(谷歌为图灵奖提供资金支持)指出,“Barto和Sutton开创的强化学习直接回应了图灵的挑战”。

在过去几十年里,他们的工作一直是人工智能发展的关键。他们开发的工具仍然是人工智能热潮的核心支柱,带来了重大进展,吸引了大批年轻研究人员,并推动了数十亿美元的投资。强化学习的影响在未来仍将持续。”