最新研究表明,网络攻击者正在利用泄露的云凭证在几分钟内劫持企业AI系统。近期事件显示,攻击者能够在19分钟内攻破大型语言模型(LLM)的基础设施。

这种被称为“LLMjacking”的攻击方法以非人类身份(NHIs)——如API密钥、服务账户和机器凭证——为目标,绕过传统安全控制,并利用窃取的生成式AI访问权限牟利。

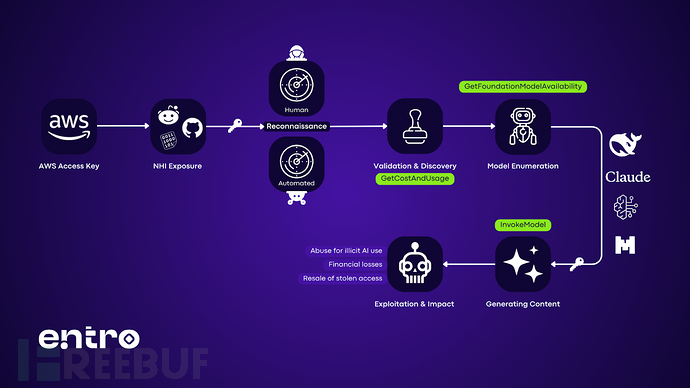

LLMjacking的攻击链

安全公司Entro Labs最近在GitHub、Pastebin和Reddit上发布了功能性AWS密钥,以研究攻击者的行为。

他们的研究揭示了一种系统化的四阶段攻击模式:

LLMJacking攻击链

(1) 凭证收集:自动化的机器人使用Python脚本扫描公共代码库和论坛,以检测有效凭证,其中44%的非人类身份是通过代码库和协作平台泄露的。

(2) 快速验证:攻击者在凭证暴露后的9-17分钟内执行初始API调用(如GetCostAndUsage)以评估账户价值,并避免使用可预测的调用(如GetCallerIdentity)以逃避检测。

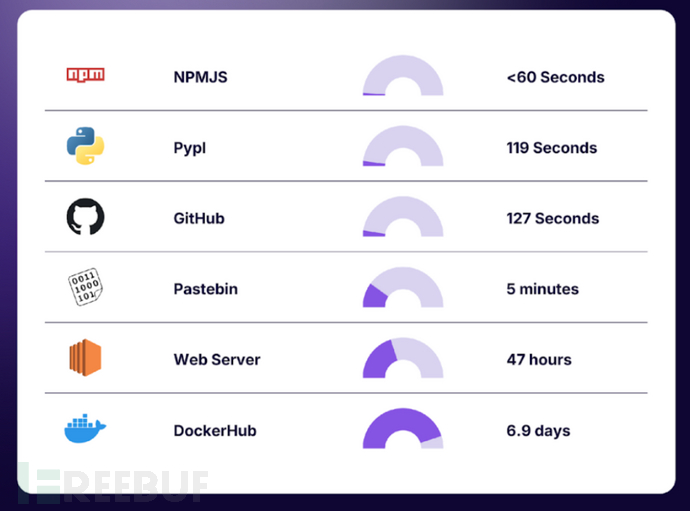

不同泄露位置的密钥访问平均时间

(3) 模型枚举:入侵者通过AWS Bedrock执行GetFoundationModelAvailability请求,以列出可访问的LLM——包括Anthropic的Claude和Amazon Titan——并映射可用的攻击面。

(4) 利用:攻击者对受损端点进行自动化的InvokeModel尝试,研究人员在实验密钥中观察到每小时超过1200次未经授权的推理尝试。

Storm-2139网络犯罪集团最近利用这种方法攻击了Microsoft Azure AI客户,窃取API密钥以生成暗网内容。取证日志显示,攻击者:

- 使用Python的requests库进行凭证验证

- 使用aws s3 ls命令识别AI/ML存储桶

- 尝试通过精心设计的提示绕过内容过滤器执行bedrock: InvokeModel

Entro的模拟漏洞测试显示,攻击者将自动化脚本与手动侦察相结合——63%的初始访问使用了Python SDK,而37%使用Firefox用户代理通过AWS控制台进行交互式探索。

未受控制的LLMjacking带来了严重的风险:

- 成本滥用:一个具有Bedrock访问权限的受损非人类身份可能每天产生46000美元的未经授权推理费用。

- 数据泄露:在22%的观察事件中,攻击者泄露了模型配置和训练数据元数据。

- 声誉损害:微软2025年第一季度的漏洞事件中,威胁行为者使用窃取的Azure OpenAI密钥生成了超过14000张深度伪造图像。

缓解策略

- 实时检测和监控非人类身份

- 实施自动化的密钥轮换

- 强制执行最小权限原则

- 监控异常的API活动

- 教育开发人员如何安全管理非人类身份

随着攻击者在20分钟内即可利用泄露的密钥,实时密钥扫描和自动轮换不再是一种可选的保护措施,而是LLM时代的关键生存机制。