众所周知,在当今信息爆炸的时代,如何从海量数据中高效、精准地提取有价值的内容,成为人工智能领域的重要课题。DeepSearch 作为一种创新的迭代搜索系统,以其独特的循环推理机制和强大的信息挖掘能力,逐渐崭露头角,成为解决复杂查询与研究需求的利器。

本文将带大家深入探索 DeepSearch 的前世今生——从其概念的萌芽、技术原理的演进,到如今在智能搜索与知识生成领域的广泛应用。通过梳理其发展脉络与核心优势,我们将为您揭开这一技术背后的奥秘,呈现一幅清晰而立体的全景图景,让大家在“一文”之中,轻松读懂 DeepSearch 的独特魅力与未来潜力...

一、DeepSearch 在大模型中的应用

作为搜索技术进入了一个全新的时代的兴起标志,DeepSearch 和 DeepResearch 通过深度学习和大型语言模型,实现了从关键词匹配到语义理解、从静态索引到动态推理的转型,为用户提供了更智能、更个性化的搜索体验。与此同时,这些技术的开源与专有并存的模式,刺激了全球 AI 生态的竞争与合作,促使搜索应用在学术研究、企业服务和日常生活中得到更广泛的落地。

截至 2025 年 3 月,这些技术已开始在多个领域展现潜力:从学术界的高效文献检索,到企业级的实时商业情报,再到消费者的个性化内容发现,DeepSearch 和 DeepResearch 正重塑搜索的未来。它们的兴起不仅体现了 AI 技术的快速发展,也预示着搜索领域将迎来更加智能化和多样化的新时代。

二、DeepSearch & DeepResearch 的发展历程

众所周知,在 2025 年初,人工智能驱动的搜索技术迎来了革命性突破,DeepSearch 和 DeepResearch 俨然已成为搜索领域的新标准。这些创新技术的兴起标志着搜索功能从传统的关键词匹配和静态索引,向基于大型语言模型(LLM)与深度学习的高级语义理解和知识推理转型,极大地提升了搜索的准确性、相关性和智能化水平。

1. DeepSeek 的 DeepSeek-r1:开源先锋

2025 年 1 月 20 日,DeepSeek 公司发布其开源大型语言模型 DeepSeek-r1,迅速成为 DeepSearch 领域的标杆。该模型以其强大的语义搜索能力、开放源码特性以及高效的训练效率吸引了全球开发者和研究者的广泛关注。DeepSeek-r1 结合了先进的变换器架构和自监督学习技术,能够处理复杂查询并提供深度语境理解,特别适用于学术研究、商业情报和个性化推荐场景。其开源特性促使社区迅速围绕 DeepSeek-r1 构建生态,涵盖插件、优化工具和行业应用,加速了 DeepSearch 的普及和创新。

2. Google 与 OpenAI 的 DeepResearch:专有技术引领

而仅仅两周后,即 2025 年 2月 2 日,Google 和 OpenAI 联合发布了专有技术 DeepResearch,进一步推动了搜索领域的智能化升级。DeepResearch 整合了 Google 的搜索索引能力和 OpenAI 的生成式 AI 技术(如 GPT 系列的最新迭代),实现了从简单查询到复杂推理的跨越。DeepResearch 特别优化了多模态搜索(如文本、图像、视频的综合检索)和实时知识更新能力,适用于企业级应用、高端科研和精准商业决策。虽然其专有性质限制了源码公开,但 Google 和 OpenAI 通过云服务和 AP I接口使其广泛可用,迅速在金融、医疗和法律等领域获得采用。

3. 行业跟进:全球与国内大模型厂商的积极响应

随后,Jina AI 推出了开源项目 node-deepresearch,进一步丰富了 DeepSearch 和 DeepResearch 的生态。构建在 Jina AI 的神经搜索框架之上,node-deepresearch 专注于分布式搜索和边缘计算场景,特别适合低延迟、高吞吐量的搜索需求。

其开源特性使其迅速与 DeepSeek-r1 形成互补,吸引了中小企业和开源社区的广泛参与。node-deepresearch 通过轻量级设计和跨平台支持,填补了大型专有模型在资源受限环境中的应用空白。

与此同时,其他 AI 领域领先企业也迅速跟进。Hugging Face 整合其模型中心(Model Hub)推出了基于 DeepSearch 的开源搜索工具,优化了社区模型的检索与应用。Perplexity 则推出了专有搜索增强产品,结合其对话式 AI 能力,进一步提升用户体验。

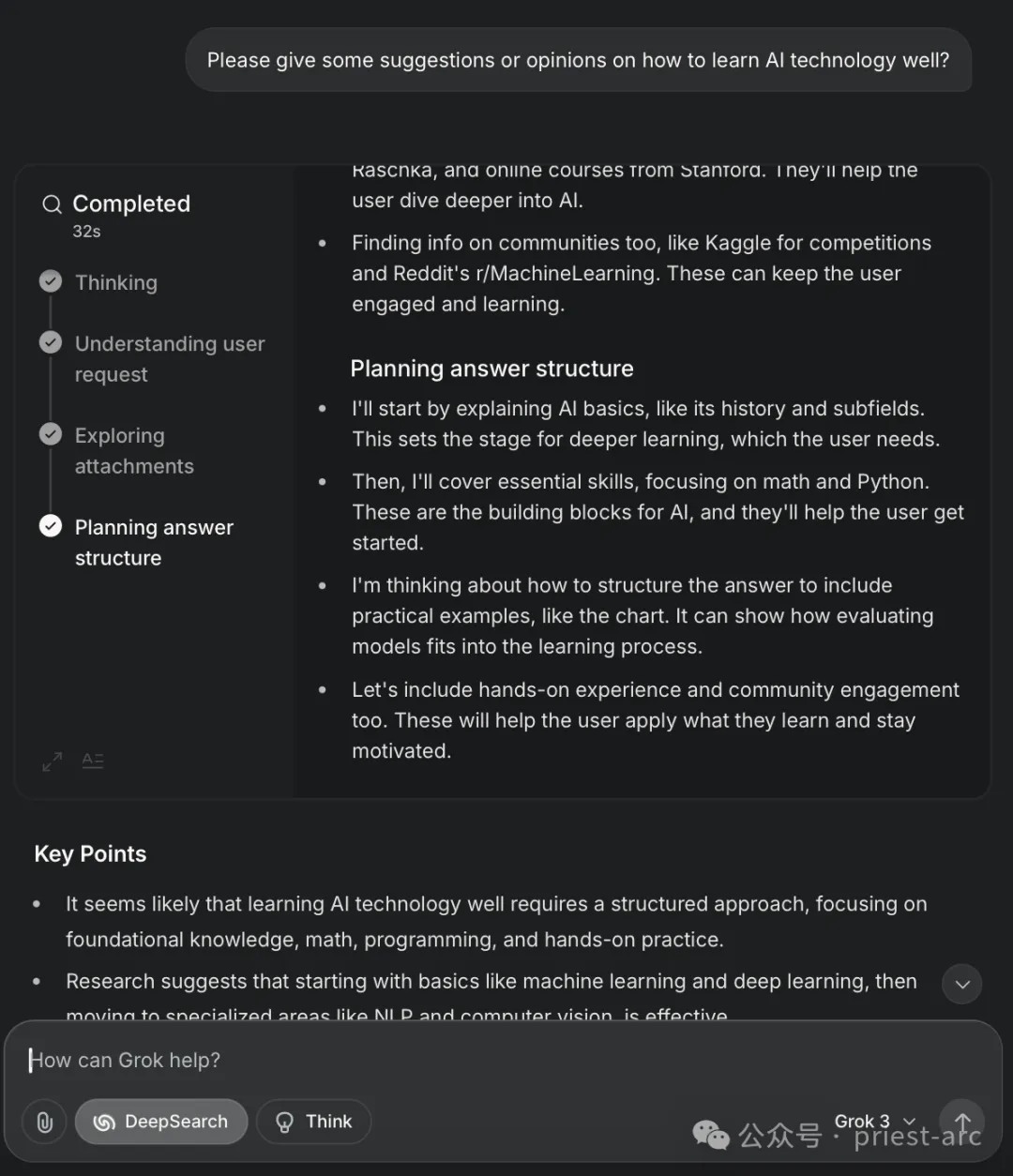

xAI(Grok3)也不甘示弱,利用其独特的多模态理解能力,推出了面向科研和创新的 DeepSearch 解决方案,强调知识发现的深度与广度。此外,国内大模型厂商如百度(文心大模型)、阿里(通义千问)和字节跳动(抖音大脑)也迅速响应,推出了各自的 DeepSearch 和 DeepResearch 变种,结合本地化数据和语言特性,服务于中国市场的搜索需求。这些厂商的跟进不仅加速了技术的全球化传播,也推动了区域化创新。

三、那么, DeepSearch 为何神秘之物?实现机制是怎样的?

作为一种先进的迭代搜索系统,DeepSearch 的核心在于通过不断循环执行三个基本动作,直至挖掘出最优答案。其围绕三个动作展开,具体可参考如下:

- 搜索:充分利用网络搜索引擎,广泛探索互联网上的资源和信息;

- 阅读:深入剖析特定网页或文档的内容,提取关键信息并理解其上下文;

- 推理:综合评估当前的搜索状态,分析已有信息的质量与相关性,并据此决定下一步的行动方向。

与传统的检索增强生成(RAG)系统不同,传统 RAG 系统通常仅执行一次搜索并直接生成答案,而 DeepSearch 的独特之处在于其迭代性,会持续进行多次搜索-分析-优化的循环,直到满足预设的停止条件为止。

这些条件可能包括令牌(token)使用量的上限、失败尝试的次数阈值,或系统判定已找到充分可靠的答案。这样的设计使得 DeepSearch 能够逐步逼近问题的核心,避免单次搜索可能导致的浅层或不准确的结果。

而对于 DeepResearch 而言,其在 DeepSearch 基础之上,进一步扩展了 DeepSearch 的功能,专注于生成结构化、逻辑清晰的长篇研究报告。其工作流程可以分为三个阶段:

- 目录生成:根据研究主题,首先构建一个详细的纲要或目录,明确报告的各个章节和逻辑结构;

- 章节填充:针对目录中的每一部分,调用 DeepSearch 系统进行深入的信息挖掘和内容生成;

- 内容整合:将所有章节的内容进行合并与优化,确保整体报告在逻辑连贯性、内容深度和表达一致性上达到更高标准。

通过这种方式,DeepResearch 不仅继承了 DeepSearch 的迭代搜索能力,还增加了对复杂研究任务的支持,适用于需要系统性分析和长篇输出的场景。

DeepSearch 和 DeepResearch 依托一系列精心设计的技术机制,以确保系统在效率、准确性和稳定性方面达到最佳水平。以下是对其关键技术实现的深入解析。

1. 循环推理机制

系统采用循环推理(Iterative Reasoning)方式,通过一个 While 循环持续执行推理任务。每次迭代包含搜索、阅读和推理三个核心步骤,并依据预设终止条件判断是否继续运行。这种动态调整策略使系统能够在每轮推理中充分利用新获取的信息,不断优化决策,直至满足以下任一条件:

- 成功找到满足需求的答案

- 达到资源预算上限(例如令牌消耗超出设定阈值)

- 该机制确保推理过程高效可控,并最大化信息挖掘能力。

2. 系统提示工程优化

在提示工程(Prompt Engineering)设计上,系统采用 XML 结构化标记方式,将不同的任务模块(如搜索指令、内容分析、推理决策)进行明确划分。例如:

这种分区方式增强了模型对复杂任务的理解能力,并提升了输出的稳定性和可控性。具体而言,该策略具有以下优势:

- 提高解析准确性:使 LLM 能够精确区分不同功能区域,减少指令歧义。

- 增强任务可控性:通过清晰的结构引导推理逻辑,确保模型执行预期操作。

- 提升复杂任务的稳定性:避免因长文本提示导致的混淆,提高多步骤任务的可靠性。

3. 知识缺口的高效处理

当系统在推理过程中检测到知识缺口(Knowledge Gaps)或未解问题时,它不会直接进入递归求解模式,而是采用先进先出(FIFO)队列进行子问题管理。这种策略的核心优势包括:

- 避免递归引发的计算复杂度激增,降低系统资源消耗。

- 确保问题处理的顺序性,有序推进多层级问题的解析。

- 动态调整推理流程,优先解决高优先级子问题,提高整体任务完成效率。

这种队列驱动的推理机制使得系统在处理多层次推理任务时更加高效稳定。

4. 查询重写与多元化信息覆盖

为了优化信息检索能力,系统采用查询重写(Query Rewriting)技术,针对初始搜索请求生成等价但形式多样的查询语句,以提高信息覆盖范围。关键优化策略包括:

- 同义词扩展:使用不同术语表达相同概念,如 AI 计算 ⇄人工智能计算⇄深度学习算力

- 语言多样化:支持跨语言查询优化,提升全球范围内的信息获取能力。

- 多格式覆盖:针对不同信息载体(如学术论文、新闻文章、技术论坛)优化查询表达,提高搜索结果的广度与深度。

这种多维度搜索优化策略确保了系统能够充分挖掘与目标任务相关的关键信息,提高检索的全面性和精准度。

5. 内存管理与知识存储优化

在大语言模型(LLM)的上下文管理中,系统采用记忆(Memory)与知识(Knowledge)分离策略,实现高效的内存管理:

- 记忆(短期上下文):存储当前推理过程中需要保留的临时信息,确保上下文连贯性。

- 知识(长期积累):将高价值信息结构化存储,以供后续任务复用,避免重复推理。

此外,系统通过动态内存清理策略,在推理过程中定期移除冗余或低价值信息,优化计算资源利用率,确保推理效率最大化。

6. 生成与评估分离的答案优化机制

系统在答案生成阶段采用“生成-评估” 双阶段流程,确保最终输出的内容质量可靠。

生成阶段(Answer Generation):

- 专注于内容生成,确保回答的流畅性与逻辑性。

- 采用多轮推理优化,提升内容的准确度与完整性。

评估阶段(Answer Evaluation):

- 独立执行答案质量检测,包括准确性、相关性、完整性评估。

- 使用自动化检测工具(如基于 LLM 的内容审查)验证答案质量,确保可信度。

这种解耦式生成-评估框架避免了传统 LLM 直接输出可能导致的误导性问题,提高答案的可靠性和可信度。

7. 预算控制与“野兽模式”优化策略

为应对计算资源限制,系统引入预算控制(Resource Budgeting)机制,在推理过程中动态监测令牌使用量、计算资源占用率等关键指标,并在接近上限时触发“野兽模式”(Beast Mode),优化推理流程。

在“野兽模式”下,系统采取如下策略以确保输出质量:

- 精简推理路径:减少冗余计算,仅关注核心问题,快速得出可用答案。

- 优化信息利用率:优先处理高价值信息,剔除低影响因素,提高推理效率。

- 确保最优解的可用性:即便在受限计算环境下,也能提供实用性较强的答案,避免因资源消耗殆尽导致任务失败。

该机制使系统能够在不同计算环境下灵活调整推理策略,实现资源利用的最优化。

Happy Coding ~

Reference :

- [1] https://forums.developer.nvidia.com/

- [2] https://www.run.ai/