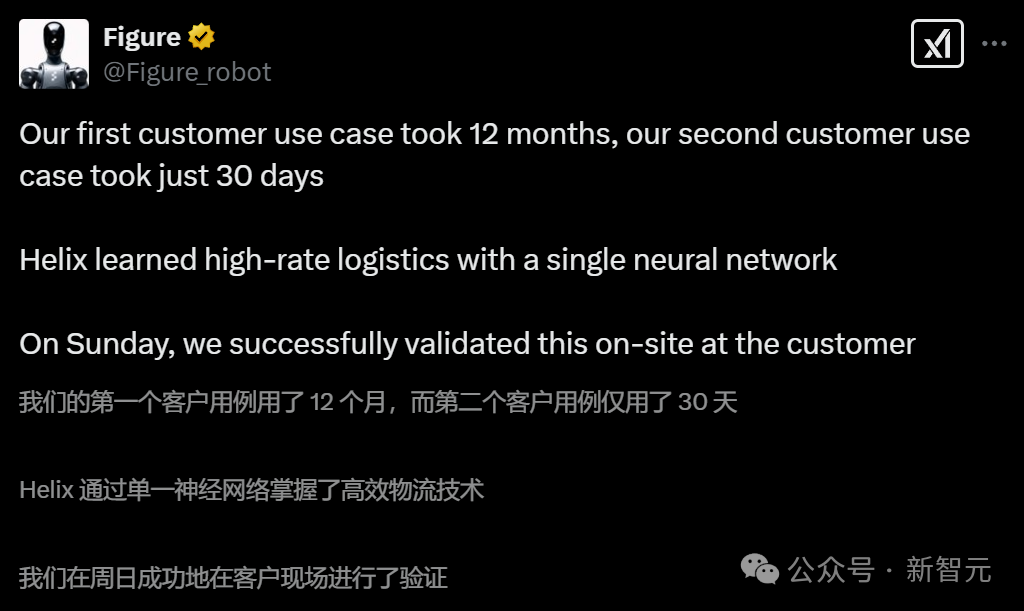

踹掉OpenAI之后,Figure的迭代堪称神速!

几天前才发布了第一款自研视觉-语言-动作(VLA)模型Helix,统一了感知、语言理解和学习控制。。

就在刚刚,他们又在一个全新场景中实现了机器人应用的落地——物流包裹操作和分拣。

而且,只用了短短30天。

图片

图片

图片

图片

为了达到人类级别的速度、精确度和适应性,Figure对自研模型Helix的系统1(S1),也就是底层视觉运动控制策略,做出了全面的改进:

- 隐式立体视觉(implicit stereo vision):Helix系统1现在具有丰富的3D理解能力,实现更精确的深度感知运动。

- 多尺度视觉表征(Multi-scale visual representation):底层策略可以捕捉精细细节,同时保持场景层面的理解,实现更准确的操作。

- 学习式视觉本体感知(learned visual proprioception):每个Figure机器人现在都可以自我校准,使跨机器人迁移变得无缝。

- 运动模式(sport mode):使用简单的测试时加速技术,Helix 达到了比示范者更快的执行速度,同时保持高成功率和灵巧度。

结果显示,在这个特定场景中,仅需8小时精心策划的示范数据,就能产生灵活多变的操作策略。

只见,Figure机器人军团同时走向自己的工位,站成一排,同步开启打工模式。

图片

图片

看它灵活的双手,拿起包裹后,识别物流码逐一分拣。

整条流水线上,全由Figure完成,无需人类插手。

图片

图片

值得一提的是,它们还会自我校准。

图片

图片

对此网友纷纷表示,「工厂工人将被迅速取代!」

还有网友感慨道,「将现有劳动力转换为机器人会比我们想象的要快得多。」

图片

图片

图片

图片

图片

图片

极具挑战性的物流场景

包裹处理和分拣是物流中的基本操作。这通常涉及将包裹从一条传送带转移到另一条传送带,同时确保运输标签正确朝向以便扫描。

这项任务面临几个关键挑战:包裹的尺寸、形状、重量和刚性(如硬盒或软袋),都各不相同。

为此,系统必须能够:

- 确定抓取移动物体的最佳时机和方法,并重新调整每个包裹的朝向使标签可见

- 跟踪持续移动的传送带上众多包裹的动态流动,并保持高吞吐量

- 实现自我调整,因为环境无法被完全预测

而这些,在仿真环境中是很难进行复刻的。

值得注意的是,解决这些挑战不仅是Figure业务的关键应用,它还为Helix系统1带来了全新的通用改进,从而使所有其他用例都从中受益。

图片

图片

图片

图片

图片

图片

对Helix视觉-运动策略(系统1)的架构改进

视觉表征

此前的系统1依赖于单目视觉输入,而现在的新系统采用了立体视觉主干网络,结合多尺度特征提取网络来捕捉丰富的空间层次结构。

新系统不再单独处理每个摄像头的图像特征token,而是会在token化之前将两个摄像头的特征在多尺度立体网络中合并,这样保持了输入到交叉注意力Transformer的视觉token总数不变,同时避免了额外的计算开销。

多尺度特征使系统能够同时识别精细细节和更广泛的上下文信息,共同提升了基于视觉的控制可靠性。

图片

图片

跨机器人迁移

在多个机器人上部署同一策略时,需要解决因个体机器人硬件细微差异导致的观测和动作空间分布偏移问题。

这些差异主要包括传感器校准差异(影响输入观测)和关节响应特性(影响动作执行),若不进行适当补偿,将会显著影响策略性能。

尤其是在涉及高维度的整个上半身动作空间时,传统的手动机器人校准方法难以适用于大规模机器人群组。

为解决这一问题,Figure训练了一个视觉本体感知模型,该模型完全基于每个机器人自身的视觉输入来估计末端执行器的六自由度(6D)姿态。

这种在线「自我校准」机制使得跨机器人策略迁移能够高效进行,同时将停机时间降至最低。

图1:可扩展的实时视觉校准技术实现强大的跨机器人迁移能力

图1:可扩展的实时视觉校准技术实现强大的跨机器人迁移能力

数据筛选

数据方面,Figure在筛选时排除了那些速度较慢、失误或完全失败的人类示范。

但有意保留了一些自然包含纠正行为的示范,前提是造成失败的原因是环境的随机因素,而非操作者的错误。

与远程操作者密切合作,可以改进和统一操控策略,并带来显著的性能提升。

推理阶段操作加速

为了让系统能够接近并最终超越人类操作速度,Figure应用了一种简单但有效的测试阶段技术,从而实现了比示范者更快的学习行为——对策略动作块输出进行插值(「运动模式」)。

其中,S1策略输出动作「块」,即以200Hz频率执行的一系列机器人动作。

在实践中,可以在不修改训练程序的情况下实现20%的测试阶段加速。

方法是,将一个[T x action_dim]的动作块(表示一个T毫秒的轨迹)线性重采样为一个更短的[0.8 * T x action_dim]轨迹,然后以原始的200Hz控制率执行这个更短的动作块。

结果与讨论

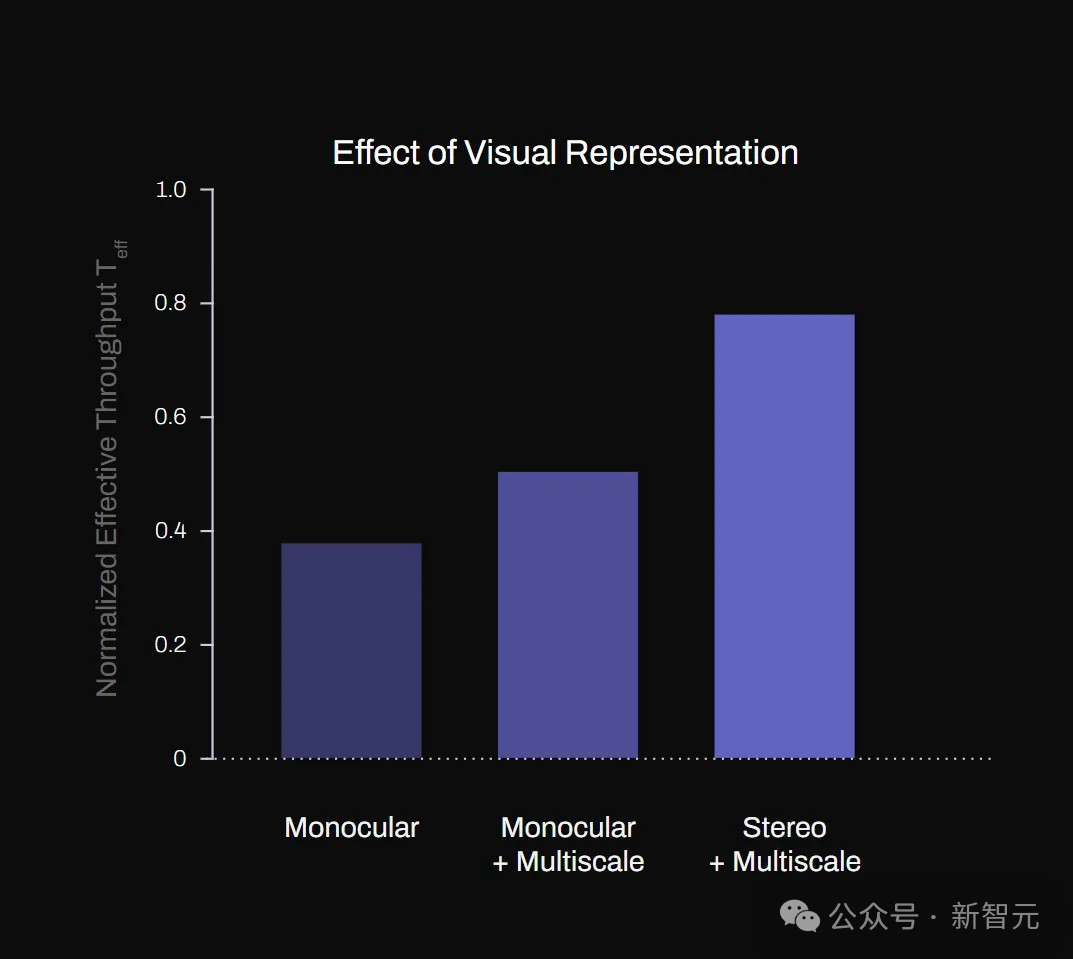

使用标准化有效吞吐量* T_eff 来衡量系统性能,可以反映系统处理包裹的速度与训练数据中演示者速度的比值。(这一指标考虑到了系统重置所花费的时间)

例如,当T_eff > 1.1时,表示系统操作速度比训练所用的专家轨迹快10%。

立体视觉的重要性

图2(a)展示了多尺度特征提取器和立体视觉输入对系统T_eff的影响。

其中,多尺度特征提取和隐式立体输入显著提升了系统性能,立体视觉也显著增强了系统处理各种尺寸包裹的稳健性。

相比于非立体基线模型,立体模型实现了高达60%的吞吐量提升。

图2:(a)不同视觉表示方法对系统性能影响的消融研究

图2:(a)不同视觉表示方法对系统性能影响的消融研究

此外,配备立体视觉的S1系统能够成功处理系统从未训练过的平信封,表现出良好的泛化能力。

图片

图片

机器人可以将信封分拣出来。

可以看出机器人的手部活动十分灵活。

图片

图片

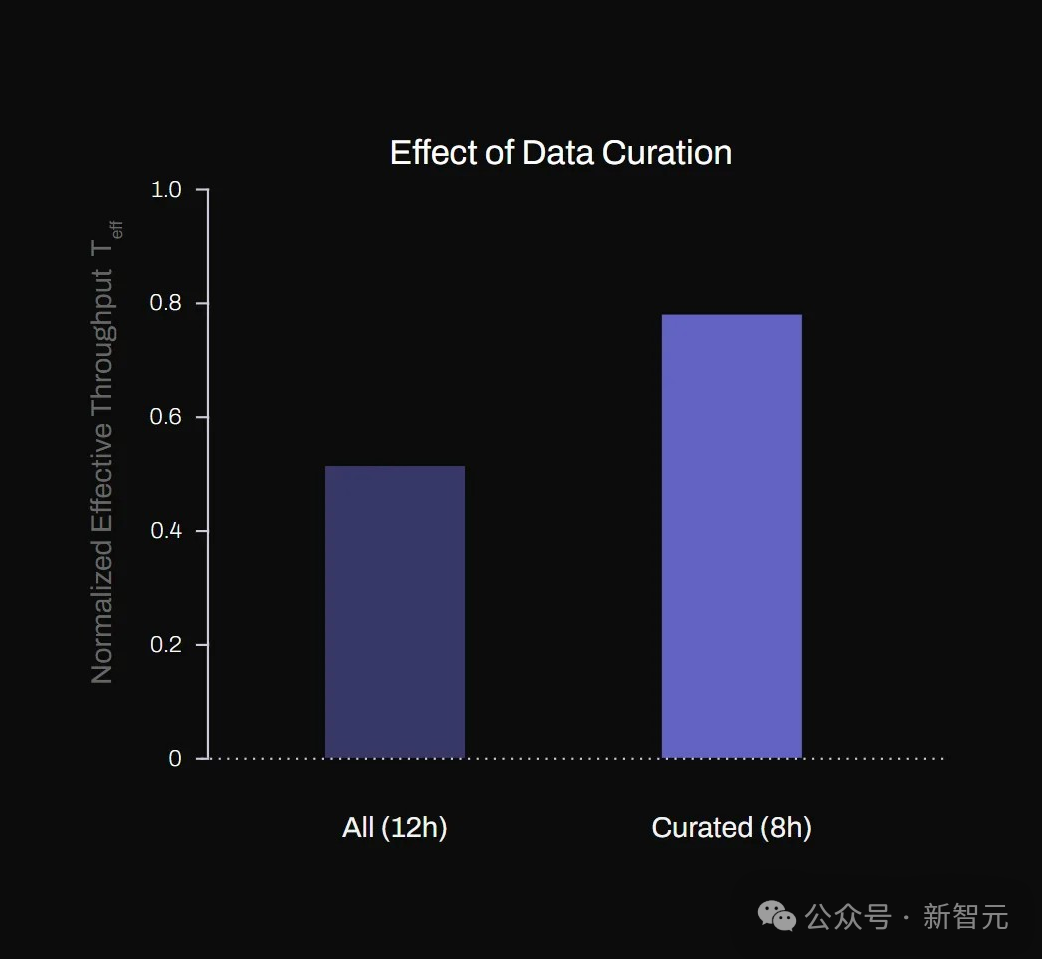

质量胜于数量

Figure发现,对于单个应用场景,数据质量和一致性比数据数量更为重要。

如图2(b)所示,尽管训练数据量减少了三分之一,但使用精心筛选的高质量示范数据训练的模型仍然实现了40%更高的吞吐量。

图2(b):数据筛选对有效吞吐量的影响

图2(b):数据筛选对有效吞吐量的影响

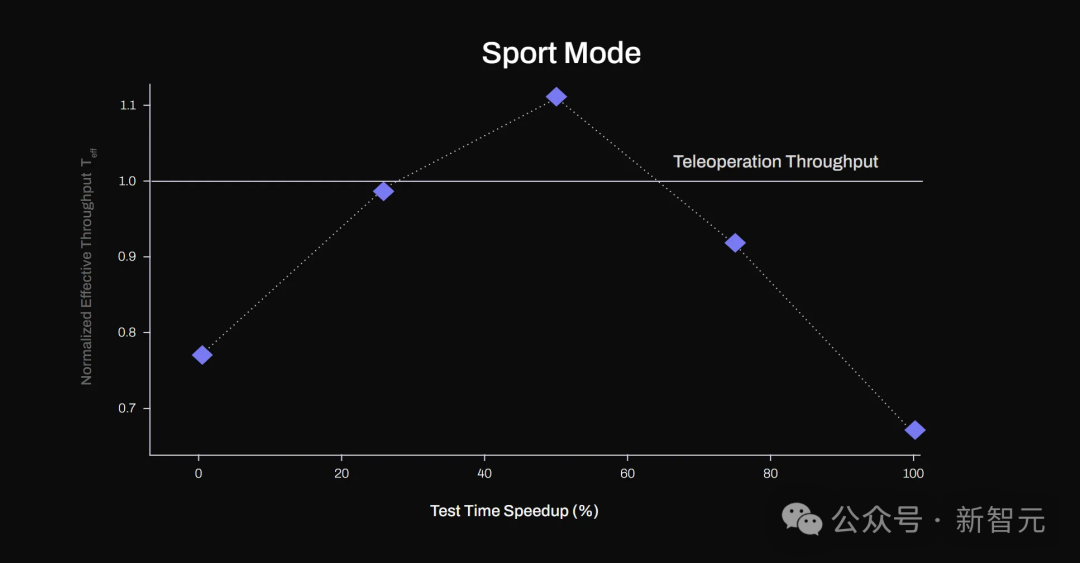

运动模式

通过线性重采样技术(即「运动模式」)加速策略执行,在提速不超过50%的范围内表现出奇地有效。这可能归功于动作输出块的高时间分辨率(200Hz)。

然而,当速度提高超过50%时,有效吞吐量开始大幅下降,因为动作变得过于不精确,系统需要频繁重置。

图3显示,在速度提高50%的情况下,策略能够实现比其训练所基于的专家轨迹更快的物体处理速度(T_eff>1)。

图片

图片

图3:通过动作块重采样实现测试阶段加速。在测试阶段速度提高50%的情况下,S1系统实现了比示范数据更高的有效吞吐量(T_eff>1)

跨机器人迁移

最后,通过利用学习型校准和视觉本体感知模块,Figure成功将最初仅在单个机器人数据上训练的策略应用到多台不同机器人上。

尽管各机器人间存在传感器校准差异和细微硬件不同,系统在所有平台上仍保持了相当一致的操作性能水平。

这种一致性凸显了学习型校准在减轻数据分布偏移方面的有效性,大大减少了繁琐的单机器人重新校准需求,使大规模部署变得更加实用。

总结

综上,Figure展示了如何通过高质量数据集,结合立体多尺度视觉、实时校准和测试阶段加速等架构优化,在实际物流优先级分拣场景中实现超越示范者速度的灵巧机器人操作——这一切仅使用了相对适量的示范数据。

研究结果表明,端到端视觉-运动控制策略在速度和精度至关重要的复杂工业应用中具有巨大的扩展潜力。