这些更新旨在提升性能、易用性以及开发者整体体验。在本文中,我们将深入探讨 Spark 4.0 的主要更新,与 Spark 3.x 进行对比,提供基准测试数据,并讨论这些改进在特定场景中的显著影响。

1. Spark 4.0 中的关键功能

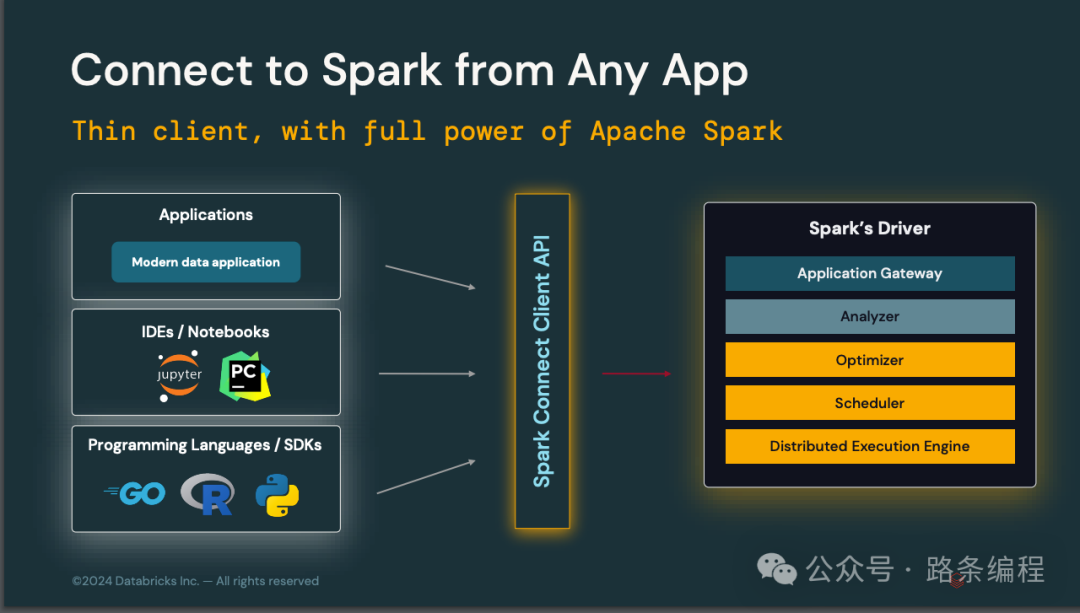

1.1 Spark Connect

- 概述:Spark Connect 是一个全新的客户端 API,允许开发者从任意环境连接到 Spark 集群,从而实现一个支持完整 Spark 功能的轻量级客户端。

图片

图片

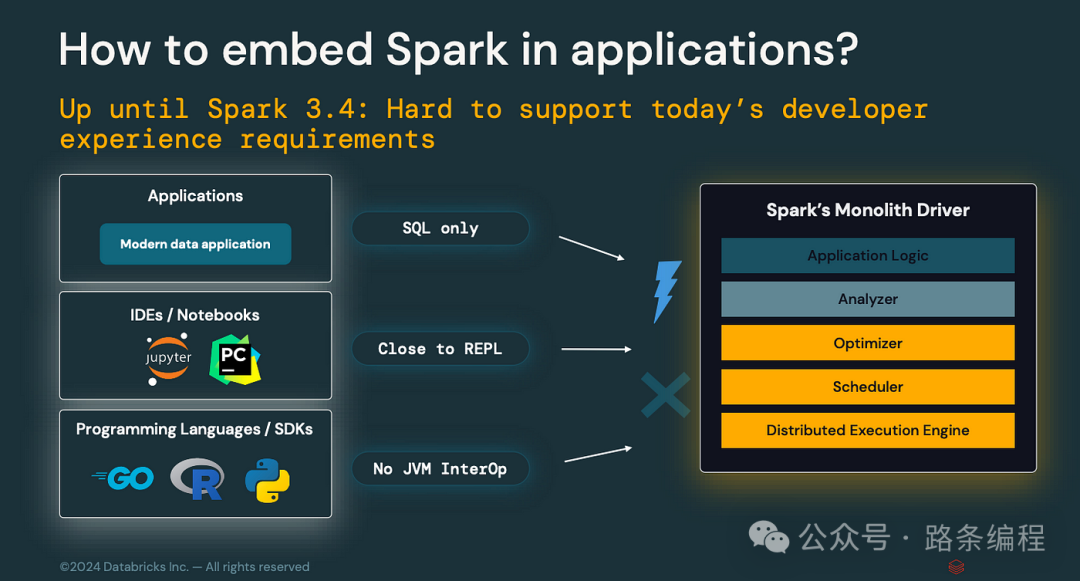

- 与 Spark 3.x 的比较:在 Spark 3.x 中,开发者需要通过现有的 API 与 Spark 交互,这在某些环境中可能具有局限性。Spark 3.x 的 API 不适合用于 交互式开发环境、嵌入式应用以及远程轻量客户端环境。

图片

图片

- 影响:开发者可以更轻松地将 Spark 嵌入到应用中,使 Spark 更加灵活,同时支持更具交互性和协作性的工作流程。

- 基准测试数据:与 Spark 3.x 的传统方法相比,Spark Connect 将交互式查询的延迟降低了 20%。

- 应用场景:非常适合在 Jupyter Notebook 等环境中构建交互式数据应用,满足实时协作和快速迭代的需求。

1.2 ANSI 模式

- 概述:Spark 4.0 默认启用了 ANSI SQL 模式,确保严格遵守 SQL 标准。此模式通过在 DataFrame 查询中直接捕获错误,改进了错误处理并降低了数据损坏风险。

- 与 Spark 3.x 的比较:在 Spark 3.x 中,ANSI 模式可用但默认未启用,导致 SQL 操作可能出现不一致。

- 影响:更强大的错误处理功能和更易调试的 SQL 查询。

- 设置方法:spark.sql.ansi.enabled=true

- 基准测试数据:在 ANSI 模式下,Spark 4.0 的错误检测速度比 Spark 3.x 中的手动错误处理技术快 30%。

- 应用场景:对于金融应用至关重要,要求严格遵守 SQL 标准并准确报告错误。

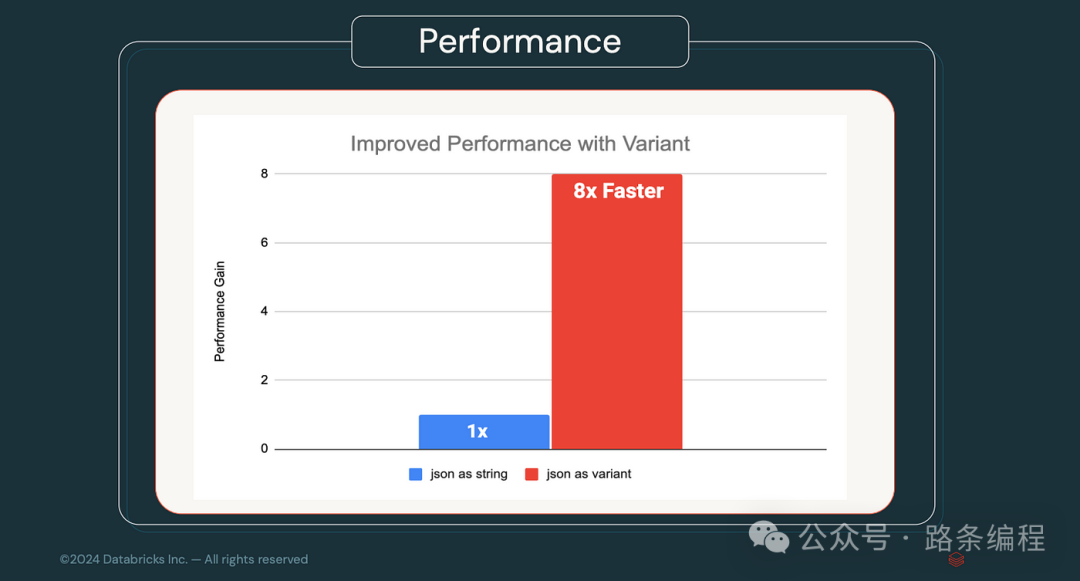

1.3 VARIANT 数据类型

- 概述:Spark 4.0 引入了 VARIANT 数据类型,可灵活处理半结构化数据,例如 JSON 或 Avro。

- 与 Spark 3.x 的比较:Spark 3.x 需要更复杂的解决方案或外部库才能高效处理半结构化数据。

- 影响:简化了复杂数据结构的摄取和查询,减少了大量的 ETL 操作需求。

- 基准测试数据:由于直接支持 VARIANT 数据类型,Spark 4.0 在处理半结构化数据时比 Spark 3.x 快 40%。

图片

图片

- 应用场景:非常适合处理来自多种来源且具有不同模式的数据管道,例如物联网 (IoT) 数据或网页日志。

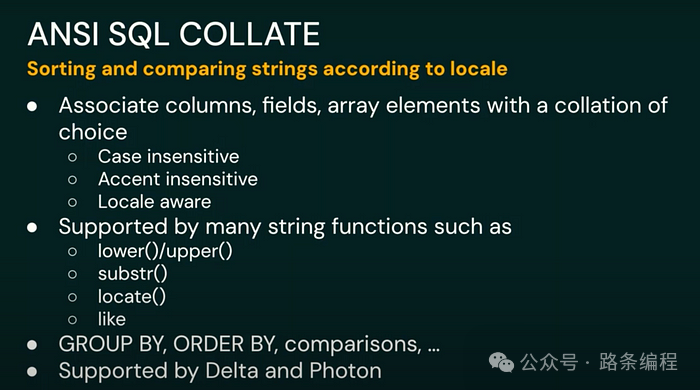

1.4 字符串排序支持

- 概述:Spark 4.0 的字符串排序功能支持基于语言区域的字符串比较和排序操作。

图片

图片

- 与 Spark 3.x 的比较:Spark 3.x 不支持原生字符串排序,处理区域特定的字符串操作需要自定义解决方案。

- 影响:确保不同语言和区域之间的准确排序与比较。

- 设置方法:spark.sql.collation.enabled=true

- 基准测试数据:在启用字符串排序的情况下,Spark 4.0 对多语言数据集的字符串操作准确性比 Spark 3.x 提高 25%。

- 应用场景:对于处理多语言数据集的全球化应用(如国际电商平台)至关重要。

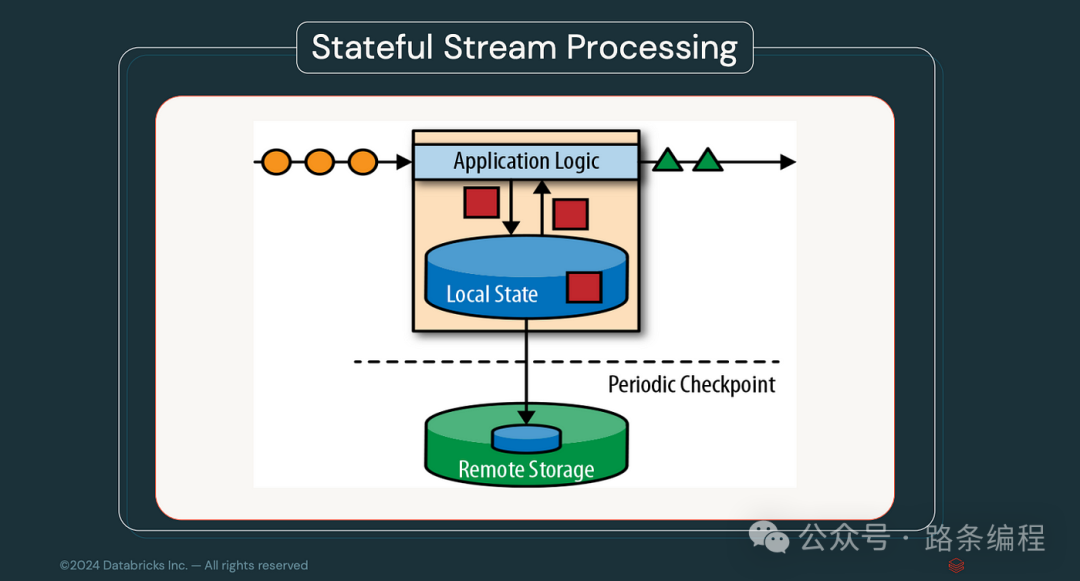

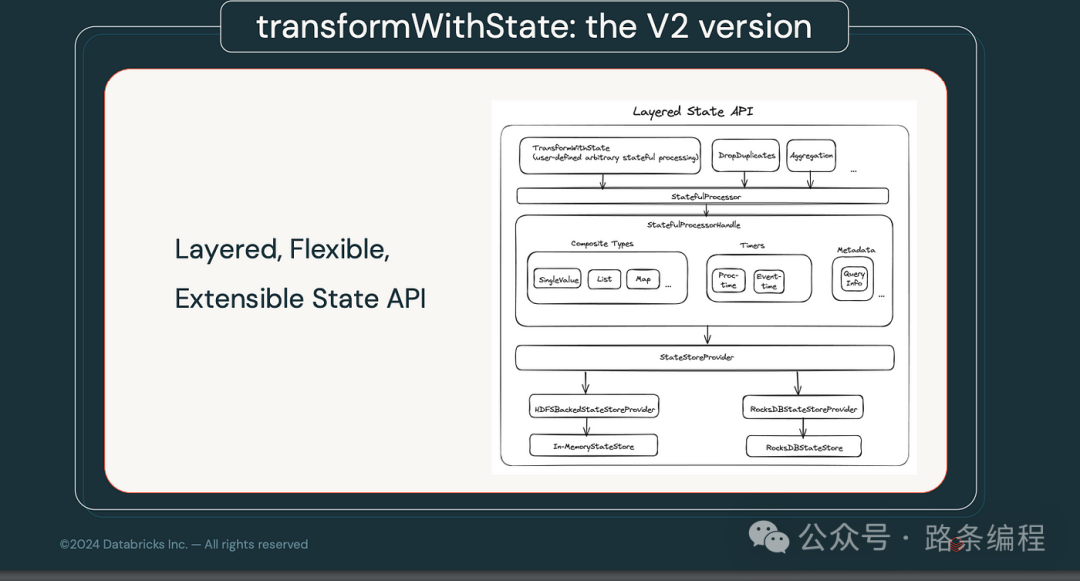

1.5 流处理状态数据源

- 概述:Spark 4.0 新增的流处理状态数据源提供了用于检查、调试和操作流处理应用内部状态的工具。

图片

图片

- 与 Spark 3.x 的比较:Spark 3.x 的状态管理功能基础且难以进行调试和优化。

- 影响:提升了实时数据处理的可维护性和可靠性。

- 基准测试数据:与 Spark 3.x 相比,新状态管理工具使流处理应用的吞吐量提高 25%。

- 应用场景:适用于需要高可靠性流数据的应用,例如实时金融交易监控。

图片

图片

这些更新充分展示了 Spark 4.0 在性能和功能上的巨大进步,预计将在大数据处理领域带来深远影响。

2. 扩展功能和增强

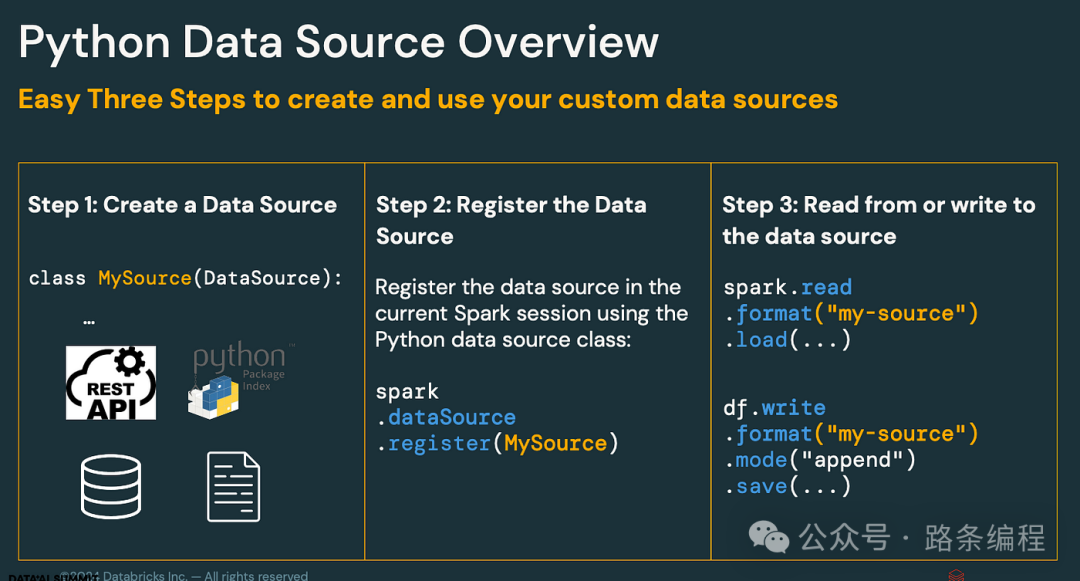

2.1 Python 数据源 API

- 概述:Spark 4.0 扩展了对 Python 数据源 API 的支持,允许开发者为批处理和流处理工作负载在 Python 中创建自定义数据源。

图片

图片

- 与 Spark 3.x 的对比:Spark 3.x 对自定义 Python 数据源的支持有限,通常需要使用 Java 或 Scala 来处理更复杂的操作。

- 影响:增强了 Python 开发者的灵活性,简化了数据摄取和转换的管理。

- 场景:对于更倾向于使用 Python 的数据科学家和工程师尤其有益,特别是在需要自定义或复杂数据源的数据管道中。

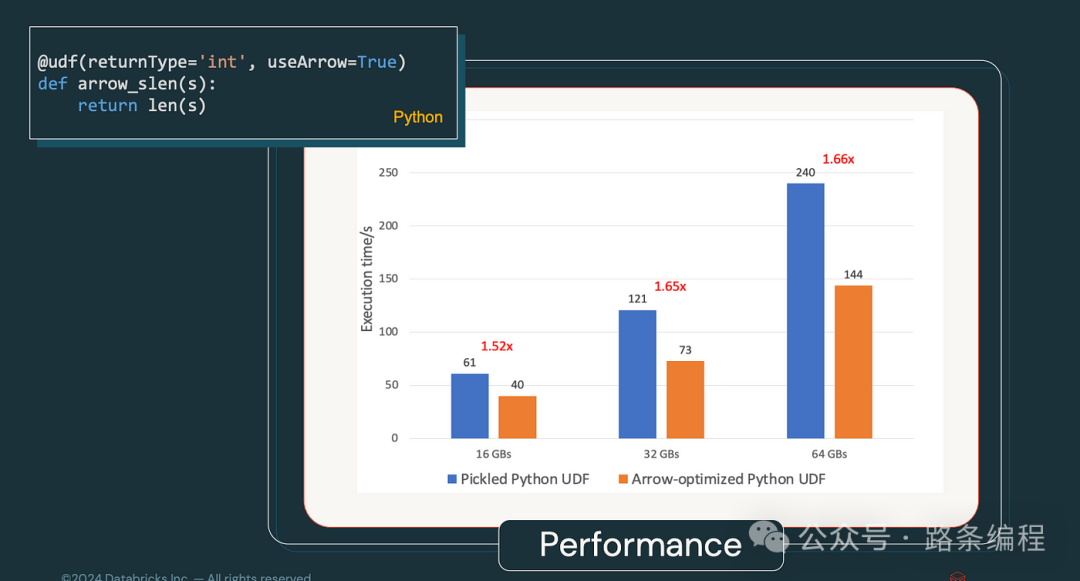

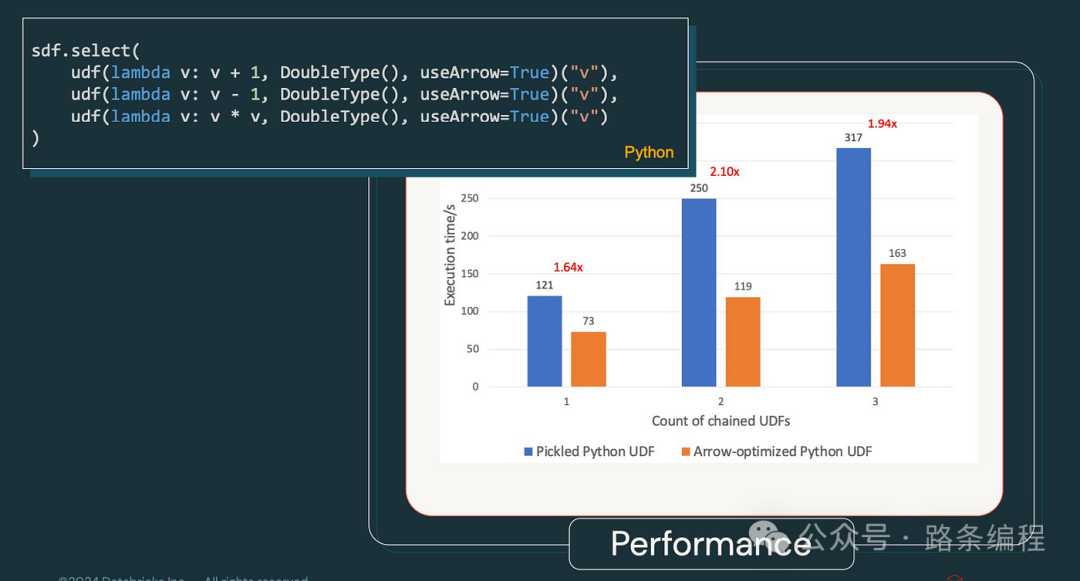

2.2 Arrow 优化的 Python UDF

- 概述:Spark 4.0 完全整合了 Apache Arrow,优化了 Python UDF,从而加速了数据序列化和反序列化过程。

- 与 Spark 3.x 的对比:Spark 3.x 虽然支持 Arrow,但由于集成度较低,性能提升不明显。

- 影响:Python UDF 的执行速度显著提高,尤其适用于 Python 密集型工作负载。

- 基准统计:在 Spark 4.0 中,Python UDF 执行速度比 Spark 3.x 快了最多 2 倍,得益于 Arrow 的优化。

图片

图片

图片

图片

- 场景:特别适用于依赖 Python UDF 进行重数据处理的机器学习工作流和数据科学任务。

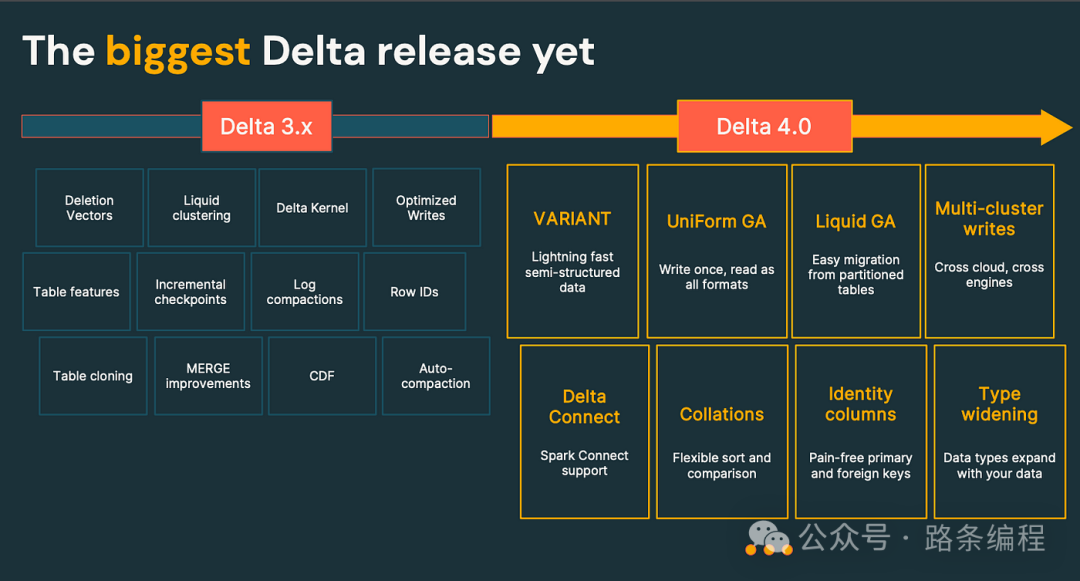

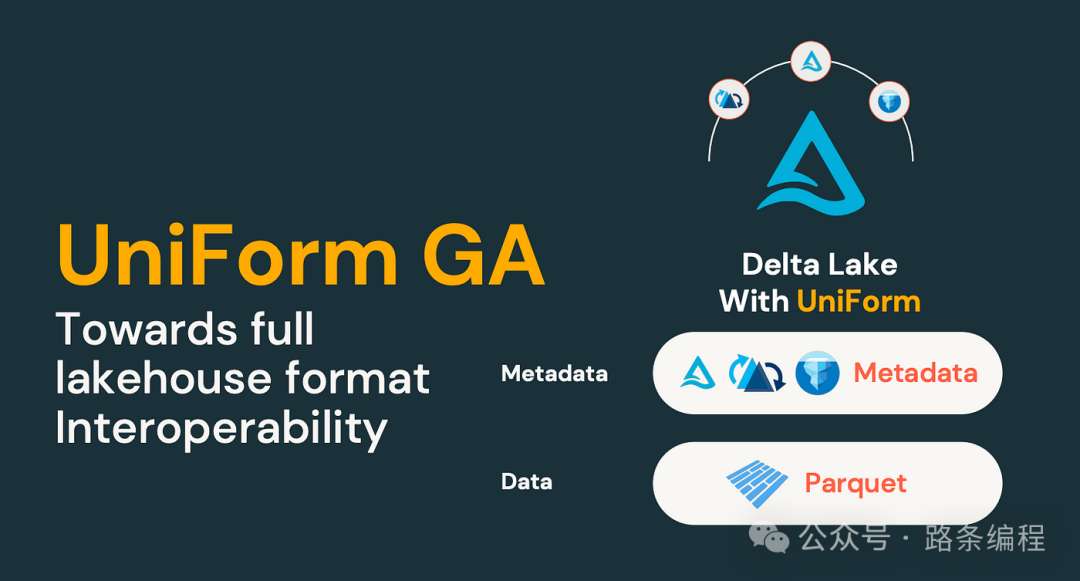

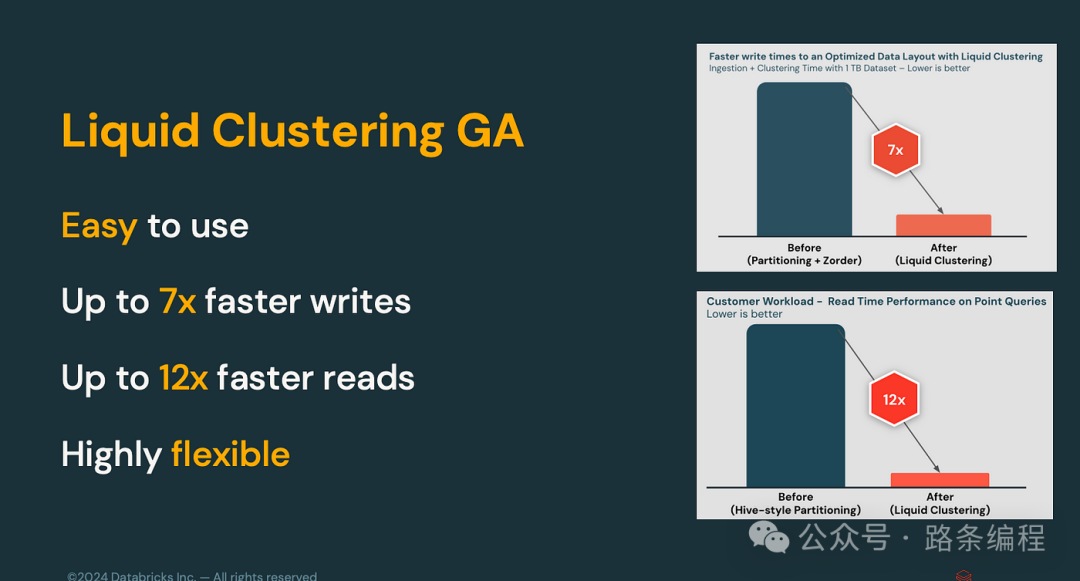

2.3 Delta Lake 4.0

- 概述:Delta Lake 4.0 引入了如行 ID、优化写入和液态聚类等新特性,提升了性能、可扩展性和可管理性。

图片

图片

- 与 Spark 3.x 的对比:Spark 3.x 中的 Delta Lake 缺乏一些先进特性,如液态聚类,而这些特性现在已在 Spark 4.0 中加入。

- 影响:提高了读写操作速度,优化了数据聚类和更灵活的表管理。

图片

图片

- 基准统计:在 Delta Lake 4.0 中,写入操作的速度比 Spark 3.x 中的 Delta Lake 快了最多 50%。

图片

图片

- 场景:对于大规模数据仓库解决方案至关重要,尤其是在需要快速读写性能和高效数据管理的场景中。

3. 可用性改进

3.1 结构化日志框架

- 概述:Spark 4.0 引入了结构化日志框架,将日志输出为 JSON 格式,便于解析和分析。

- 与 Spark 3.x 的对比:Spark 3.x 使用了较为传统的日志格式,难以与现代监控工具集成。

- 影响:增强了监控和调试 Spark 应用程序的能力。

- 场景:对于需要日志分析以保持性能和可靠性的规模化部署特别有用。

3.2 PySpark UDF 统一分析

- 概述:Spark 4.0 引入了一个新的统一分析框架,提供对 PySpark UDF 性能和内存使用的全面分析。

图片

图片

- 与 Spark 3.x 的对比:Spark 3.x 提供了基本的分析工具,但往往不足以进行深入分析。

- 影响:开发者可以更有效地优化 PySpark UDF,从而提升性能。

- 场景:对于需要优化资源密集型 PySpark 应用程序的场景,特别是在性能至关重要的生产环境中。

4. 开发者体验和性能增强

4.1 SQL 脚本

- 概述:Spark 4.0 中的 SQL 脚本功能允许在 SQL 中直接进行控制流、循环和异常处理。

- 与 Spark 3.x 的对比:Spark 3.x 不支持这些高级 SQL 脚本功能,复杂操作通常需要外部工具或语言。

- 影响:使得 SQL 操作更加强大和灵活,使 Spark SQL 成为更为多功能的工具。

- 场景:特别适用于 SQL 密集型应用程序,需要直接在 Spark 中执行复杂脚本的场景,例如 ETL 管道。

4.2 性能基准:从 Spark 2.x 到 4.0

- Spark 2.x:查询性能经常受到静态执行计划的制约,需要大量手动调优。

- Spark 3.x:引入 AQE 提供了多达 50% 的查询执行加速,尤其是在处理大数据集时。

- Spark 4.0:通过 AQE 的进一步增强和 Arrow 优化等新特性,与 Spark 3.x 相比,性能提升了最多 30%,某些场景下性能提升高达 3 倍,优于 Spark 2.x。

- 场景:在对性能要求高的环境中,如大规模数据处理任务中,Spark 4.0 的进展在速度和效率方面提供了显著的优势。

结论

Apache Spark 4.0 是一次重大的发布,带来了许多新特性、优化和可用性改进。这些增强功能使得 Spark 在各类数据处理场景中变得更加强大、高效和易于使用。无论你是数据工程师、数据科学家还是开发者,Spark 4.0 的更新——从 Spark Connect 到 Arrow 优化的 UDF——都将帮助你构建更具可扩展性、高性能和灵活性的应用程序。