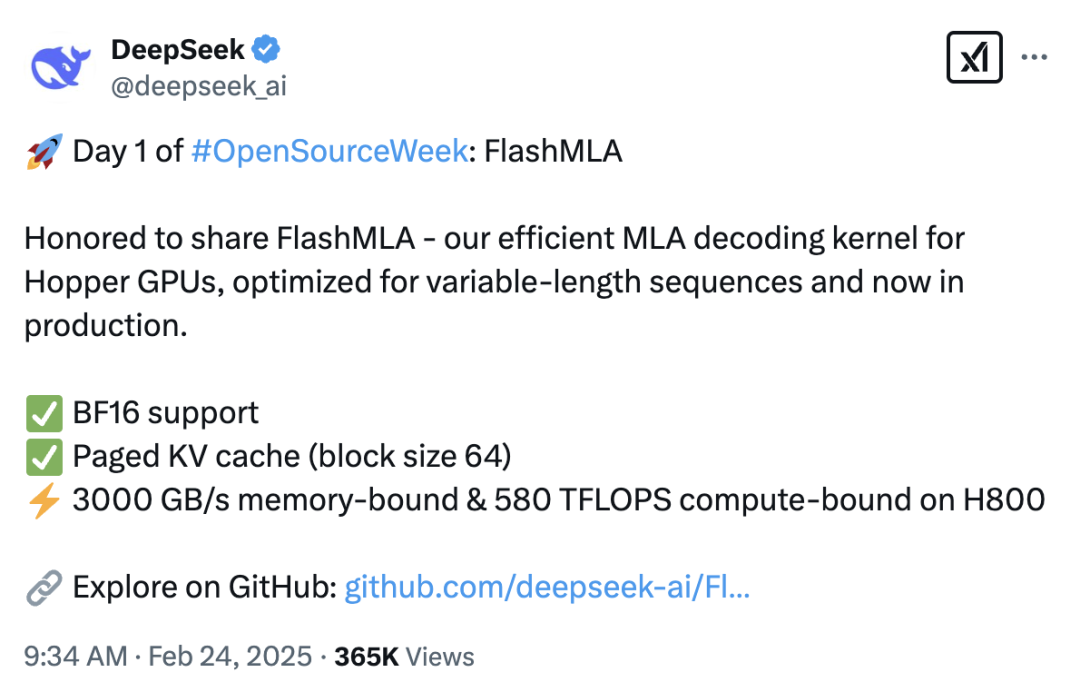

2025 年 2 月 24日,中国 AI 领域明星公司 DeepSeek 正式启动“开源周”,并甩出首张技术王炸 —— FlashMLA。这款专为 NVIDIA Hopper GPU 优化的高效解码内核,针对多头潜注意力(MLA)进行了深度优化,尤其在处理变长序列的大型语言模型(LLM)推理场景中表现出色。

图片

图片

FlashMLA 是什么?

FlashMLA 是 DeepSeek 为 Hopper 架构 GPU(如英伟达 H100/H800)量身打造的多层注意力机制(MLA)解码内核。其核心目标是通过动态内存调度与并行计算优化,显著提升大语言模型(LLM)的推理效率,尤其在处理可变长度序列时表现突出。

FlashMLA 性能有多强?

FlashMLA 在 H800 SXM5 GPU 上展现了惊艳的性能,基于 CUDA 12.6 测试数据如下:

- 内存受限场景:处理速度高达 3000 GB/s。

- 计算受限场景:算力达到 580 TFLOPS。

FlashMLA 的工作原理

FlashMLA 在处理可变长度序列方面表现出色,这是自然语言处理和生成式 AI 等任务中常见的挑战。传统的解码内核通常难以应对这种不规则的数据,从而导致性能瓶颈。FlashMLA 通过在 Hopper GPU 上优化内存使用和计算,解决了这一问题,确保无论输入大小如何,都能实现流畅高效的性能。

FlashMLA 真正的创新在于对 BF16 的支持以及具有块大小为 64 的分页 KV 缓存。这些特性最大程度地减少了内存开销并降低了延迟,使 FlashMLA 成为实时 AI 应用的理想选择。对于开发者而言,这意味着更快的模型训练和推理,尤其适用于复杂且动态的数据集。

Deepseek 还借鉴了 FlashAttention 2&3 和 CUTLASS 等项目的经验,并将这些最佳实践融入 FlashMLA 中。

FlashMLA 的优势

- 专为 Hopper GPU 优化性能FlashMLA 针对 NVIDIA Hopper GPU(如 H800)量身打造,利用其先进的 Tensor Cores 和 Transformer Engines,实现 3000 GB/s 的内存带宽和 580 TFLOPS 的计算性能。这种优化让它能高效处理 LLM 等 AI 应用的高强度计算需求。

- 支持变长序列处理FlashMLA 针对变长序列进行了优化,非常适合自然语言处理(NLP)任务。无论是句子还是文档,输入长度变化无常,它都能灵活应对,使其成为聊天机器人、翻译系统和文本生成等现实应用的理想选择。

- 高效的内存管理通过块大小为 64 的分页 KV 缓存,FlashMLA 提升了内存效率并减少了解码时的延迟。这种分页方式将数据拆分为易管理的块,尤其对内存受限的大型模型表现优异,避免了性能瓶颈。

- BF16 精度的高效支持FlashMLA 采用 BF16 格式,在保持足够精度的同时降低内存使用并加速计算。相比 FP32,这种紧凑格式特别适合在资源有限的硬件上部署 LLM 或扩展至更大模型。

- 助力更大规模 AI 模型通过优化数据传输和内存使用,FlashMLA 支持推理超出 GPU DRAM 容量两倍的模型,速度提升显著(CPU 上 4-5 倍,GPU 上 20-25 倍)。这意味着无需昂贵硬件升级即可运行超大规模 LLM。

FlashMLA 对 AI 的影响

FlashMLA 诞生于人工智能发展的关键时刻。2025 年初,xAI 将发布 Grok 语音模式,这将为实时人工智能交互设定新的基准,而 FlashMLA 则优化了后端基础设施,以应对日益增长的对人工智能模型速度和效率的需求。

医疗保健和金融等行业将从中受益匪浅。想象一下实时分析患者数据或高频交易算法,速度以毫秒计算。FlashMLA 的高性能可以彻底改变这些领域,推动创新和效率的提升。

Deepseek 的开源策略也促进了人工智能的道德发展。像 FlashMLA 这样的工具能够平衡竞争环境,使小型团队能够与大型公司竞争,尤其是在世界范围内推动人工智能开发透明化的背景下。

总结

FlashMLA 仅仅是个开始。Deepseek 的开源周预示着一系列创新发布即将到来。我们可以看到针对其他 GPU 架构的改进、扩展的 BF16 支持以及与新兴 AI 框架的集成。接下来的开源周会带来什么?让我们拭目以待。

参考资料

- deepseek-ai/FlashMLA:https://github.com/deepseek-ai/FlashMLA