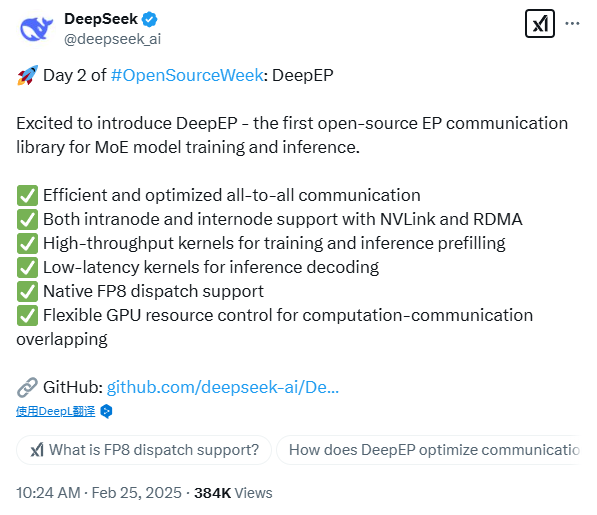

DeepSeek开源第二日!又是重磅炸弹——DeepEP。

这可是用于 MoE 模型训练和推理的全球首个开源 EP 通信库!

今天的开源项目仍然围绕着GPU资源优化的主题,看来DS真的很懂怎么榨干英伟达芯片的算力。

💫特点:

1️⃣高效、优化的全对全通信(All-to-All Communication)

2️⃣利用 NVLink 和 RDMA 支持节点内和节点间通信

3️⃣用于训练和推理预填充的高吞吐量内核

4️⃣用于推理解码的低延迟内核

5️⃣本机 FP8 调度支持

6️⃣用于计算-通信重叠的灵活 GPU 资源控制

⭐️DeepEP通信库是什么:

首先来看EP,EP(Expert Parallelism)是一种并行计算方法,专门用于稀疏专家(MoE, Mixture of Experts)模型的训练和推理。MoE 模型会根据输入数据选择性地激活部分专家(Experts),而不是让所有参数都参与计算,这样可以在保持较大模型容量的同时提高计算效率。

EP(Expert Parallelism)本身的难点主要来自 MoE(Mixture of Experts)模型的动态计算分配,MoE 训练不同于普通 Transformer 训练,由于专家被分散在多个 GPU 上,大量数据需要跨 GPU 传输,导致 All-to-All(全对全)通信 成为瓶颈。

EP 通信库是专门为 MoE 模型设计的高效通信库,优化了专家之间的数据传输,主要用于 训练和推理时的分布式计算加速。MoE 需要动态选择激活的专家,EP 通信库可以高效地在不同 GPU/节点之间分配计算任务。

🌟意义:

传统的模型并行方式(如张量并行 TP、流水线并行 PP)无法很好地处理 MoE 模型的动态专家选择,而 EP 专门针对 MoE 进行优化,能提高计算利用率、减少 GPU 闲置,并让更大的 MoE 模型训练和推理变得更加高效。

众所周知,DeepSeek才是真正的“OpenAI”!

有了这一波的技术分享,相信我们“揭开 AGI 的神秘面纱”的那一天又近了一步。