1. 前言

今天分享的是提示工程(prompt engineering),我们大概可以将其理解为用简单明了的话告诉AI你需要什么,比如先讲清任务,再加例子或背景,这样AI才能更懂你,给出更准更有用的回答!

2025年注定不平凡,大模型百花争放,闭源的守着自己的一亩三分地不断深耕,开源的出来就是王炸,开源大模型以DeepSeek为首的尤其突出,随后OpenAI,百度文心一言等相继传出部分大模型免费开放给用户使用。。

普通老百姓现在能做的就是学会如何同人工智能交流,并得到你要的结果。

2. 如何向大模型提问

首先现在的大模型都是指令型大模型,也就是通过指令可以不断训练出自己的大模型,因此我们应该学习如何写好指令让大模型为我所用。

学好指令的关键就是理解指令,指令就是提示,即prompt,就是如何写出一些提示,让大模型足够了解你的意图,但是这样往往还不够,还得输入上下文,情绪,样例以及其他补充等。也就是说你给大模型给的信息越全,它越能够理解你的意图并输出满意的答案。

目前我们先根据大家接受的程度分别举两个例子,这俩例子就是简单指令和coT(chain of Thought)思维链指令。

1)简单指令

简单指令就是我们可以通过一些基础指令再加上一些上下文等方式给出,或者更简单的讲就是你给别人讲一个事情,如果一句话不能说明白的,就把背景,期望等都加上,你能确保他能理解就行,如果还不能理解就继续补充相关内容。

例如:

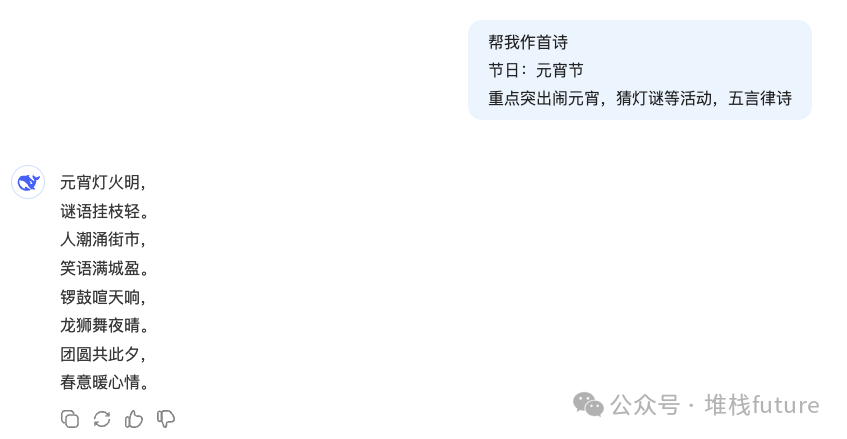

图片

图片

帮我作首诗,这是我的任务同时也是一条指令,另外我也补充了上下文,关于元宵节活动并且还是五言律诗,因此模型毫无含糊给出了我想要的答案。

但是如果我不提供更多的上下文,那么很有可能输出结果不是我想要的,例如:

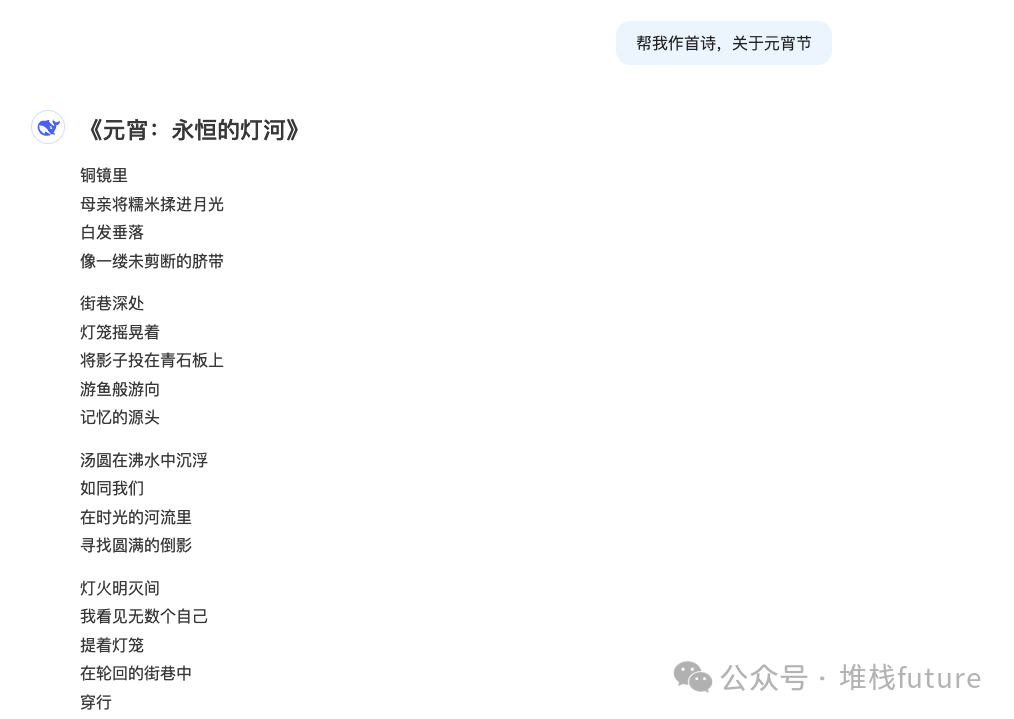

图片

图片

因此写好指令可以让大模型能更懂你。

2)coT指令

思维连(coT)提示过程核心在于鼓励大模型解释其推理过程,主要思想就是通过像大模型展示一些少量的例子,在例子中解释其推理过程,这样的话大模型在回答提示时也会显示推理过程,这种推理的解释往往会引导出更准确的结果。

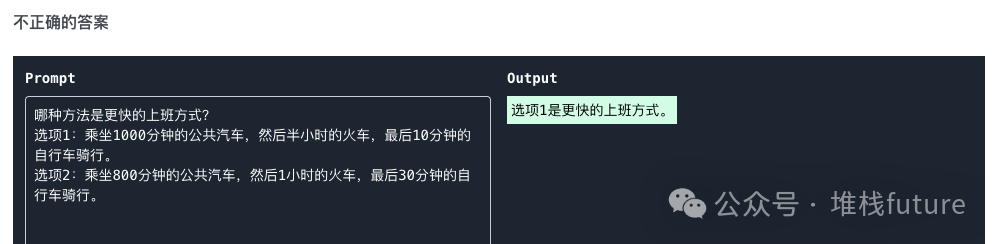

coT指令能解决简单指令无法解决的问题,比如来自网友的一段简单指令的截图:

图片

图片

很明显大模型给的答案是错的,正确答案是选项2。

那正确的答案怎么得来呢?请看以下截图:

图片

图片

就是在简单指令的基础上给出一些样例并且解释其推理过程,那么大模型就会自己按照coT给出自己的推理结果,这种答案几乎是完美的,因此学好coT指令可以让大模型像人类一样思考,交出完美的答案。

3. prompt总结

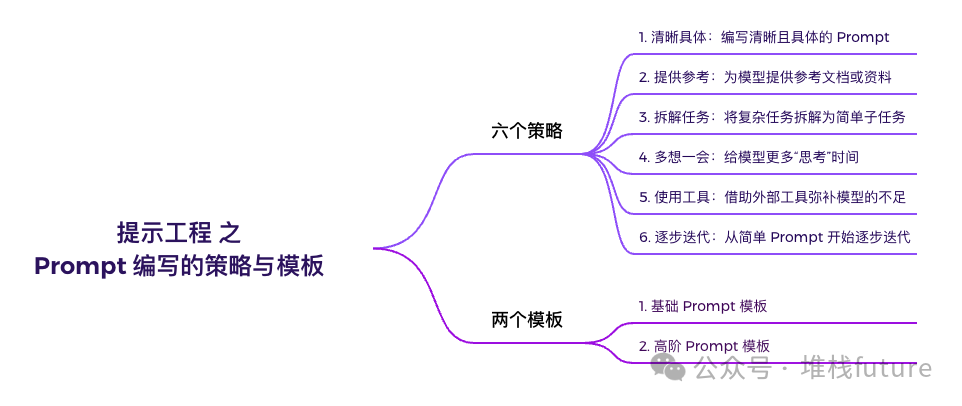

其实学好prompt还有好多策略以及模板,如图:

图片

图片

学好6个策略和2个模板之后,你就可以应对复杂的场景任务,后续文章会详细介绍。