随着 AI 大模型的爆发,DeepSeek 作为一款备受瞩目的开源大模型,吸引了众多开发者的关注。如何在本地搭建 DeepSeek 推理环境,以便更高效地进行 AI 研究和应用开发?本篇文章将为你详细解析本地部署 DeepSeek 的完整流程,让你轻松打造属于自己的 AI 推理环境。

准备工作

首先我们要准备一台电脑,配置越高当然越好,不过我的测试本是一个比较老旧的 MBP,配置如图:

同时,要在本地搭建好 Python 环境,这个不在这里赘述。

接下来本文将详细介绍如何在本地部署 DeepSeek 蒸馏模型,内容主要包括 Ollama 的介绍与安装、如何通过 Ollama 部署 DeepSeek,在 Cherry Studio 中使用 DeepSeek。

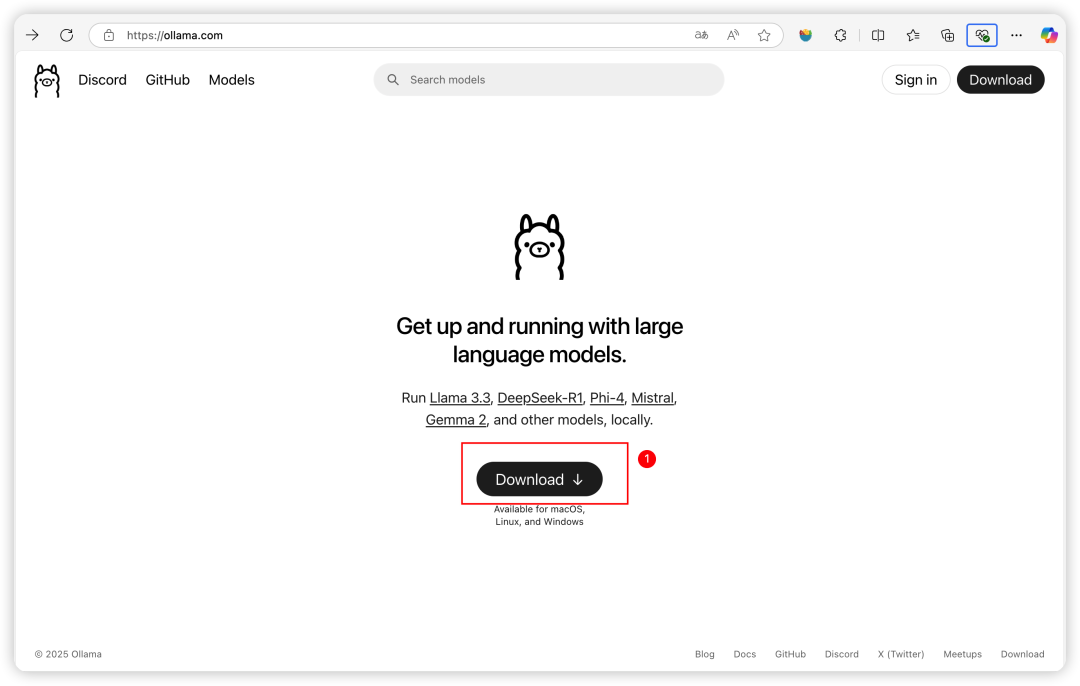

安装 Ollama

首先打开 Ollama 的官方网站:https://ollama.com/,如图:

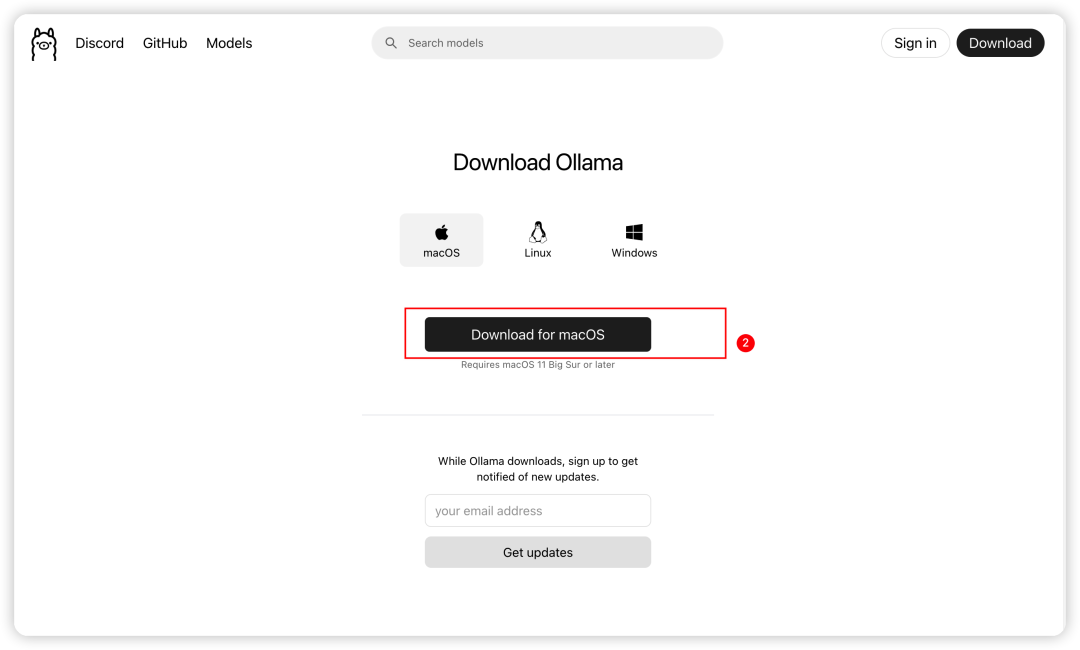

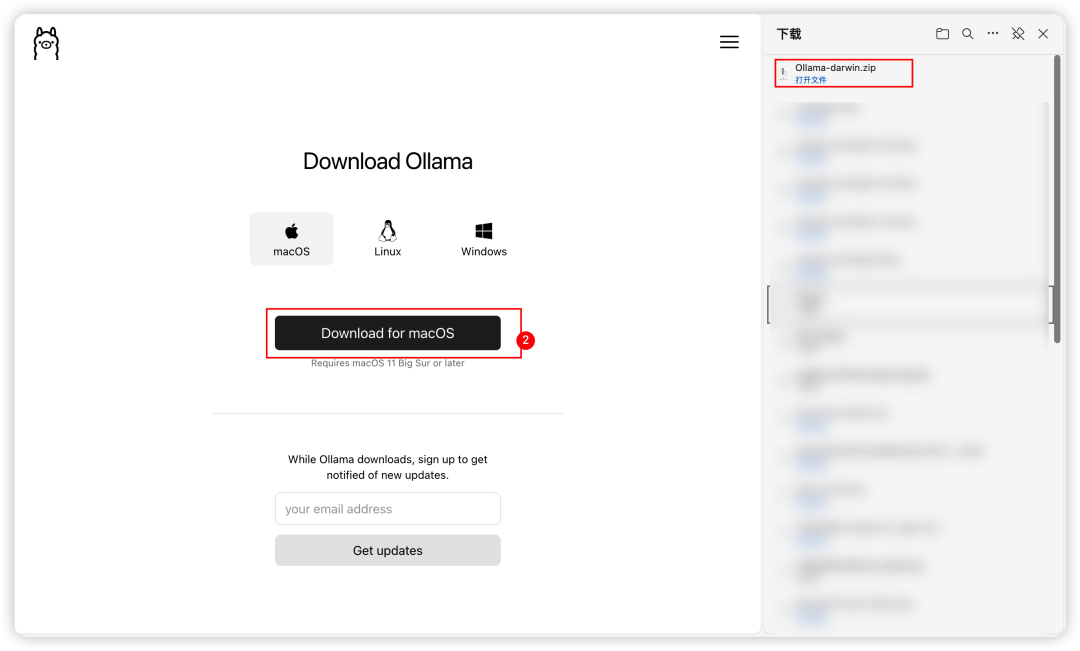

点击 Download,会进入到如下页面:

点击 Download for macOS 即可进行下载。

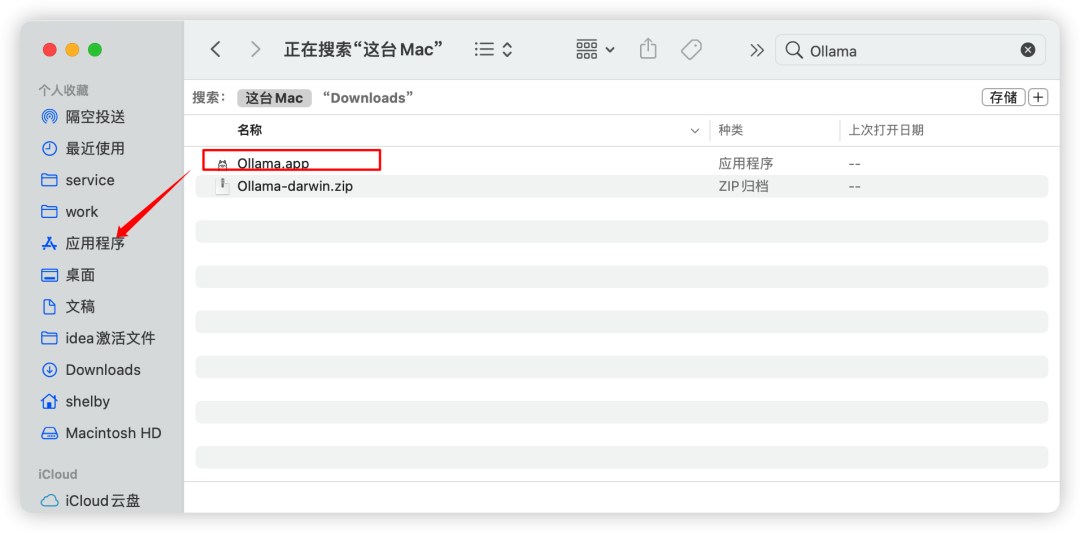

下载完成后解压安装。解压后会产生一个 Ollama.app。我们只需要将这个 app 移动到应用程序中即可。如图:

然后接下来我们找到应用程序中的 Ollama,点击进行安装。

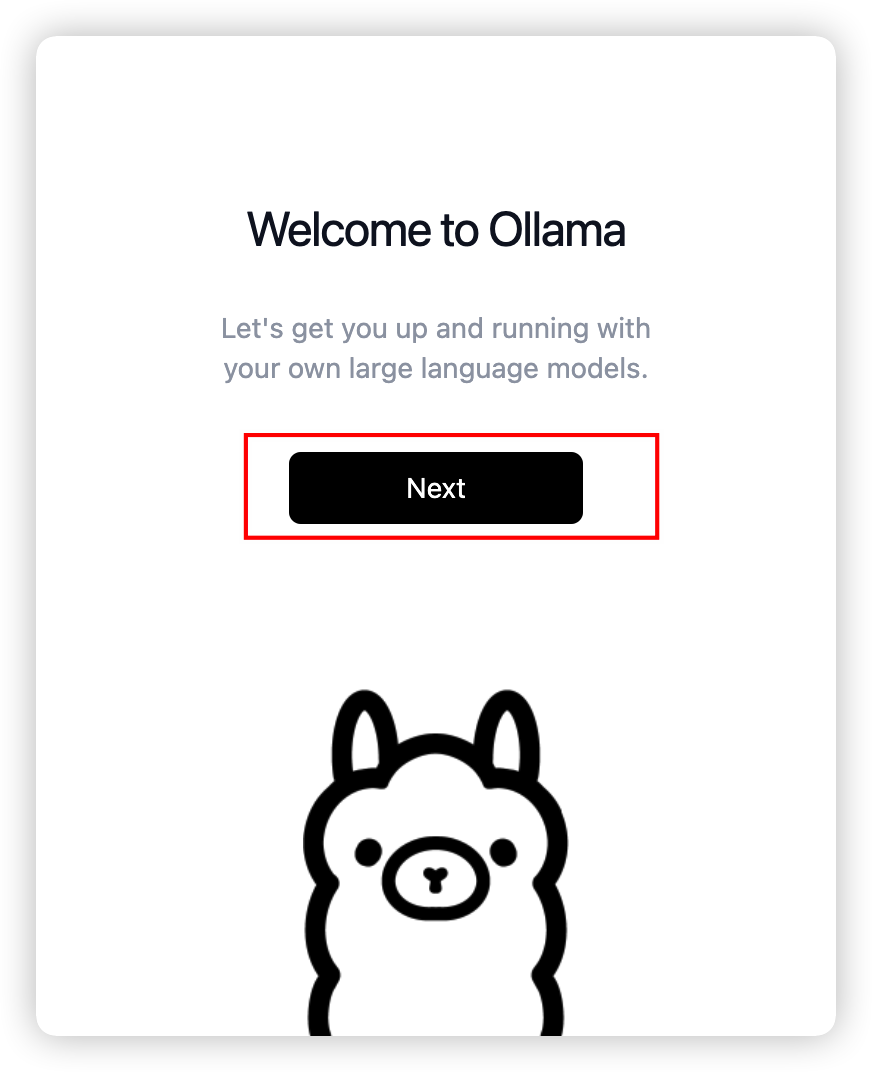

会出现如图所示的页面,只需点击 Next 即可。

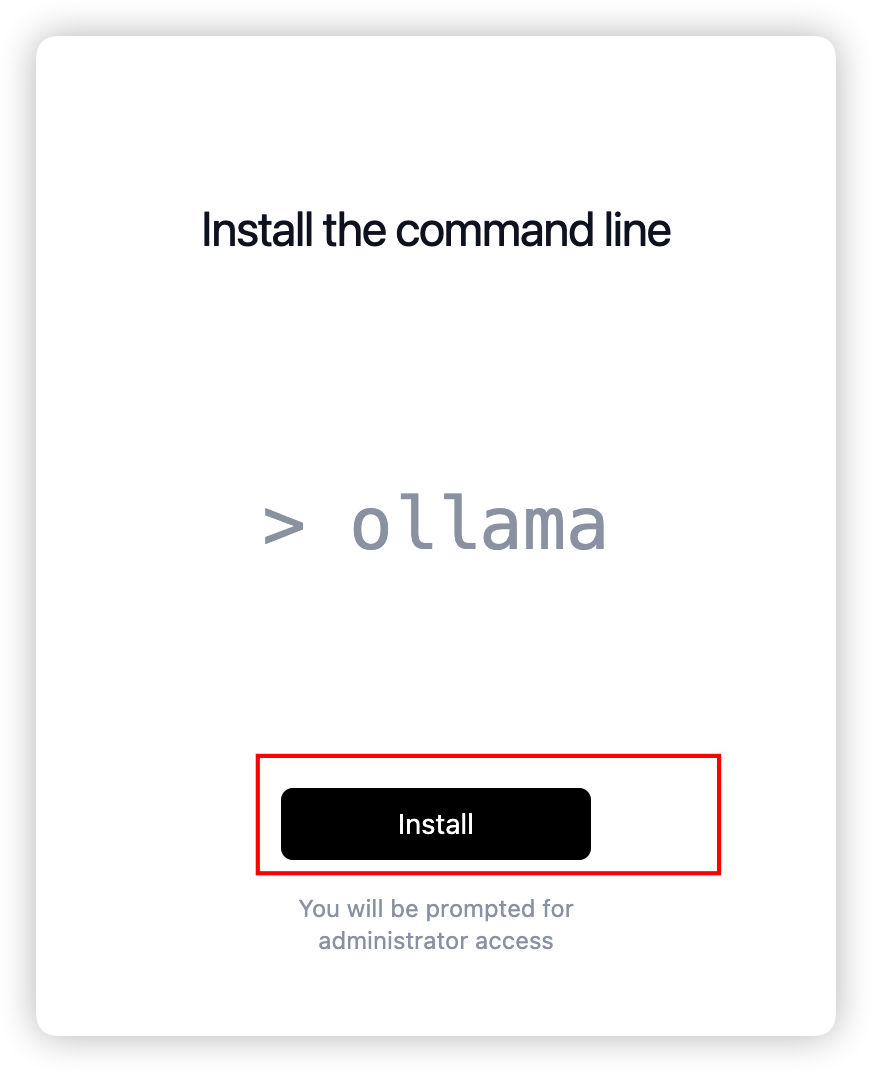

当点击完 Next 后会出现下图所示的页面,我们继续点击 Install 即可。

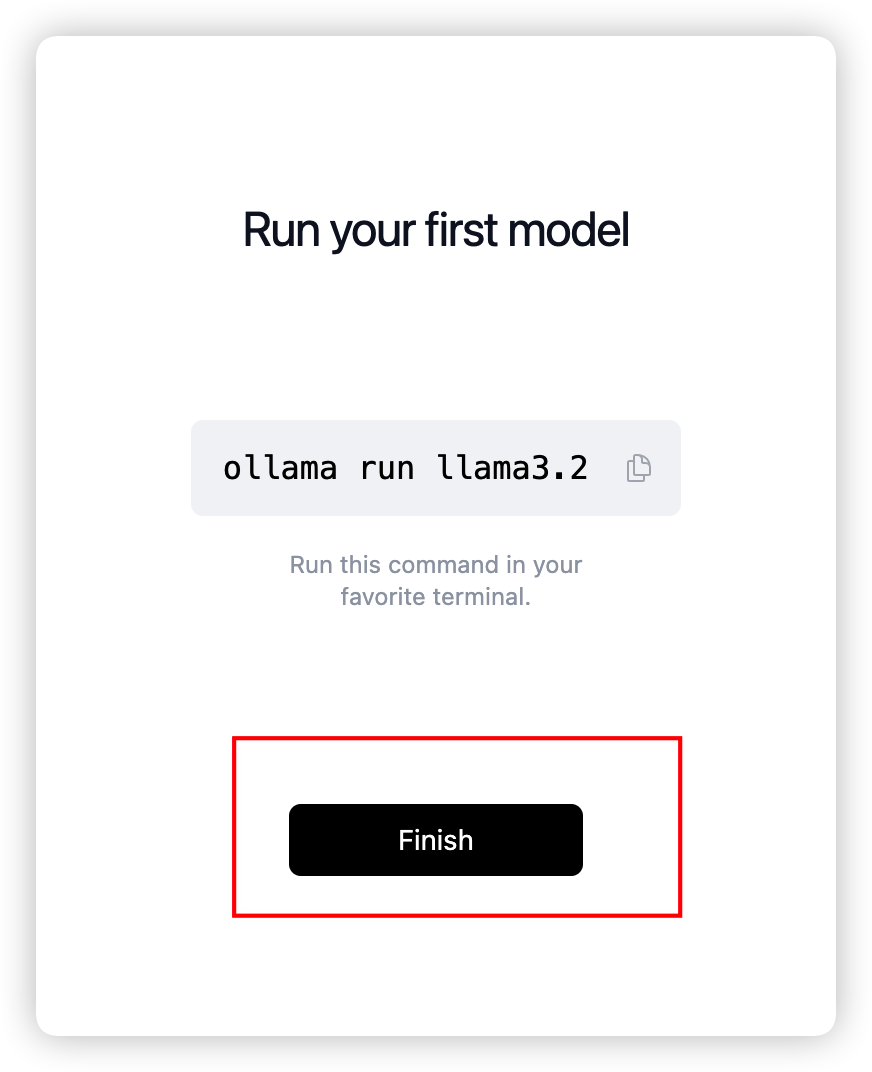

最后会出现 Finish 页面,

安装好 Ollama 后 Mac 的通知栏会有一个类似下图的下图标,说明安装完毕。

至此 Ollama 安装告一段落。

配置 Models

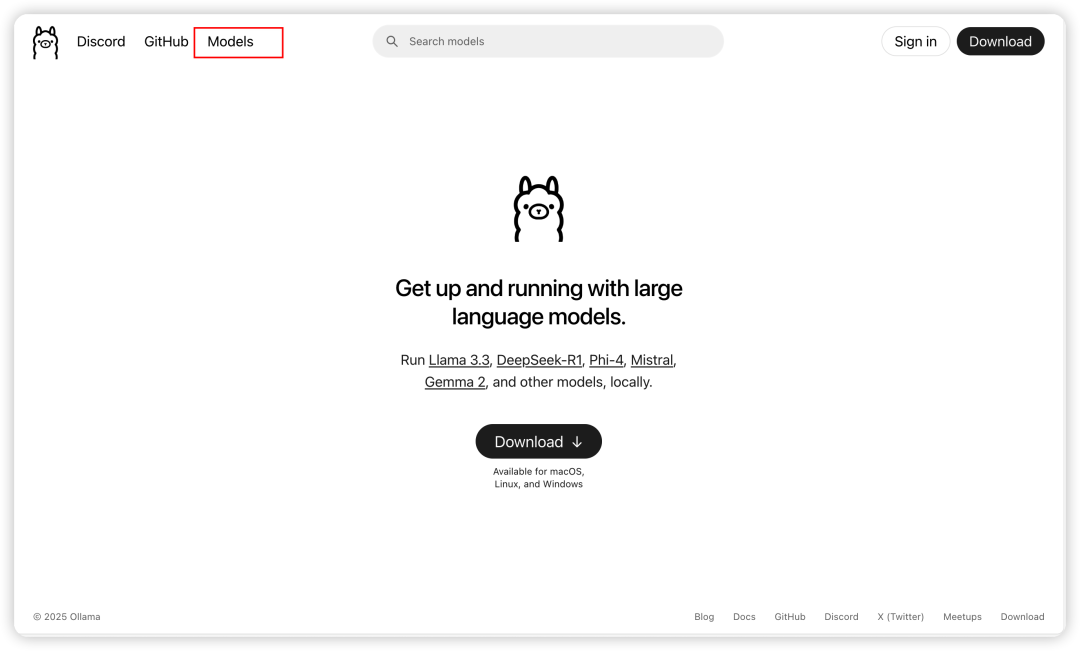

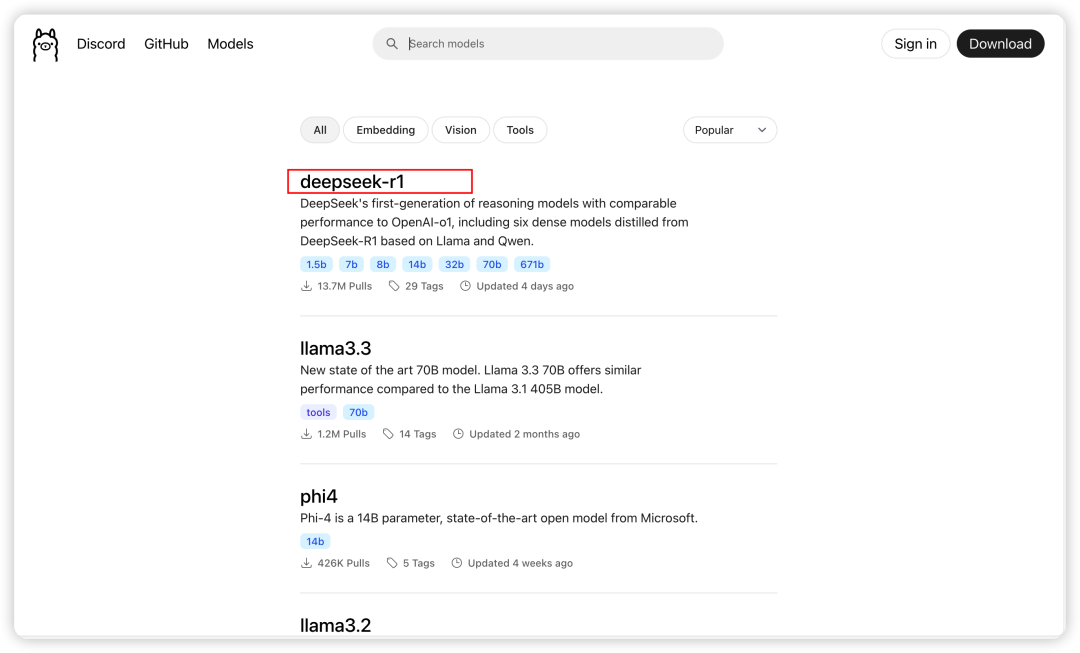

当安装完 Ollama 后,我们需要回到 Ollama 的官网找到 Models 去下载我们的模型,如图:点击 Download。

点击完 Download 后会出现下图所示的页面,也就是我们所需要的东西:

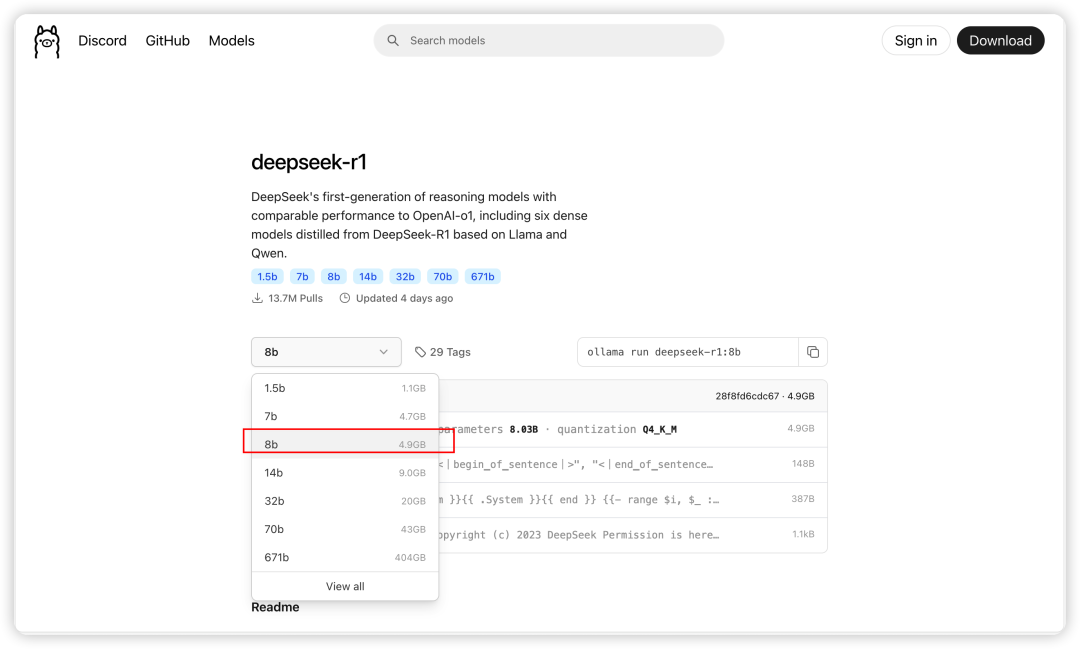

我们点击 deepseek-r1。此时会出现如下页面:

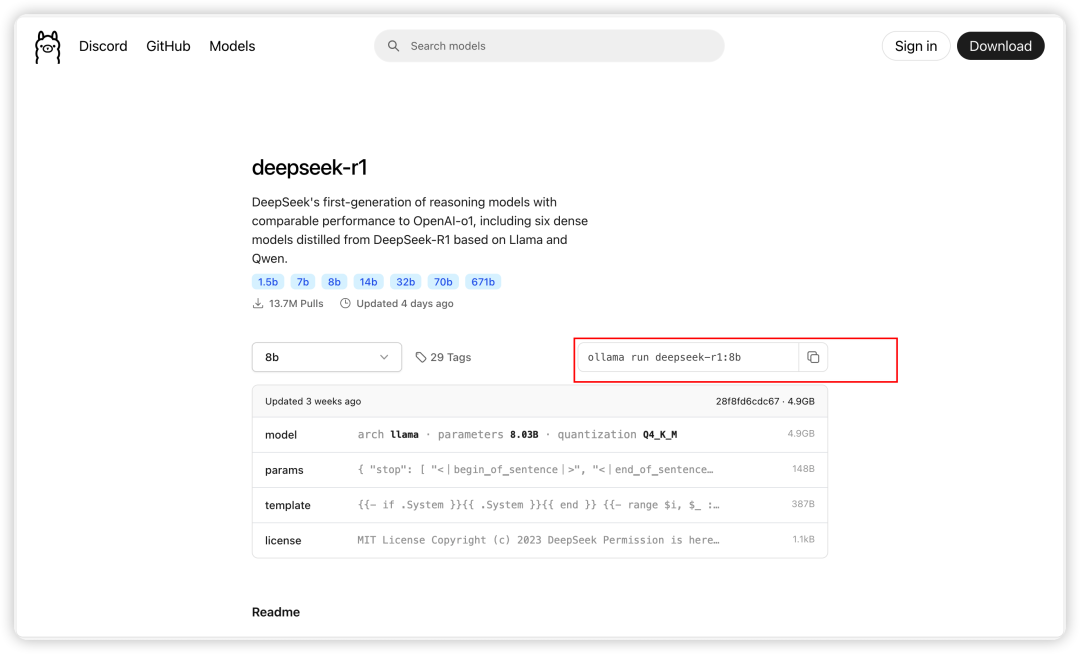

因为测试电脑的硬盘原因我们选择的是 8B 版的。可因个人需要进行调整。选择好 8B 版本后。复制图中的命令进行留存,后面会用到。

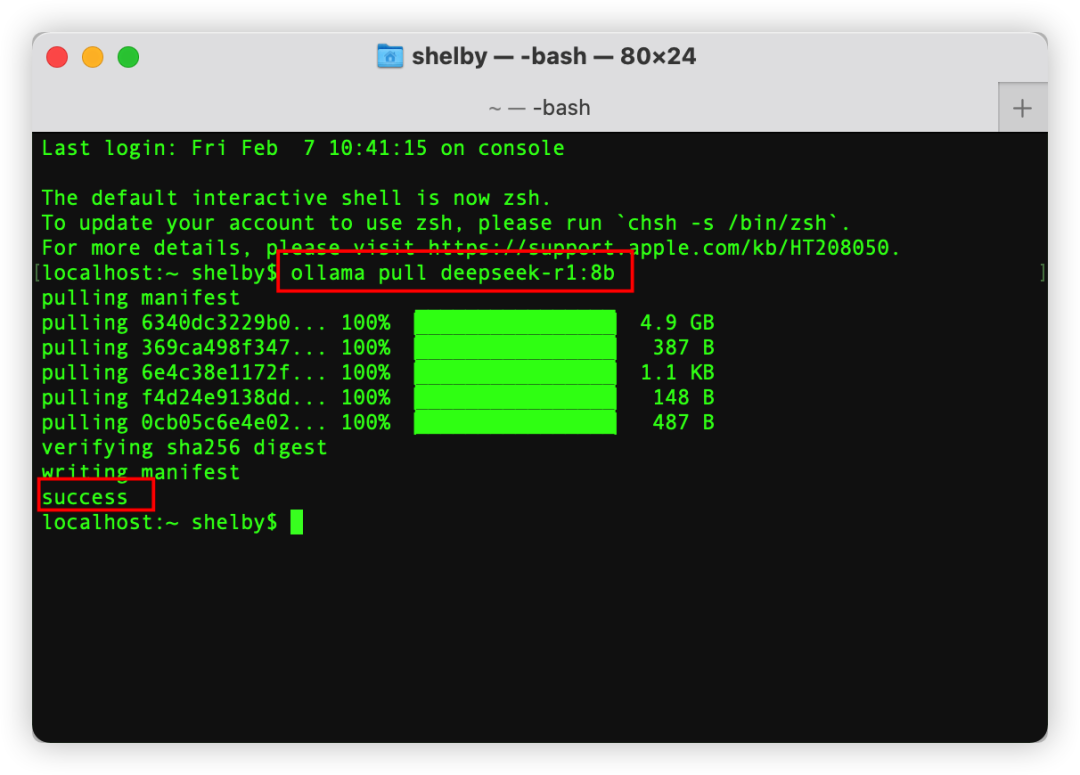

打开我们 Mac 的终端。输入上面我们记住的命令。记住要将命令中的 run 替换成 pull 然后执行下载。结果如图所示,出现 success 说明安装成功。

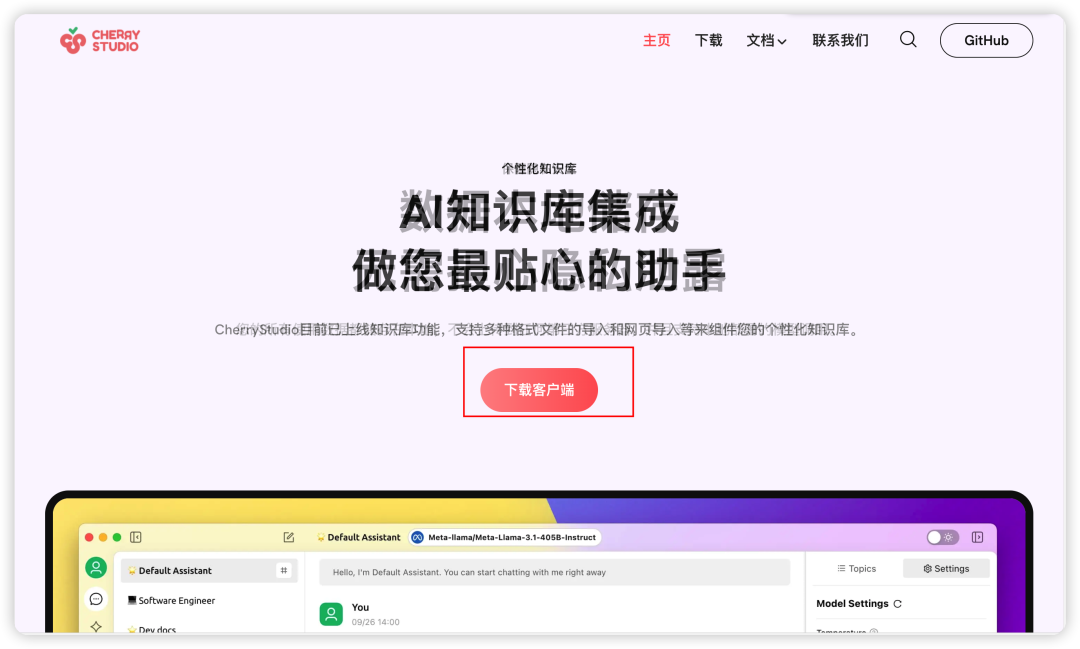

安装配置 Cherry Studio

首先打开 Cherry Studio 官网:https://cherry-ai.com 点击下载客户端。如图:

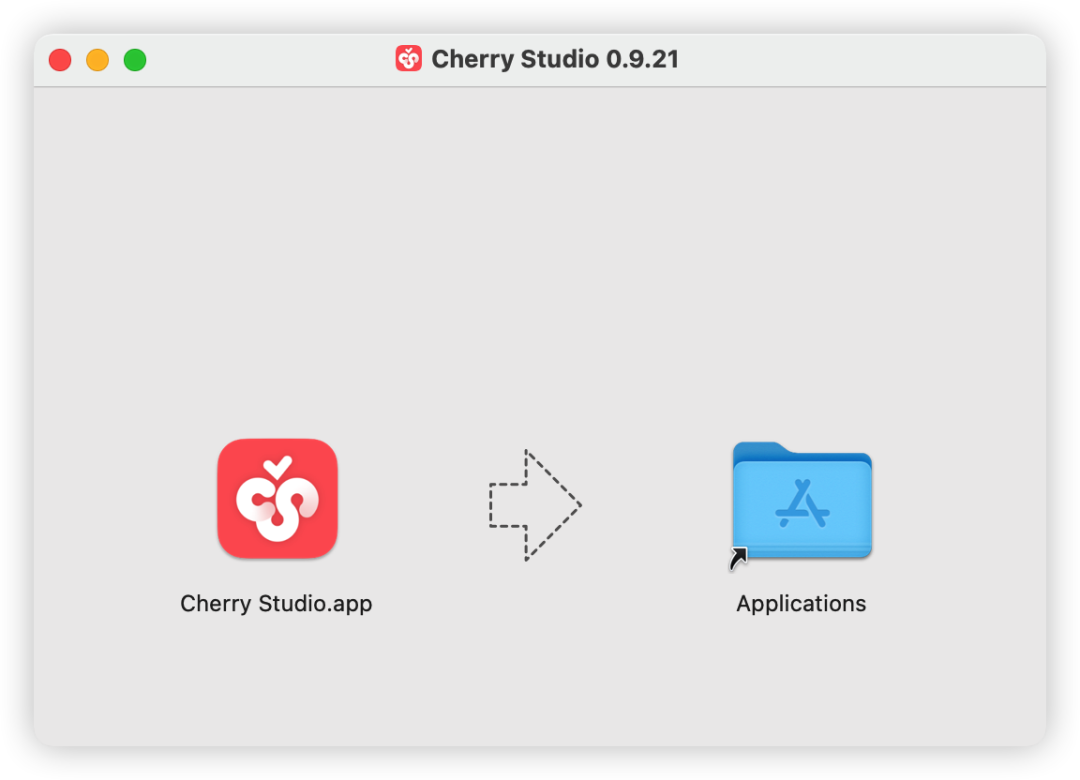

下载完成后会有一个 cherry studio 的 dmg 文件,双击安装即可。

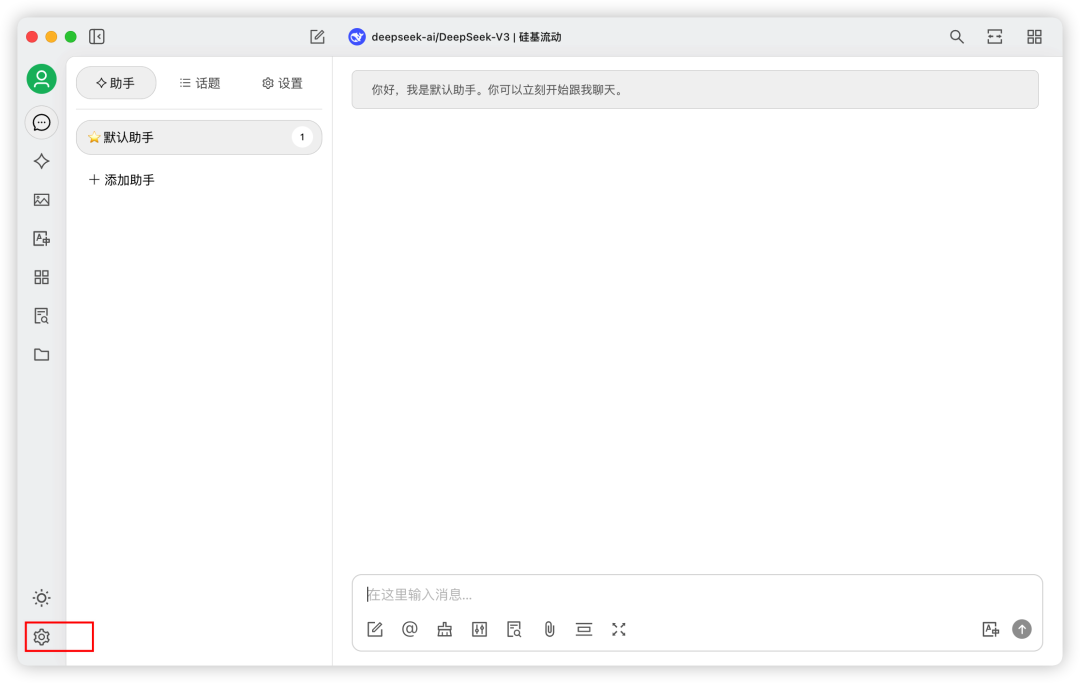

安装完成 Cherry Studio 后。我们在应用程序中找到并打开它。如图:

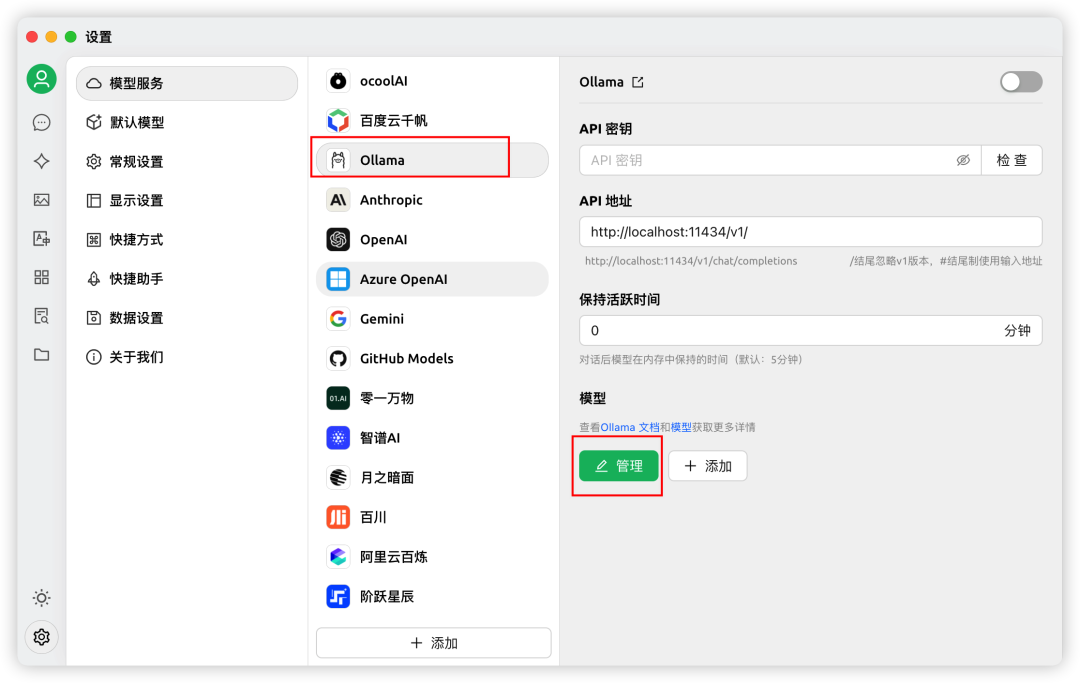

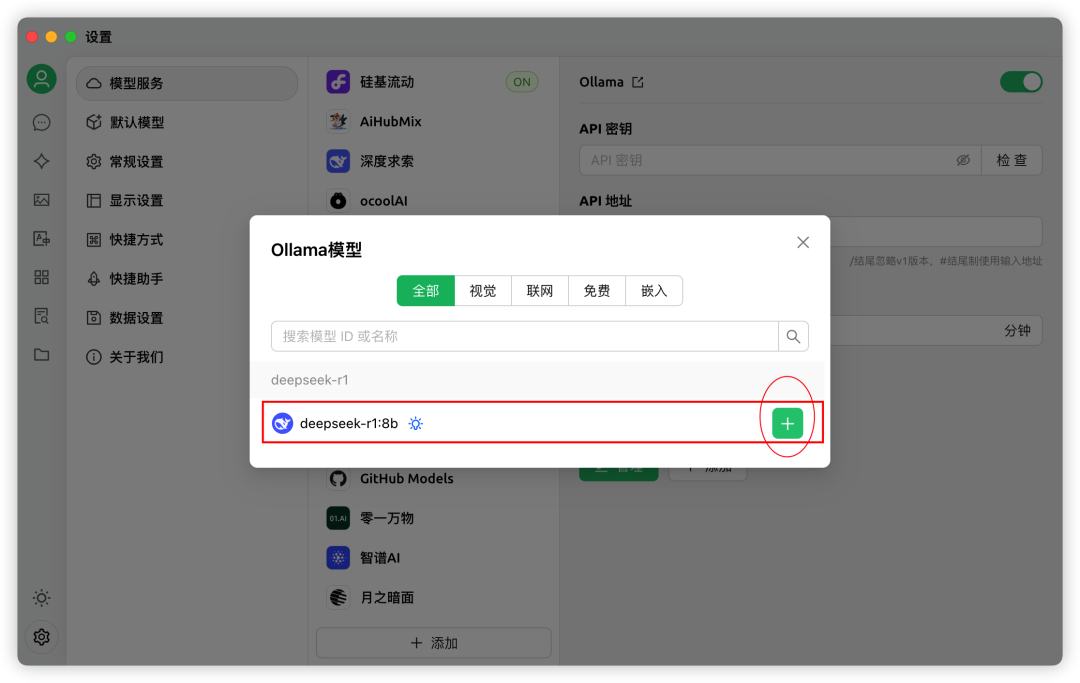

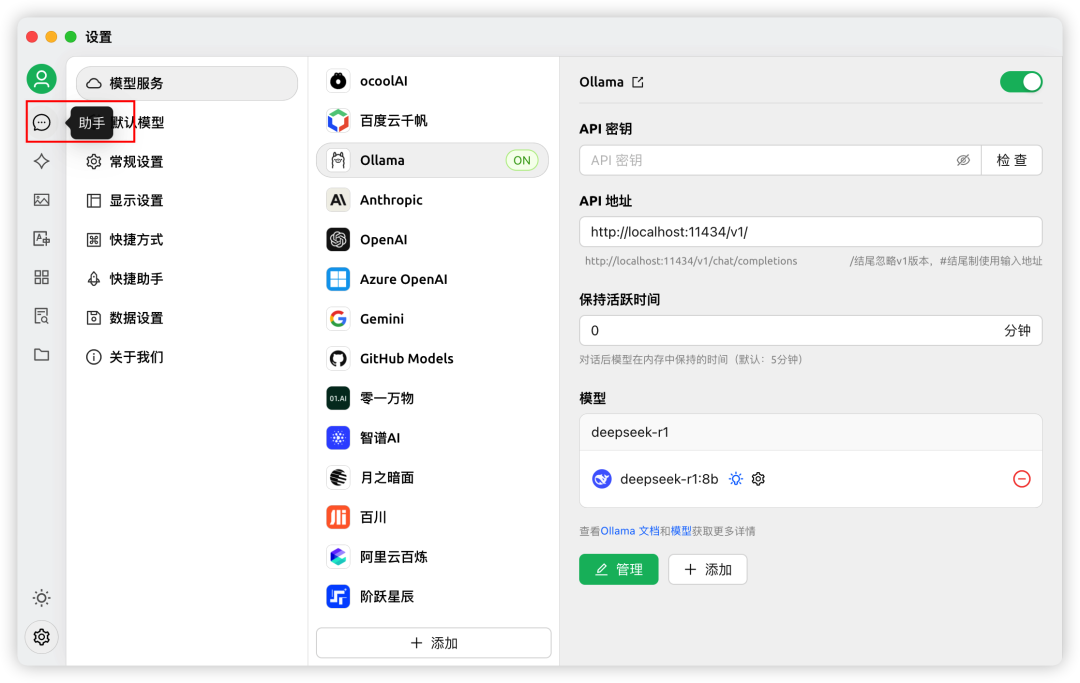

我们点击上图中:设置的小图标,进行配置模型。选择 Ollama。然后点击管理。

接着选择我们下载的 8B 版本,或者是你下载的版本。

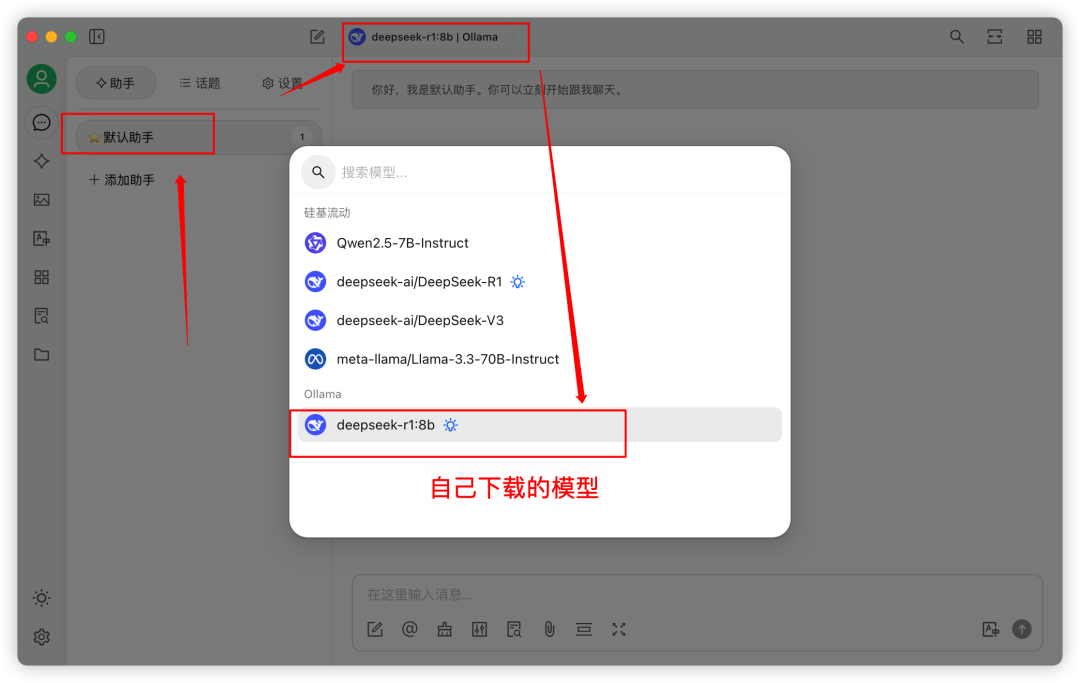

配置完成后,我们回到聊天助手那里。

接着按图操作:

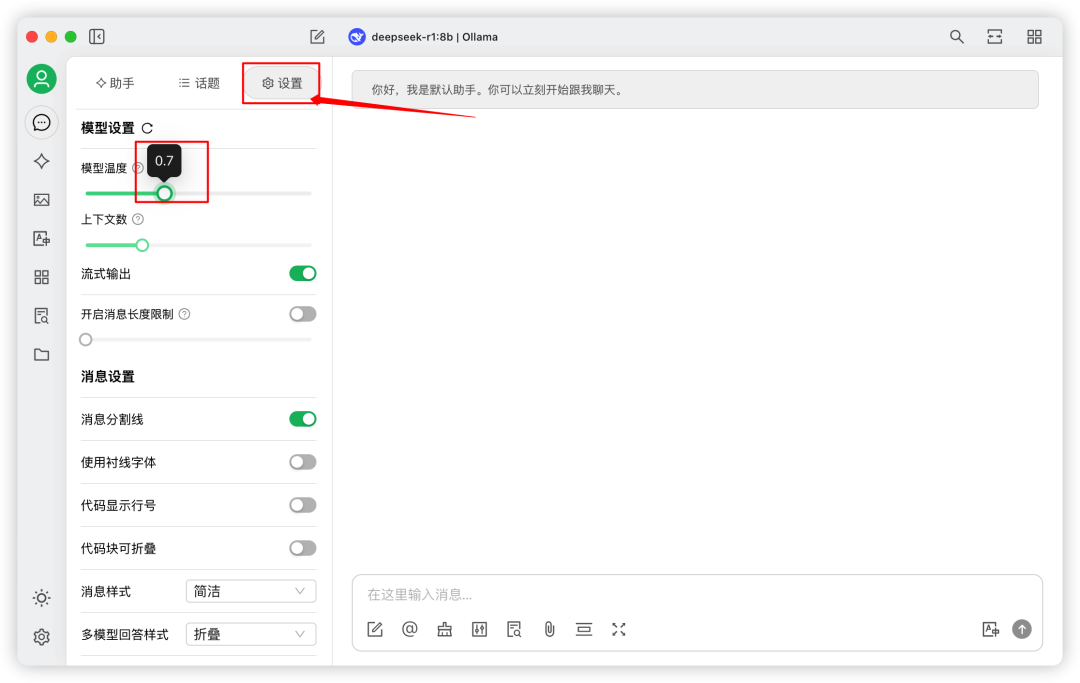

最后一步是在设置中配置模型参数:

至此 Cherry Studio 设置完毕。

测试

我们就可以进行测试啦:

通过本地部署 DeepSeek,我们可以打造属于自己的 AI 语言模型推理环境,无需依赖云端 API,同时能够获得更高的安全性和可控性。