当前 AI 在推理能力提升上遇到了诸多瓶颈,这在一定程度上限制了其进一步发展和广泛应用。在传统的 AI 训练中,模型对大量监督数据的依赖是一个显著问题。

监督学习需要大量带有标注的数据来训练模型,使其能够对新的数据进行准确的分类或预测。然而,获取高质量的标注数据往往需要耗费大量的人力、物力和时间。

以图像识别为例,为了训练一个能够准确识别各种动物的 AI 模型,需要人工对大量的动物图像进行标注,标记出图像中动物的种类、特征等信息。这个过程不仅繁琐,而且容易出现标注错误,从而影响模型的训练效果。

在复杂任务中,AI 的推理也存在明显的局限性。许多 AI 模型在面对需要多步逻辑推理的任务时,表现并不理想。

强化学习是一种通过让智能体在环境中不断尝试和学习,以获得最优的行为策略的方法。与监督学习不同,强化学习不需要大量的标注数据,而是通过智能体与环境的交互,根据环境反馈的奖励信号来学习最优策略。

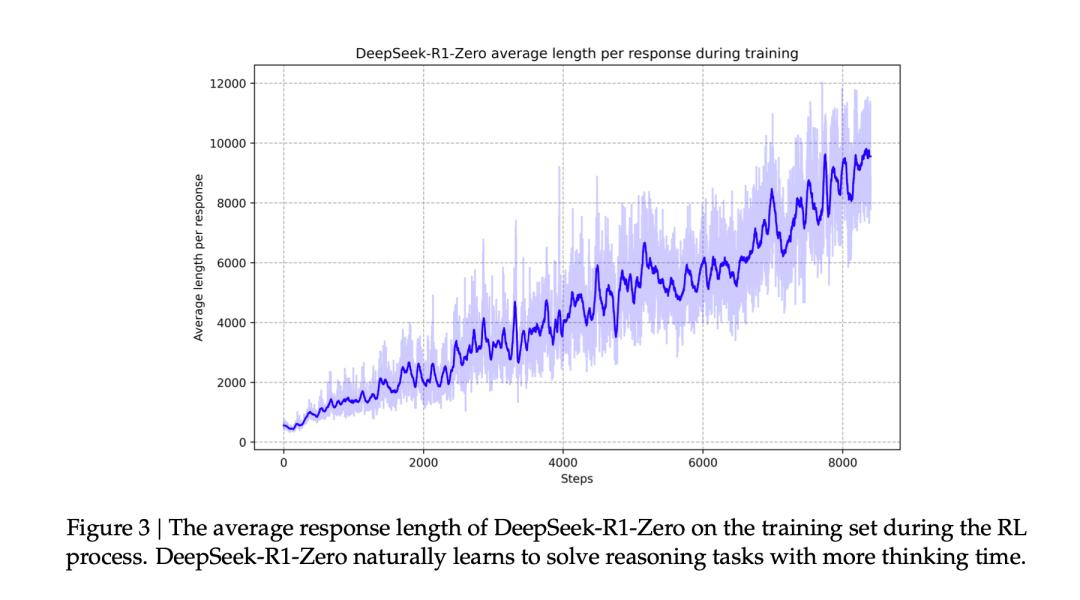

DeepSeek-R1-Zero 模型完全依赖于强化学习技术,而不涉及任何形式的监督式微调(Supervised Fine-Tuning,SFT)。这种全新的训练方式使得模型能够在没有人为干预的情况下,通过自我进化不断提升其推理能力。它的出现,为 AI 推理能力的提升开辟了一条新的道路,也为解决当前 AI 发展的困境带来了新的希望。

"自我进化"的显著特点

(一)自验证和反思:模型的自我纠错

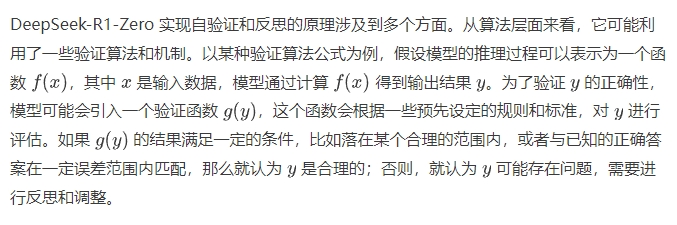

在 DeepSeek-R1-Zero 的自我进化过程中,自验证和反思是其重要的特点之一。自验证是指模型能够对自身的推理过程和结果进行检验,判断其是否合理和准确。反思则是在自验证的基础上,当发现问题时,模型能够对自己的思考过程进行回顾和分析,找出错误的原因,并尝试调整和改进。

5000字揭秘!DeepSeek-R1-Zero自我进化的3大特点和3大基石-AI.x社区

5000字揭秘!DeepSeek-R1-Zero自我进化的3大特点和3大基石-AI.x社区

具体来说,在实际应用中,当模型面对一个数学问题时,它会按照自己的推理逻辑得出一个答案。然后,模型会启动自验证机制,通过验证函数对这个答案进行检查。如果发现答案不符合数学运算的基本规则,比如在加法运算中,结果小于其中一个加数,那么模型就会意识到可能出现了错误。

接下来,模型会进入反思阶段,它会回顾自己的推理步骤,分析是哪个环节出现了问题。可能是在某个计算步骤中出现了失误,或者是对问题的理解存在偏差。通过反思,模型会尝试调整自己的推理过程,重新计算答案,直到得到一个经过自验证认为合理的结果。

这种自验证和反思的能力,使得 DeepSeek-R1-Zero 能够在不断的自我学习和进化中,提高自己的推理准确性和可靠性。它不再仅仅依赖于外部的监督和纠正,而是能够自主地发现问题并解决问题,这是其在人工智能领域中具有重要意义的创新之处。

(二)长链思考(CoT)生成:深度推理的奥秘

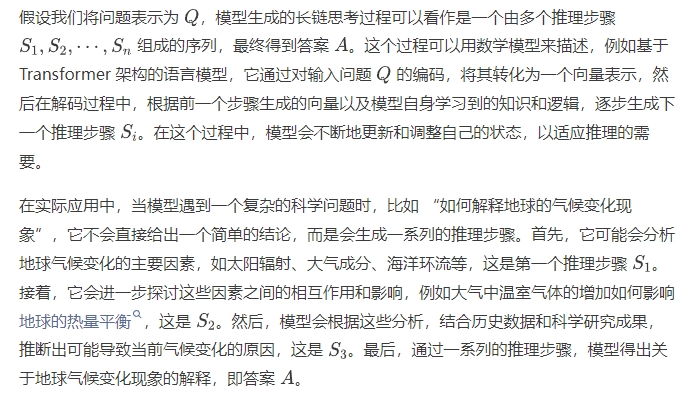

长链思考(CoT)生成是 DeepSeek-R1-Zero 另一个引人注目的特点。长链思考是指模 型在处理复杂问题时,能够生成一系列连贯的、逐步深入的推理步骤,就像人类在解决复杂问题时进行的深度思考一样,通过一环扣一环的逻辑推理,最终得出准确的答案。

DeepSeek-R1-Zero 能够生成长链思考,背后有着复杂而精妙的机制。从数学模型的角度来看,它可以被理解为一个基于序列生成的过程。

5000字揭秘!DeepSeek-R1-Zero自我进化的3大特点和3大基石-AI.x社区

5000字揭秘!DeepSeek-R1-Zero自我进化的3大特点和3大基石-AI.x社区

这种长链思考的能力,使得 DeepSeek-R1-Zero 能够处理那些需要深度推理和综合分析的复杂问题。它能够将一个大问题分解为多个小问题,逐步解决,从而提高了模型在复杂任务中的表现。与传统的语言模型相比,DeepSeek-R1-Zero 的长链思考能力使其在面对复杂问题时,能够提供更加详细、准确和有逻辑的回答,这对于推动人工智能在科学研究、工程设计、医疗诊断等领域的应用具有重要的意义。

(三)“aha moment”:灵感闪现的瞬间

“aha moment” 是 DeepSeek-R1-Zero 在训练过程中出现的一种独特现象,它为模型的推理能力提升带来了意想不到的突破。“aha moment” 原本是心理学中的一个概念,指的是人们在解决问题时突然获得灵感、恍然大悟的瞬间。在 DeepSeek-R1-Zero 中,“aha moment” 表现为模型在训练过程中,突然对自己的初始推理步骤进行重新评估和调整,从而显著提高推理能力。

具体来说,在训练过程中,模型会不断地尝试解决各种问题,在这个过程中,它可能会陷入一些局部最优解或者错误的推理路径。然而,在某些特定的时刻,模型会自发地对自己的初始步骤进行反思和重新审视。它会从不同的角度去思考问题,尝试不同的推理策略,就好像突然找到了新的思路一样。这种重新评估和调整往往会带来推理能力的显著提升,使得模型能够更好地解决复杂问题。

从原理上来说,“aha moment” 的出现与模型的强化学习过程密切相关。在强化学习中,模型通过与环境进行交互,根据环境反馈的奖励信号来不断调整自己的行为策略。当模型在解决问题时,它会根据当前的推理步骤得到一个奖励值,如果这个奖励值较低,说明当前的推理策略可能不是最优的。在这种情况下,模型会尝试探索新的推理路径,当它偶然发现一种新的、更有效的推理方式时,就会出现 “aha moment”。这个新的推理方式会得到更高的奖励值,模型会记住这个成功的经验,并在后续的推理中更多地采用这种方式,从而提高自己的推理能力。

“aha moment” 的出现,为 DeepSeek-R1-Zero 的自我进化提供了一种强大的驱动力。它使得模型能够在不断的尝试和探索中,突破原有的思维局限,发现更优的推理策略,从而实现推理能力的跨越式提升。这种现象也为人工智能的发展提供了新的思路和方向,让我们看到了模型在自主学习和进化过程中所蕴含的巨大潜力。

实现自我进化的技术基石

(一)强化学习:驱动进化的引擎

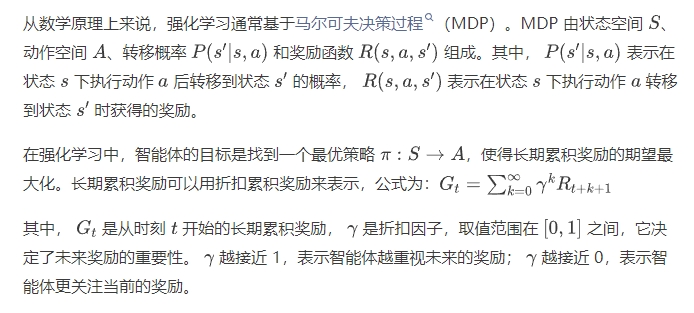

强化学习作为 DeepSeek-R1-Zero 实现自我进化的核心技术之一,在其发展过程中发挥着至关重要的作用。强化学习是一种基于智能体与环境交互的学习范式,智能体在环境中执行动作,环境根据智能体的动作反馈奖励信号,智能体通过不断地尝试和学习,调整自己的行为策略,以最大化长期累积奖励。

在 DeepSeek-R1-Zero 中,强化学习的过程可以看作是模型在不断地探索和尝试解决各种问题。以数学问题为例,模型就像是一个解题者,它会根据自己当前的知识和策略,尝试不同的解题步骤。如果它的解题步骤得到了正确的答案,就会得到一个正的奖励信号;如果答案错误,或者解题过程不符合要求,就会得到一个负的奖励信号。模型通过不断地接收这些奖励信号,调整自己的解题策略,逐渐提高自己解决数学问题的能力。

5000字揭秘!DeepSeek-R1-Zero自我进化的3大特点和3大基石-AI.x社区

5000字揭秘!DeepSeek-R1-Zero自我进化的3大特点和3大基石-AI.x社区

DeepSeek-R1-Zero 通过不断地与环境交互,根据奖励信号来调整自己的策略,逐渐优化自己的推理能力。在这个过程中,它不断地尝试新的推理路径和方法,通过强化学习的机制,将那些能够得到高奖励的推理策略保留下来,从而实现自我进化。

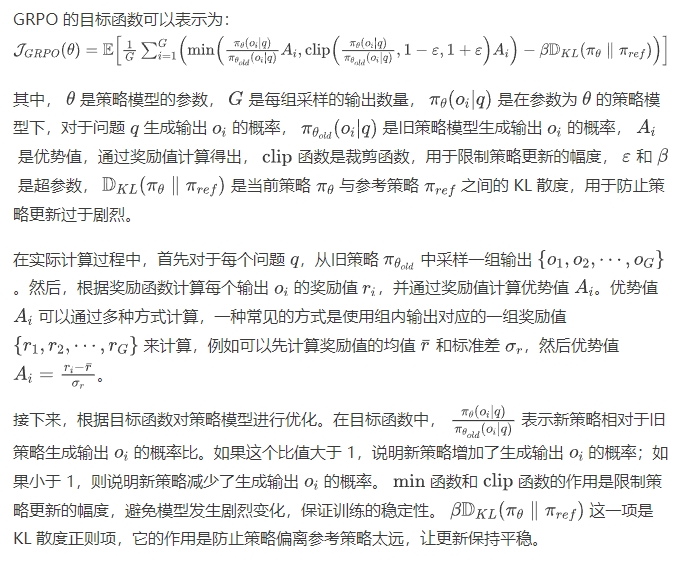

(二)群体相对策略优化(GRPO)算法

群体相对策略优化(GRPO)算法是 DeepSeek-R1-Zero 中另一个关键的技术,它为模型的训练和优化提供了高效的方法。GRPO 算法的核心思想是通过群体相对策略优化,避免了传统强化学习算法中对价值网络的依赖,从而降低了训练成本,提高了训练效率。

在传统的近端策略优化(PPO)算法中,需要维护一个与策略模型大小相当的价值网络来估计优势函数,这在大规模模型训练中会带来巨大的计算和存储负担。而 GRPO 算法则摒弃了这种方式,它通过从旧策略中采样一组输出,并最大化目标函数来优化策略模型。

5000字揭秘!DeepSeek-R1-Zero自我进化的3大特点和3大基石-AI.x社区

5000字揭秘!DeepSeek-R1-Zero自我进化的3大特点和3大基石-AI.x社区

通过这种方式,GRPO 算法能够在不依赖价值网络的情况下,实现对策略模型的有效优化,同时保持训练过程的稳定性和高效性。与传统的 PPO 算法相比,GRPO 算法具有更低的计算成本和更好的训练稳定性,能够更有效地提升 DeepSeek-R1-Zero 的推理能力。

(三)奖励建模:引导进化的方向

奖励建模在 DeepSeek-R1-Zero 的自我进化过程中起着引导方向的重要作用。它就像是一个指南针,告诉模型什么样的行为是好的,什么样的行为是不好的,从而引导模型朝着正确的方向进化。

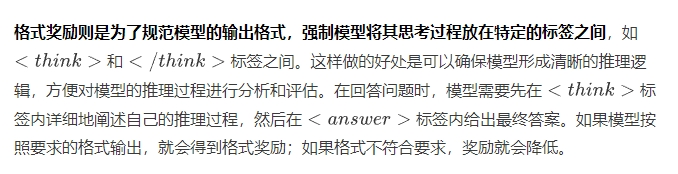

DeepSeek-R1-Zero 采用了一个基于规则的奖励系统,这个系统主要包含两类奖励:准确性奖励和格式奖励。

准确性奖励主要用于评估模型回答的正确性。对于具有确定性结果的任务,如数学问题,要求模型以特定格式(如在方框内)提供最终答案,以便能够可靠地基于规则验证正确性。在解决数学方程时,模型给出的答案如果经过验证是正确的,就会得到较高的准确性奖励;如果答案错误,则得到较低的奖励。对于编程问题,如 LeetCode 问题,可以使用编译器基于预定义的测试用例生成反馈,判断代码的正确性,从而给予相应的准确性奖励。如果模型编写的代码能够通过所有的测试用例,就会获得较高的奖励;否则,奖励较低。

5000字揭秘!DeepSeek-R1-Zero自我进化的3大特点和3大基石-AI.x社区

5000字揭秘!DeepSeek-R1-Zero自我进化的3大特点和3大基石-AI.x社区

通过这两种奖励的结合,DeepSeek-R1-Zero 能够在训练过程中不断地调整自己的行为,提高自己的推理能力和输出质量。准确性奖励促使模型努力寻找正确的答案,而格式奖励则帮助模型整理自己的思路,以更清晰、更有条理的方式呈现推理过程。这种奖励建模的方式为模型的自我进化提供了明确的目标和方向,使得模型能够在不断的尝试和学习中,逐渐提升自己的性能,成为一个更强大的推理模型。

用实力说话:性能表现与成果

惊艳的基准测试成绩

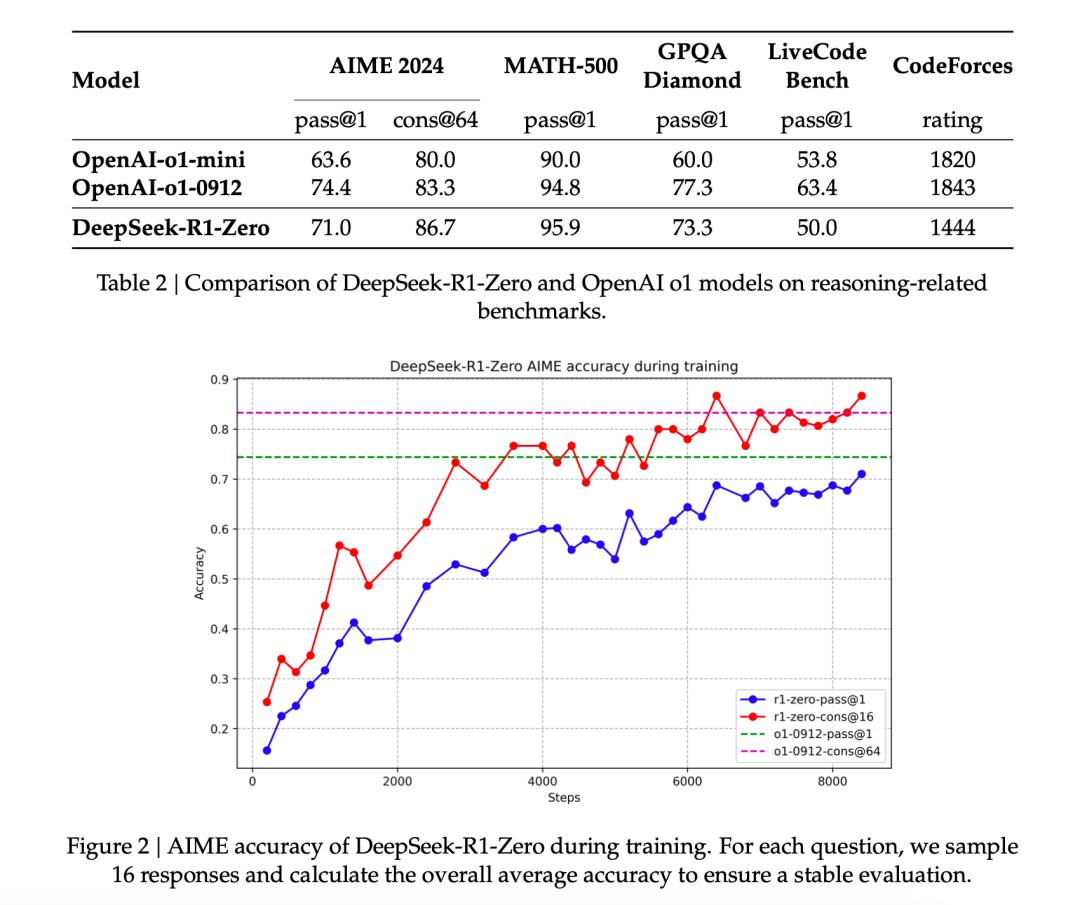

DeepSeek-R1-Zero 在多个权威基准测试中展现出了卓越的性能,其成绩令人瞩目。在 AIME 2024(美国数学邀请赛)基准测试中,这是一项极具挑战性的数学竞赛,要求参赛者具备深厚的数学知识和强大的推理能力。DeepSeek-R1-Zero 在训练初期,pass@1 分数仅为 15.6% ,但随着训练的深入,通过不断地自我进化和优化,其 pass@1 分数大幅提升至 71.0% 。更为惊人的是,当采用多数投票机制时,其分数更是达到了 86.7% ,这一成绩与 OpenAI o1-0912 的表现相当甚至更优,充分证明了其在数学推理领域的强大实力。

在 MATH - 500 基准测试中,DeepSeek-R1-Zero 同样表现出色。该测试主要考察模型在复杂数学问题上的解决能力,涵盖了代数、几何、数论等多个数学分支。DeepSeek-R1-Zero 在这个测试中的成绩远超传统监督学习训练的模型,进一步证明了强化学习在增强数学推理能力方面的显著效果。与其他知名模型相比,如 OpenAI 的 o1 系列模型,DeepSeek-R1-Zero 在某些指标上也毫不逊色,甚至在部分任务上表现更为突出。

在复杂问题解答(GPQA)方面,DeepSeek-R1-Zero 与 OpenAI-o1-mini 相比,正确率提升了 13.3% ,这表明它在理解和回答复杂问题时,能够更准确地把握问题的关键,提供更合理的答案。在代码推理任务中,尽管它仍然落后于 OpenAI-o1-0912,但在强化学习的帮助下,已经具备了相当强的代码分析能力,能够对代码的逻辑、功能和潜在问题进行有效的推理和判断。 这些基准测试成绩不仅体现了 DeepSeek-R1-Zero 强大的推理能力,也证明了其自我进化过程的有效性。通过不断地自我验证、反思和长链思考,它能够在各种复杂任务中不断提升自己的表现,为人工智能在数学、科学等领域的应用提供了有力的支持。