安装环境

操作系统:Windows 10及以上

准备工具:

- 轻量级AI模型调用工具Ollama,调用AI模型为deepseek-r1

- AI 模型管理工具Cherry-Studio或AnythingLLM(二选一)

资源链接:

安装步骤

第一步、下载安装Ollama并修改环境变量

要运行大模型,首先需要一个好用的工具,推荐使用 Ollama ,它是一个轻量级的工具,支持快速安装和运行大语言模型(如deepseek、Llama、Qwen 等)。

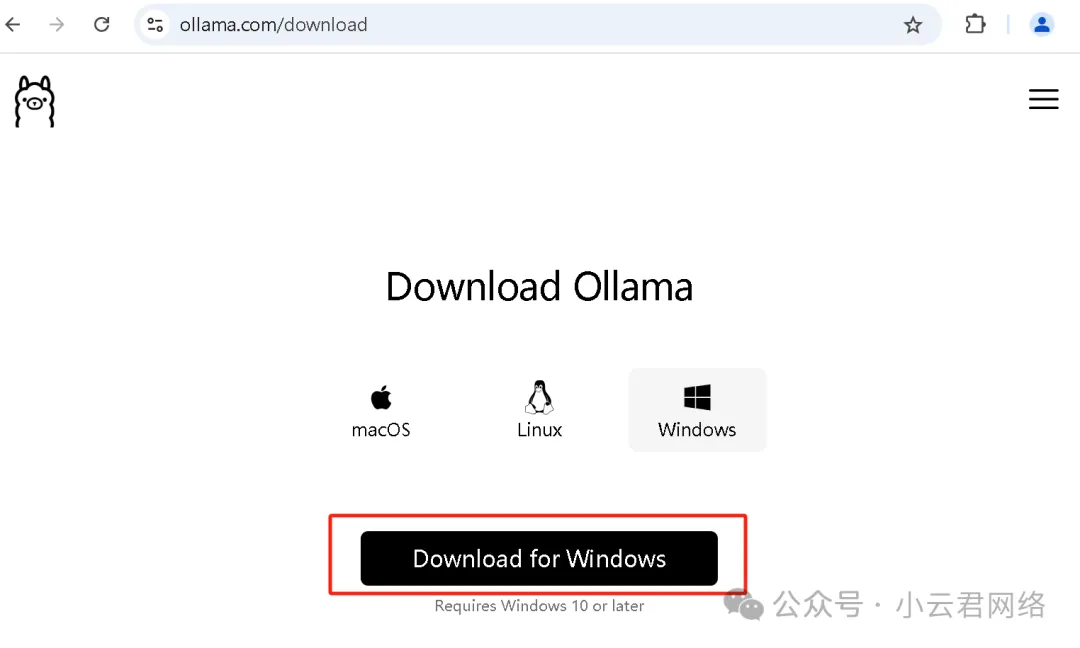

ollama下载地址 :官网链接https://ollama.com/download/或者我的网盘(文章开头)

选择合适的操作系统下载,默认安装完成即可。这里注意,ollama安装完成后先不要启用,因为它默认是会将模型下载到C盘的,deepseek、Qwen等模型最小也有好几个GB会占用C盘空间,所以需要先设置ollama的环境变量。

环境变量设置方法:

① 菜单键搜索“环境变量”

② 按照如下步骤设置环境变量:

- OLLAMA_HOST:设置为0.0.0.0 会将ollama服务应用到所有的网络,默认ollama只绑定到了127.0.0.1和localhost上了;

- OLLAMA_MODELS_PATH:设置了AI模型的存放路径。

③安装ollama并且设置完环境变量后,CMD打开命令窗口输入下述命令即可查看版本:

第二步、加载AI大模型(这里使用deepseek-R1大模型)

① 打开ollama官网https://ollama.com/search可以找到AI大模型deepseek-r1,因为爆火,头个就是它

进入后可根据自身电脑的配置选择规格,然后复制后边对应的命令即可

这里说明一下:只有671B是满血deepseek大模型,其它的都是蒸馏小模型。另外根据自身电脑配置选择规格参考如下(配置太低是跑不动高规格模型的)

模型 | 显存需求 | 内存需求 | 推荐显卡 | 性价比方案 |

7B | 10-12GB | 16GB | RTX 3060 | 二手2060S |

14B | 20-24GB | 32GB | RTX 3090 | 双卡2080Ti |

32B | 40-48GB | 64GB | RTX 4090 | 租赁云服务器 |

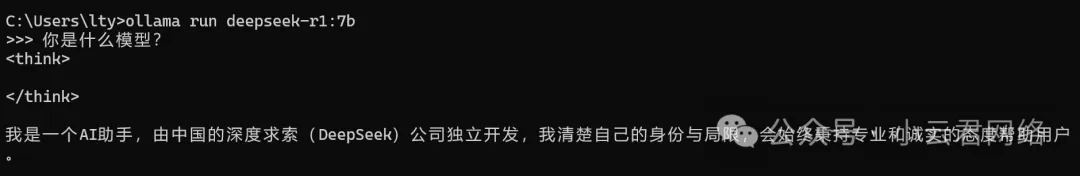

② 将刚刚复制的命令在CMD命令窗口中运行,即可完成AI模型下载(由于修改了环境变量,存放路径不再是C盘):

然后就可以提问AI了:

按Ctrl+Z可以回到上级,输入以下命令可以查看已下载的模型列表:

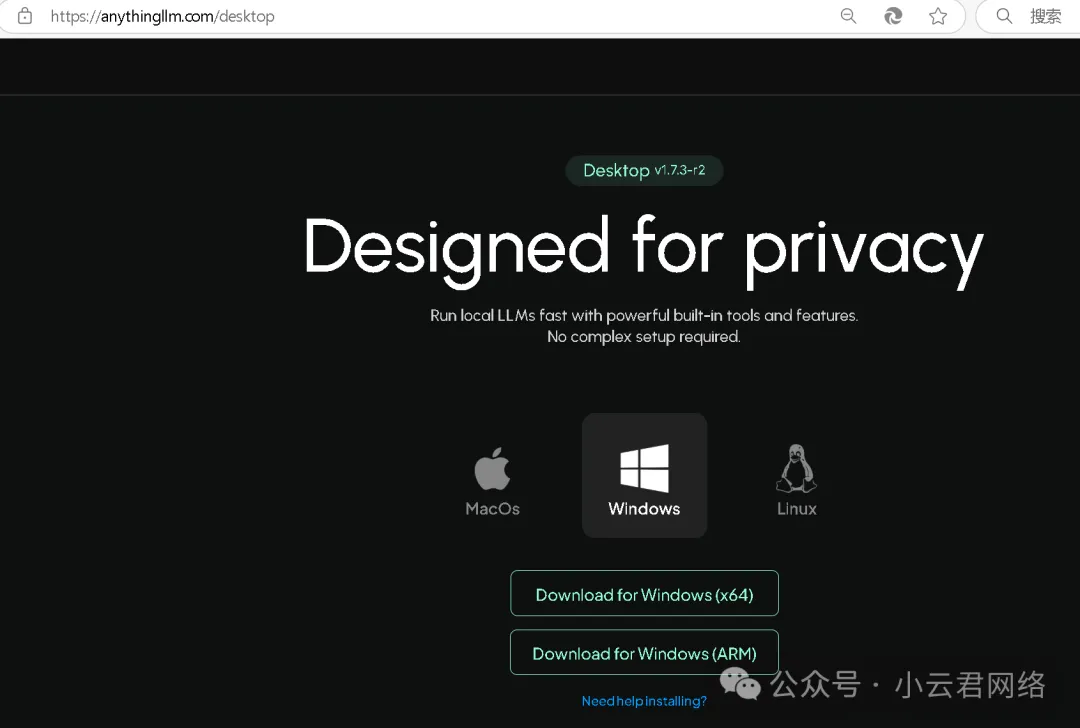

为了更加美观和可视化的与AI交流,下面需要通过交互工具实现,可以用cherry-studio或者anythingLLM,二选一。本文即介绍anythingLLM的部署方法。

第三步、安装AnythingLLM并通过ollama加载deepseek模型

① 下载地址:官网链接https://anythingllm.com/desktop或我的网盘(文章开头)

② 完成安装后打开AnythingLLM,点击“设置”修改变量参数:

设置完成后创建自己的工作区,这样就可以可视化的开展页面对话了: