半导体研究机构SemiAnalysis认为,DeepSeek囤积了6万张英伟达GPU卡,其中包括1万张A100、1万张H100、1万张“特供版”H800、3万张“特供版”H20。马斯克认为DeepSeek实际使用的GPU数量可能接近5万个Nvidia H100 GPU。但是,据论文显示,DeepSeek-V3开源基础模型的训练在2048块英伟达H800 GPU集群上完成。

什么是真实的?什么是在炒作呢?

架构的影响

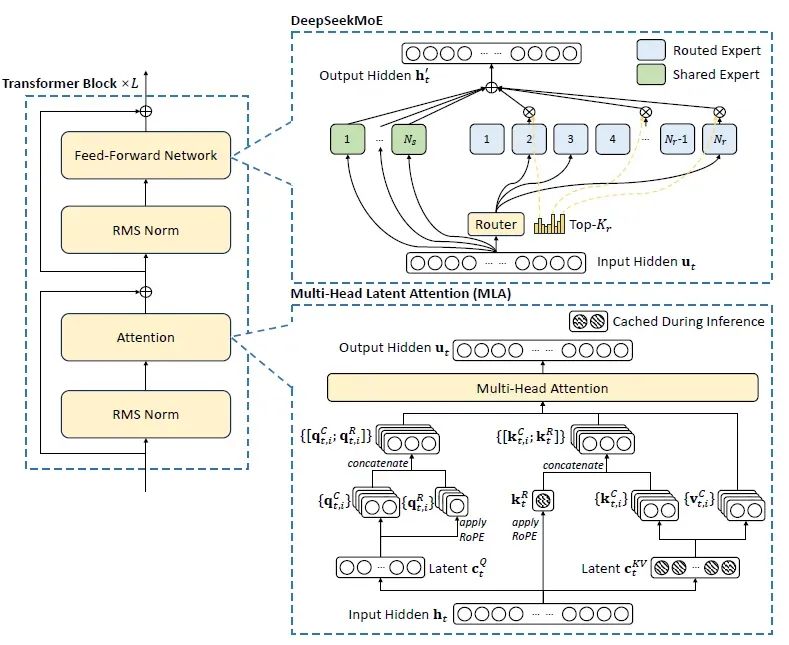

DeepSeek的架构是一个开源的专家混合 (MoE) 语言模型,使用一个创新的 Transformer 体系结构设计,用于经济的训练和有效的推理,其核心可能是多头潜在注意 (MLA) 和 DeepSeekMoE。

图片

图片

多头注意力 (MHA) 中的键值 (KV) 缓存是 LLM 推理的一个重要瓶颈。分组查询注意力 (GQA) 和多查询注意力 (MQA) 等方法试图缓解这一问题,但往往会影响性能。MLA 通过利用低级关键值联合压缩来解决这个问题。实证结果表明,MLA 不仅优于传统的 MHA,而且显著降低了 KV 缓存,从而提高了推理效率。

MLA 的主要目标是通过将键和值压缩成比原始表示尺寸小得多的潜在向量,从而减小 KV 缓存的大小。这些被压缩的潜在 KV 向量存储在 KV 缓存中,然后在生成阶段 (通过上投影) 被解压缩到原始维度,以便进行多头注意力的计算。这种优化维护甚至可以增强模型的准确性,同时将缓存大小降低到与 GQA 所达到的大小相当的水平。事实上,这种缓存减少方法可以与 MQA (最积极的缓存减少方案) 相媲美,同时提供与传统 MHA 相当甚至更高的模型精度。

DeepSeekMoE 引入了两项关键创新,以最大限度地实现专家的专业性:

- 细粒度专家细分:将专家细分为更细的粒度,以实现更高的专业化和更精确的知识获取。

- 共享专家隔离:隔离专门的专家以减少路由专家之间的知识冗余。

使用相同数量的激活参数和全部专家参数,DeepSeekMoE 的性能明显优于 GShard 等传统 MoE 架构。

另外. DeepSeek 还采用了多令牌预测 (MTP) 。MTP 没有严格地逐个生成令牌,而是训练模型一次处理多个令牌。这种方法提高了吞吐量,也是 DeepSeek-V3 比 DeepSeek-V2 快三倍生成文本的部分原因。

通过整合这些创新,DeepSeek提供了强大的性能、成本效益高的培训、大量的 KV 缓存减少和高推理吞吐量。

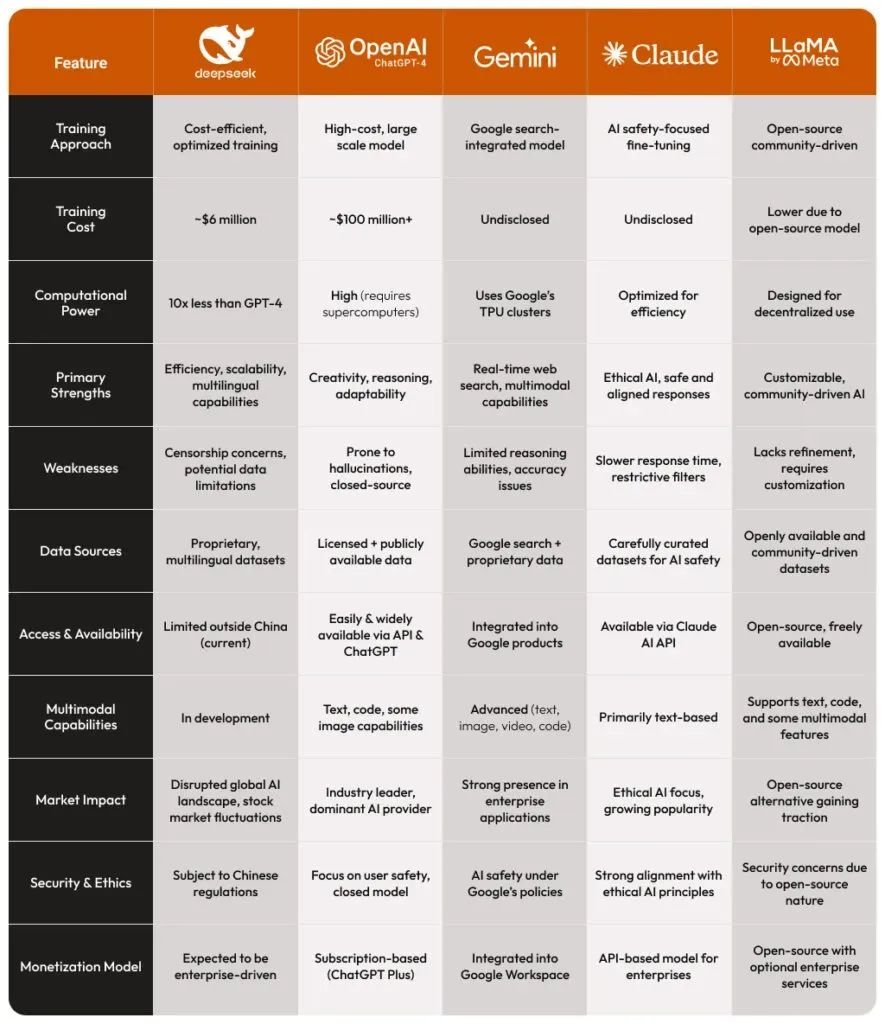

DeepSeek 与其他大模型的对比

下面表格提供了一个 DeepSeek 比较其他领先的人工智能语言模型的简要说明。它强调了 DeepSeek 与 ChatGPT、 Gemini、 Claude 和 Llama 之间的关键区别,侧重于性能、效率和培训成本等方面。

图片

图片

简单而言,

- DeepSeek 正在通过成本效益高的培训和具有竞争力的性能 / 资源比例,打动人工智能市场,在 DeepSeek 与 Openai ChatGPT 的对比中提供了一个令人信服的案例。

- OpenAI (ChatGPT-4) 仍然占据主导地位,但 DeepSeek 的崛起引入了一个新的玩家,能够以更低的成本提供类似的功能。DeepSeek VS ChatGPT 目前成为了一种趋势。

- 谷歌 Gemini 与搜索的整合使其在实时更新方面功能强大,而 DeepSeek 的多语言专注可能使其成为强大的替代品。

- Anthropic Claude 优先考虑人工智能的安全性,将自己定位为一个值得信赖的模型,但它可能缺乏 DeepSeek 的可扩展性和适应性。

- Meta 的Llama是开源的,允许定制,但它可能还没有达到 DeepSeek 在多语言和结构化人工智能响应方面的表现。据报道,Meta建立了四个作战室来调查深度搜索的发展趋势。

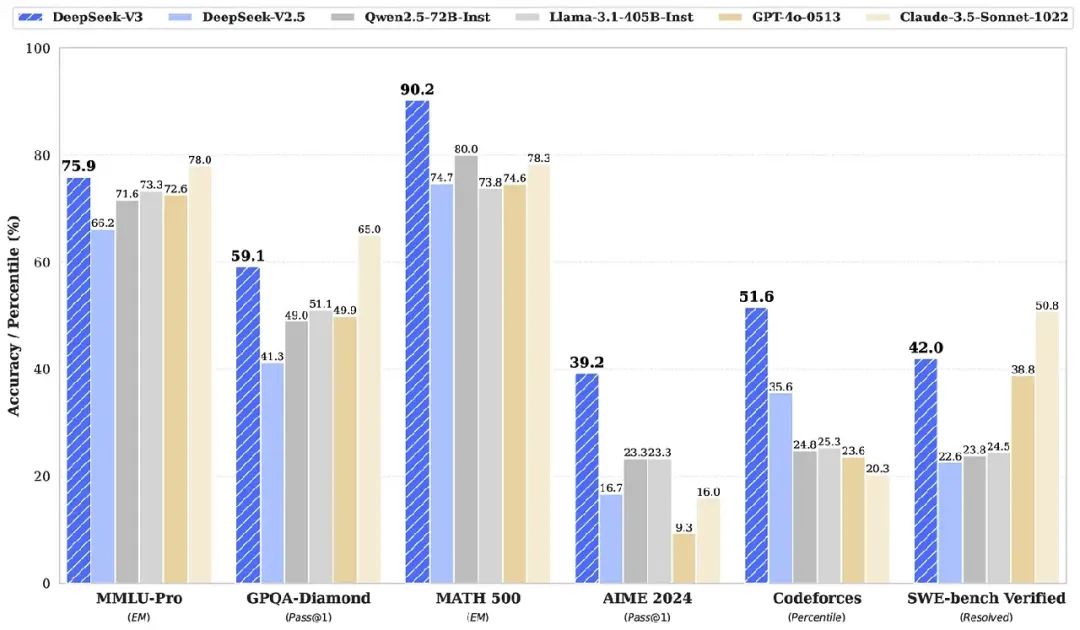

就性能指标而言,

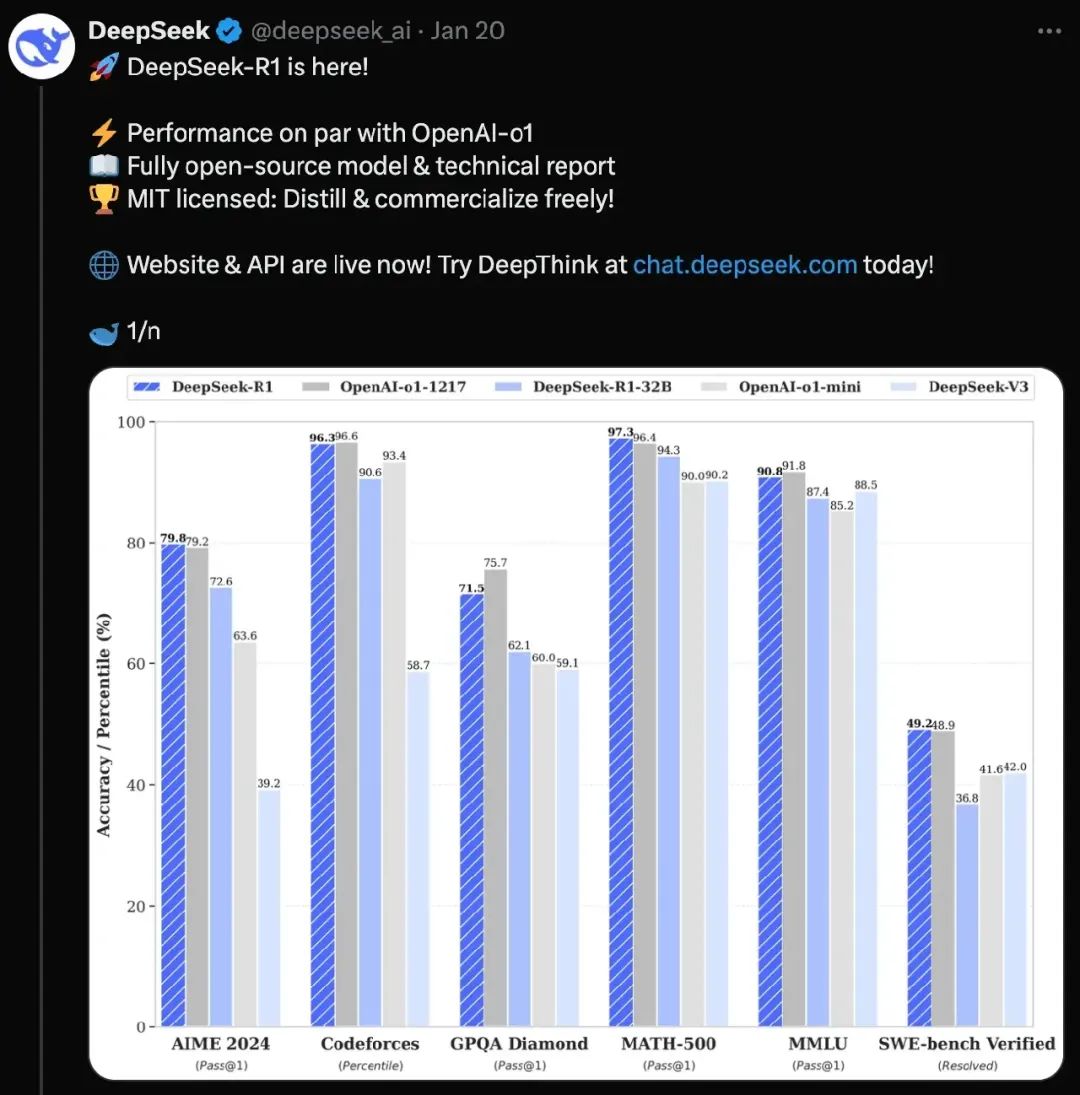

“DeepSeek” 无疑是一个戏剧性的入口,引发了一场关于人工智能未来的全球对话。它的创新方法和令人印象深刻的能力既令人兴奋又令人关切,突出了技术进步与地缘政治考虑之间复杂的相互作用。

DeepSeek 的各模型对比:V3,R1 和R1-Zero

DeepSeek R1 专为高级推理任务设计,利用强化学习技术提高其性能,在复杂的推理任务中脱颖而出。这个模型在需要逻辑推理和问题解决的场景中特别有效。

图片

图片

相比之下,DeepSeek V3 是为自然语言处理任务的多功能性而构建的,侧重于使用混合专家体系结构的可伸缩自然语言处理,使其能够有效地处理各种应用程序。考虑一个场景,其中 DeepSeek-V3 的任务是根据用户提示词生成文本。该模型对输入进行评估,仅激活与提示的具体上下文最相关的专家,从而优化其处理能力。例如,如果提示此与技术编码有关,那么专门研究编程语言的专家将被激活,而其他专家子系统将保持休眠状态,从而节省计算资源。

图片

图片

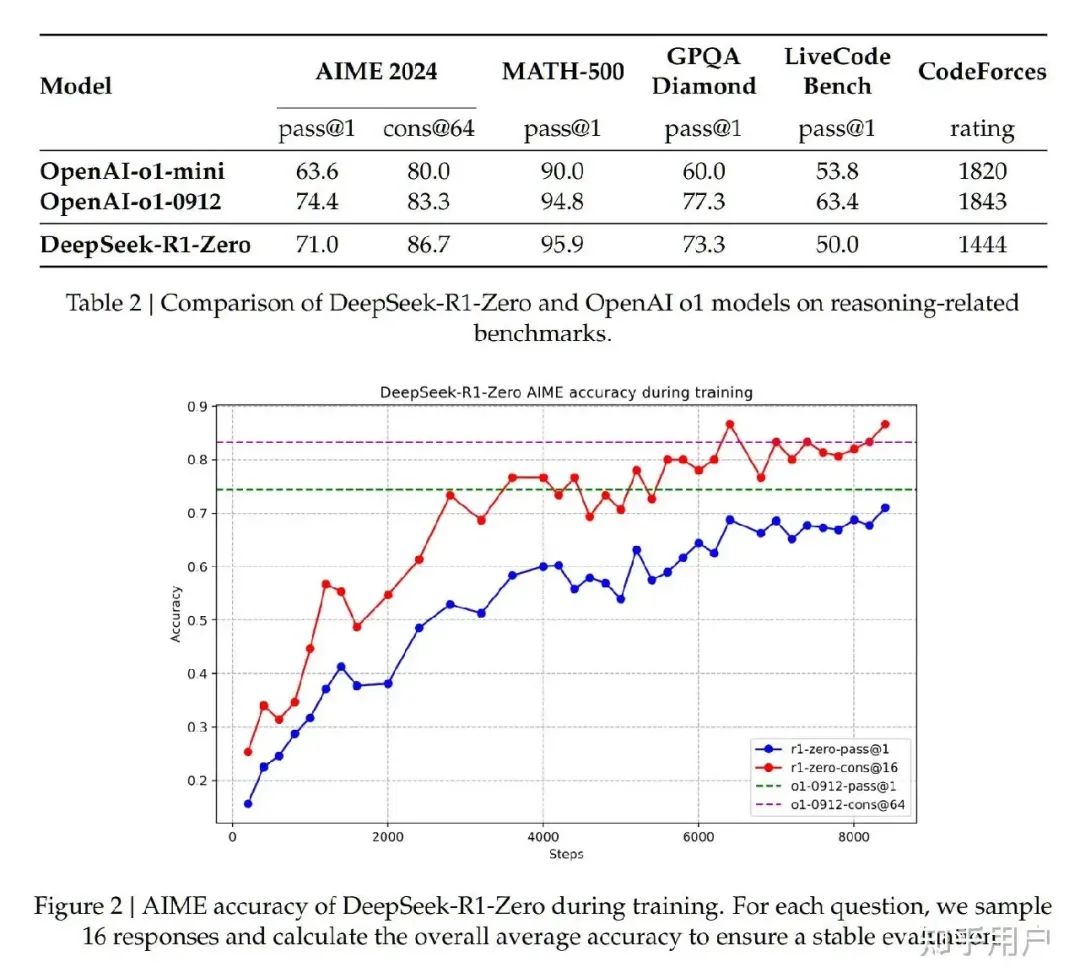

最后,DeepSeek R1-Zero 代表了一种创新的方法,它只通过强化学习进行培训,而不需要事先监督微调。这个模型已经显示出有前途的推理能力,但可能需要与可读性和连贯性做斗争。

图片

图片

虽然它只保留了在推理过程中激活 370 亿个参数的效率,但它强调了在不同任务之间的泛化,而不需要大量的微调或特定于任务的训练数据。在推理和数学相关任务方面,DeepSeek r 1 始终优于 DeepSeek r 1-zero,更适合需要精确计算和逻辑推理的应用。

回到本文开始提出的问题,那么DeepSeek 模型训练真正的成本是什么?使用了多少GPU呢?

成本的计算分析

根据可用数据,我们可以计算分析,得到可能的结果。

首先,我们假设使用了50000个GPU,训练了60天相当于1440个小时,则总的训练时长=50000 X 1440 = 72000000 GPU小时。

再假设每个GPU小时的成本=3美元,那么训练成本= 72000000 X 3 = 246000000 美元。一般地,其他附加成本约占训练成本的10~20%,我们假设附加成本约占训练成本的15%,则训练的总成本为 246000000 x 115% = 248400000 美元,与传说中的2.48亿美元吻合。

我们知道如何训练的总成本=总的GPU小时 x 单个GPU小时的成本,则总的GPU小时 =训练的总成本/ 单个GPU小时的成本,如果训练的总成本是500万美元,单个GPU小时的成本的成本是3美元的话,则总的GPU小时= 5000000/3=1666667 GPU小时。

既然知道了训练的总GPU小时数,就可以估算总的训练时长了。

已知总的GPU小时 = GPU个数 X 小时为单位的训练时长,则 小时为单位的训练时长= 总的GPU小时 /GPU个数,如果使用了50000个GPU的话,所以总的训练时长= 1666667 /50000 = 33.33 小时,约为1.39天。

如果使用了2000个GPU的话, 总的训练时长= 1666667 /2000 = 833.33 小时,约为34.72天。

因此, 500 万美元可能更贴近于真实,这只是训练成本,即~35天内 2000 个 NVIDIA H800 GPU。2.48 亿美元的估计则是基于 50000 个 GPU 60 天的训练,这种设置可能只是一种谣传。DeepSeek 拥有它们,但该项目只使用了 2000 个 GPU,实现了智能优化 。

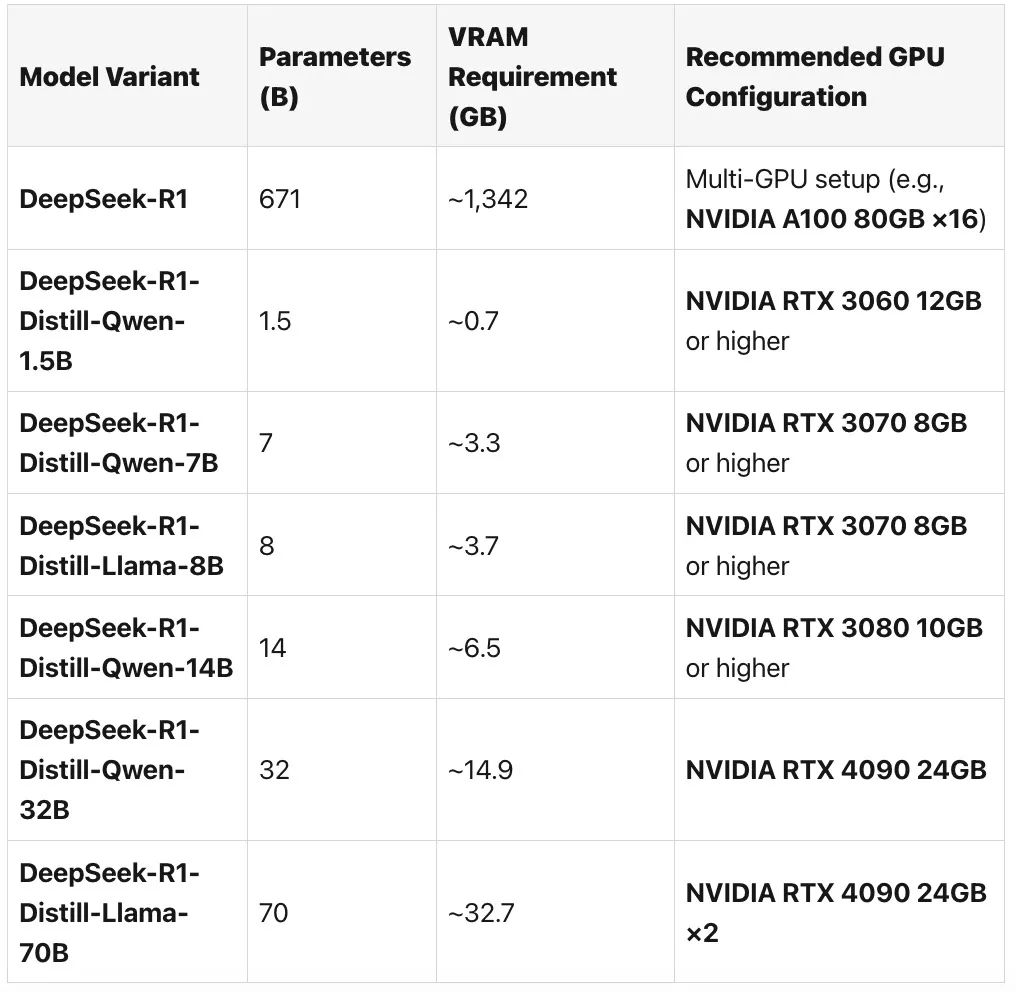

以DeepSeek R1 为例, 有人推荐了如下的GPU配置:

图片

图片

一旦经过了训练,DeepSeek 大模型推理阶段的硬件需求明显降低,即使在功能较差的 GPU 上部署也是可行的。

- 更少的 GPU 需求:推理可以在像 NVIDIA RTX 4090 (24 GB VRAM) 或企业级 A100 这样的 GPU 上执行,而不是大规模集群。

- 更低的 VRAM 使用:使用 4 位和 8 位量化,DeepSeek 降低了高达 75% 的 VRAM 消耗,允许高效的模型服务。

- 能源节省:相比于训练推理的能源消耗降低了超过 50% 能源消耗。

- 实时处理:优化的执行管道允许低延迟推断,这对于聊天机器人和自动化等 AI 驱动的应用程序至关重要。

问题是:“DeepSeek” 是一个转瞬即逝的现象,还是一股将重塑人工智能世界的力量呢?

一句话小结

DeepSeek 的 GPU 需求突出了有效的人工智能基础设施规划的必要性。通过使用智能工作负载分配、量化和动态 GPU 分配,业务可以显著降低计算成本,同时保持高性能。DeepSeek R1 显示了大模型领域上的创新,一些的复现版本也证明了这一点。

ps. 需要注意的是,那些“精简版”的R1 版本并不是模型的全部。完整模型为 671B 参数,每个实例需要 ~16 个 80GB GPU。而且,托管版本可能会使用用户的数据进行训练,所以在上传敏感内容之前请仔细检查。