一眼概览

MusicMagus 提出了一种基于扩散模型的零样本文本到音乐编辑方法,可在不额外训练的情况下,通过文本编辑修改音乐的风格、音色和乐器,同时保持其他属性不变。实验表明,该方法在风格转换和音色转换方面优于现有零样本方法,并在某些任务上超越监督学习方法。

核心问题

当前的文本到音乐生成模型已取得长足进展,但音乐创作往往需要反复修改,而如何在保持音乐整体结构的同时,精准编辑特定属性仍然是个挑战。现有方法依赖手工标注数据集或特定任务训练,限制了编辑的灵活性和通用性。因此,本研究的核心问题是:

如何在无需额外训练的情况下,实现灵活的文本驱动音乐编辑?

技术亮点

1. 无监督零样本编辑:MusicMagus 不依赖成对训练数据,而是利用预训练扩散模型的潜在表示空间,直接进行文本驱动的音乐编辑。

2. 语义一致性约束:通过向量化的编辑方向和交叉注意力约束,确保编辑后的音乐在保持原有结构的同时,仅修改目标属性。

3. 兼容现有模型:无需重新训练,直接集成于现有的文本到音乐扩散模型(如 AudioLDM 2),提升可用性。

方法框架

图片

图片

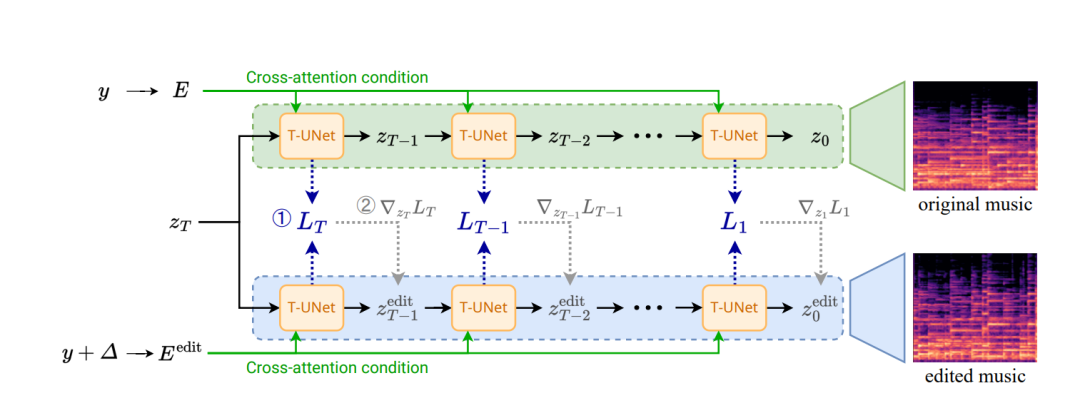

MusicMagus 的编辑过程包括以下步骤:

1. 文本变换:通过单词替换(如“钢琴”→“吉他”)来定义编辑目标,并计算语义变换向量,以捕捉文本变化的方向。

2. 扩散模型编辑:

• 在潜在空间应用编辑向量,调整扩散模型的语义条件;

• 施加交叉注意力约束,确保非编辑部分保持不变。

3. 音乐重建:利用扩散模型去噪生成新的音乐片段,实现零样本风格或音色转换。

实验结果速览

图片

图片

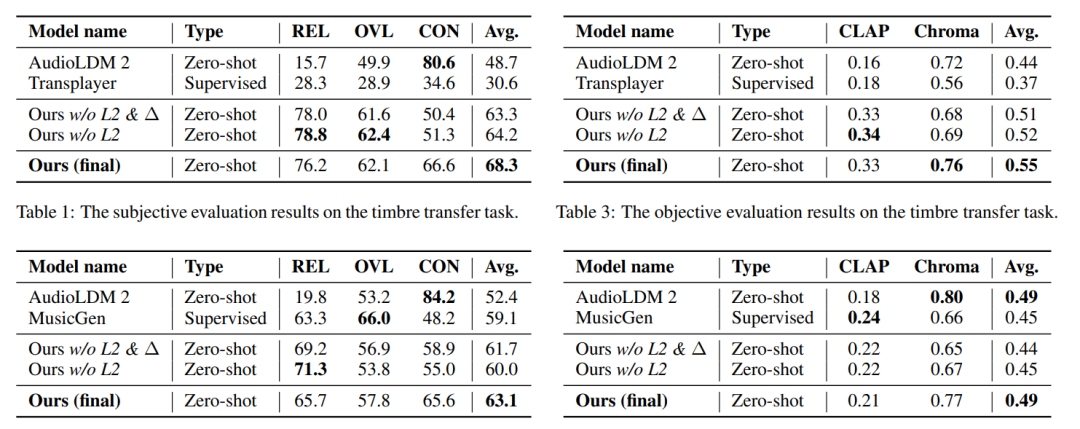

(1) 主观实验

在音色转换任务中(钢琴 → 风琴、钢琴 → 中提琴等),MusicMagus 在相关性(REL)、整体质量(OVL)和一致性(CON)方面均优于AudioLDM 2 和 Transplayer。

(2) 客观实验

MusicMagus 在语义一致性(CLAP 相似度)和旋律一致性(Chroma 相似度)方面均优于基线。

实用价值与应用

MusicMagus 适用于多种音乐编辑场景:

• 音乐制作:艺术家可通过文本指令快速调整风格或替换乐器,提升音乐创作效率。

• 影视配乐:可根据导演需求调整背景音乐风格,而无需重新录制。

• 游戏音效:允许游戏开发者通过文本指令灵活调整游戏配乐,增强互动体验。

此外,该方法还可用于真实音乐编辑,通过DDIM 反演对真实音频进行修改,但目前仍受模型泛化能力的限制。

开放问题

• 长音频编辑:当前方法主要针对短音乐片段,未来如何扩展至完整歌曲或长音频编辑?

• 多乐器混合编辑:目前仅支持单个音色转换,如何在不影响整体结构的情况下修改多个乐器或风格?

• 更高音质生成:现有扩散模型生成的音乐仍受16kHz 采样率限制,如何提高音质以满足专业需求?