北大、腾讯提出的DragonDiffusion可以对生成或真实的图像进行多种编辑,包括移动物体、调整物体大小、替换物体外观、拖动内容等。值得注意的是,所有编辑和内容保存信号都来自图像本身,模型不需要微调或额外的模块。

论文介绍

尽管现有的大规模文本转图像 (T2I) 模型能够从详细的文本描述生成高质量的图像,但它们往往缺乏对生成或真实图像进行精确编辑的能力。在本文中,我们提出了一种新颖的图像编辑方法DragonDiffusion,可在扩散模型上实现Drag式的操作。

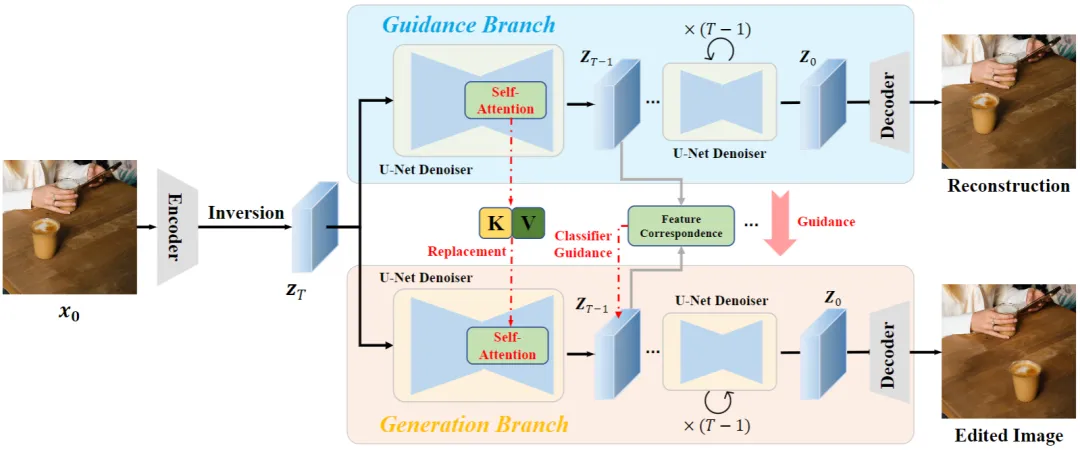

具体而言,我们根据扩散模型中中间特征的强对应性构建分类器指导。它可以通过特征对应损失将编辑信号转换为梯度,以修改扩散模型的中间表示。基于这种指导策略,我们还构建了一个多尺度指导,以考虑语义和几何对齐。此外,还添加了跨分支自注意力以保持原始图像和编辑结果之间的一致性。

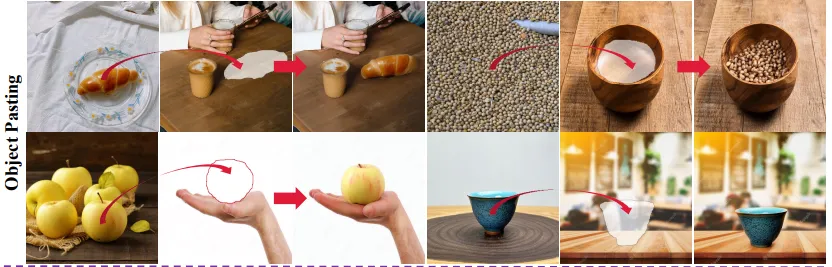

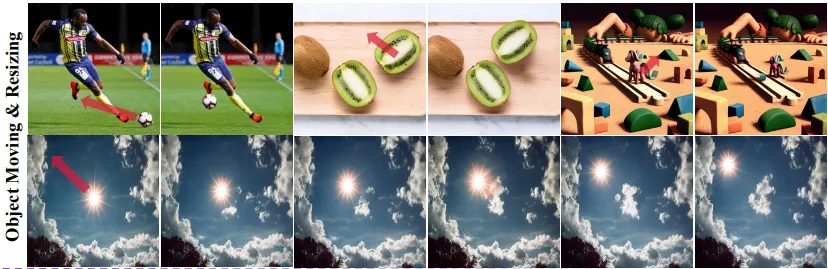

我们的方法通过高效的设计,实现了对生成或真实图像的各种编辑模式,例如对象移动、对象调整大小、对象外观替换和内容拖动。值得注意的是,所有编辑和内容保存信号都来自图像本身,模型不需要微调或额外的模块。

方法

所提出的DragonDiffusion 的流程。我们提出的方法由指导分支和生成分支组成。指导分支通过中间特征的对应关系为生成分支提供编辑和一致性指导。

所提出的DragonDiffusion 的流程。我们提出的方法由指导分支和生成分支组成。指导分支通过中间特征的对应关系为生成分支提供编辑和一致性指导。

结果

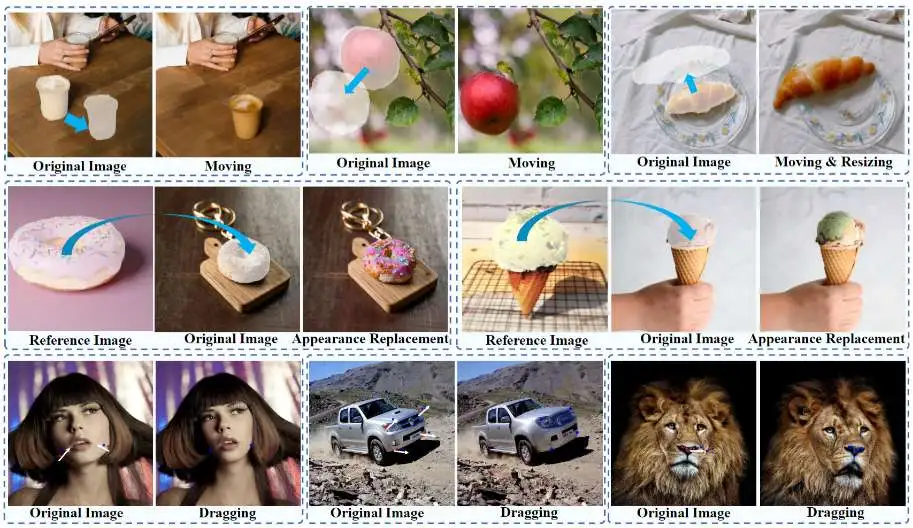

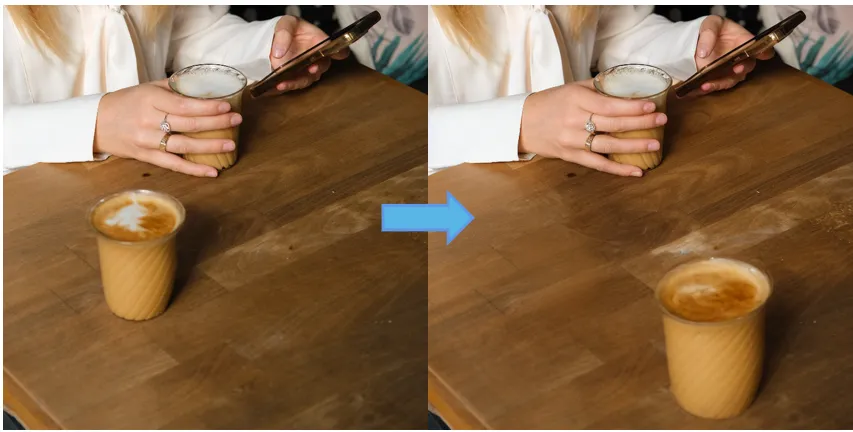

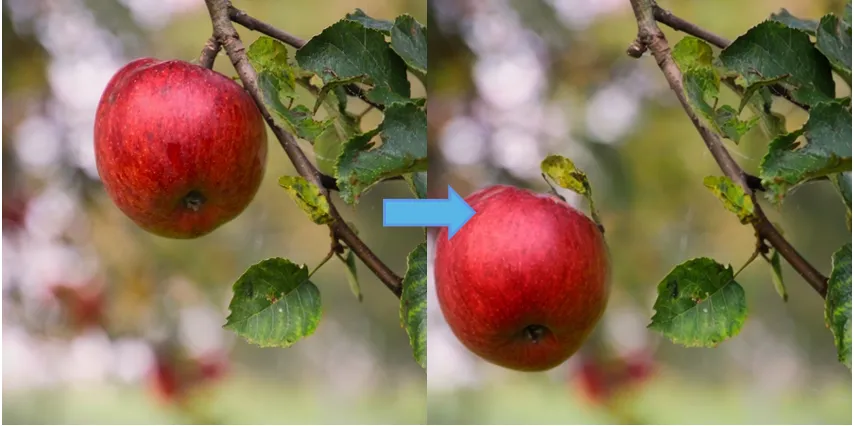

物体移动结果

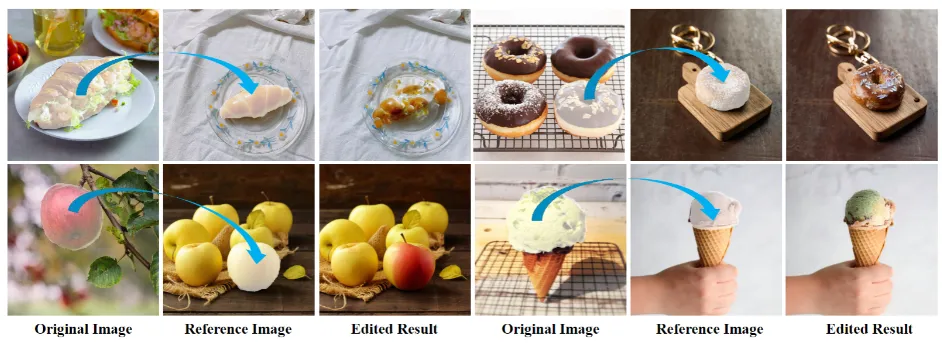

物体外观替换结果

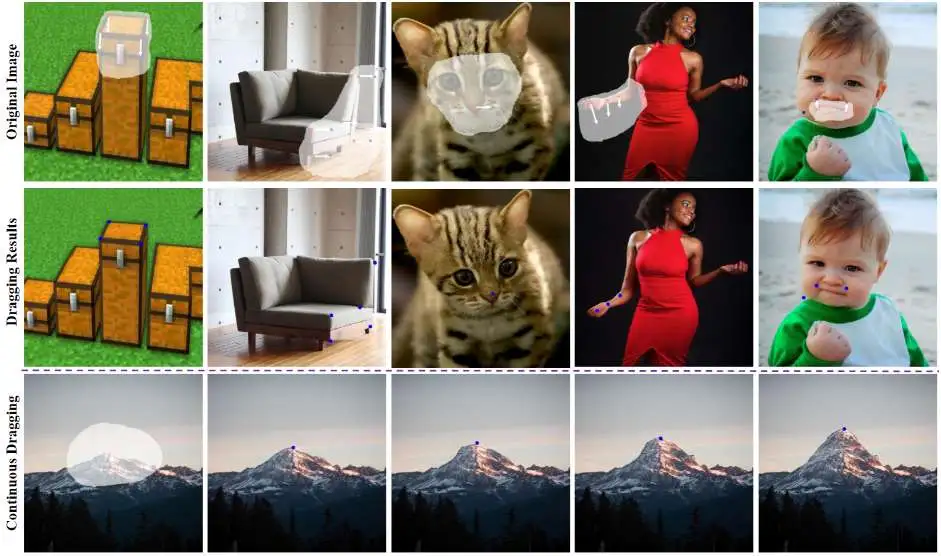

内容拖拽结果