出品 | 51CTO技术栈(微信号:blog51cto)

就在昨晚,Meta冷不防就把自家的大模型发布前的决策步骤对外公开了。

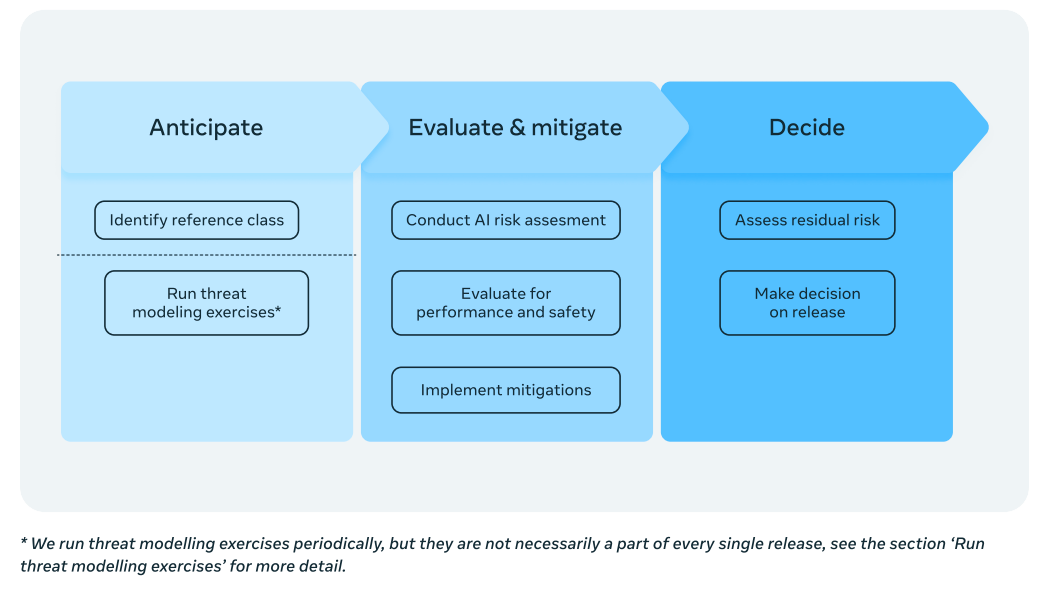

“我们在开发和发布前沿AI时遵循的流程的概述,以确保我们在整个过程中监控和管理风险。我们的治理方法可以分为三个主要阶段:计划、评估和缓解、以及决策。

在任何阶段的发现都可能通过我们的集中审查流程引发讨论,这确保了高级决策者参与开发和发布生命周期的全过程。”

图片

图片

1.Meta:停止发布极高风险的AI模型

在一份新的政策文件中,Meta 表示,在某些情况下,它可能不会发布内部开发的高性能人工智能系统。

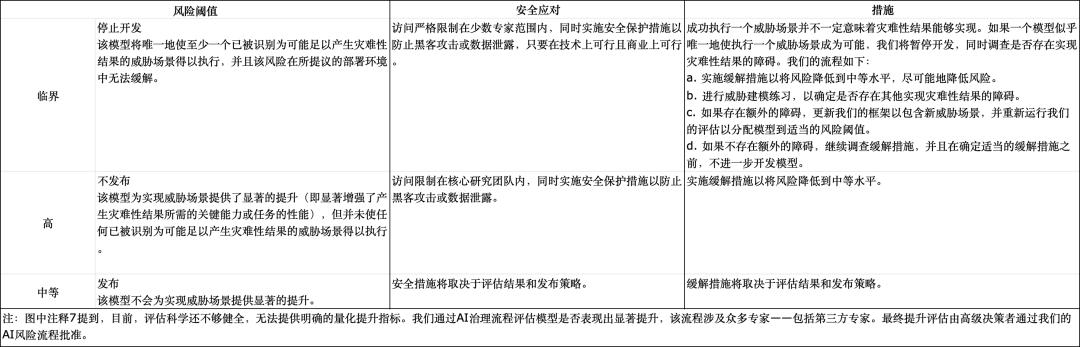

该文件被 Meta 称为“前沿人工智能(Frontier AI)框架”,其中确定了两种该公司认为风险过高的人工智能系统:“高风险”系统和“关键风险”系统。

根据 Meta 的定义,“高风险”和“极高风险”系统都能够“协助”网络安全、化学和生物攻击,不同之处在于“极高风险”系统可能导致“在拟议的部署环境中造成无法缓解的灾难性后果”。相比之下,高风险系统可能会使攻击更容易实施,但成功的概率不如极高风险系统那么大。

在这里,我们谈论的是哪种攻击?Meta 给出了几个例子,比如“对最佳实践保护的企业级环境的自动端到端攻击”和“高影响力生物武器的扩散”。Meta 承认,其文件中列出的可能灾难远非详尽无遗,但包括 Meta 认为“最紧迫”的灾难,以及发布强大的 AI 系统可能直接导致的灾难。

2.现在的评估科学并不强大

令人有些惊讶的是,根据该文件,Meta 对系统风险的分类并非基于任何一项实证检验,而是基于内部和外部研究人员的意见,并接受“高级决策者”的审查。为什么?Meta 表示,现在评估科学“不足够强大,无法提供明确的量化指标”来决定系统的风险性。

如果 Meta 确定某个系统具有高风险,该公司表示,它将在内部限制对系统的访问,并且在实施缓解措施以“将风险降低到中等水平”之前不会发布该系统。另一方面,如果某个系统被视为具有严重风险,Meta 表示,它将实施未指定的安全保护措施,以防止系统被泄露,并停止开发,直到系统的危险性降低为止。

图片

图片

但风险和利益并存。Meta认为,通过在决定如何开发和部署先进AI时同时考虑利益和风险,可以以一种既保持该技术对社会的利益,又保持适当风险水平的方式将该技术提供给社会。

“虽然本框架的重点是我们在预测和缓解灾难性结果风险方面的努力,但强调开发先进AI系统的最初原因是因为这些技术对社会的巨大潜在利益是很重要的。与量化风险一样,量化AI的利益是一门不完美的科学。”

首先,风险和利益都是逐渐出现的,而且往往在不同的时间范围内,因此技术的整体影响可能会随着时间的推移而变化。

其次,许多影响很难量化。例如,访问先进的AI模型对推进不同领域的科学研究有明显的好处,但量化这些研究的价值极其困难,其他发现或变量也会影响研究的规模和影响。

即使对于可以分配收入生成或生产力提高百分比等具体结果的情况,通常也存在主观判断,即这些经济利益对社会的重要性。

“虽然不可能消除主观性,但我们认为考虑我们开发的技术的利益是很重要的。这有助于我们确保实现我们向社区提供这些利益的目标。它还推动我们专注于充分缓解我们识别的任何重大风险的方法,而不会消除我们最初希望提供的利益。”

3.下一步计划

Meta期望更新前沿AI框架,以反映技术和我们对如何管理其风险和收益的理解的发展。“为此,有必要观察模型在其部署环境中的表现,并监控AI生态系统的演变。这些观察结果将反馈到我们评估已部署模型的缓解措施的充分性以及我们框架的有效性。我们将根据这些观察结果更新我们的框架。”

文件称,Meta正在跟踪前沿AI能力和评估方面的最新技术发展,包括通过与同行公司以及更广泛的AI社区(包括学者、政策制定者、民间社会组织和政府)的互动。我们期望随着我们对如何衡量和缓解前沿AI潜在灾难性风险的集体理解的发展,更新我们的框架,包括与国家行为者相关的内容。这可能涉及添加、移除或更新灾难性结果或威胁场景,或改变我们准备模型进行评估的方式。我们可能会选择根据我们修订后的框架重新评估某些模型。

“我们认识到需要在Meta内部以及更广泛的生态系统中进行更多研究,以了解如何在开发前沿AI模型时有效衡量和管理风险。为此,我们将继续致力于:(1)提高评估的质量和可靠性;(2)开发额外的、健全的缓解技术;以及(3)更先进的开源AI模型发布后监控方法。”

4.Meta此举:既回应了OpenAI的闭源,也回应了DeepSeek的爆火

Meta 的 Frontier AI Framework似乎是为了回应外界对该公司“开放”系统开发方式的批评。该公司表示,该框架将随着人工智能格局的变化而发展,而 Meta此前承诺将在本月法国人工智能行动峰会之前发布该框架。Meta 采取的策略是公开提供其人工智能技术(尽管按照普遍理解的定义,它不是开源的),这与 OpenAI 等选择将系统置于 API 之后的公司形成了鲜明对比。

对于 Meta 来说,开放发布的方式已被证明是好事也是坏事。该公司的 AI 模型系列Llama的下载量已达数亿次。但据报道, Llama 还被至少一名美国对手用来开发国防聊天机器人。

有媒体认为,Meta发布 Frontier AI 框架,或许也是为了将其开放 AI 战略与中国 AI 公司 DeepSeek 进行对比。

随着DeepSeek-R1的推出,全球开源大模型领域都在将目光转向DeepSeek,但有关用户数据安全的担忧也随之而来。从外媒报道来看,虽然有夸张的成分,比如用户数据被中国公司操纵(毫无根据),但也有部分合理的质疑:输出内容幻觉仍然存在,代码生成方面不如o1等等。

Meta 在文件中写道:“我们相信,在制定有关如何开发和部署先进人工智能的决策时,通过同时考虑利益和风险,就有可能以一种既保留该技术对社会的利益又保持适当风险水平的方式将该技术推向社会。”

Meta 首席执行官扎克伯格曾经表示,有朝一日会将AGI公开,大家一起期待。