人工智能在过去十年中的发展令人惊叹。其中,2017 年 Google 发布的“Attention Is All You Need”论文奠定了神经网络架构的重要基础,推动了大规模语言模型(LLM)的突破。

OpenAI 早期专注于强化学习(RL),但在 Transformer 结构问世后,迅速调整方向,借助 Google 的开源研究开发出强大的 LLM。然而,尽管 OpenAI 最初以“开放”为宗旨,近年来却逐渐转向封闭模式,自 GPT-2 以来,其所有模型进展均未再公开。

最近,OpenAI 发布了名为 “o1” 的新模型,专注于增强长链式思维(Chain-of-Thought)和强化学习,以提升解决复杂问题的能力。然而,该模型的具体训练细节仍未公开。

但这一切正在改变。

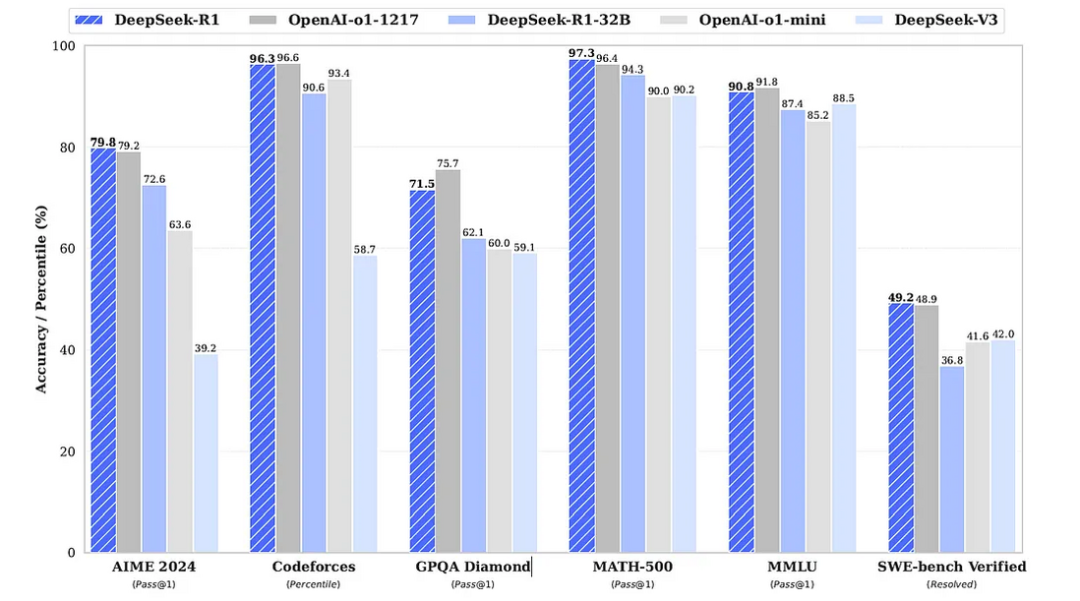

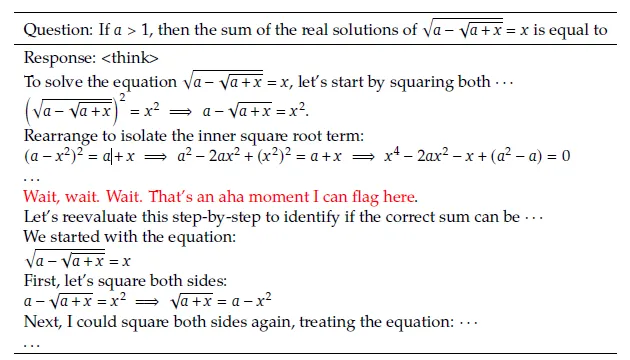

中国 AI 公司 DeepSeek 近期发布了新一代模型 DeepSeek-R1,在复杂领域的推理能力上媲美 OpenAI 的 o1,甚至在多个数学和编程基准测试上超越了它。

图片

图片

LLM 的标准训练流程

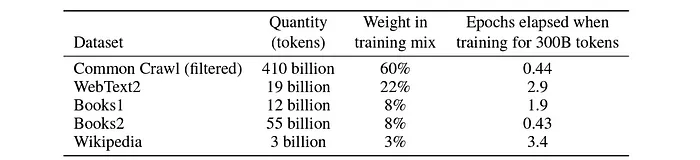

训练大规模语言模型通常从大规模文本数据的收集开始。这些数据可能来自公开网络资源或专有数据集。

图片

图片

随后,这些数据经过清理、格式化、分词,并转换为文本嵌入,供模型进行自监督学习。这一阶段称为预训练,帮助模型掌握语法、语义和上下文关系。

在此基础上,模型会经过 监督微调(SFT),用于提升特定任务(如数学推理、编程、翻译等)的能力。

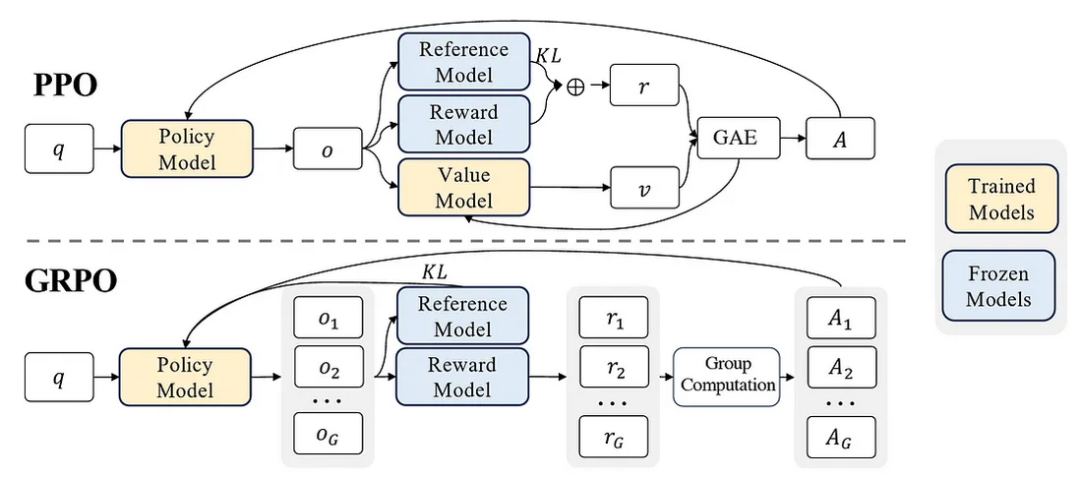

为了确保模型生成的内容符合人类偏好,通常会通过基于人类反馈的强化学习(RLHF)进行优化,例如使用 PPO(近端策略优化) 或 DPO(直接偏好优化)。

强化学习在长链式思维的优化上发挥着关键作用,这也是 DeepSeek-R1 能够展现强大推理能力的核心原因。

突破 SFT 训练方式,直接使用强化学习

DeepSeek 团队以 DeepSeek-V3-Base 作为预训练基础模型,并跳过了传统的 SFT 过程,直接使用强化学习(RL)来提升推理能力。这使得模型能够在没有监督数据的情况下,自我进化并提升推理能力。

在强化学习中,DeepSeek 团队并未采用 OpenAI 开发的 PPO,而是提出了一种自研算法 GRPO(组相对策略优化)。

PPO vs. GRPO

- PPO 依赖“策略模型”和“价值模型”计算优势估计(Advantage Estimation),计算成本较高。

- GRPO 直接根据一组样本的相对奖励计算优势估计,避免了价值模型的计算,提高训练效率并降低成本。

强化学习奖励机制

DeepSeek-R1 采用基于规则的奖励系统,而非神经网络奖励模型,以减少计算开销并避免“奖励作弊”现象。

- 准确性奖励:依据答案的正确性给予分数。

- 格式奖励:若模型在回答中遵循特定格式,则额外加分。例如,推理过程包裹在 <think></think> 标签中,最终答案位于 <answer></answer> 标签内。

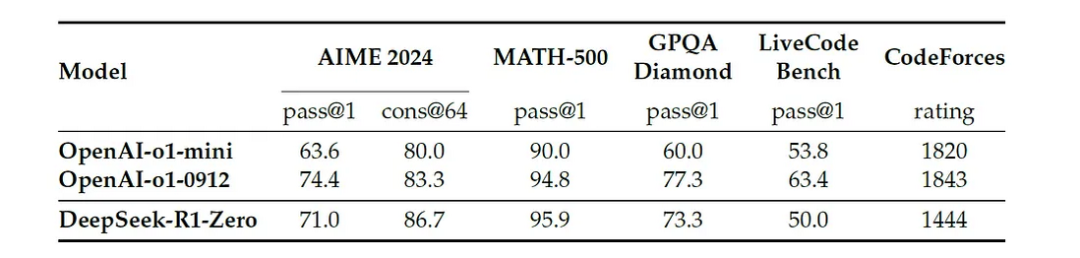

经过这一训练阶段,模型进化为 DeepSeek-R1-Zero,并展现出惊人的推理能力。

图片

图片

DeepSeek-R1-Zero 训练效果

随着强化学习的持续进行,**DeepSeek-R1-Zero 在 AIME(2024)数学竞赛上的首答正确率(pass@1)从 15.6% 提升至 71%**,几乎与 OpenAI o1 持平。

图片

图片

进一步测试表明,在 cons@64 指标上,DeepSeek-R1-Zero 甚至超越了 OpenAI o1(83.3% vs 86.7%)!

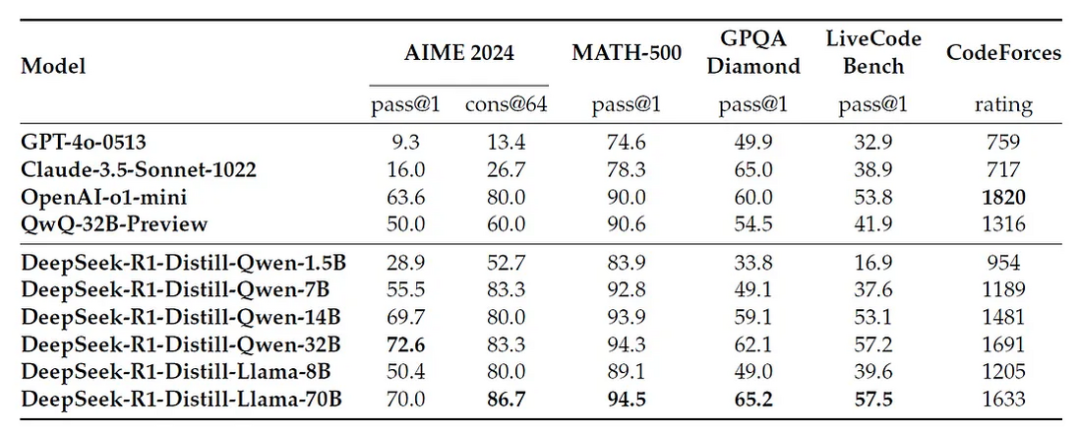

强化学习训练中的关键现象

- 模型逐渐增加计算时间,并生成更多推理步骤,以深入思考复杂问题。

- 自我反思、自我纠正 等能力自然出现,使其能够回顾并调整推理过程。

- 在训练过程中,研究人员观察到模型在推理某个复杂数学问题时,突然意识到自己可以更深入思考,并主动重新评估之前的推理步骤——这种现象被称为“顿悟时刻(Aha Moment)”。

图片

图片

补充 SFT 以优化模型表达能力

尽管纯强化学习训练提升了推理能力,但 DeepSeek-R1-Zero 仍然存在一些问题,例如:

- 输出格式混乱,影响可读性。

- 回答可能混杂多种语言。

为此,研究人员引入了一小部分 长链式思维(CoT)数据 进行 SFT,确保模型能够清晰表达推理过程。随后,再次使用强化学习优化推理能力,同时引入语言一致性奖励,确保生成的内容保持单一语言表达。

最终,模型演化为 DeepSeek-R1。

DeepSeek-R1 超越 OpenAI o1 的测试表现

DeepSeek-R1 在多个基准测试上展现出卓越表现,尤其是在:

- 数学推理(AIME、MATH-500)

- 编程能力(LiveCodeBench、SWE Verified、Codeforces)

此外,DeepSeek-R1 还在长上下文理解、事实性问答、写作任务等领域超过了自家的 DeepSeek-V3,并在格式化指令跟随能力上表现优异。

图片

图片

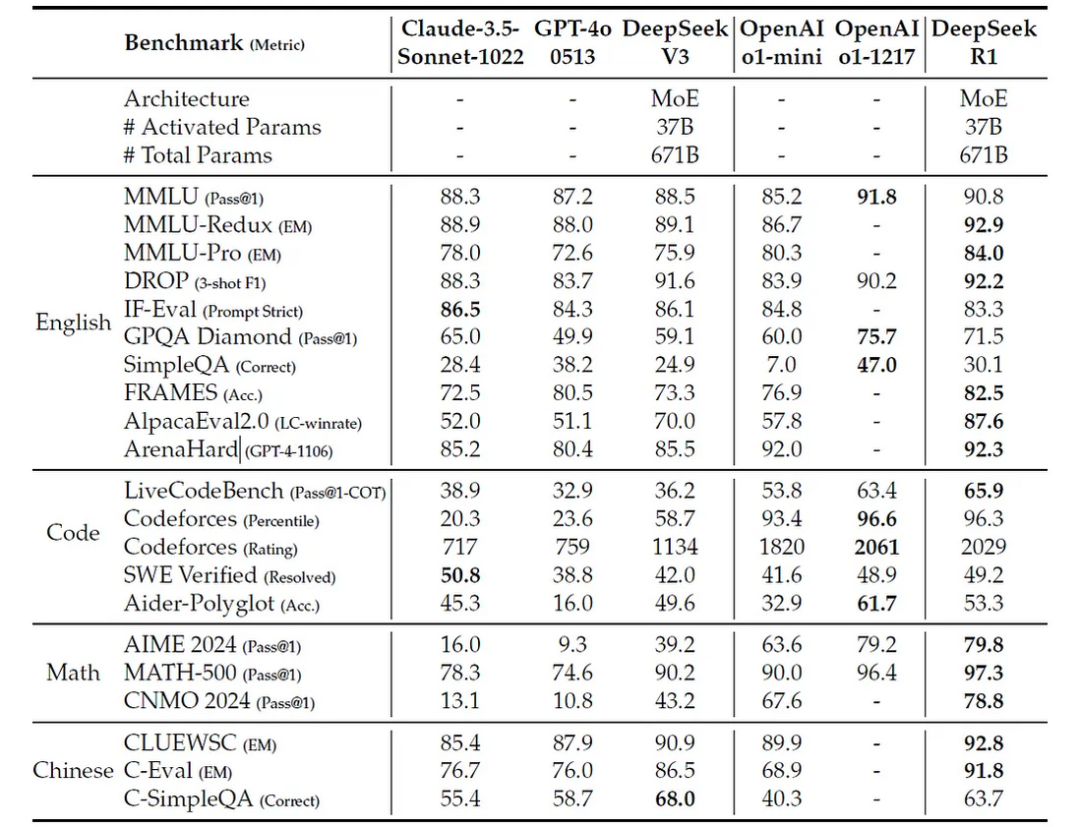

小型模型的蒸馏研究团队使用 知识蒸馏 方法,将 DeepSeek-R1 的知识迁移至更小的 Qwen 和 Llama 模型,如:

- DeepSeek-R1-Distill-Qwen-32B 超越 OpenAI o1-mini。

- DeepSeek-R1-Distill-Llama-70B 在多数测试中远胜对手。

为了进一步优化,研究人员还尝试对 Qwen-32B 进行 RL 训练,最终得到 DeepSeek-R1-Zero-Qwen-32B,其推理能力达到 Qwen 旗下最强模型 QwQ-32B-Preview 的水平。

图片

图片

训练成本与推理费用

DeepSeek-R1 采用 6710 亿参数的 专家混合架构(MoE),但训练成本远低于 OpenAI 和 Meta 的同类模型。

- DeepSeek-R1 训练成本约为 10M(相比之下,GPT-4 训练成本约 $100M,o1 可能更高)。

- 推理费用仅 60 / 100 万 tokens,后者比 DeepSeek-R1 贵 27 倍。

DeepSeek-R1 未来展望

尽管 DeepSeek-R1 在某些任务上仍逊于 DeepSeek-V3(如函数调用、多轮对话、JSON 生成等),但其开源研究已经对 AI 领域产生深远影响。

Hugging Face 目前已发布开源复现版 Open-R1,预计未来将有更多基于 DeepSeek-R1 的项目涌现。

这一突破不仅提升了开源 LLM 的竞争力,更加速了 AI 技术的民主化进程!