1. 一眼概览

MetaDiff 提出了一种基于条件扩散模型的创新元学习方法,通过将梯度下降优化建模为去噪过程,有效提升了小样本学习(FSL)的性能,显著减少了内循环优化中的内存负担和梯度消失风险。

2. 核心问题

小样本学习的主要挑战在于:如何在训练数据有限的情况下快速适应新任务,而不引入过拟合或内存瓶颈。传统基于梯度的元学习方法需要计算内循环路径上的二阶导数,导致内存消耗高和梯度消失问题,从而影响性能。

3. 技术亮点

1. 创新建模:首次揭示梯度下降算法与扩散模型之间的密切联系,提出将梯度下降建模为扩散去噪过程;

2. 条件扩散元学习:设计了基于条件扩散模型的元学习框架,通过噪声预测优化任务特定权重;

3. 高效性与鲁棒性:避免内循环路径的反向传播,大幅降低内存开销,提升小样本学习的效率和稳定性。

4. 方法框架

MetaDiff 的核心流程如下:

- 特征编码:通过共享的嵌入网络将支持集和查询集样本编码为特征向量;

- 噪声初始化:为任务特定的基础分类器随机初始化权重;

- 扩散去噪:通过任务条件 UNet,逐步去除权重中的噪声,优化至目标权重;

- 分类预测:利用优化后的基础分类器对查询集样本进行分类。

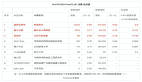

5. 实验结果速览

在 MiniImagenet 和 TieredImagenet 数据集上的实验结果显示,MetaDiff 超越了多种最先进的基于梯度的元学习方法:

• 在 5-way 1-shot 设置中,MetaDiff 的准确率提升了 1%-3%;

• GPU 内存占用在增加内循环步数时保持不变,相比传统方法显著降低。

6. 实用价值与应用

MetaDiff 的优势在于其通用性和高效性,适用于小样本场景的快速学习任务,如医学影像分析、冷启动推荐系统等。其扩展潜力包括其他优化算法的建模和低资源领域的应用。

7. 开放问题

• MetaDiff 能否扩展至处理多模态数据的小样本学习?

• 在梯度计算较复杂的场景中,MetaDiff 的条件 UNet 是否需要进一步优化?