整理 | 言征

出品 | 51CTO技术栈(微信号:blog51cto)

大型语言模型的竞争似乎正在结束,只有少数几个明显的赢家。其中,DeepSeek V3 已成为 2024 年的焦点,引领中国开源模型的发展。据 Hugging Face 称,DeepSeek V3 与 GPT-4 和 Claude 3.5 等闭源巨头正面交锋,上个月的下载量为 45,499 次,与Meta 的 Llama 3.1(491,629 次下载)和谷歌的 Gemma 2(377,651 次下载)并驾齐驱。但并非今年推出的所有 LLM 都能乘风破浪——有些失败了,尽管前景光明,但未能引起人们的兴趣。以下是 2024 年未能取得成功的模型。

1.Databricks:DBRX

2024 年 3 月, Databricks推出了 DBRX,这是一款拥有 1320 亿个参数的开源 LLM。它采用细粒度的 MoE 架构,每个输入激活 16 位专家中的 4 位,拥有 360 亿个活动参数。该公司声称,该模型的表现优于 GPT-3.5 和 Gemini 1.5 Pro 等闭源模型。

然而,自推出以来,很少有人讨论它的采用情况,或者企业是否认为它适合构建应用程序。Mosaic 团队于 2023 年被 Databricks 以 13 亿美元收购,该团队领导了其开发,该公司花费 1000 万美元打造了 DBRX。但遗憾的是,该模型上个月在 Hugging Face 上的下载量惨不忍睹,只有 23 次。

2.TII:Falcon 2

5 月,阿布扎比技术创新研究所 (TII) 发布了其下一代 Falcon 语言模型,包括两个版本:Falcon-2-11B 和 Falcon-2-11B-VLM。Falcon 2 模型的基准性能令人印象深刻,Falcon-2-11B 的表现优于Meta 的 Llama 3 8B,并与Google 的 Gemma 7B 相当,这已由 Hugging Face 排行榜独立验证。

然而,Meta 在今年晚些时候发布了 Llama 3.2 和 Llama 3.3,将 Falcon 2 抛在身后。据 Hugging Face 称,Falcon-2-11B-VLM上个月的下载量仅为 1,000 次左右。

3.Snowflake:Arctic

今年 4 月,Snowflake 推出了Arctic LLM,这是一个拥有 480B 参数的模型,使用 128 位专家构建了一个密集的 MoE 混合 Transformer 架构。该公司自豪地表示,它只花了 200 万美元来训练该模型,在 SQL 生成等任务上的表现优于 DBRX。

该公司对 DBRX 的关注表明其试图挑战 Databricks。同时,Snowflake 承认 Llama 3 等模型在某些基准测试中表现优于它。

4.Stable:LM 2

Stability AI 于去年 1 月推出了Stable LM 2 系列,包含两个版本:Stable LM 2 1.6B 和 Stable LM 2 12B。1.6B 模型经过 2 万亿个 token 的训练,支持西班牙语、德语、意大利语、法语和葡萄牙语等七种语言,在大多数任务中的表现都优于微软的 Phi-1.5 和 TinyLlama 1.1B 等模型。

5 月份推出的稳定版 LM 2 12B 提供 120 亿个参数,并使用 7 种语言的 2 万亿个词条进行训练。该公司声称,该模型可与 Mixtral、Llama 2 和 Qwen 1.5 等大型模型相媲美,在 RAG 系统的工具使用方面表现出色。然而,最新的用户统计数据却讲述了一个不同的故事,12月的下载量仅为 444 次。

5.Nemotron-4 340B

Nemotron-4-340B-Instruct是 NVIDIA 为合成数据生成和聊天应用程序开发的 LLM。它于 2024 年 6 月发布,是 Nemotron-4 340B 系列的一部分,该系列还包括 Base 和 Reward 版本。尽管该模型功能强大,但其普及率却很低,2024 年 12 月在 Hugging Face 上的下载量仅为 101 次左右。

6.Jamba

AI21 Labs于 2024 年 3 月推出了 Jamba,这是一款将基于 Mamba 的结构化状态空间模型 (SSM) 与传统 Transformer 层相结合的 LLM。Jamba 系列包括多个版本,例如 Jamba-v0.1、Jamba 1.5 Mini 和 Jamba 1.5 Large。

Jamba 拥有 256K 的 token 上下文窗口,能够处理比许多竞争模型大得多的文本块,这最初引起了人们的兴奋。然而,该模型未能引起太多关注,上个月在 Hugging Face 上的下载量仅为 7K左右。

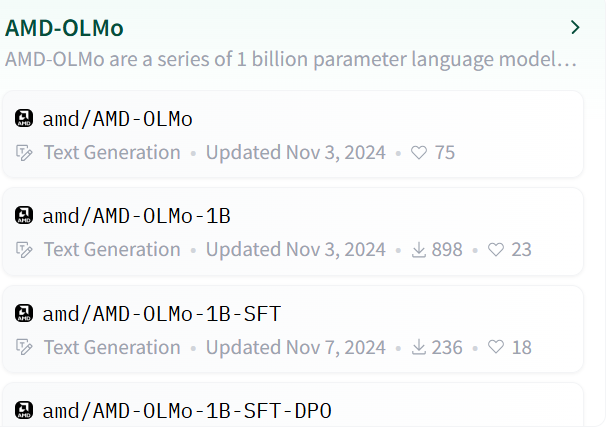

7.AMD OLMo

2024 年底,AMD 凭借其基于 Transformer 的解码器专用语言模型 OLMo 系列进入开源 AI 领域。OLMo 系列包括基础 OLMo 1B、OLMo 1B SFT(监督微调)和 OLMo 1B SFT DPO(通过直接偏好优化与人类偏好保持一致)。

该模型在 16 个 AMD Instinct MI250 GPU 驱动的节点上进行训练,实现了 12,200 个令牌/秒/gpu 的吞吐量。

旗舰模型 OLMo 1B 拥有 12 亿个参数、16 个层、16 个 head、隐藏层大小为 2048、上下文长度为 2048 个 token、词汇量为 50,280,面向开发者、数据科学家和企业。尽管如此,该模型在社区中仅收获了1k左右的下载。