由北京大学、上海人工智能实验室、南洋理工大学提出了一种新框架DiffSensei可以实现定制化漫画生成,解决现有方法在多角色场景中对角色外观和互动控制不足的问题。DiffSensei结合了基于扩散的图像生成器和多模态大语言模型(MLLM),其核心任务是生成具有动态多角色控制的漫画图像。

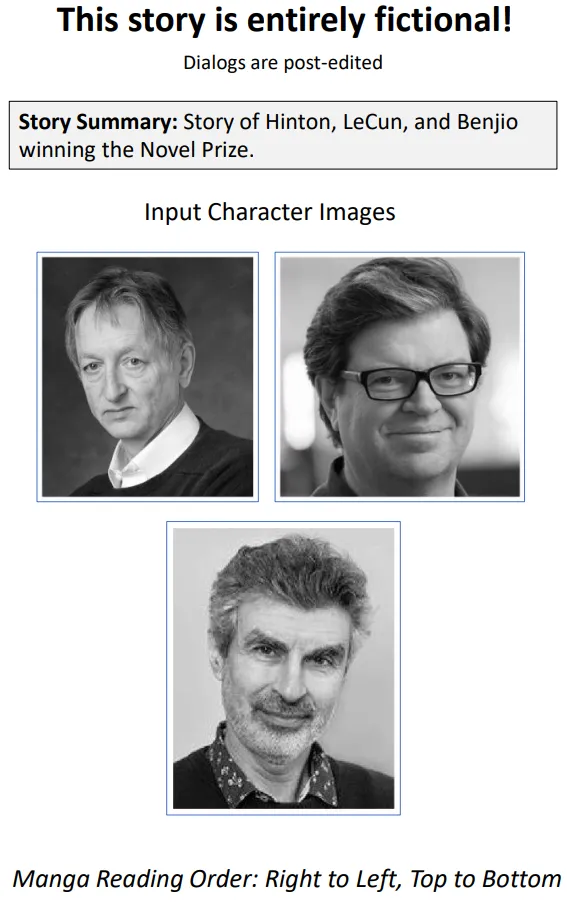

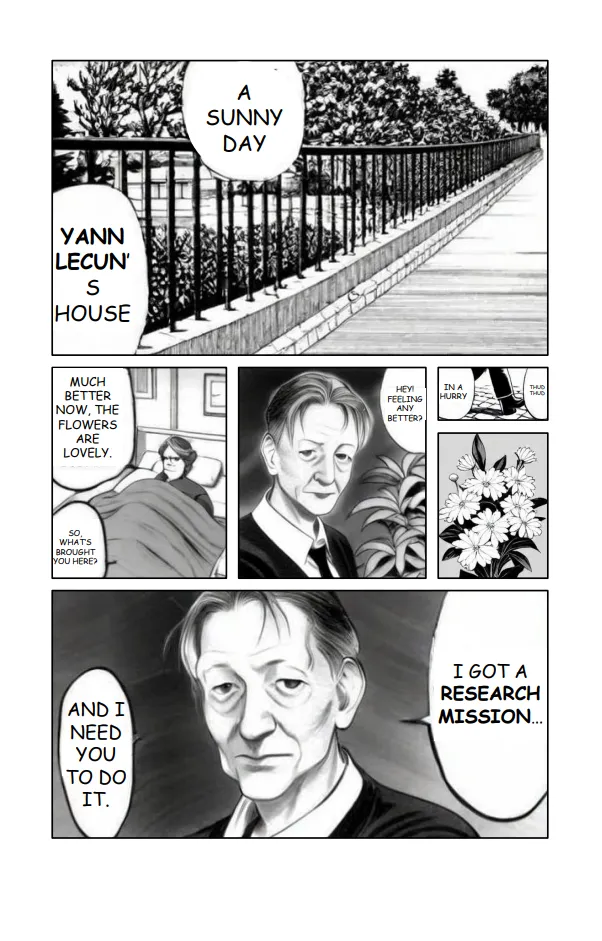

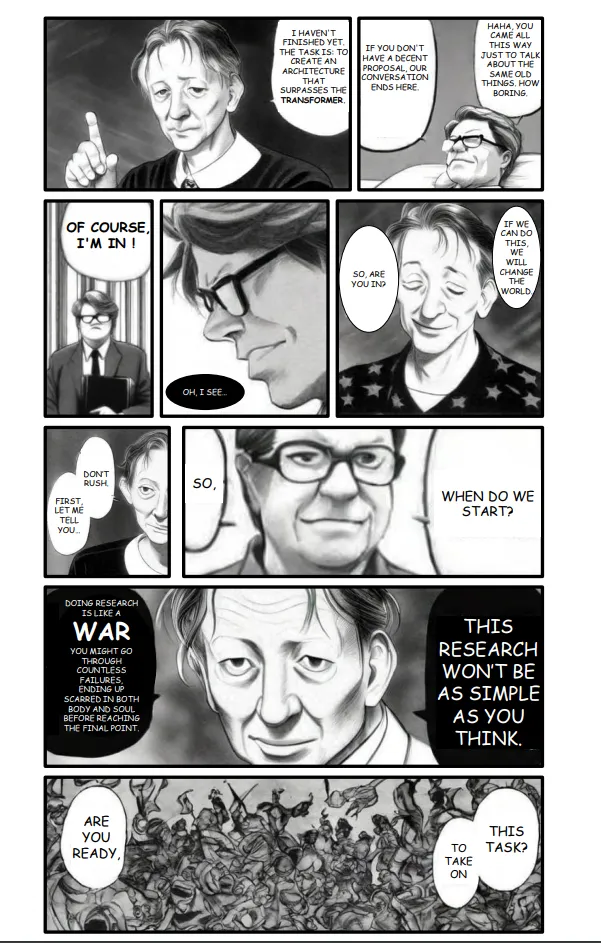

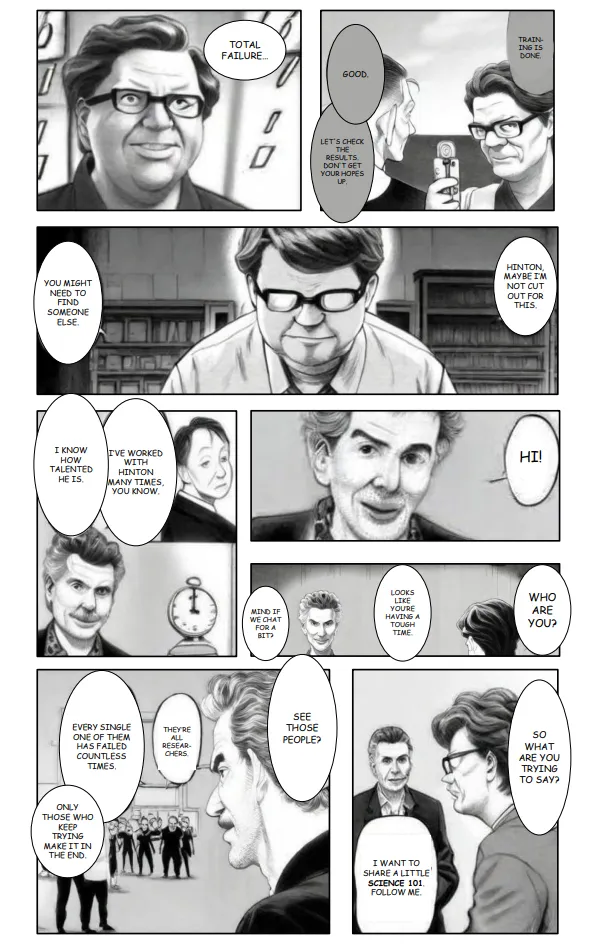

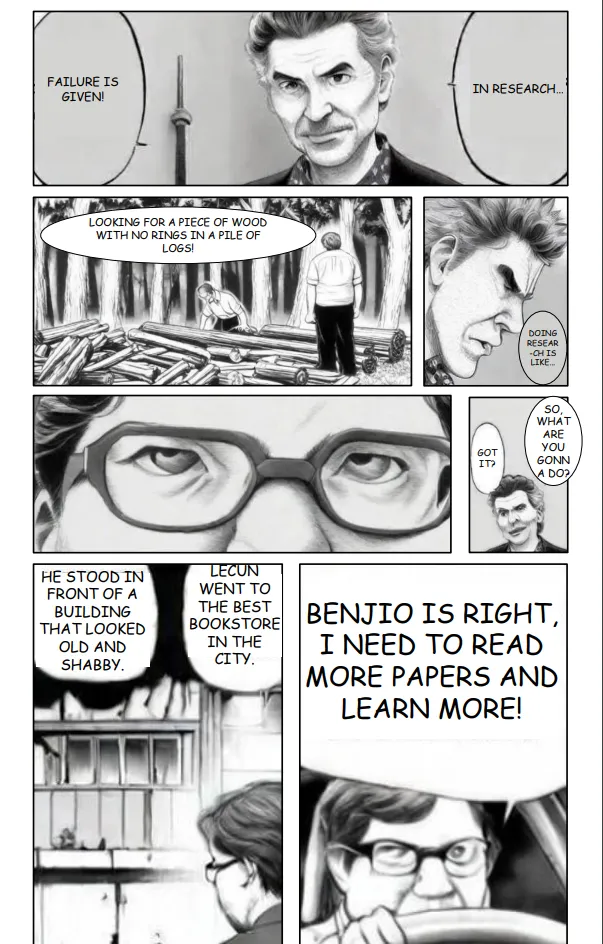

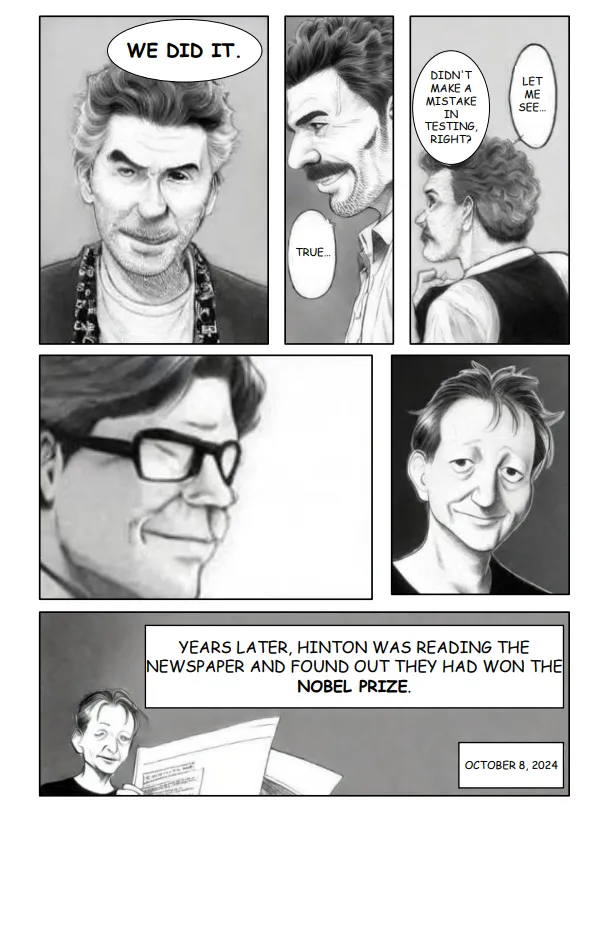

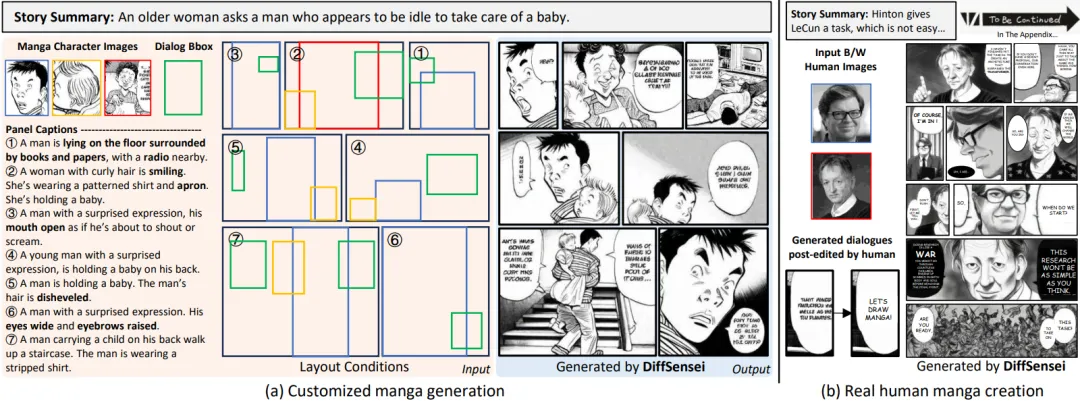

DiffSensei 的结果。(a)具有可控角色图像、面板标题和布局条件的定制漫画生成。DiffSensei 成功地根据面板标题生成了详细的角色表情和状态。(b)为真实人类图像创作漫画。对话由人类后期编辑。

DiffSensei 的结果。(a)具有可控角色图像、面板标题和布局条件的定制漫画生成。DiffSensei 成功地根据面板标题生成了详细的角色表情和状态。(b)为真实人类图像创作漫画。对话由人类后期编辑。

相关链接

- 论文:http://arxiv.org/abs/2412.07589v1

- 主页:https://jianzongwu.github.io/projects/diffsensei/

- 代码:https://github.com/jianzongwu/DiffSensei

- 数据集:https://huggingface.co/datasets/jianzongwu/MangaZero

论文阅读

DiffSensei:连接多模态 LLM 和扩散模型以实现定制漫画生成

DiffSensei:连接多模态 LLM 和扩散模型以实现定制漫画生成

摘要

故事可视化是从文本描述创建视觉叙事的任务,文本到图像生成模型已取得进展。然而,这些模型通常缺乏对角色外观和互动的有效控制,尤其是在多角色场景中。

为了解决这些限制,论文提出了一项新任务:定制漫画生成,并引入了 DiffSensei,这是一个专为生成具有动态多角色控制的漫画而设计的创新框架。DiffSensei 将基于扩散的图像生成器与充当文本兼容身份适配器的多模态大语言模型 (MLLM) 集成在一起。该方法采用掩蔽交叉注意来无缝整合角色特征,无需直接像素传输即可实现精确的布局控制。

此外,基于 MLLM 的适配器会调整角色特征以与面板特定的文本提示保持一致,从而可以灵活调整角色表情、姿势和动作。论文还推出了 MangaZero,这是一个专为此任务量身定制的大型数据集,包含 43,264 页漫画和 427,147 个带注释的面板,支持可视化连续帧中各种角色的互动和动作。大量实验表明 DiffSensei 的表现优于现有模型,通过实现文本自适应角色定制,标志着漫画生成取得了重大进步。

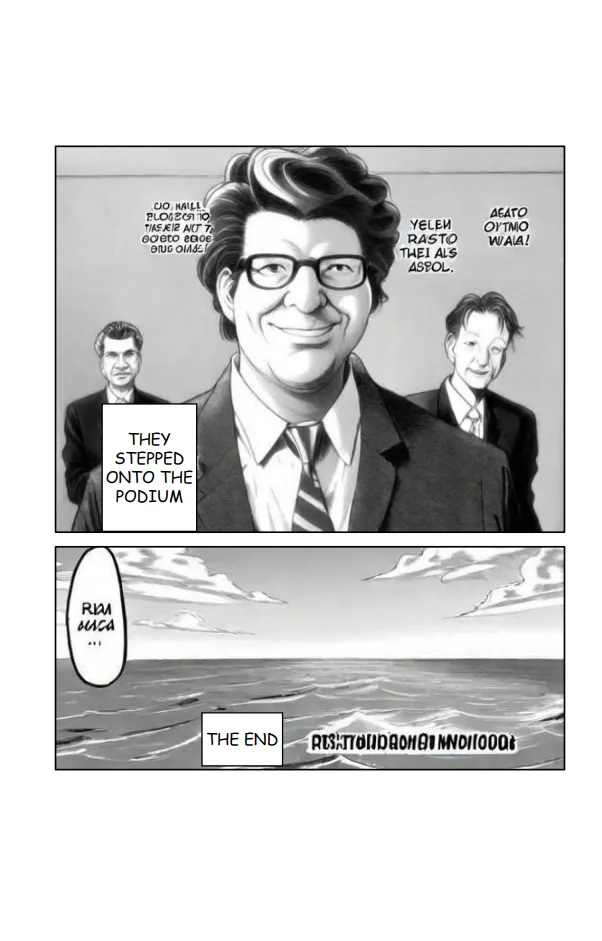

模型架构

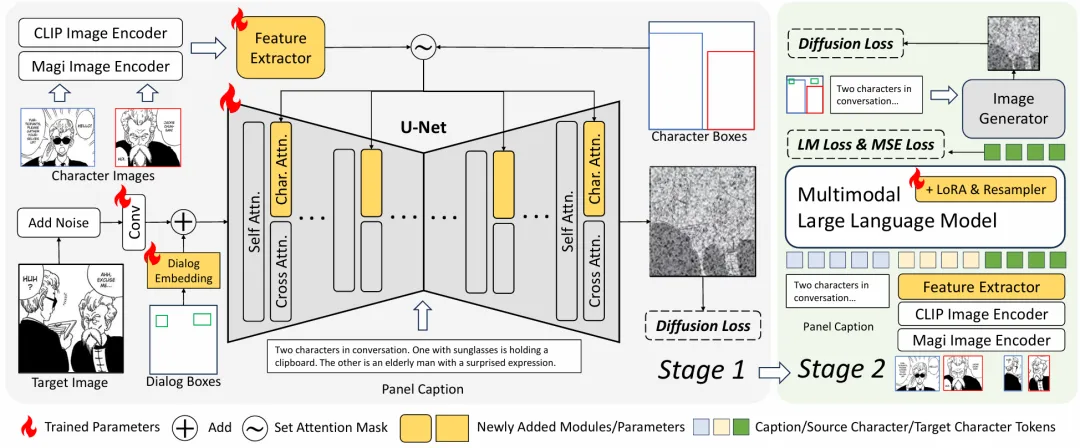

DiffSensei 的架构。 在第一阶段,论文训练一个具有布局控制的多角色定制漫画图像生成模型。在第一个卷积层之后,将对话嵌入添加到噪声隐含层中。U-Net 和特征提取器中的所有参数都经过训练。在第二阶段,微调 MLLM 的 LoRA 和重采样器权重,以适应与文本提示相对应的源角色特征。使用第一阶段的模型作为图像生成器并冻结其权重。

DiffSensei 的架构。 在第一阶段,论文训练一个具有布局控制的多角色定制漫画图像生成模型。在第一个卷积层之后,将对话嵌入添加到噪声隐含层中。U-Net 和特征提取器中的所有参数都经过训练。在第二阶段,微调 MLLM 的 LoRA 和重采样器权重,以适应与文本提示相对应的源角色特征。使用第一阶段的模型作为图像生成器并冻结其权重。

结果展示

关于 LeCun、Hinton 和 Benjio 获得诺贝尔奖的故事……