捍卫「人类智慧」最后一战!

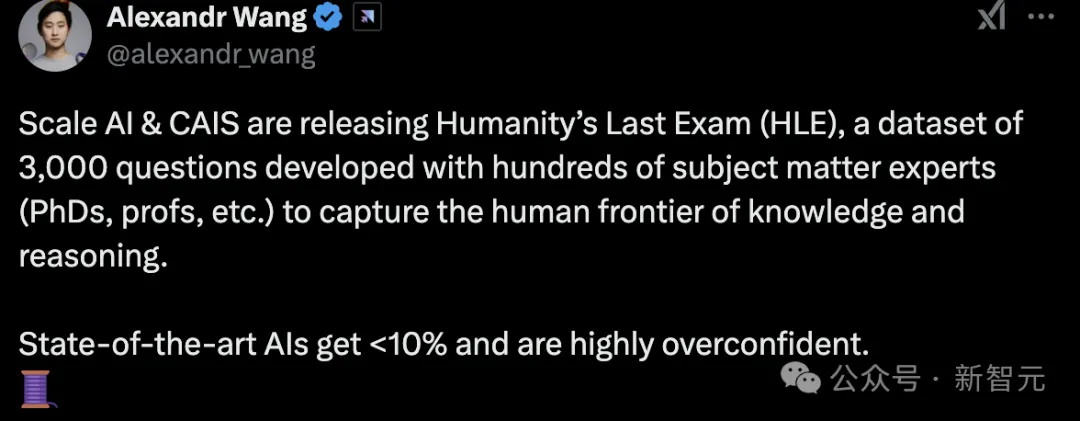

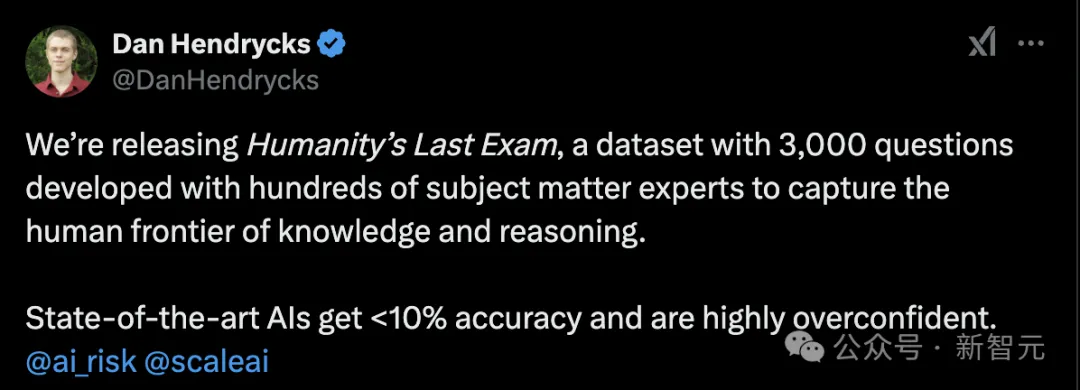

刚刚,Scale AI和Center for AI Safety(CAIS)公布了「人类最后一场考试」结果!

新基准全称「人类最后一次考试」(Humanity’s Last Exam),简称「HLM」,包含3000个问题,由数百位领域专家开发,用于追寻人类知识推理的边界。

目前,最好的模型,准确率也小于10%,而且自信「过头」。

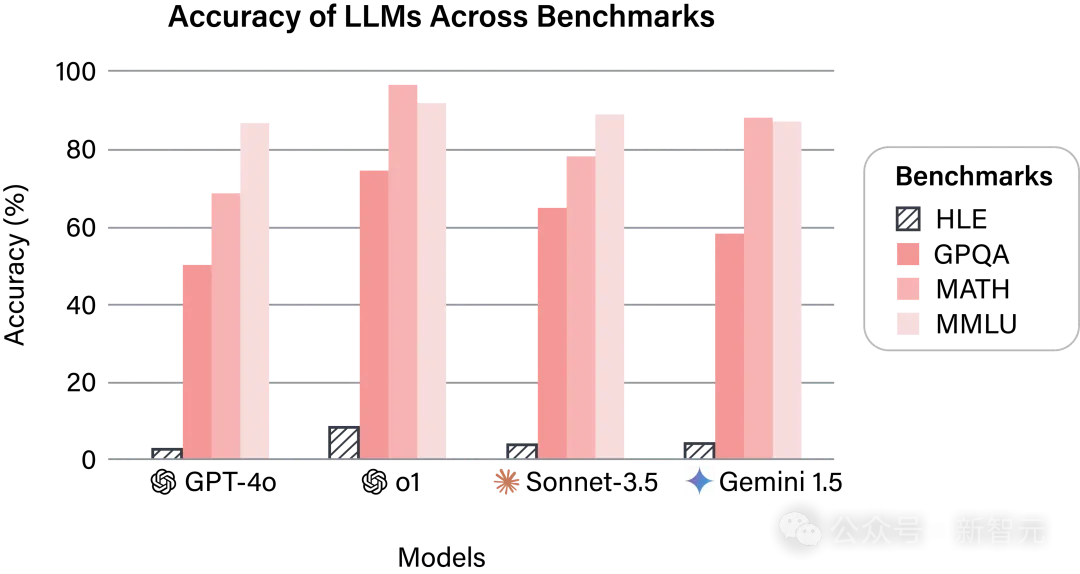

具体结果如下:

Scale AI和CAIS同时公布了相关论文、数据集和测试代码。

项目链接:https://lastexam.ai/

网友对这项工作也不吝赞赏:

「人类最后一次考试」

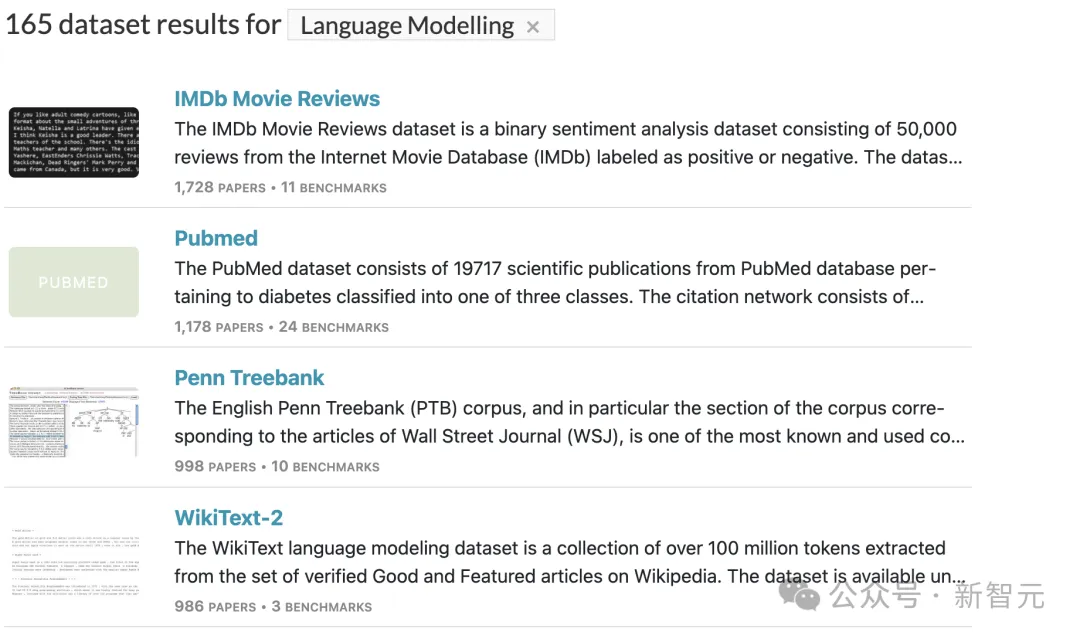

为了评估AI的能力的进展,已发布了多个数据集,针对语言模型,根据「Paper with code」网站统计,就有165个相关数据集。

然而,目前的基准测试难度并未跟上进步的步伐:LLM在一些热门基准测试(如MMLU)上已能达到90%以上的准确率,这限制了对最新LLM能力的有效评估。

甚至有基准被爆出,可能存在给某些模型「漏题」的问题。

为此,Scale AI和CAIS推出了名为「人类最后的考试」(Humanity's Last Exam)的多模态基准测试,旨在成为这类封闭式学术基准测试的最终版本,覆盖广泛的学科领域。

测评一览

「人类最后一次考试」(HLE)包含两种问题格式:

- 精确匹配题(Exact-Match Questions):模型需要输出一个完全匹配的字符串作为答案。

- 选择题(Multiple-Choice Questions):模型需要从五个或更多选项中选择一个正确答案。

此外,HLE是一个多模态基准测试,其中10%的问题要求理解文本和图像参考,80%的问题为精确匹配题,其余为选择题。

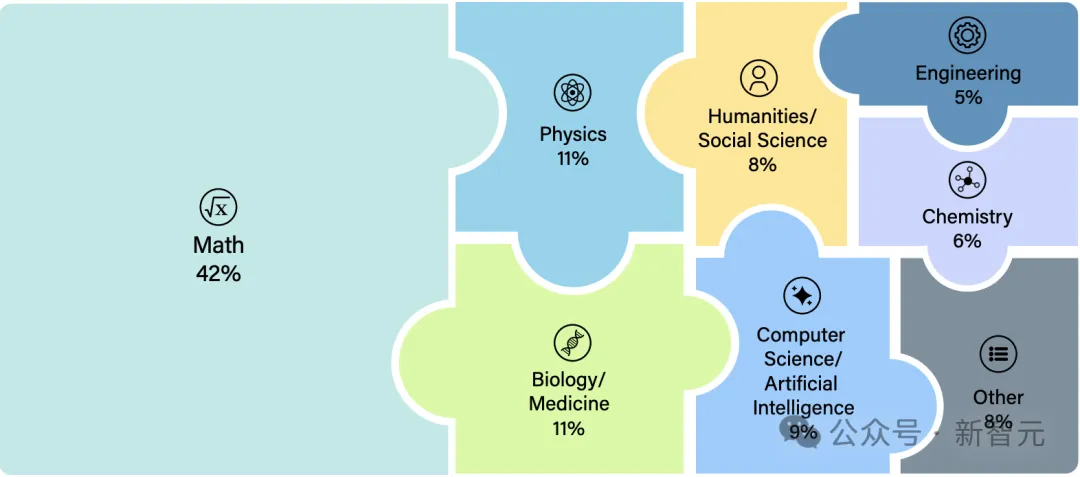

该数据集包含3000道难度较高的问题,涉及100多个学科。

各学科分类,大体如下:

图3:HLE高级类别分组。

大部分问题已公开发布,同时保留了一部分私有测试集,用于评估模型是否存在过拟合现象。

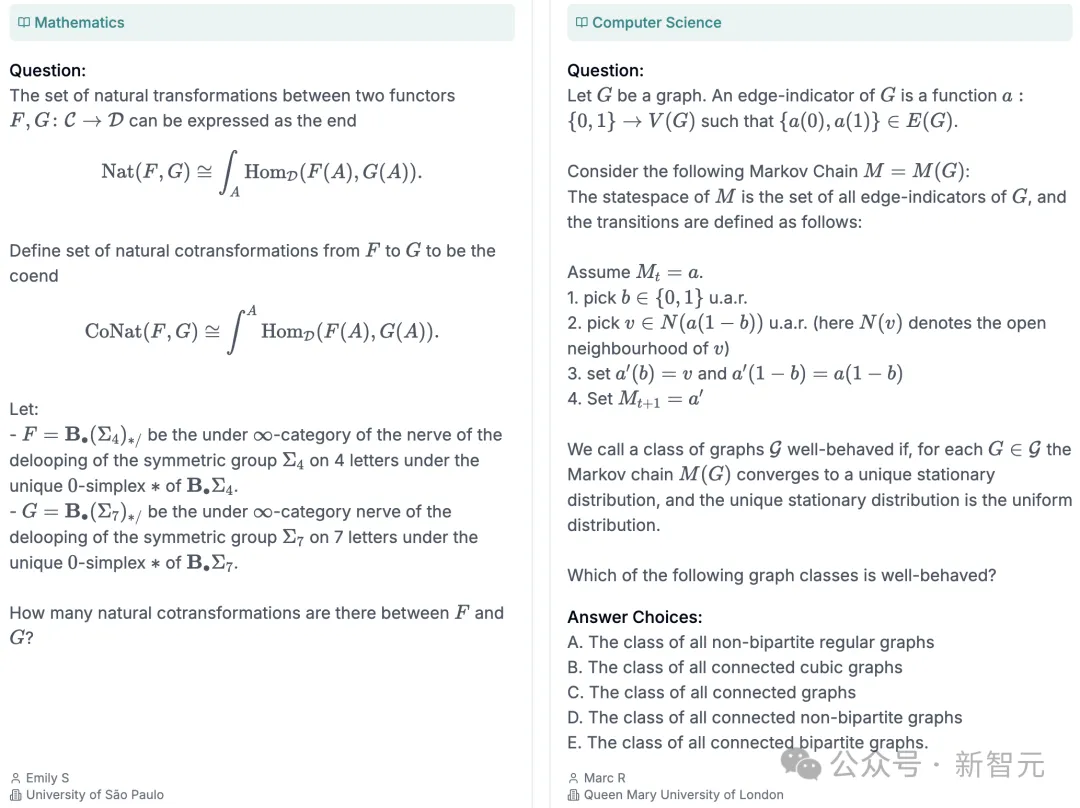

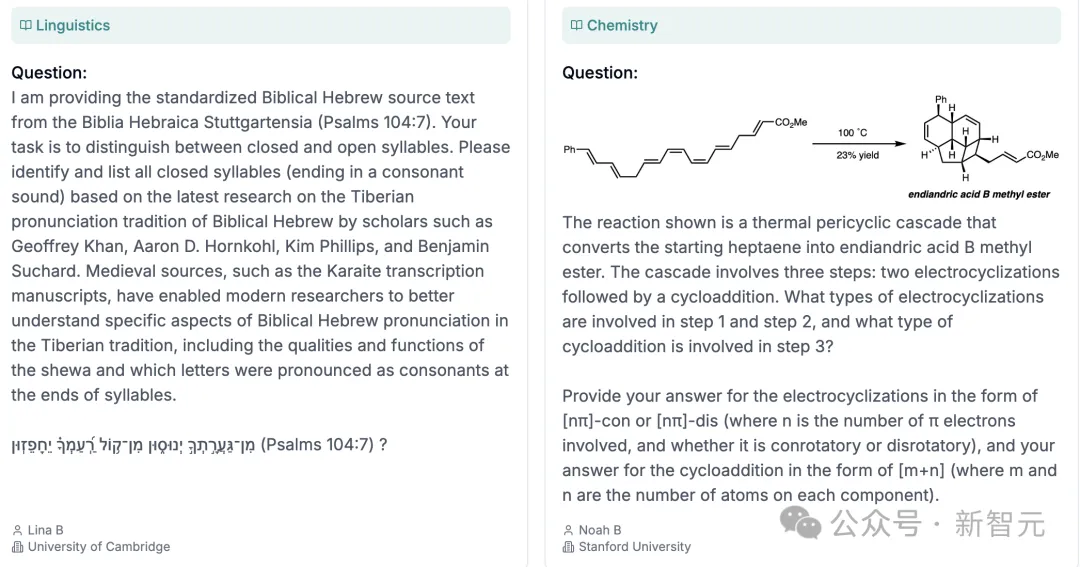

在项目网站上,公布了不同领域/科目的8个样题,包含化学、物理、数学、计算机科学、语言学等。

比如,其中的一道常识性问题:

希腊神话中,伊阿宋的曾祖父是谁?

具体样题,参考下列图片。

创建流程

为了吸引高质量的问题提交,HLE设立了总额50万美元的奖金池,并提供以下奖励:

- 顶级问题奖励:每道排名前50的问题将获得5,000美元奖金。

- 优质问题奖励:接下来的500道问题,每道将获得500美元奖金。

此外,任何被HLE接受的问题提交者,都有机会成为相关论文的共同作者,激励了众多高水平的专家参与,特别是那些拥有高级学位或在相关技术领域拥有丰富经验的专业人士。

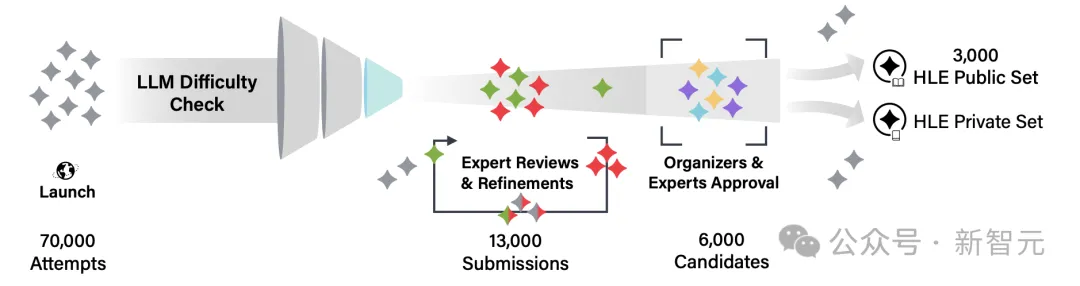

总体而言,总收集了超过70,000个试验性问题,其中13,000个问题被选出来供人类专家评审,进而最终确定在公开考试中发布的3,000个问题。

近1000名专家成功提交了问题。

他们来自50个国家的500多个机构,其中大多数贡献者是活跃的研究员或教授。

问题涵盖了多种格式,包括纯文本和多模态难题,整合了图像和图表。

为了确保问题的高质量和难度,HLE的数据集通过以下流程创建:

- 问题筛选:首先接收问题提交,这些问题专门前沿的LLM设计,LLM通常难以正确回答。

- 迭代优化:在专家同行评审的帮助下,反复修改和优化提交的问题,提升问题的复杂性和准确性。

- 手动审核:由组织者或由组织者培训的专家,手动审核每道问题,确保问题符合测试要求。

- 保留私有数据集:除了公开数据集,还保留了一部分私有测试集,用于评估模型在公开基准测试上的过拟合和可能的作弊行为。

HLE的数据集创建流程

具体结果

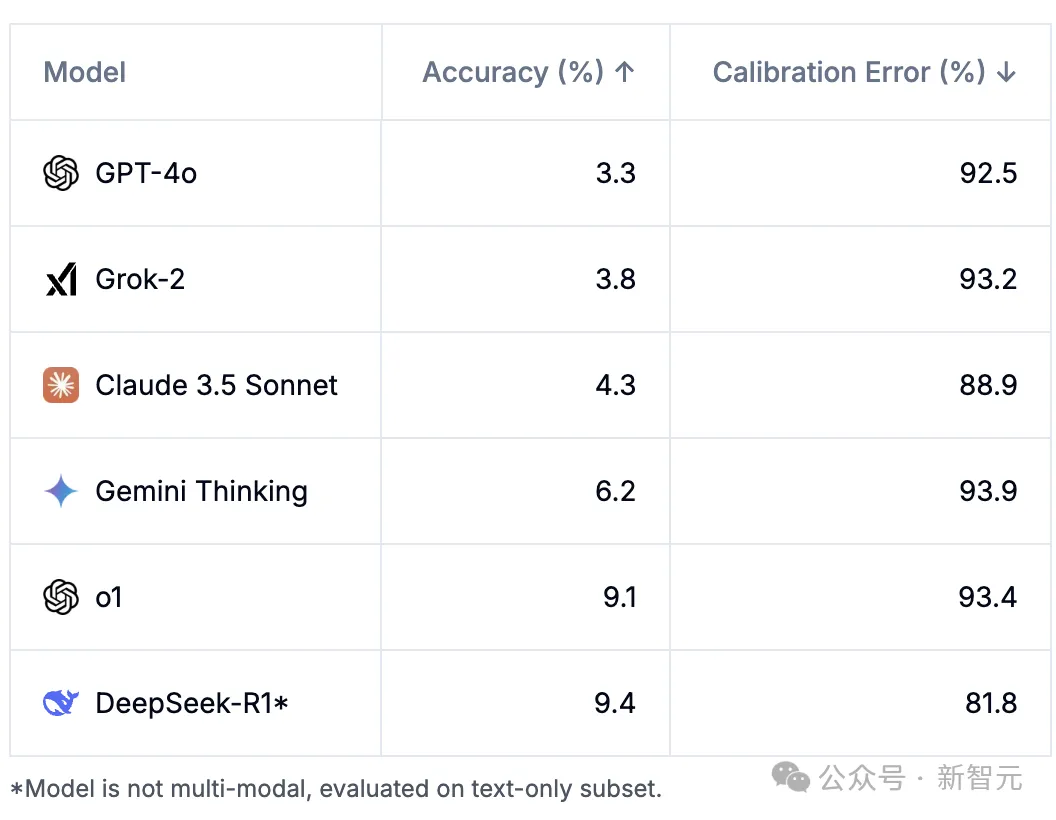

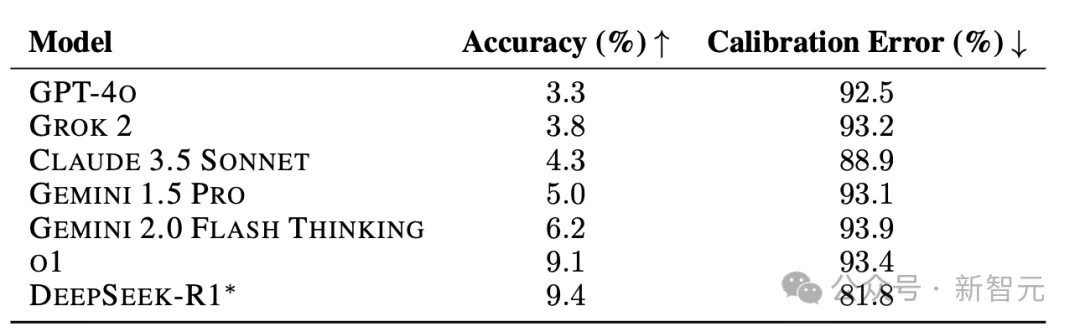

研究者共测评了7个模型,包括GPT-40、Grok 2、Claude 3.5 Sonnect、Gemini 1.5 Pro、Gemini 2.0 Flash Thinking、o1和DeepSeek-R1。

表1显示,所有前沿模型在HLE中的准确率都很低,所有模型的校准表现都很差,反映在较高的RMS校准误差分数中。

表1:不同模型在HLE上的准确率和RMS校准误差。

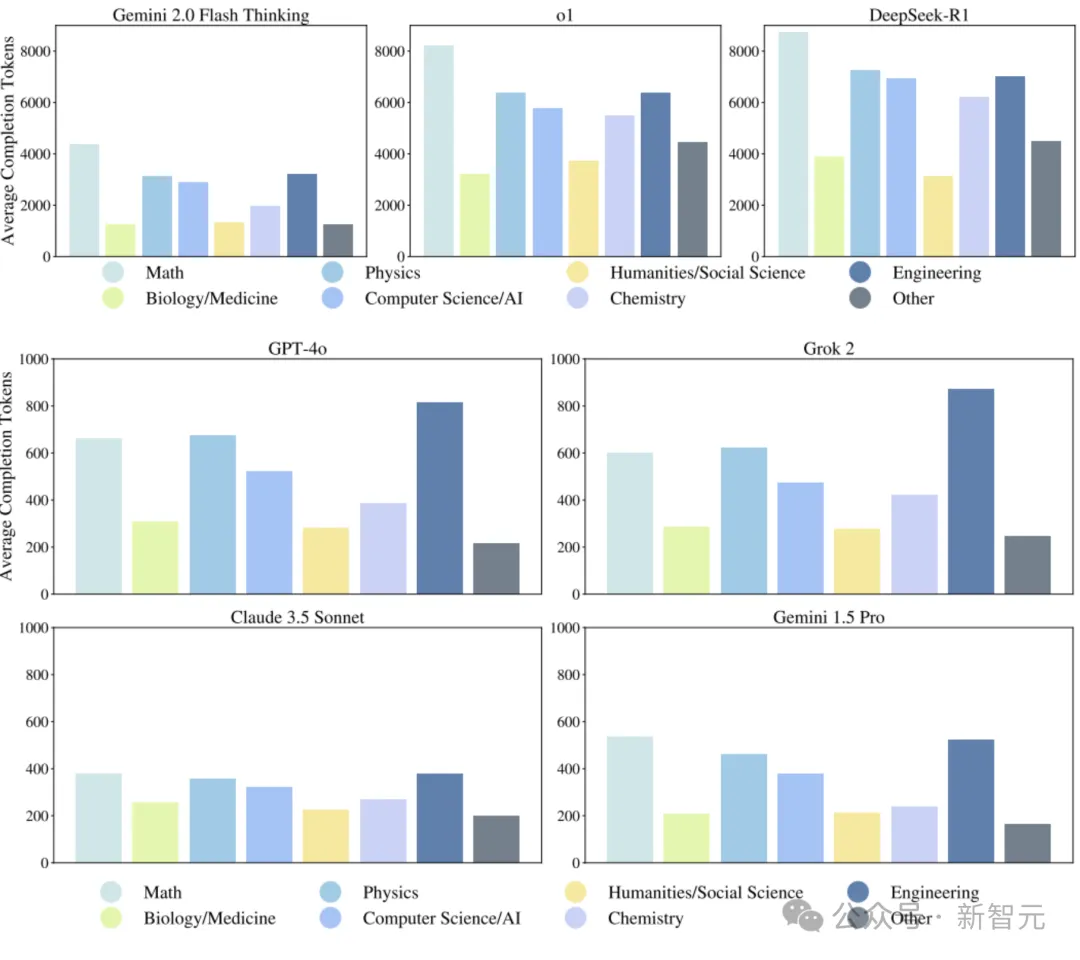

具有推理能力的模型,通常需要显著更多的推理时间和计算资源。

为了更清晰地了解这一点,对各模型生成的补全(completion)token数量进行了分析。

正如图5所示,推理模型Gemini 2.0 Flash Thinking、o1和DeepSeek-R1为了提升性能,需要生成的token数量远远超过非推理模型GPT-40、Grok 2、Claude 3.5 Sonnect以及Gemini 1.5 Pro(见图5)。

图5:不同模型的平均补全(completion)token数量

展望未来

在「人类最后一次考试」(Humanity's Last Exam,简称 HLE)中,目前的LLM表现仍然非常差。

但从发展历史来看,基准测试的饱和速度非常快——模型往往在短短的时间内,从接近0的准确率跃升至接近100%的表现。

鉴于AI发展的快速步伐,在2025年底前,模型有可能在HLE上超过50%的准确率。

AI实验室有新榜单可刷了,跃跃欲试

如果模型在HLE中获得高分,将表明模型在封闭式、可验证的问题以及前沿科学知识方面的专家级表现,但这并不意味着模型具备自主研究能力或「通用人工智能」(AGI)。

HLE测试的是结构化的学术问题,而非开放式研究或创造性问题解决能力,因此它更侧重于技术知识和推理能力的衡量。

作者在论文表示:「虽然HLE是给予模型的最后一场学术考试,但它远非AI评估的最后一个基准。」