译者 | 核子可乐

审校 | 重楼

Meta发布的BLT架构为大模型扩展找到又一条出路,也开启了用patch方法取代token的全新可能性。

开篇先提问:我们为什么非得把文本拆分成token?直接用原始字节怎么就不行?

要回答这个问题,我们得先从大语言模型的文本处理方式入手。它们需要用关于常用词块的规则将文本拆分成一个个token,而这个标记化过程也一直面临质疑。无论模型的其余部分在训练期间如何学习和适应,标记化阶段的初始规则都始终保持不变。因此一旦相关语言的训练数据不足、或者训练素材的文本格式比较特殊,大模型的处理能力就将大打折扣。

Meta提出的全新字节级标记化(BLT)架构则采用一种完全不同的方法。它不再预先定义token,而是查看文本的原始字节,并根据其可预测程度以动态方式对各字节进行分组。如果下一字节的可预测度极高(例如可补全为一个常用词),该架构就会将更多字节组合起来;而当下一字节不可预测(例如开始另一新句),则将字节划入多个较小的组。

使用固定推理预算进行训练时,模型的扩展趋势

传统基于token的模型(例如Llama 2和3)会根据推理预算对模型大小进行缩放。相比之下,BLT架构则能够在同等预算条件下,同时缩放模型大小与patch大小。patch大小为6和8的BLT模型在性能上迅速超越了Llama 2和3。而在使用更高推理预算时,较大的patch大小(例如8)则对应更佳性能和更高计算效率。上图中的垂直线所示,为计算效率与性能表现的关键交汇点。

这种动态方法具备以下三大核心优势:

第一,它在性能方面足以比肩Llama 3等基于标记器的顶尖模型,同时以较低的性能损失换取高达50%的推理次数削减。更高的计算效率,意味着该模型能够以更低资源需求处理文本中的可预测部分。

第二,它能够更好地处理极端情况。以需要字符级理解的任务为例,包括纠正拼写错误或处理较为凌乱的文本,BLT在这些任务上的表现明显优于基于token的模型,原因就在于它可以直接访问并操作单个字符。

第三,它引入了一种新的语言模型扩展方法。在基于标记器的传统模型中,扩展工作往往面临一定限制。而BLT架构允许同时增加模型大小和字节组的平均大小,同时保持计算预算不变。这就为构建更高效的大模型开辟了新的可能性。

BLT各核心组件

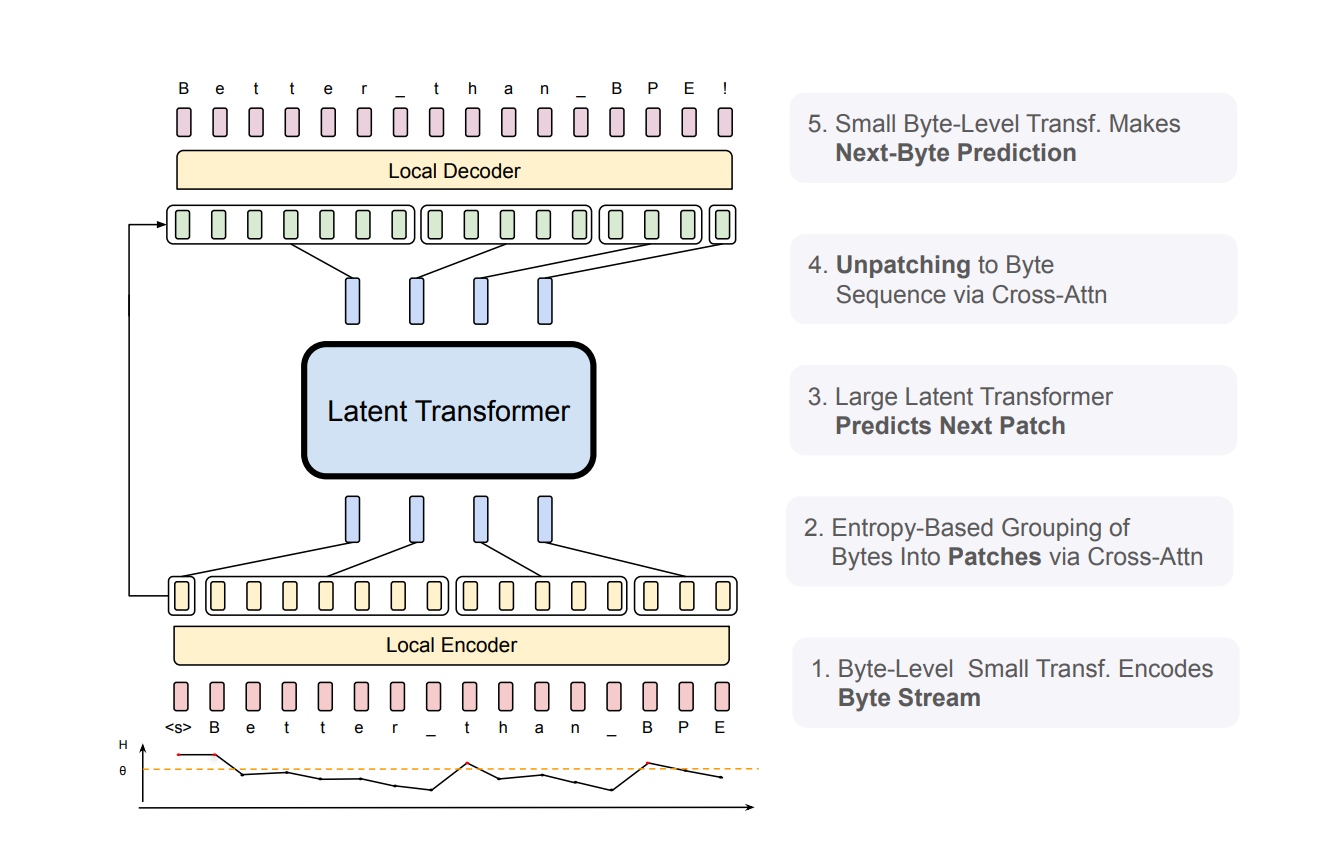

要了解BLT在实践中的工作原理,需从以下三大核心组件入手:

1. 轻量级本地编码器,负责处理原始字节并根据其可预测性进行分组。

2. 大型Transformer,负责处理各字节组(即「patch」)。

3. 轻量级本地解码器,负责将patch表示转换回字节。

BLT架构包含三大主要模块:轻量级本地编码器,负责将输入字节转换为patch形式;Latent Transformer,负责处理各patch;轻量级本地解码器,用于生成下一个字节patch。BLT使用字节n-gram嵌入与交叉注意力以增强Latent Transformer与字节级模块之间的信息流。与固定词汇标记化不同,BLT会将字节动态分组为patch,从而保持对字节级信息的访问能力。

架构中基于熵的分组机制特别值得一提。BLT使用小语言模型实现了令人惊喜的下一字节预测效果。一旦遇到很难预测的字节(例如新单词的开头),BLT会创建一个边界并开启新的ptach。这样它就能将更多计算资源用于处理文中最具挑战性的部分,同时高效处理难度较低的部分。

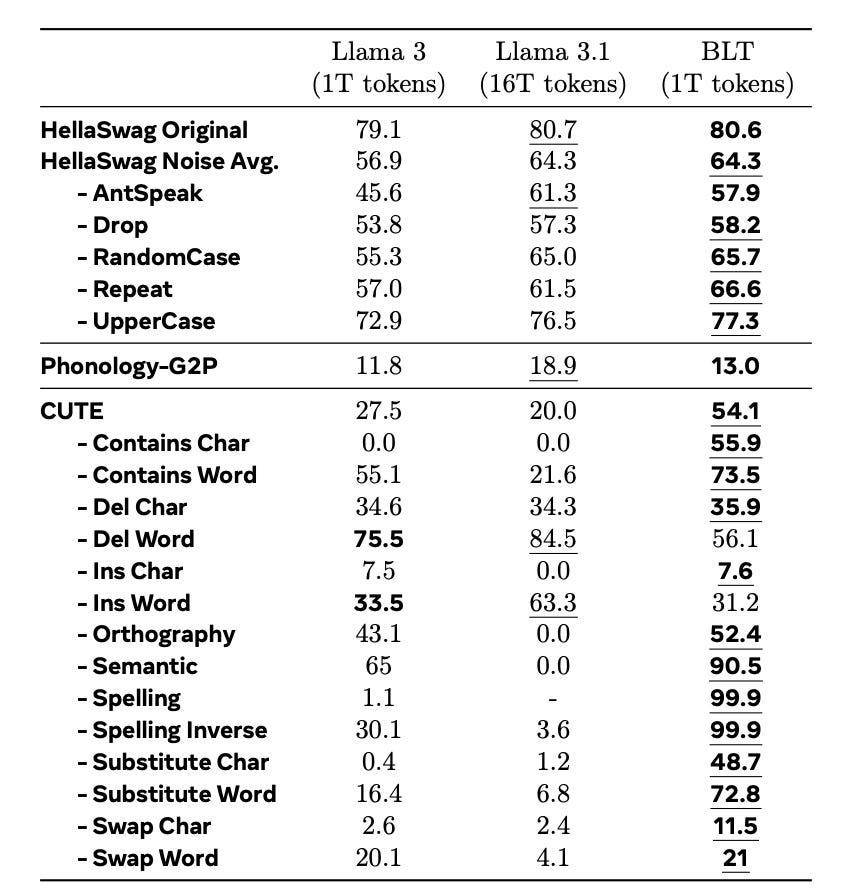

以下结果令人眼前一亮。在标准基准测试中,BLT的性能已经追平甚至超越了Llama 3,而且在需要字符级理解的任务方面尤其出彩。以测试字符操作的CUTE基准测试为例,BLT的表现比基于token的模型高出25分以上——相应训练数据则仅相当于最新Llama模型的十六分之一。

8B BLT模型与8B BPE Llama 3的比对结果。二者均使用1T token训练而成,测试内容为针对噪声及语言结构的稳健性任务。单项最佳结果以粗体标出,整体最佳结果(包括Llama 3.1)则以下划线标出。很明显,BLT在多项任务上的表现均优于Llama 3,甚至超越Llama 3.1。这表明字节级感知具备暴力堆砌训练数据所难以实现的优势。

由此看来,未来的语言模型可能不再需要僵化的标记化机制。通过以动态方式直接处理字节,我们或将构建起效率更高、更善于处理人类语言复杂要素的新一代大模型。

原文标题:Bye Tokens, Hello Patches,作者:Mike Young