本文经AIGC Studio公众号授权转载,转载请联系出处。

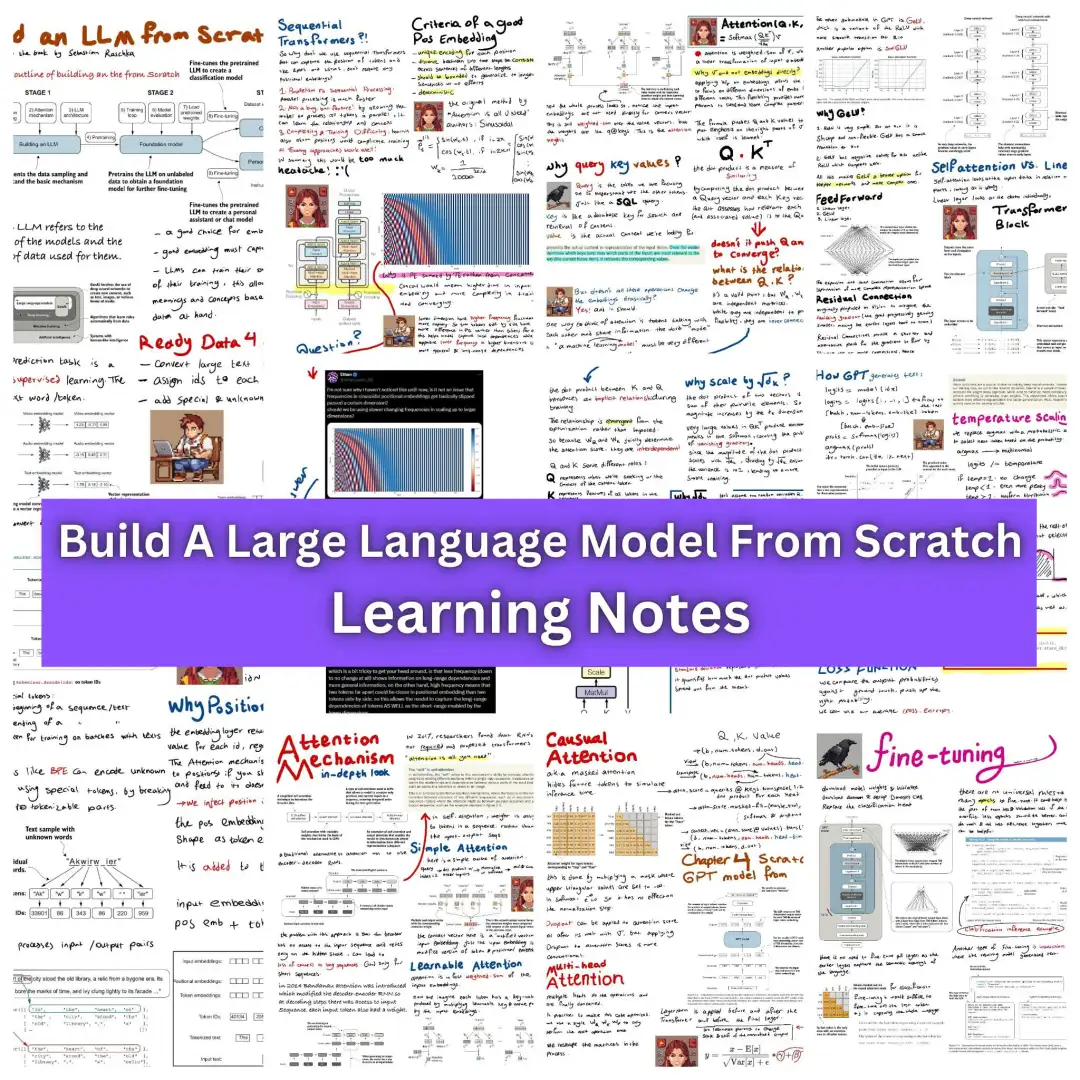

今天给大家推荐一份GitHub上很火的机器学习学习笔记《从零构建大型语言模型》,目前已经收获1.4K stars,,这份笔记完美展示了从零构建LLM的技术路线图,既有理论深度,又包含实践要点。每个核心概念都配有清晰的示意图,便于理解和实践。建议先掌握基础概念,再逐步深入理解高级特性,这样能形成更系统的知识体系。

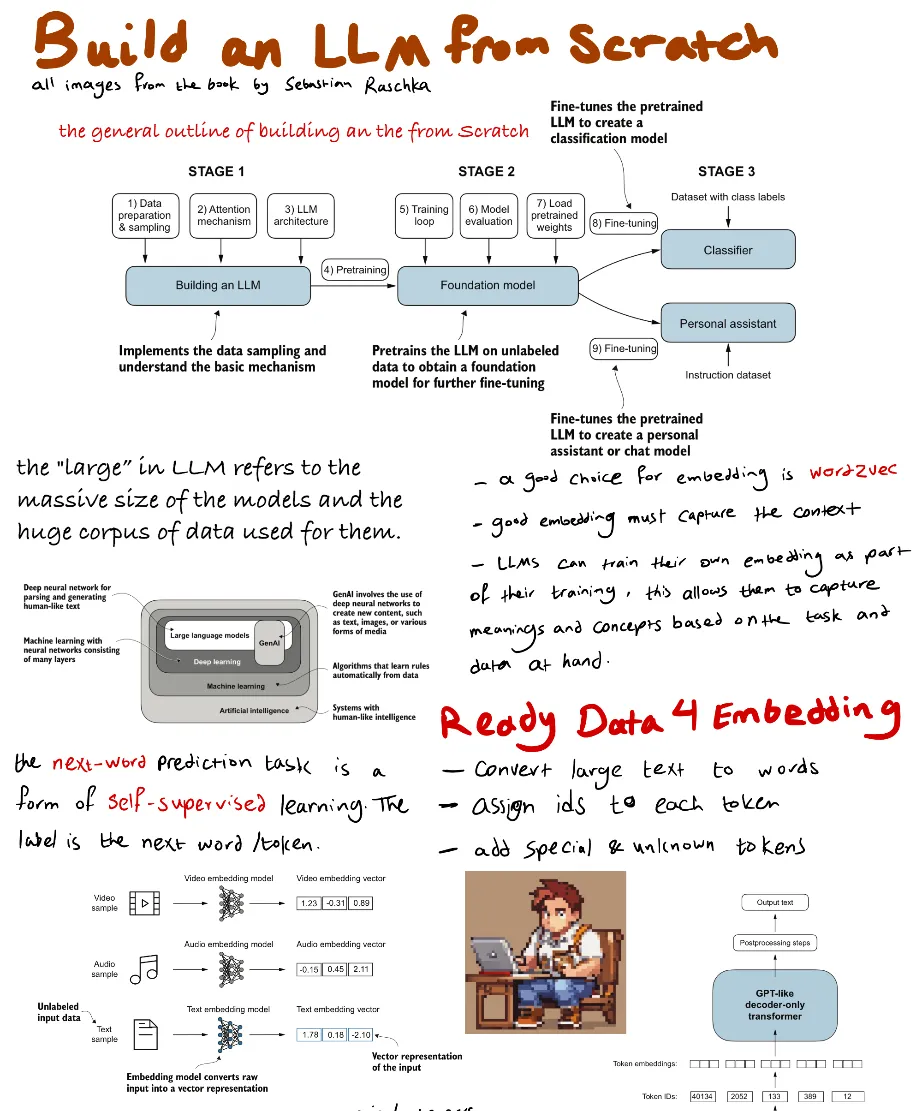

第一部分:基础架构

- LLM的核心是对模型结构和训练数据的深入理解

- 从数据采样和预处理开始,逐步构建基础模型

- 需要特别关注词元化(Tokenization)处理,这是模型理解文本的基础

第二部分:关键技术点

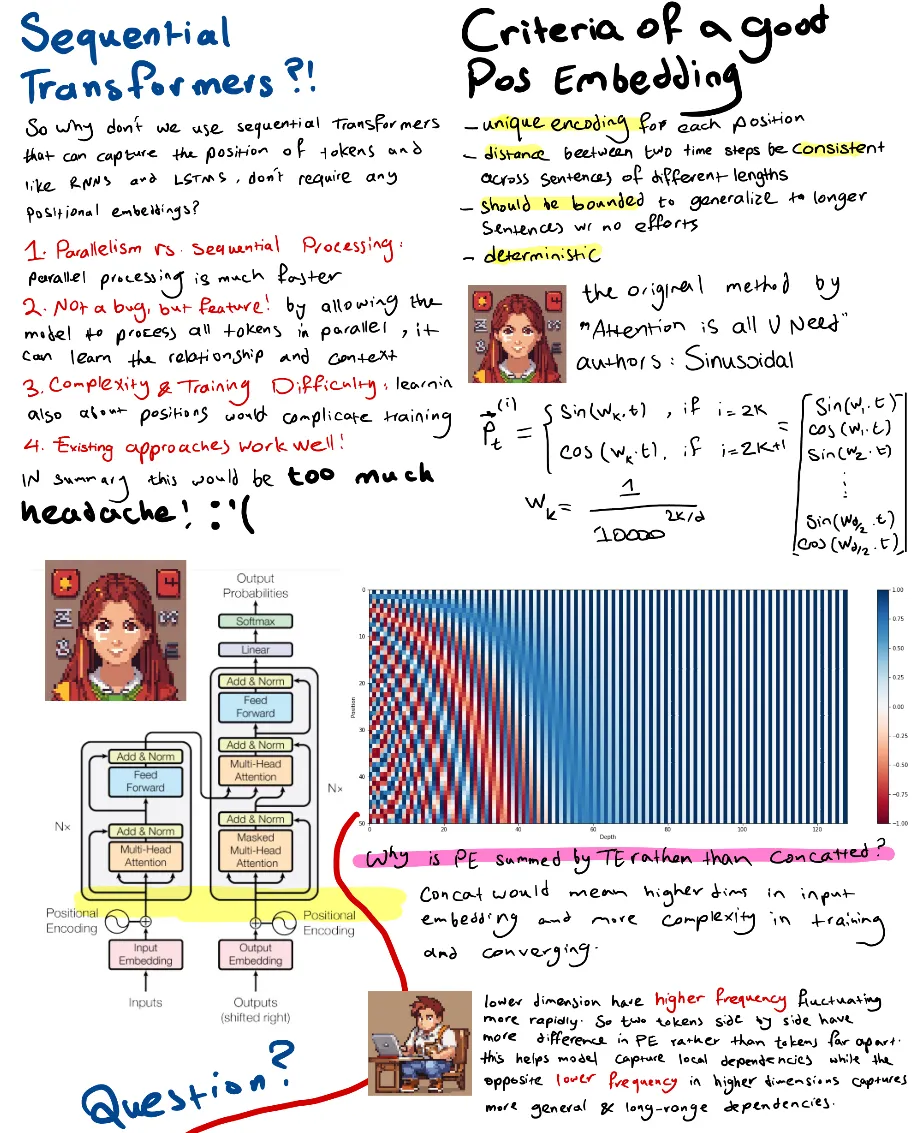

- 位置编码(Positional Encoding)

- 帮助模型理解文本序列中的位置信息

- 通过数学编码方式赋予每个标记相对位置

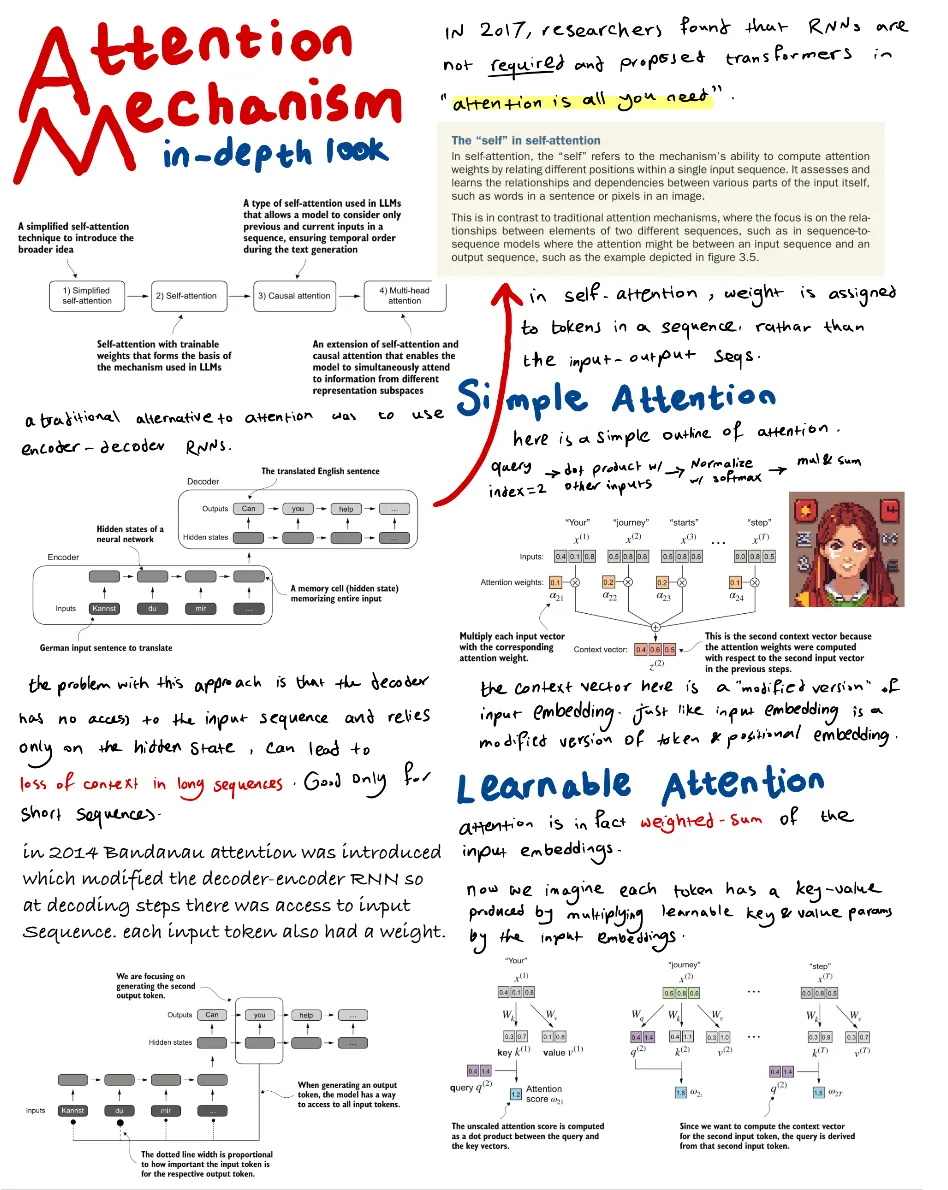

- 注意力机制(Attention Mechanism)

- 包含自注意力和因果注意力两种形式

- Q、K、V三个关键参数的协同作用

- 进行尺度缩放以稳定训练

- Transformer结构

- 编码器-解码器架构设计

- 多头注意力机制的实现

- 前馈网络和归一化层的配置

第三部分:优化策略

- 微调(Fine-tuning)技术要点

- 损失函数的选择与调整

- 温度系数(Temperature)对输出的影响

学习链接

- GitHub:github.com/hesamsheikh/ml-retreat/blob/main/assets/LLM-from-scratch-notes.pdf