引言

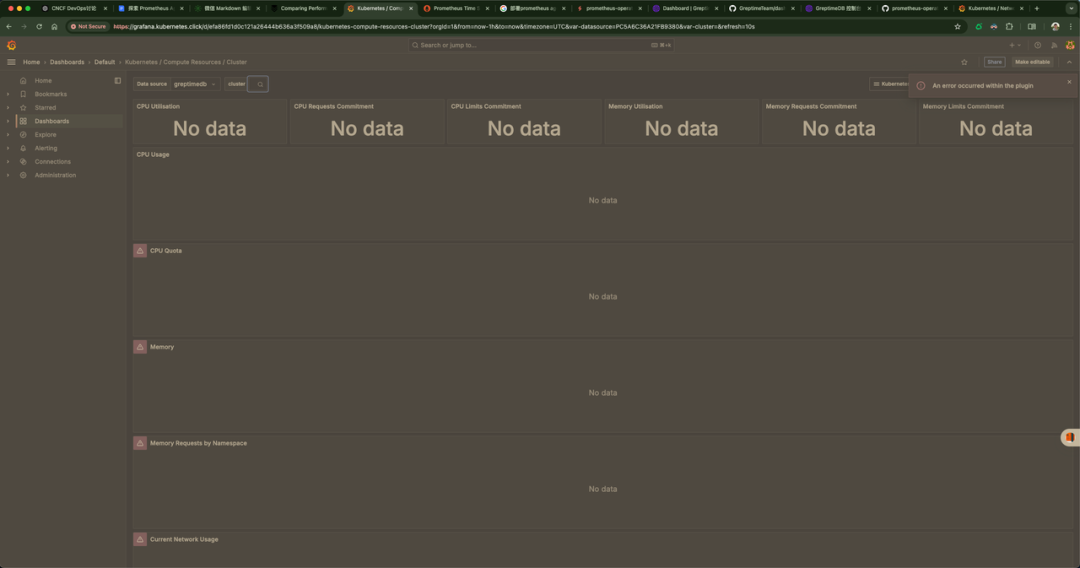

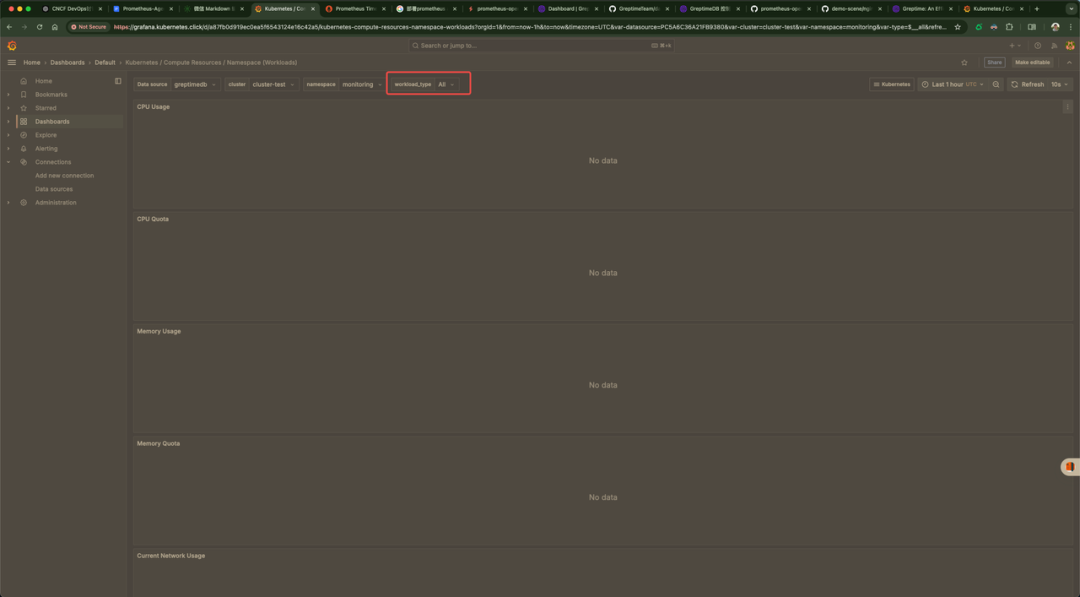

我们的上一篇文章中讲解到了 Prometheus-Agent + GreptimeDB,当时最大的问题是使用 GreptimeDB 作为 Grafana 的数据源,然后去看 Dashboard 有很多的都没有数据,如下图所示

图片

图片

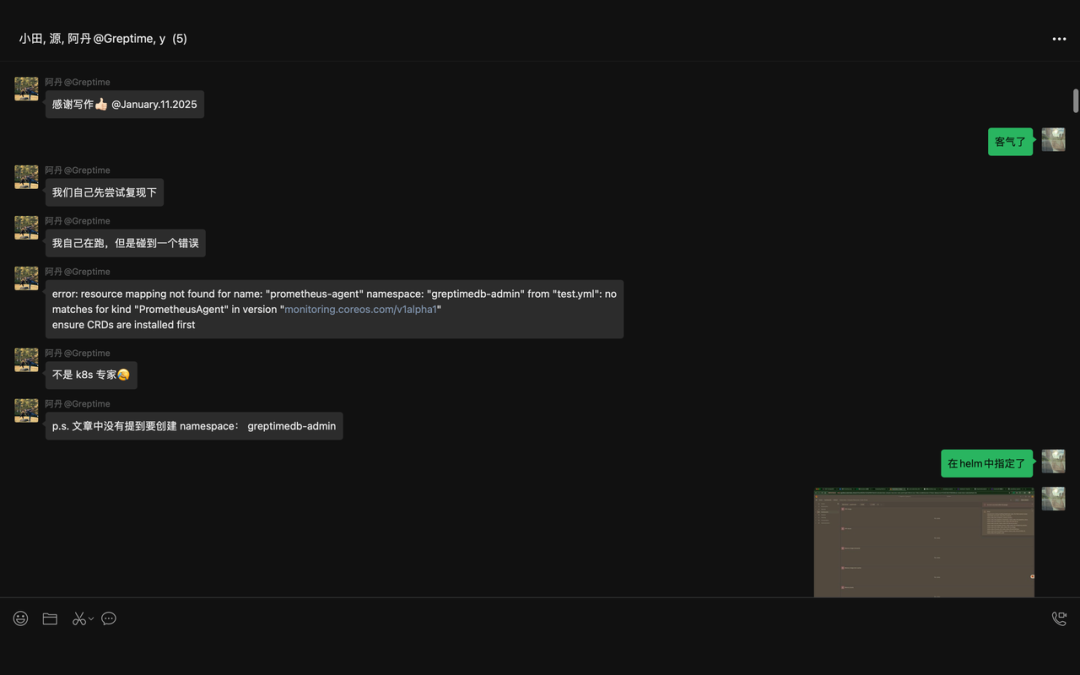

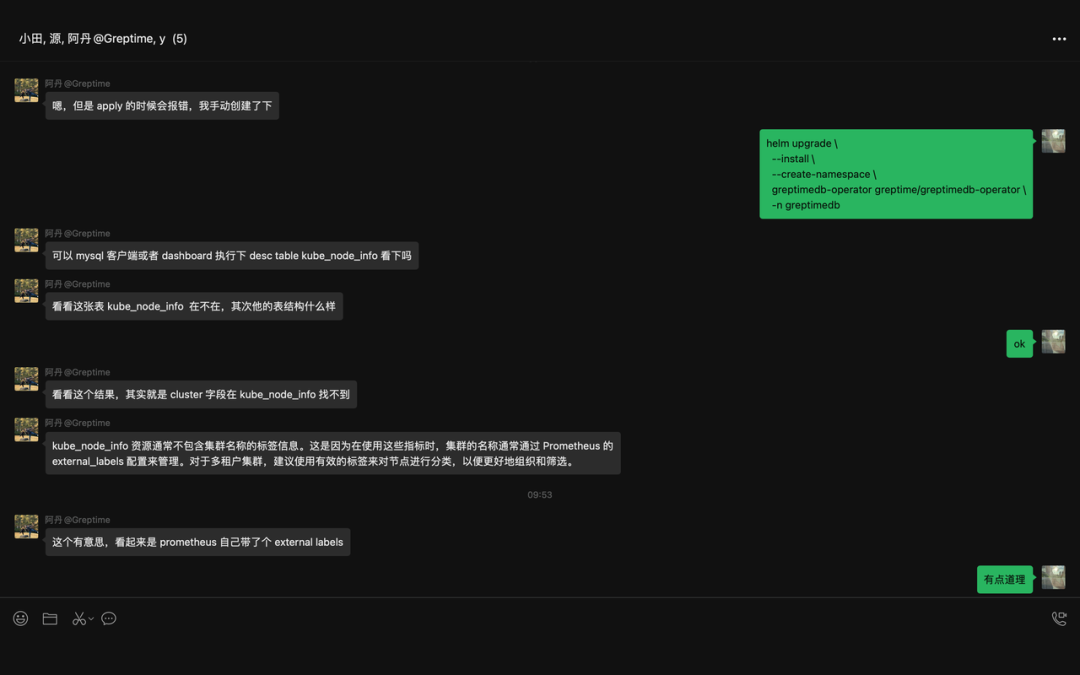

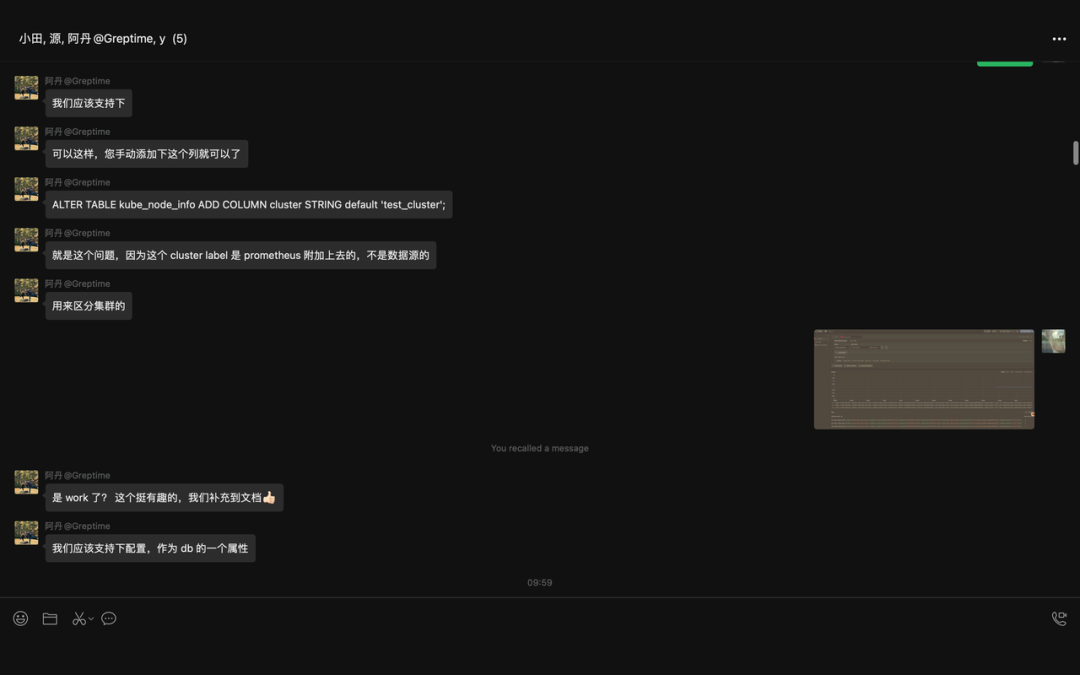

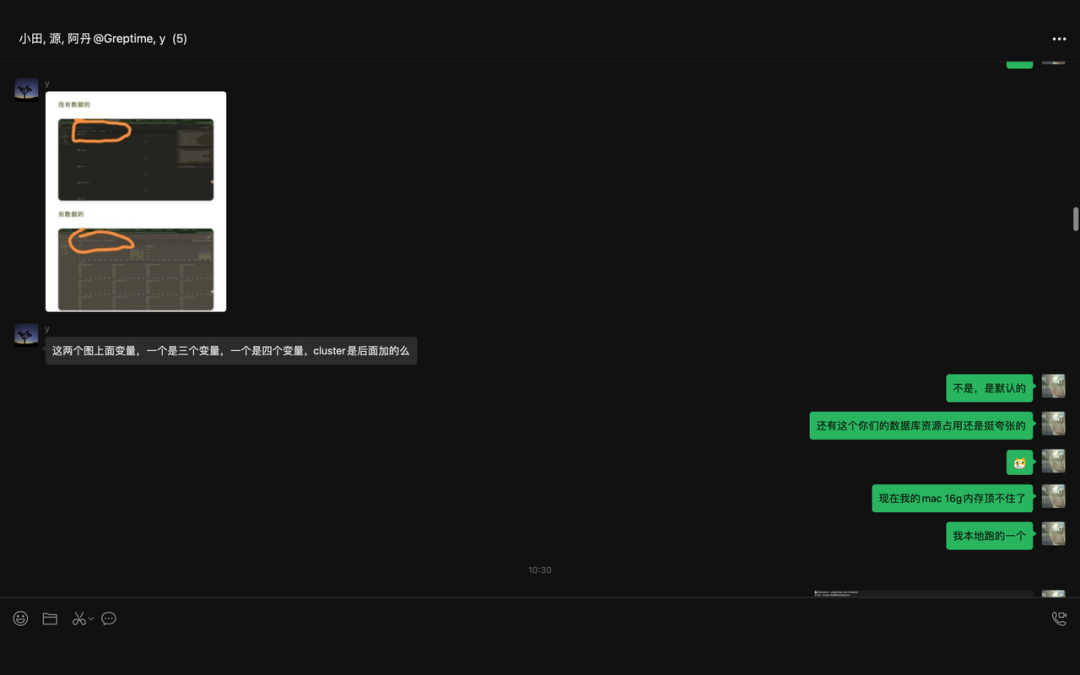

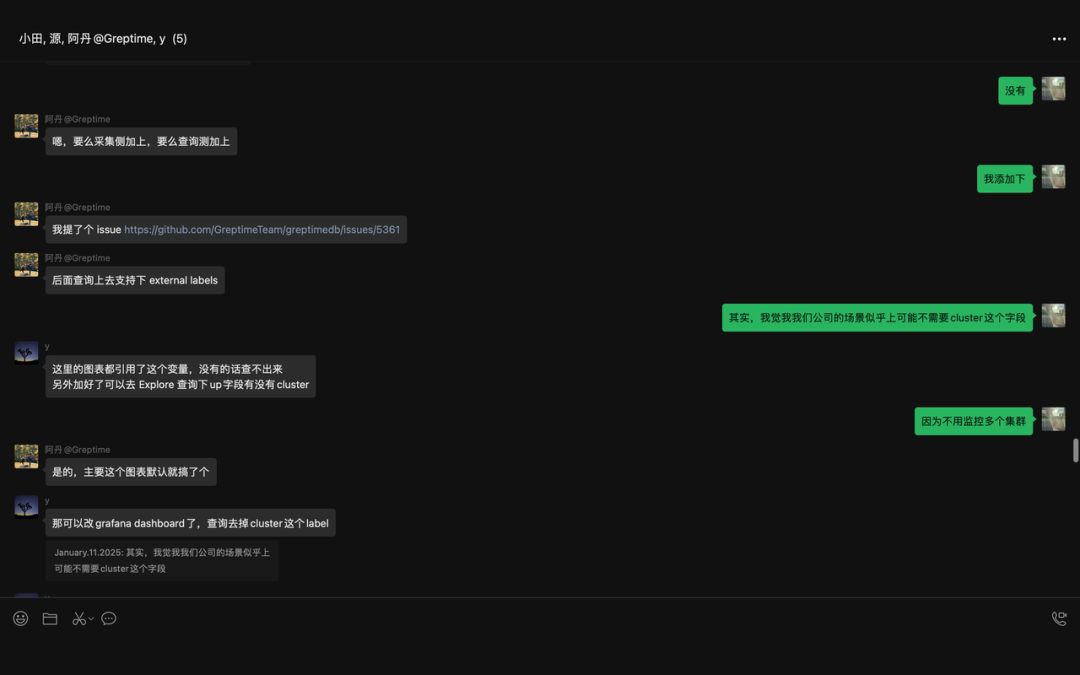

当时文章一经发出,就收到了来自 GreptimeDB[1] 官方人员的注意,随后,我们经过进一步的交流,如下图所示

图片

图片

图片

图片

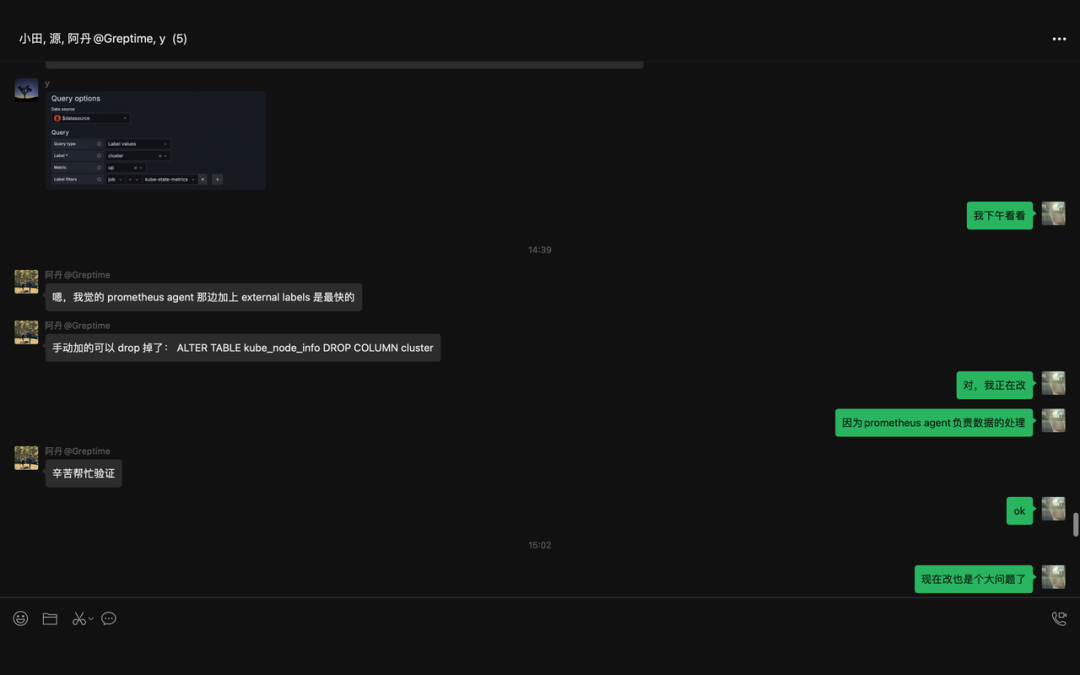

随后,我们进入群聊

图片

图片

图片

图片

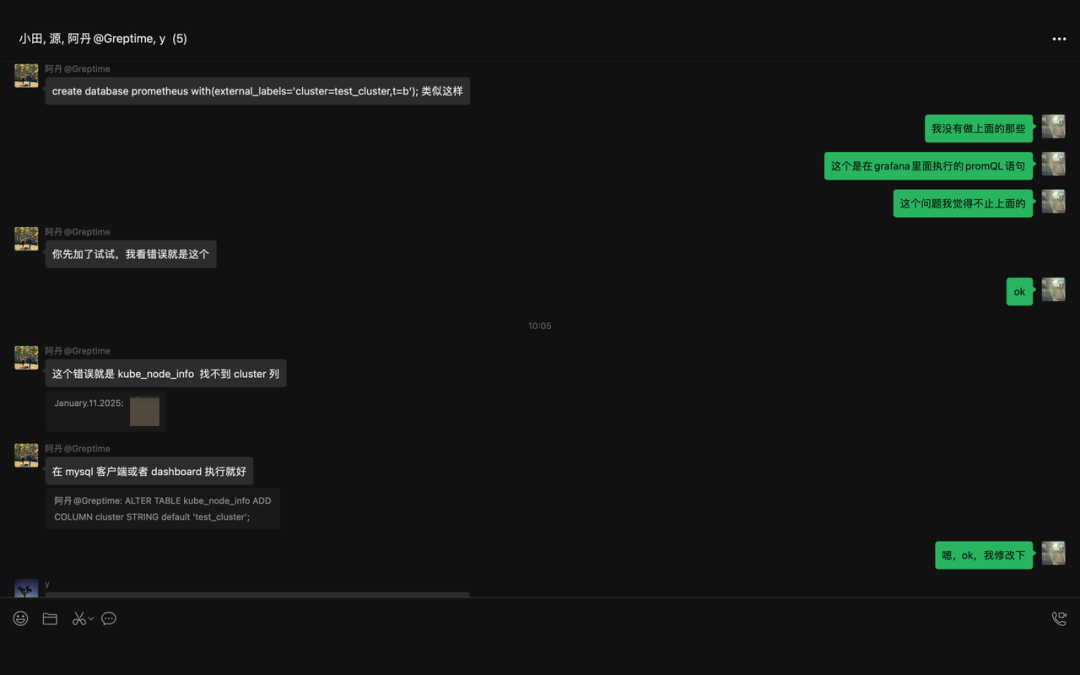

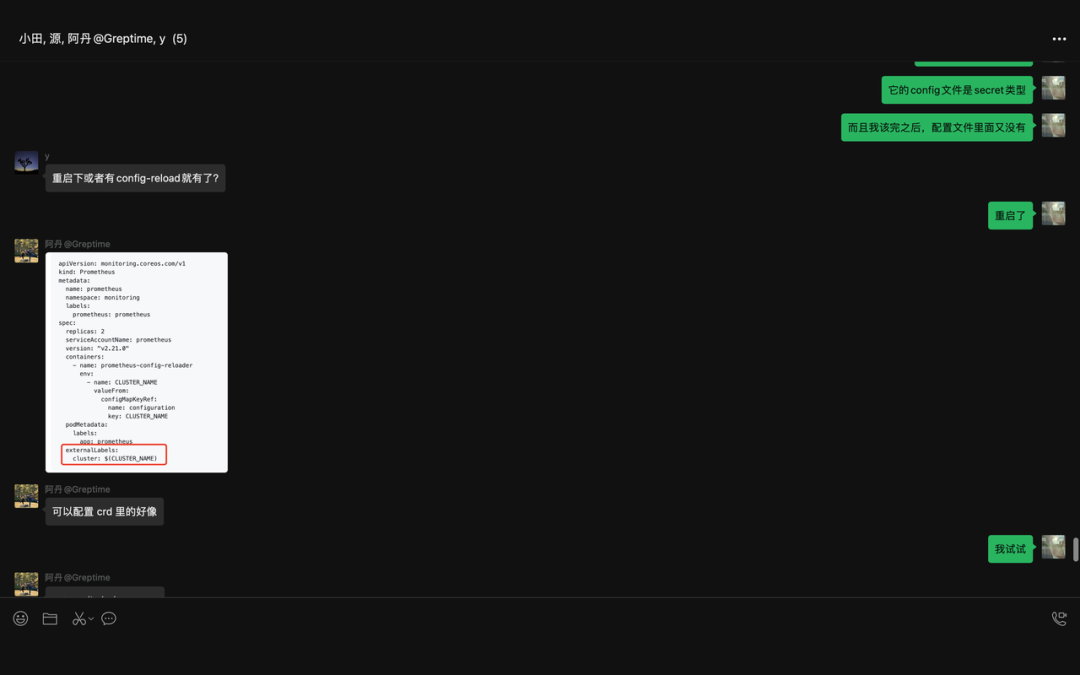

以下的这部分算是 get 到了终点,但是当时并没有立刻采取行动

图片

图片

图片

图片

图片

图片

图片

图片

图片

图片

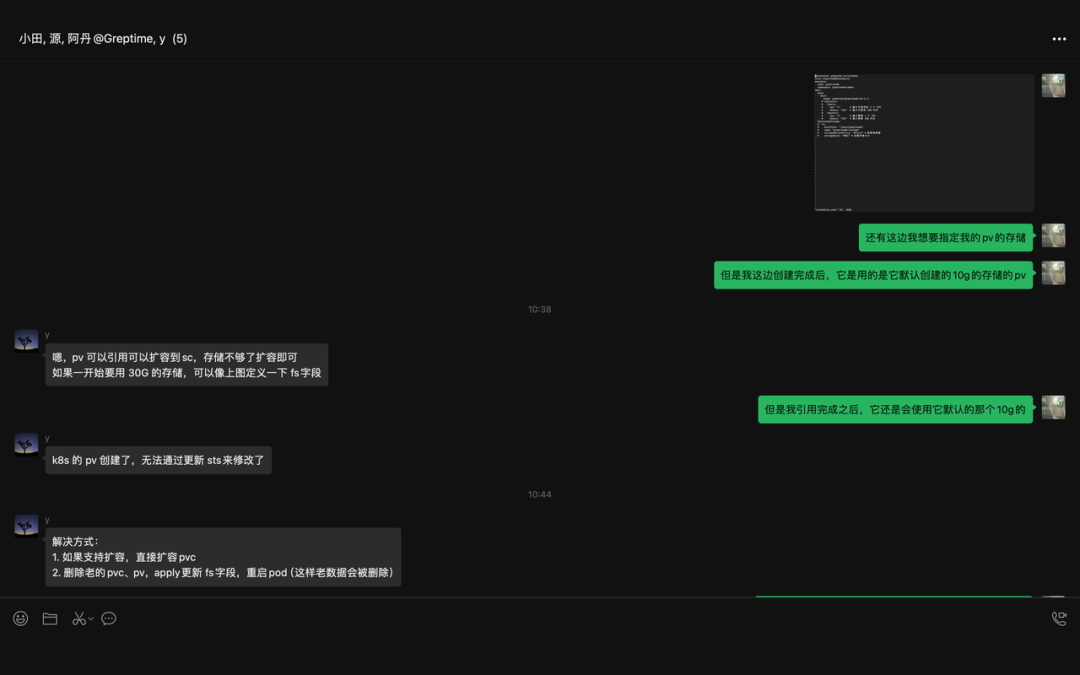

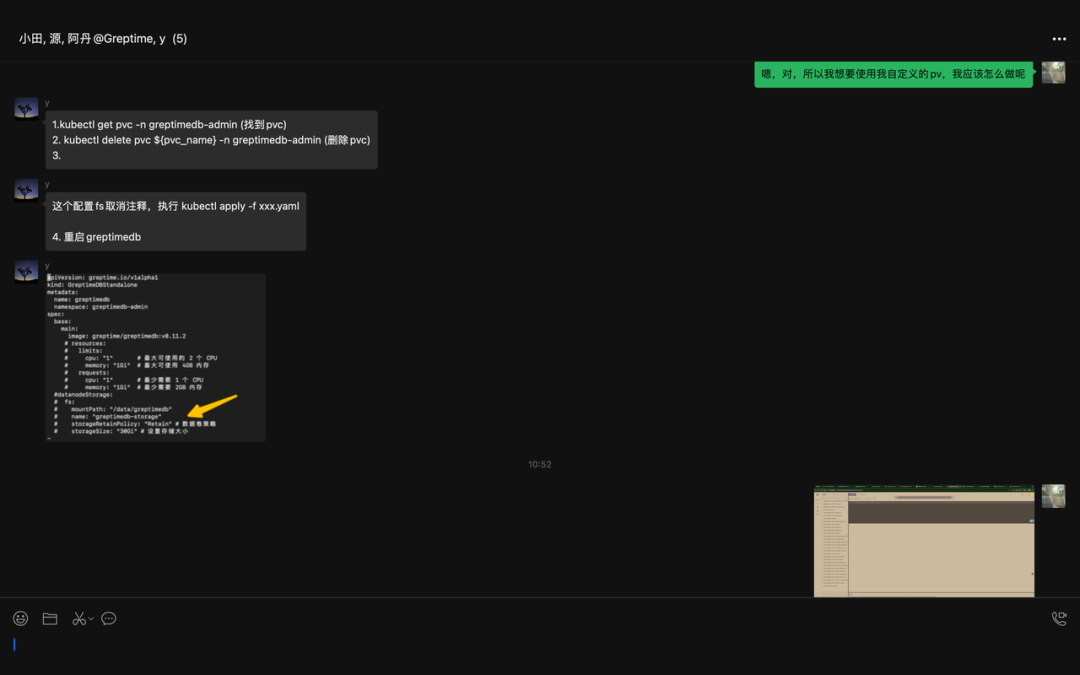

到了后面,我想着怎么给 GreptimeDB 弄一个自定义的存储,因为它的这个 控制器 创建完成后,就会自动创建 PV 和 PVC 然后挂载,10G 的存储,但是我想要自定义,如下 YAML。

然后我们部署看看;

可以看到是 30G,并没有我们上面说的那个问题,原来是我搞错了,我们下面这个关于存储的问题就解决了。

图片

图片

图片

图片

这边当时也挺搞笑的,哈哈!

图片

图片

图片

图片

图片

图片

图片

图片

图片

图片

图片

图片

图片

图片

图片

图片

图片

图片

图片

图片

图片

图片

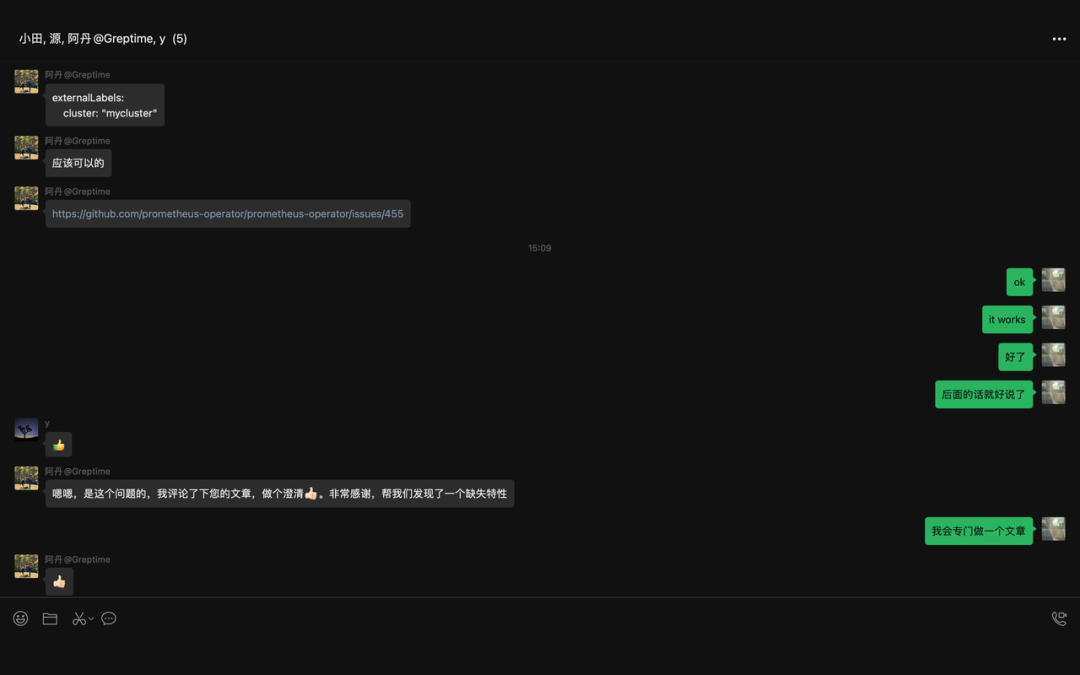

我们这里添加下:

这里添加就 work 了,然后如果还有更多的,就继续添加就可以了。

图片

图片

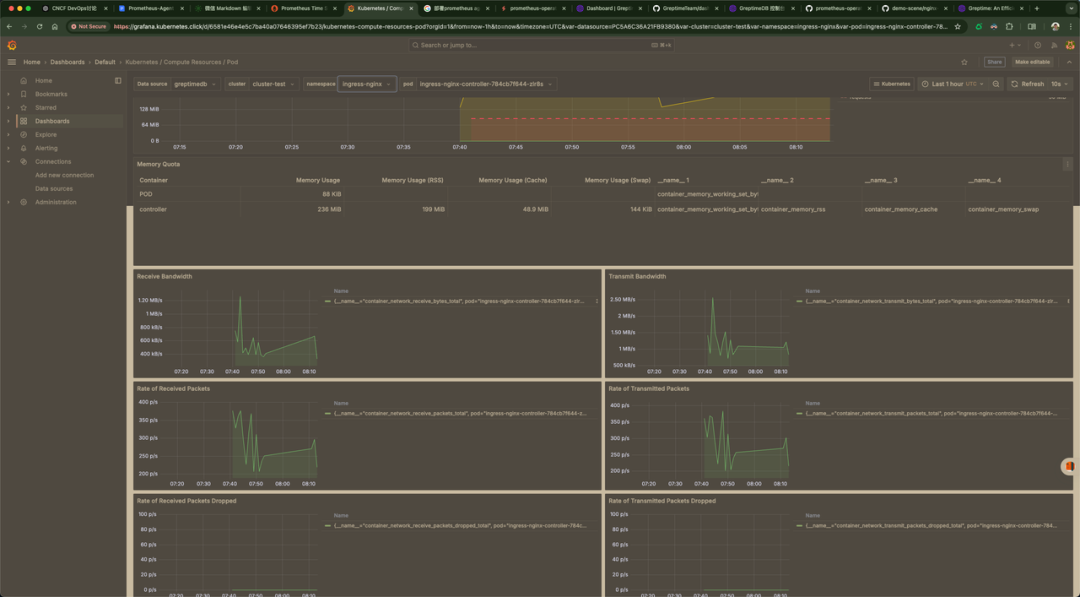

可以看到,终于有数据了。

图片

图片

但是这又有一个问题,其实还有很多像这样类似的问题,大致解决,和上面的是一样的思路。

图片

图片

我们添加下就可以了。

弄了半天,还是不行,在此希望有大佬出主意,非常感谢,作为回报,我会把你记在心里!

可以看下我们最终的 YAML 文件;

结语

这个问题,还可以,不算是特别过分吧,还是跌亏有 GreptimeDB 的相关人员,不然,这个问题怎么解决?

那么我们的 Prometheus-Agent + GreptimeDB 算是不是很圆满地结束了,但是后面大概还会又些小问题,不过都是小事了。

引用链接

[1] GreptimeDB: https://greptime.com/