众多文档,如技术手册、历史档案、学术论文和法律文件,往往以扫描件或图片形式存在。这对检索增强生成(Retrieval-Augmented Generation, RAG)、内容提取以及文档解读等后续处理工作构成了极大的挑战。

文档解析技术应运而生,它能够识别并提取文档中的多种元素,如文字、公式、表格和图片,同时保持它们之间的结构联系。提取后的内容可转换成 Markdown、HTML 或 JSON 等结构化格式,从而实现与下游任务的无缝集成。

1.Overview

![图 1:文档解析方法概述。来源:Document Parsing Unveiled[1] 图 1:文档解析方法概述。来源:Document Parsing Unveiled[1]](https://s5.51cto.com/oss/202501/16/f290cea669d0d3422b914001fc872191e809e4.webp) 图 1:文档解析方法概述。来源:Document Parsing Unveiled[1]

图 1:文档解析方法概述。来源:Document Parsing Unveiled[1]

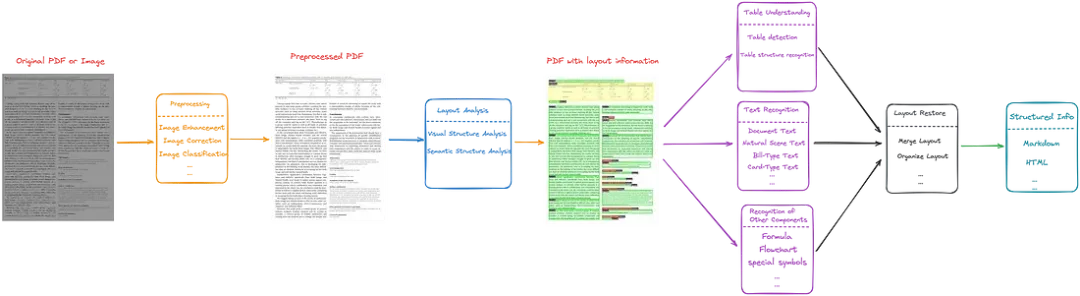

文档解析技术主要分为两大类:模块化 pipeline 系统和基于大型视觉-语言模型的端到端处理方法。

![图 2:两种文档解析方法。来源:Document Parsing Unveiled[1] 图 2:两种文档解析方法。来源:Document Parsing Unveiled[1]](https://s7.51cto.com/oss/202501/16/272345b3156cfe71fd58042bd538d1c1aaa32e.webp) 图 2:两种文档解析方法。来源:Document Parsing Unveiled[1]

图 2:两种文档解析方法。来源:Document Parsing Unveiled[1]

模块化 pipeline 系统[2]将文档解析任务拆分为多个独立阶段,每个阶段针对特定的功能和任务。这些模块通常包括:

- 布局分析:它通过识别文本块、标题、图片、表格和数学表达式等元素,以及它们在文档中的空间布局和阅读顺序,来检测文档布局结构。

- 内容提取:这一步骤涉及多个关键流程,例如文本提取、数学公式提取、表格数据提取和结构提取,以及图表识别。

- 关系整合:在保持元素间空间和语义关系的基础上,将提取的文本、表格和图表等元素进行整合。

而端到端视觉-语言模型(VLMs)则致力于通过多模态大模型统一处理任务,从而简化文档解析流程。

图 3:基于模块化 pipeline 方法的概览图,此图由作者提供

图 3:基于模块化 pipeline 方法的概览图,此图由作者提供

图 4:端到端视觉-语言模型(VLMs)的概览图,此图由作者提供

图 4:端到端视觉-语言模型(VLMs)的概览图,此图由作者提供

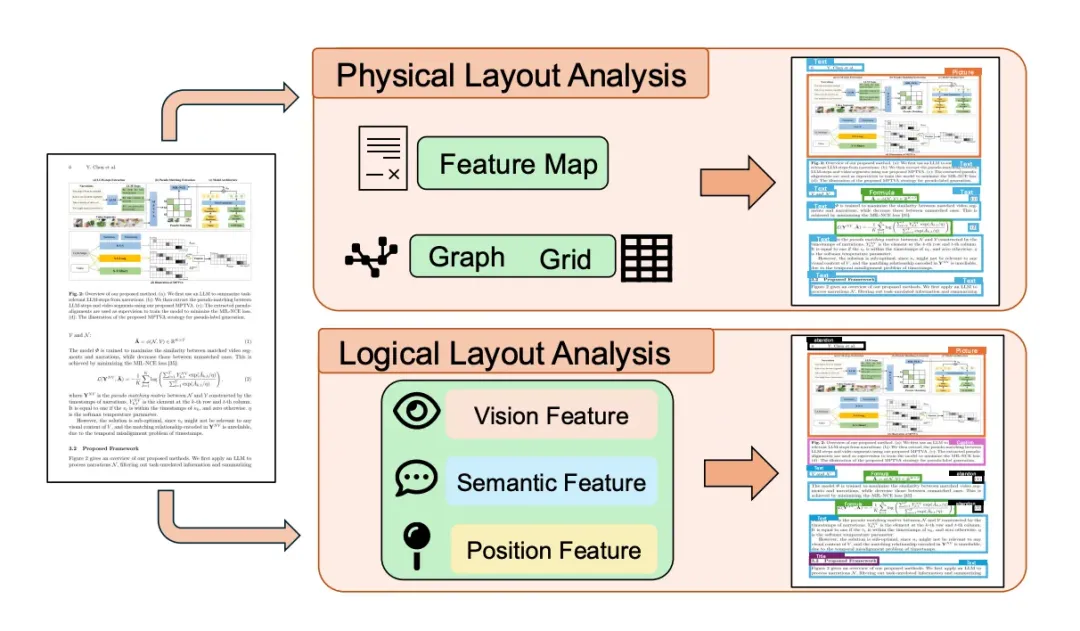

2.模块化 pipeline 系统:布局分析

布局分析(Layout analysis)是识别文档结构的关键步骤,它能够精确地定位文本块、图片和表格,从而实现信息的准确提取。

图 5:文档布局分析 (DLA) 算法概览。来源:Document Parsing Unveiled

图 5:文档布局分析 (DLA) 算法概览。来源:Document Parsing Unveiled

布局分析采用的方法包括使用卷积神经网络(CNNs)来捕捉视觉特征,以及 Transformers 和基于图的网络来处理元素间的空间与语义关系。

通过引入多模态模型,如 LayoutLM,布局分析得以同时结合文档的布局和文本信息,进一步提升了文档解析的准确性。

用于布局分析的主流数据集如图 6 所示。

![图 6:DLA 常用数据集摘要。来源:Document Parsing Unveiled[1] 图 6:DLA 常用数据集摘要。来源:Document Parsing Unveiled[1]](https://s9.51cto.com/oss/202501/16/339549027b222f022ee2516b1bb089fb6d2fb6.webp) 图 6:DLA 常用数据集摘要。来源:Document Parsing Unveiled[1]

图 6:DLA 常用数据集摘要。来源:Document Parsing Unveiled[1]

这些数据集分为合成数据集、真实数据集和混合数据集,覆盖了从历史文献、学术论文到收据等多种文档类型。

早期数据集,例如 IMPACT 和 GW20,主要关注历史文件,而像 PubLayNet 这样的新数据集则更注重复杂的印刷布局。ICDAR 等竞赛提供的带有高质量标注的标准化数据集,对于模型评估和基准测试至关重要。

3.模块化 pipeline 系统:光学字符识别技术(OCR)

光学字符识别(Optical Character Recognition, OCR)技术是将文档图像转换为机器可读文本的核心,它为多种后续处理任务提供了基础支持。

![图 7:OCR 算法概览。来源:Document Parsing Unveiled[1] 图 7:OCR 算法概览。来源:Document Parsing Unveiled[1]](https://s3.51cto.com/oss/202501/16/798f10247dc2d80b36134643d202af86576035.webp) 图 7:OCR 算法概览。来源:Document Parsing Unveiled[1]

图 7:OCR 算法概览。来源:Document Parsing Unveiled[1]

文本检测是首个步骤,采用了包括 YOLO 等单阶段回归模型和 Faster R-CNN 等两阶段提议方法来定位文本区域。

紧随其后的文本识别步骤,则通过 CRNN 等基于 CTC loss 的模型和基于 Transformer 的序列到序列(sequence-to-sequence)方法,将识别出的文本转换为结构化格式。

最新的研究进展通过整合语义信息,显著提高了对复杂和不规则文本的识别精度。

端到端的文本定位模型将检测与识别合二为一,通过共享特征表示提升了操作的效率和准确性。

OCR 使用的主流数据集如图 8 所示。

![图 8:OCR 常用数据集摘要。来源:Document Parsing Unveiled[1] 图 8:OCR 常用数据集摘要。来源:Document Parsing Unveiled[1]](https://s7.51cto.com/oss/202501/16/f4506054494860c0639499675c7ef582351fe0.webp) 图 8:OCR 常用数据集摘要。来源:Document Parsing Unveiled[1]

图 8:OCR 常用数据集摘要。来源:Document Parsing Unveiled[1]

这些 OCR 数据集既包含印刷文本也包含自然场景文本,其中 ICDAR 竞赛提供的数据集(如 ICDAR2013 和 ICDAR2015 )在自然场景文本检测评估中尤为突出。专门针对复杂场景下不规则文本的数据集,如 Street View Text Perspective 和 MSRA-TD500,也是研究的重要资源。SynthText 和 SynthAdd 等合成数据集则为文本检测和识别提供了大量训练数据。端到端 OCR 任务得益于 ICDAR2015 和 ICDAR2019 等带有区域和文本注释的数据集的支持。

4.模块化 pipeline 系统:数学表达式的检测和识别

数学表达式的识别与检测旨在识别和解释文档中的数学符号,包括独立表达式和内联表达式。

![图 9:数学表达式识别与检测的全景图。来源:Document Parsing Unveiled[1] 图 9:数学表达式识别与检测的全景图。来源:Document Parsing Unveiled[1]](https://s7.51cto.com/oss/202501/16/61b88fb30d63cd7ee68140a1373d99be63825f.webp) 图 9:数学表达式识别与检测的全景图。来源:Document Parsing Unveiled[1]

图 9:数学表达式识别与检测的全景图。来源:Document Parsing Unveiled[1]

4.1 检测过程

这一过程着重于在文档中搜寻并确定数学表达式的位置,使其与周围的文字区分开来。

最初,这一领域依赖于基于规则的方法,但现在,深度学习技术的应用,如使用边界框和图像分割,极大地提升了检测的精确度和速度。卷积神经网络(CNN)最初为这一领域带来了定位能力,而 DS-YOLOv5 和 R-CNN 等新算法更是将这一能力推向了新的高度。

4.2 识别过程

而识别的任务则是解读那些被检测到的数学表达式的含义,将其中的符号和结构转换成 LaTeX 或 MathML 等编码格式。

编码器-解码器模型负责将数学图像转换成 LaTeX 等格式,这通常涉及到使用 CNN 来提取图像的局部特征,以及使用 Transformer 来处理复杂的依赖关系。

在数学表达式识别(MER)领域,使用递归神经网络(RNNs)和 Transformer 模型来进行序列处理,这与 OCR 领域类似。带有注意力机制的 RNN 擅长处理嵌套和层次化的结构,而 GRU 等先进设计则提升了处理效率。树形结构和 Transformer 解码器解决了梯度消失和计算成本高等问题,因此它们在处理复杂公式时更为得心应手。

4.3 数据集

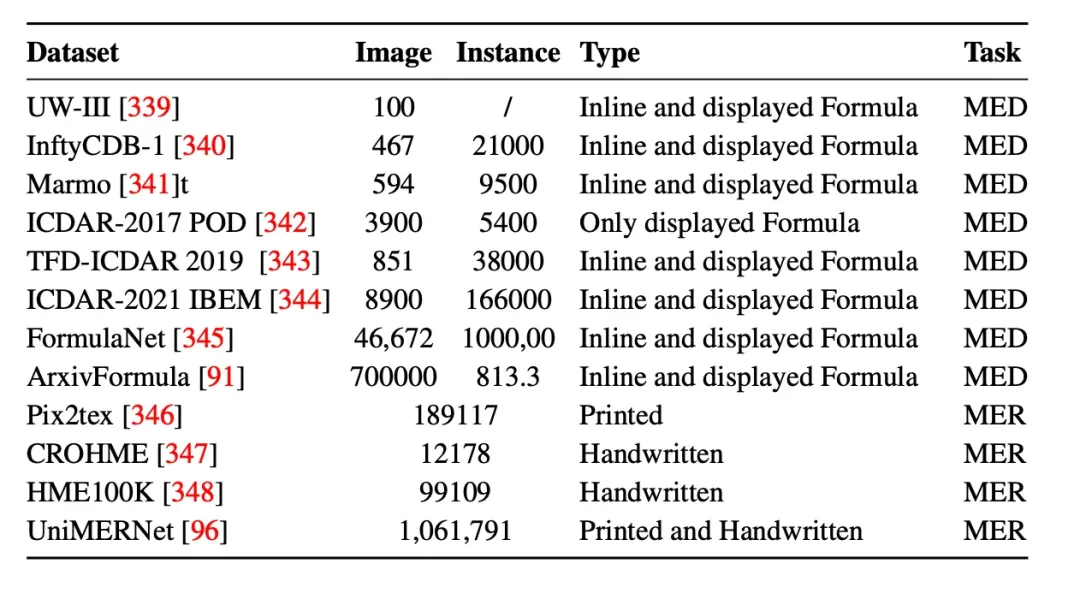

数学表达检测(MED)和识别(MER)数据集对于提高印刷和手写数学表达式的识别准确率至关重要。

图 10:MED 和 MER 常用数据集摘要。来源:Document Parsing Unveile

图 10:MED 和 MER 常用数据集摘要。来源:Document Parsing Unveile

重要数据集,例如 UW-III、InftyCDB-1 和 Marmot,支持各种文档类型的检测、提取和定位等任务。ICDAR 系列数据集对此领域贡献颇大,尤其是 ICDAR-2017 POD 和 ICDAR-2021 IBEM,它们针对的是更为复杂的场景。同时,FormulaNet 和 ArxivFormula 等大型数据集则专注于从图片中提取数学公式。

尽管现有资源丰富,但为了更好地支持多格式识别和提高模型的稳健性,数据集的进一步开发仍然十分必要。

5.模块化 pipeline 系统:图表处理

常见的图表类型包括折线图、条形图、面积图、饼图和散点图,每种图表都在传达关键信息方面发挥着重要作用。

图表处理任务包括图表分类、元素识别和数据提取等,目的是将图表中的视觉信息转化为表格或 JSON 等易于分析和访问的结构化数据格式。

![图 13:文档中与图表相关的任务概览。来源:Document Parsing Unveiled[1] 图 13:文档中与图表相关的任务概览。来源:Document Parsing Unveiled[1]](https://s8.51cto.com/oss/202501/16/861801b41d23a32329f2732aa68ba9f4110462.webp) 图 13:文档中与图表相关的任务概览。来源:Document Parsing Unveiled[1]

图 13:文档中与图表相关的任务概览。来源:Document Parsing Unveiled[1]

图表分类是区分不同图表类型(如条形图、折线图、饼图等)的关键,利用 CNN 和Vision Transformer技术,Swin-Chart 等模型在处理复杂和相似的图表方面表现卓越。

图表检测和元素识别则需要布局检测算法来定位图表区域、匹配标题和分割复合图表,这通常需要借助 YOLO 和 Faster R-CNN 等目标检测模型实现。

图表感知技术(chart perception)能够从图表中提取数据结构和文本信息。ChartDETR 等先进方法结合了 CNN 和 Transformer,实现了端到端的数据提取,而 FR-DETR 等模型则优化了流程图和树状图的结构提取,但处理复杂连接线的挑战依然存在。

![图 14:图表相关任务常用数据集汇总。来源:Document Parsing Unveiled[1] 图 14:图表相关任务常用数据集汇总。来源:Document Parsing Unveiled[1]](https://s6.51cto.com/oss/202501/16/f3db01a28be7dcfd4b1749fbf806f989c6c51a.webp) 图 14:图表相关任务常用数据集汇总。来源:Document Parsing Unveiled[1]

图 14:图表相关任务常用数据集汇总。来源:Document Parsing Unveiled[1]

DeepChart、VIEW 和 ReVision 等成熟数据集支持图表分类研究,提供了丰富的图表类型。对于数据提取和结构提取,UB-PMC 和 Synth 等自定义数据集提供了宝贵但有限的资源。UB-PMC 包含真实的科学图表,而 Synth 则是生成的模拟图表。LineEX430k 和 OneChart 等最新数据集专注于更高级的任务,如信息提取、问答和推理。

6.大模型助力文档解析

大型文档提取模型(DELMs)采用基于 Transformer 的架构,能够将文本、图像、表格等多模态信息转换成结构化数据,这对于深入解析复杂文档极为关键。

早期的模型,例如 LLaVA-Next 和 Qwen-VL,虽然为多模态信息处理奠定了基础,但在处理专业文档时,它们在光学字符识别(OCR)和文档结构理解方面的精细度不足。

随后开发的模型,如 Nougat[3] 和 Vary[4],则在 OCR、结构化信息提取以及页面布局编排方面进行了优化,有效应对了技术文档处理中的难题。

2024 年,Fox 模型[5]在处理多页文档方面取得了突破,能够在不同页面间整合视觉与文本数据,且无需调整模型权重。Detect-Order-Construct 模型[6]通过将文档结构解析分解为检测、排序和构建三个步骤,进一步提高了分层解析的精度。OmniParser[7] 等模型则朝着集成化框架迈进,提升了文本与表格的识别能力。而 GOT 模型[8]则开创了一种全能的 OCR 方法,能够应对包括乐谱和复杂布局在内的多种文档类型。

这些进步预示着大型文档提取模型(DELMs)解决方案正在更加全面地发展,为学术研究到专业领域的文档处理带来了速度与准确性的双重提升。

7.开源文档解析工具及其评估

7.1 Tools

以下是一些广受欢迎的开源工具。

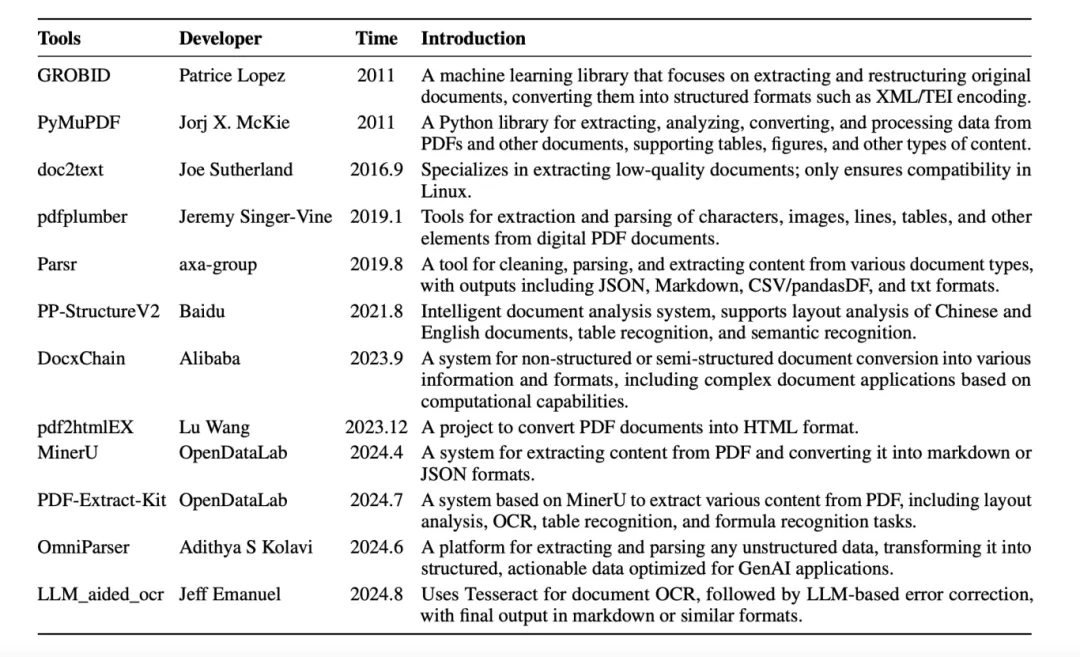

图 15:在 GitHub 上获得超过 1000 个星标的开源文档解析工具。来源:Document

图 15:在 GitHub 上获得超过 1000 个星标的开源文档解析工具。来源:Document

在 OCR 工具方面,Tesseract 和 PaddleOCR 以其高精确度、高速度以及多语言支持而处于领先地位。Tesseract 适合处理大规模的任务,而 PaddleOCR 在应对复杂情况时尤为出色。

对于那些结构较为复杂的文档,Unstructured[9] 和 Zerox 等专业框架展现出了卓越的性能,它们能够高效地提取出嵌套表格和混合内容。

包括 Nougat[3]、Fox[5]、Vary[4] 和 GOT[8] 在内的先进大模型,提供了专项解析功能。Nougat 特别适合解析含有公式的科学文档,Fox 擅长整合多模态信息,Vary 能够处理文本与图像混合的多种格式,而 GOT 凭借其统一架构,在处理表格、几何图形等不同内容类型时表现优异。

GPT-4 和 LLaMA 系列等多模态模型也在一定程度上支持文档解析任务。

7.2 Evaluation

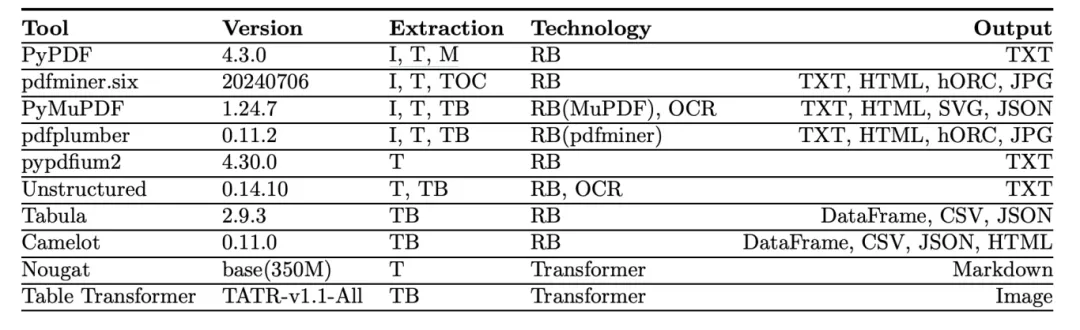

此外,本研究还对 10 种热门 PDF 解析工具在 6 个不同文档类别中的表现进行了评估和对比。

图片

图片

图 16:文本和表格提取工具概览。这些工具的主要提取功能包括图像(I)、文本(T)、元数据(M)、目录(TOC)以及表格(TB)。大多数工具采用的是基于规则(RB)的技术,部分工具还提供了光学字符识别(OCR)功能。需要注意,Nougat 和 Table Transformers 并不是本研究的主要重点。来源:A Comparative Study of PDF Parsing Tools[10]

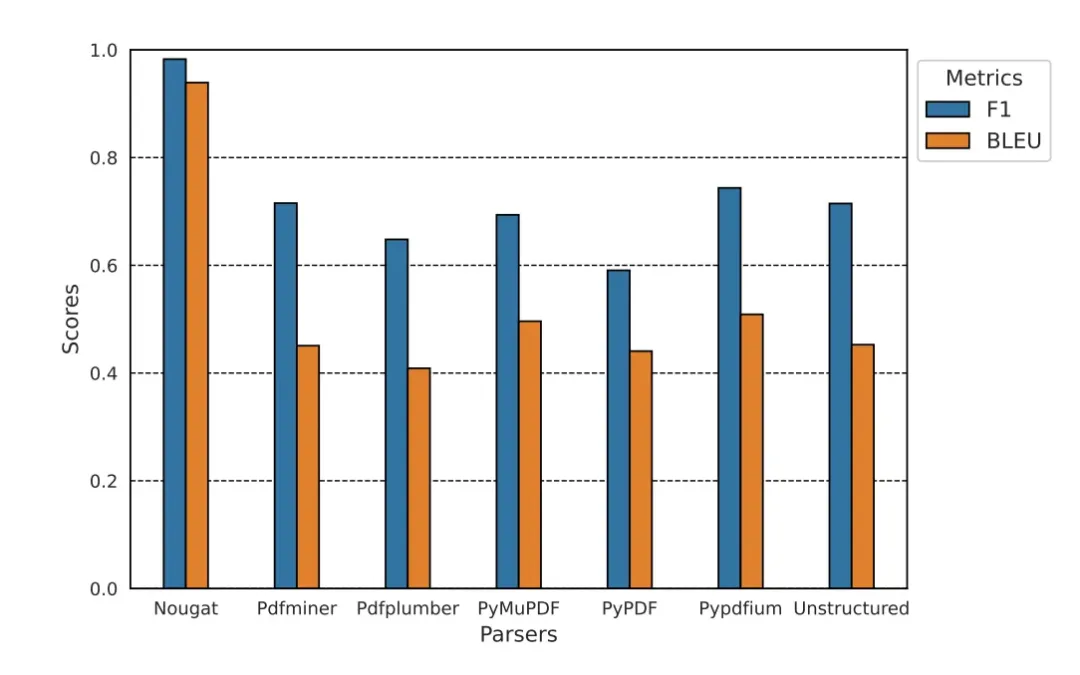

以下是基于 DocLayNet 数据集的 PDF 解析器评估结果的简明摘要。

在文本提取方面,不同文档类型间的性能差异颇为显著。PyMuPDF 和 pypdfium 在 Financial、 Tender、Law 和 Manual 类别中表现尤为出色,尤其是在保留单词结构方面。而在 visual transformer 模型 Nougat 的对比下,基于规则的解析器在文本提取上的表现则略显逊色。

图片

图片

图 17:基于规则的解析器与 Nougat 在科学文档文本提取能力的对比。来源:A Comparative Study of PDF Parsing Tools[10]

在表格提取方面,基于规则的工具在某些特定类别中表现不俗,Camelot 在 Tender 类别中领先,Tabula 则在 Manual、Scientific 和 Patent 类别中表现优异。不过,TATR[11] 在多数类别中展现出了稳定而全面的表现,尤其是在 Scientific 类别中(召回率超过0.9),尽管在 Manual 和 Tender 类别中它稍逊于 PyMuPDF 和 Camelot。

基于规则的方法,如 PyMuPDF 和 pdfplumber,在处理结构较为简单的文档时表现良好。但当遇到科学和专利文档时,基于学习的方法,如 Nougat 和 TATR,由于能够更好地处理复杂的布局和结构,因此表现更为出色。

8.Thoughts and Insights

8.1 实际应用现状

据我所知,目前模块化 pipeline 系统在实际应用中得到了广泛应用,而端到端的大模型在实际应用中仍面临一些限制。

尽管如此,端到端的大模型展现出了发展的巨大潜力。

8.2 文档解析的挑战

模块化 pipeline 系统面临的挑战包括:

- 文档布局分析(DLA)需要更深入地理解嵌套式布局。

- 光学字符识别(OCR)在处理密集文本和多字体文本时存在难题。

- 表格识别需要能够处理那些边界不清晰或跨多页的表格。

- 数学表达式识别需要加强对不同表达形式的处理能力。

- 图表提取缺乏统一的标准定义。

端到端的大模型虽然规避了模块化系统的复杂性,并提升了文档结构理解的深度,但仍面临以下挑战:

- 大多数用于文档解析的大模型并未在所有方面超越模块化 pipeline 系统。

- 由于参数固定,OCR 功能受限。

- 资源消耗大,处理密集文档效率不高,以及在大规模数据上图像与文本特征对齐的难题。

8.3 复杂文件的文档解析

当前的研究往往聚焦于结构简单的文档类型(如科学论文),而忽视了更为复杂的文件类型(例如简历)。

我们需要更加多样化的数据集。

8.4 文档类型的影响

评估结果显示,文档类型对解析器性能有着显著影响,因此工具的选择应符合具体的任务要求。

8.5 模型的可解释性与反馈循环

随着文档解析在法律和金融文件处理等关键领域的应用越来越重要,模型的可解释性变得不可或缺。能够提供透明度的技术(比如解释为何某些行或单元格被特定方式分组或标记)具有极其重要的价值。

展望未来,如果能够将用户的反馈循环纳入系统,让用户纠正错误的解释,可以为模型的自我优化开辟一条新的路径。这些模型将通过学习人类的纠正行为来动态地改进文档解析的预测结果。

9.Conclusion

本文深入评述和分析了文档解析技术,探讨了这一快速发展的领域中所采用的各种方法和技术。