都说大模型被广泛应用于学术研究的文献回顾、摘要筛选和稿件撰写等方面,然而具体多少人在使用、如何使用,却缺少定量的调查研究。

为此,研究人员进行了一项调查,识别受访者们在学术研究和发表中使用大模型的情况。以评估全球研究人员对大模型的认知水平。

论文地址:https://www.nature.com/articles/s41598-024-81370-6

这项调查的参与者包括来自59个国家、65个专业的总计226名医学相关研究者,他们在2020年至2024年间接受了哈佛医学院全球临床学者研究培训证书计划的培训。

研究人员如何使用大模型

在226名调查者中,198人(87.6%)表示之前知道大模型,其中对大模型有「一定程度」和「较深程度」了解的比例分别是33.3%和30.8%。

值得注意的是:相比不知道大模型的受访者,知道大模型的人发表的论文数更多,这一发现与先前的研究结果一致。

去年4月,斯坦福大学等机构发表的一篇论文称,对大模型的熟悉程度和使用,与学术作者在预印本和出版物上的产出率上存在正相关,这可能是缘于大模型领域研究的快节奏迭代,以及使用大模型进行写作辅助的原因。

论文地址:https://arxiv.org/abs/2404.01268v1

在这些知晓大模型的受访者中,之前使用过大模型的只有18.7%,他们主要用大模型来纠正语法和格式错误(64.9%),第二高频的使用方式是写作(45.9%),最后是修订和编辑(45.9%)。

该研究中81.3%的受访者表示,他们从未在研究项目或论文中使用大模型,有趣的是,这与去年9月发表的一篇论文的结论并不一致。

论文地址:https://www.europeanurology.com/article/S0302-2838(23)03211-6/abstract

这篇较早的论文发现,近一半的受访者表示在学术实践中使用过LLM。

尽管大模型在学术写作的各个环节中被频繁使用,但相当比例的受访者(约 40%)并不承认他们在出版物中使用过它。

研究人员隐瞒AI工具使用情况的原因有很多。首先,是研究人员对工具背后的技术缺乏信息或理解,其次,人们对使用AI工具依然抱有怀疑或负面的态度。出版商也可能会要求作者提交或包含一份声明,说明他们是否在写作中使用了AI系统。

对大模型未来影响的预期

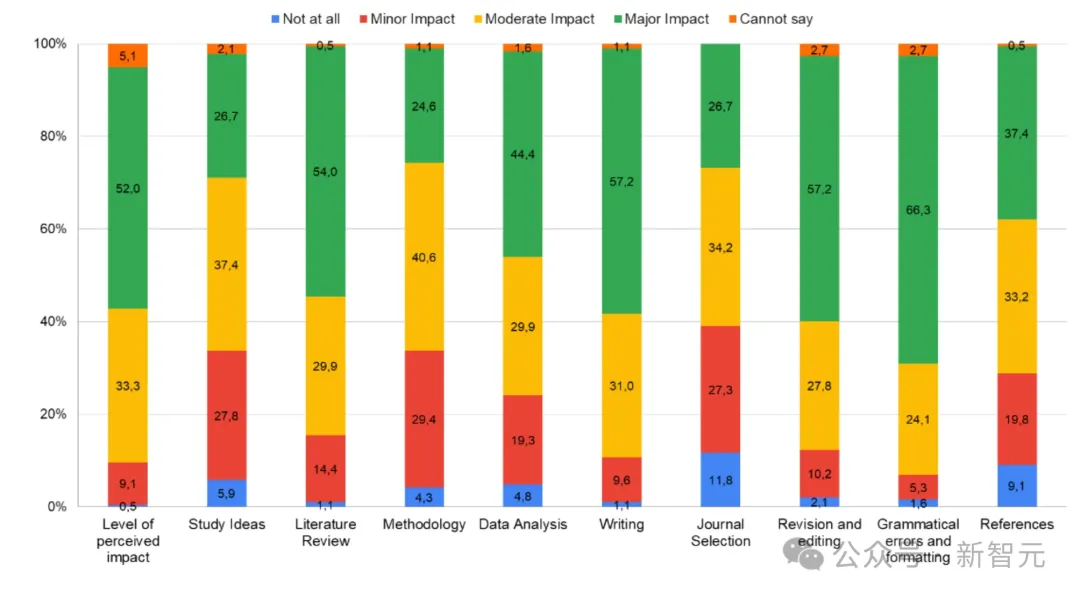

除了当前大模型的使用,这项调查还考察了受访者如何看待大模型未来对各研究阶段的影响。如下图所示,从左到右按照学术研究的各阶段,从观点产生到文献回顾,方法学涉及,数据分析,写作,选择期刊,修订和编辑,校正语法错误,设置参考文献。

预期学术研究各阶段受到大模型影响的比例

大多数(52%)受访者认为大模型将产生重大的整体影响;分阶段来看,有最多受访者认为将受到重大影响的语法错误和格式(66.3%),其次是修订&编辑(57.2%)和写作(57.2%)。

这些结果表明,在研究人员看来,大模型可以极大地提高上手速任务的效率和准确性,从而促进更快、更高品质的学术产出。

与之相对的是,有一些阶段是被认为不受影响,或仅受到有限程序影响的,包括方法论(74.3%)、期刊选择(73.3%)和研究观点(71.1%),这反映了人们在对AI在批判性评估、研究设计和期刊选择上的担忧和质疑。

当谈及大模型对学术界会带来正面或负面影响时,大多数受访者认为它将带来积极影响(50.8%),但相当一部分人表示不确定(32.6%)。

尽管大多数受访者认为期刊应允许在出版中使用AI工具(58.1%),但绝大多数(78.3%)也认为应制定相应的规定,例如修改期刊政策、增加检测大模型使用的工具,以确保 AI 工具在科研中的有序使用。

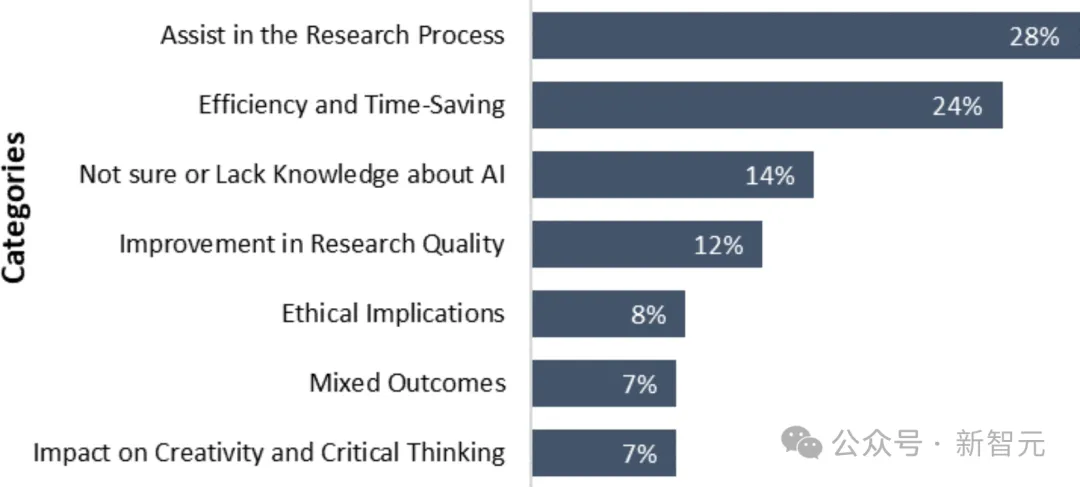

图2:受访者认为大模型在未来的主要挑战和应用范围

具体来看,如图2所示:28%的受访者表示,大模型是论文发表过程中的有用工具,尤其是在系统地组织和撰写文本上。

此外,大约四分之一的受访者表示,使用大模型后,研究人员能够在文献综述、数据分析、稿件准备等研究项目的不同阶段中节省更多时间。

同时,这项调查还揭示了受访者在学术研究中使用大模型时遇到的担忧和挑战:14%的受访者表示对大模型存在不确定感或缺乏经验,还有8%的人存在道德担忧,包括潜在的歧视、隐私泄露和剽窃问题。

这表明,尽管大多数受访者支持在学术论文中使用AI工具,但他们也不约而同地强调加强实施监管措施的必要性。

有趣的是,对于AI伦理,经验水平不同的研究人员之间存在差异。相比经验较少的参与者,拥有10年以上研究经验的参与者更有可能对AI工具有积极态度,并支持在监管条件下使用。

尽管这项调查近关注了医学相关的研究,也缺少多次采样从而获得可能的因果关联,但该研究的几个发现却值得关注。

首先是学术研究中对大模型的使用,目前还只在「尝鲜」的阶段,随着智能体的成熟,大模型的应用将超越语法修改,文献总结等方面,慢慢影响到更有批判性和创造性的研究阶段。

其次是该研究中发现大模型的应用为研究人员节省了时间,但这些节省下的时间,能否抵消掉多出来的用于检查LLM文本真实性的时间?