在 Python 中处理大文本文件可能令人头疼,尤其当文件大小达到数 GB 时,尝试一次性加载到内存中往往会导致程序崩溃。然而,Python 提供了多种高效策略,能够在保障性能的同时避免内存耗尽。

无论是处理服务器日志、海量数据集,还是其他大型文本文件,接下来将为你带来 Python 管理大文件的最佳实践和实用技巧,助你轻松应对数 GB 数据的挑战!

大文件处理不仅仅是数据科学家或机器学习工程师的专属任务,它在许多领域都是常见的需求:

- 数据分析:服务器日志、交易记录或传感器数据通常以巨大的文件形式存在。

- 网络爬取:需要处理从网页抓取的大量数据集。

- 机器学习:准备无法完全加载到内存中的训练数据集。

掌握这些技术的关键好处:

- 避免内存错误:一次性加载整个文件容易导致崩溃(例如,MemoryError)。

- 加快处理速度:通过增量读取文件,可以显著提升性能。

- 优化资源使用:即使在内存有限的机器上,也能运行大规模任务。

掌握大文件处理技术,在应对海量数据时更加从容!

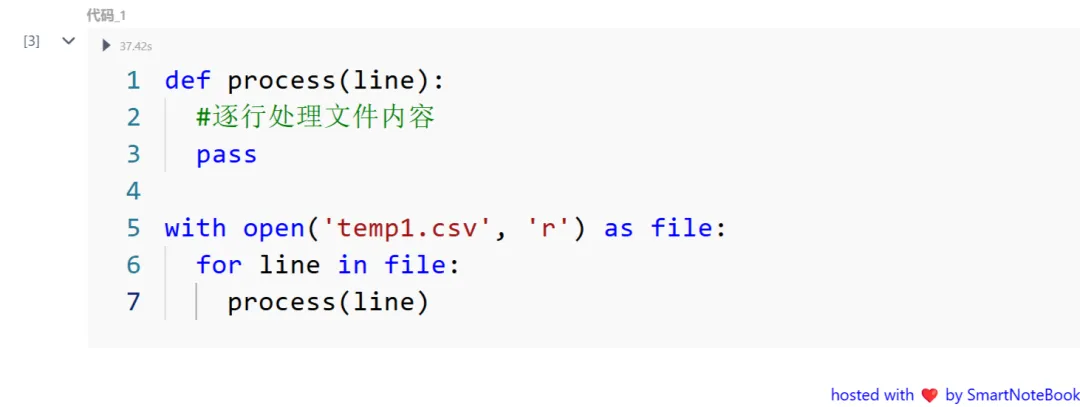

1. 使用迭代器逐行读取文件

逐行读取文件可以确保在任意时间内,仅加载文件的一小部分到内存中,从而避免内存占用过高。以下是实现方法:

图片

图片

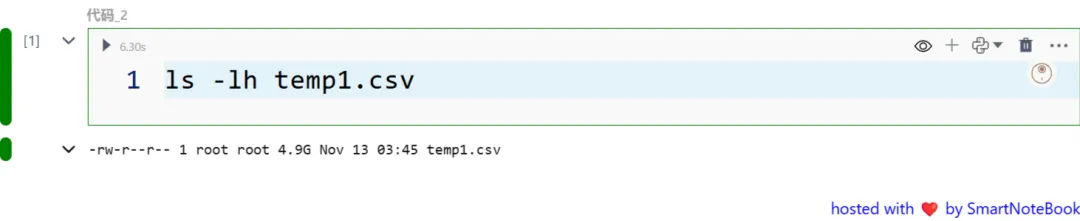

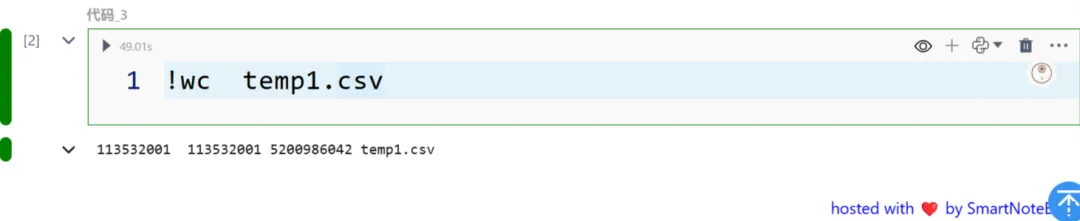

这个样例文件4.96G,一亿多行:

图片

图片

图片

图片

通过这种方式,Python 会利用文件迭代器按需读取内容,而不是一次性将整个文件加载到内存中。这种方法特别适合处理超大文本文件。

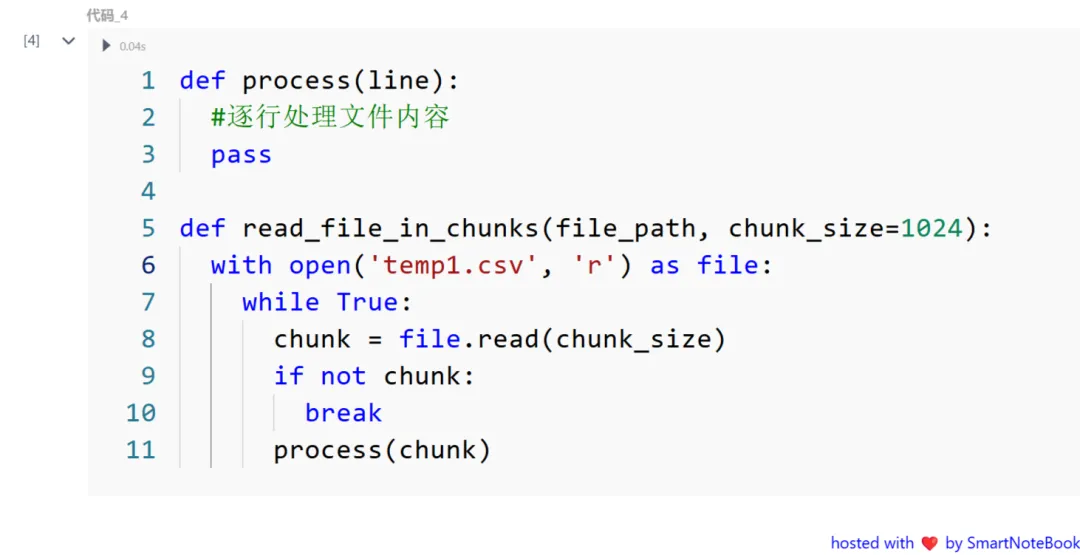

2. 按块读取文件

有时,需要比逐行读取更大的灵活性。按固定大小的块读取文件可以让你控制每次处理的数据量。适用于那些不需要逐行处理的文件。根据系统的内存大小调整 chunk_size,以获得最佳的性能表现。

图片

图片

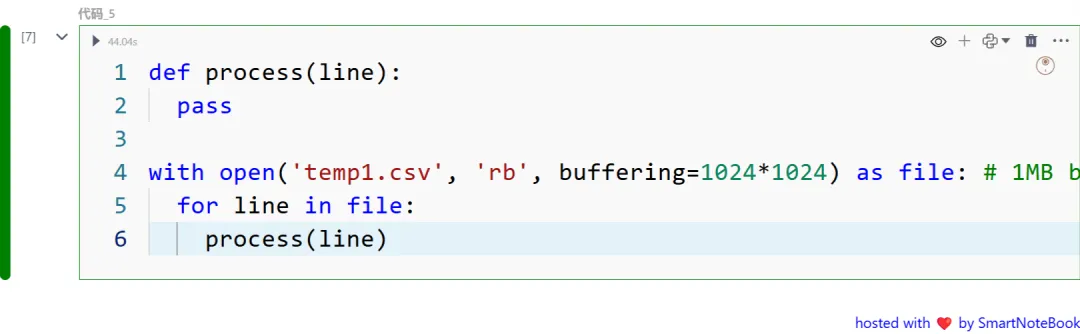

3. 缓冲文件读取

缓冲读取通过以更大的内部块处理文件,提供更高层次的优化,缓冲读取减少了频繁磁盘 I/O 操作的开销,从而提高文件读取的效率。

图片

图片

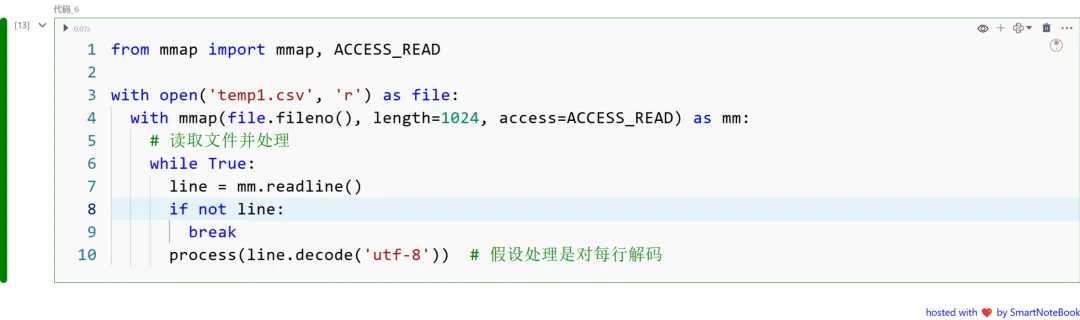

4. 内存映射文件 (mmap)

内存映射允许 Python 将文件直接当作内存中的字节数组来处理,特别适合需要随机访问的场景。

图片

图片

适用于超大文件,尤其是当你需要随机访问文件内容时。内存映射可以提升读取密集型任务的性能,因为它直接在内存中处理文件数据,而不是频繁的磁盘 I/O 操作。

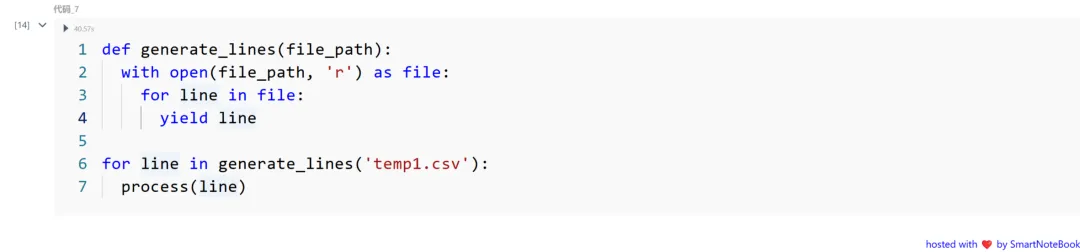

5. 使用生成器

生成器允许你懒加载数据,只加载必要的部分,从而节省内存。

图片

图片

通过逐行处理数据,生成器显著减少了内存的使用,因为它每次只加载一行,而不是一次性加载整个文件。

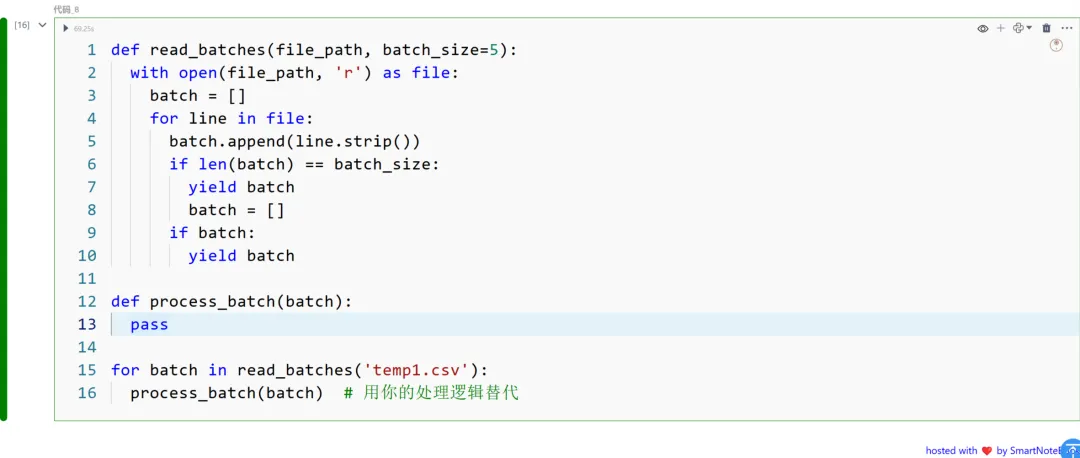

6. 批量处理行

对于结构化文件,你可以一次性处理一组行(或记录)。适用于结构化数据,如 CSV 文件或日志文件。通过按批次处理,可以提高处理效率,特别是对于大规模数据集。

图片

图片

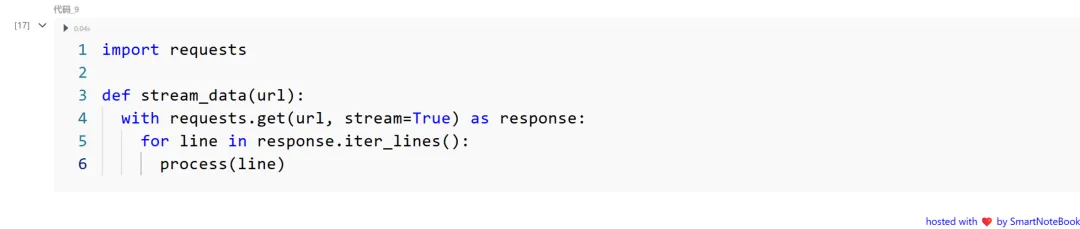

7. 流处理

如果数据是连续到达的(例如,日志或 API),可以使用流处理。非常适合用于实时日志监控或 API 数据流处理。当数据源是持续不断地流入时,流处理能够高效地逐步处理数据,而不需要一次性加载所有内容。

图片

图片

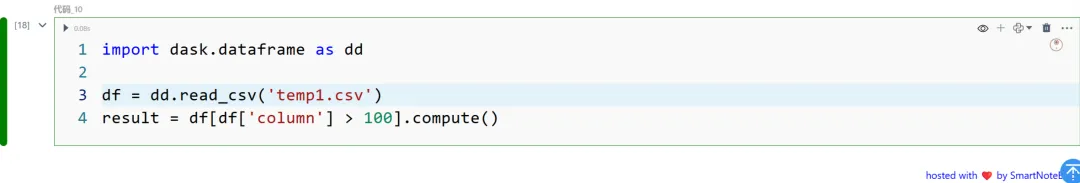

8. 使用 Dask 进行并行处理

对于超大数据集,可以考虑使用 Dask,这个库专门为大数据的并行计算设计。Dask 通过将数据分块处理,能够高效地处理超出内存的数据。当数据集太大无法完全加载到内存时,Dask 可以将数据拆分成较小的块,并行处理,从而避免内存溢出并加快计算速度。

图片

图片

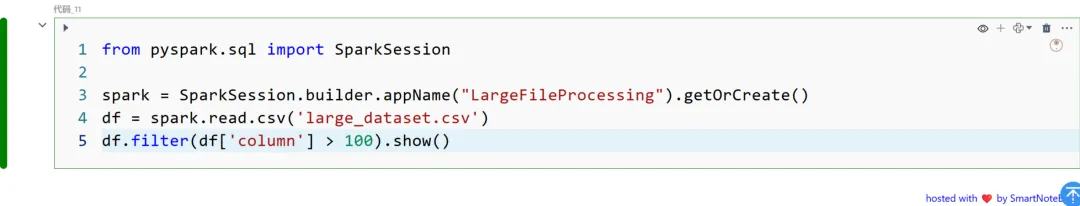

9. 使用 PySpark 进行分布式处理

当数据量超出单台机器的处理能力时,可以使用 PySpark 进行分布式处理。适用于大数据任务,需要集群级资源进行处理。PySpark 可以利用多个节点的计算能力,处理无法在单机上处理的大型数据集,提升数据处理的效率。

图片

图片

10. 针对特定格式的高效库

对于特定类型的文件,使用优化过的库来提高处理效率:

- JSON: 使用 ijson 进行增量式 JSON 解析。

- XML: 使用 lxml 进行快速且内存高效的 XML 解析。

- Parquet/Arrow: 使用 pyarrow 或 fastparquet 处理列式数据。

大文件处理的两个事实:

- 内存高效的 Python: Python 在许多地方使用懒计算(例如,生成器),以最大限度地减少内存使用。

- 鸭子类型: Python 不关心对象的类型,只关心它们的行为——这也是 Python 在处理不同数据格式时的一个重要优势。

常见错误与避免方法

- 一次性加载整个文件: 避免使用 file.readlines(),除非文件较小。

- 忘记缓冲: 使用缓冲 I/O 以提高性能。

- 忽视边界情况: 总是处理诸如空行或无效格式等错误情况。

处理大文件不必让人感到畏惧。无论是逐行读取文件、处理数据块,还是使用像 Dask 和 PySpark 这样的工具,Python 都提供了丰富的工具集,满足各种需求。