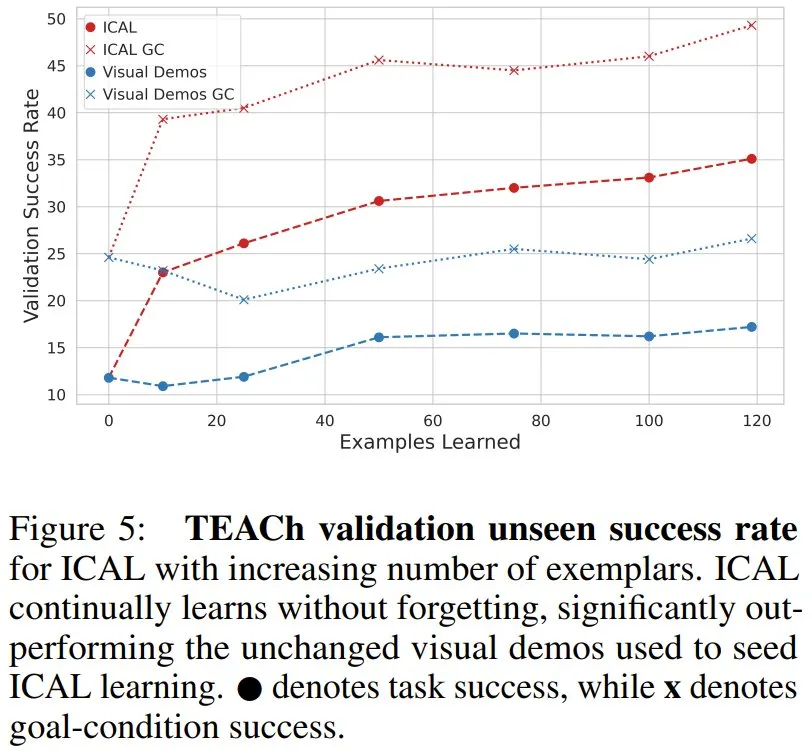

最近 AI 社区很多人都在讨论 Scaling Law 是否撞墙的问题。其中,一个支持 Scaling Law 撞墙论的理由是 AI 几乎已经快要耗尽已有的高质量数据,比如有一项研究就预计,如果 LLM 保持现在的发展势头,到 2028 年左右,已有的数据储量将被全部利用完。

图源:Will we run out of data? Limits of LLM scaling based on human-generated data

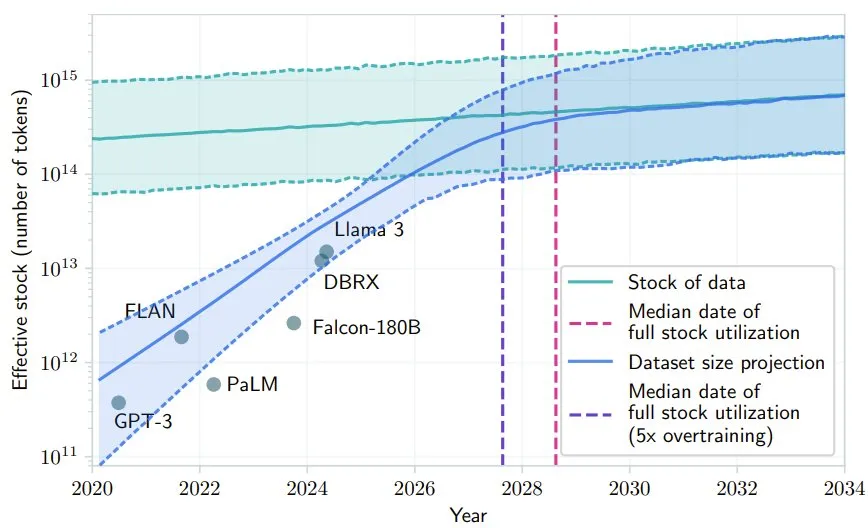

卡内基・梅隆大学(CMU)和 Google DeepMind 的一篇标题为「VLM 智能体生成自己的记忆:将经验蒸馏成具身思维程序」的研究发现,通过使用低质量数据和反馈,或许能够解决这个高质量数据不足的问题。其中提出的 ICAL 可让 LLM 和 VLM 根据次优演示和人工反馈创建有效的提示词,从而改善决策并减少对专家演示的依赖。该论文是 NeurIPS 2024 的 Spotlight 论文,项目代码也已发布。

- 论文标题:VLM Agents Generate Their Own Memories: Distilling Experience into Embodied Programs of Thought

- 论文地址:https://openreview.net/pdf?id=5G7MRfPngt

- 项目地址:https://ical-learning.github.io/

- 代码地址:https://github.com/Gabesarch/ICAL

我们知道,人类具有非常出色的少样本学习能力,通过将观察到的行为与内部世界模型相结合,可以从单一任务演示快速泛化到相关的情况。人类能分辨出与成功相关或不相关的因素,并预测可能的失败。通过反复练习和反馈,人类能很快找到正确的抽象,从而帮助模仿和调整任务以适应各种情况。这个过程可促进在各种任务和环境中不断改进和迁移知识。

最近有研究探索了使用大型语言模型(LLM)和视觉 - 语言模型(VLM)来从轨迹和经验中提取高层级见解。这些见解是模型通过内省(introspection)产生的,而通过将它们附加到提示词之后,可以提升其性能 —— 这就用到了它们强大的上下文学习能力。

现有的方法通常更关注语言上的任务奖励信号、存储失败之后的人类更正、使用领域专家来人工编写或人工挑选示例(无需内省)、或使用语言来塑造策略和奖励。关键在于,这些方法通常都是基于文本的,并不包含任何视觉提示或演示,或者仅在失败的情况下使用自省,但这只是人类和机器整合经验和提取见解的几种方式之一。

而 CMU 和 DeepMind 这个研究团队的做法是:给定次优的演示和人类自然语言反馈,通过学习上下文经验抽象来让 VLM 学习解决新任务。这种方法被命名为 In-Context Abstraction Learning(ICAL),即上下文抽象学习。

上下文抽象学习究竟如何学习?

ICAL 这种方法可通过提示,让 VLM 创建用于不熟悉领域的多模态抽象。

我们知道,之前的研究工作通常仅存储和检索成功的动作规划或轨迹。但 ICAL 不一样,强调的是学习抽象(abstraction),而这种所谓的抽象实际上包含了有关任务的动态和关键知识,如图 1 所示。

具体来说,ICAL 可处理四种类型的认知抽象:

- 任务和因果关系,确定实现目标所需的基本原则或行动,以及要素如何通过因果关系相互关联;

- 对象状态的变化,描述对象将采取的各种形式或条件;

- 时间抽象,将任务分解为子目标;

- 任务建构(task construals),突出任务中的关键视觉细节。

当具有最优或次优演示时,ICAL 可通过提示 VLM 将这些演示转换为优化后的轨迹,同时创建相关的语言和视觉抽象。然后在人类的自然语言反馈的引导下,通过在环境中执行这些轨迹来优化这些抽象。

这个抽象生成过程的每一步都会使用之前推导出的抽象,让模型不仅可以提升自己的执行效果,还能提升自己的抽象能力。

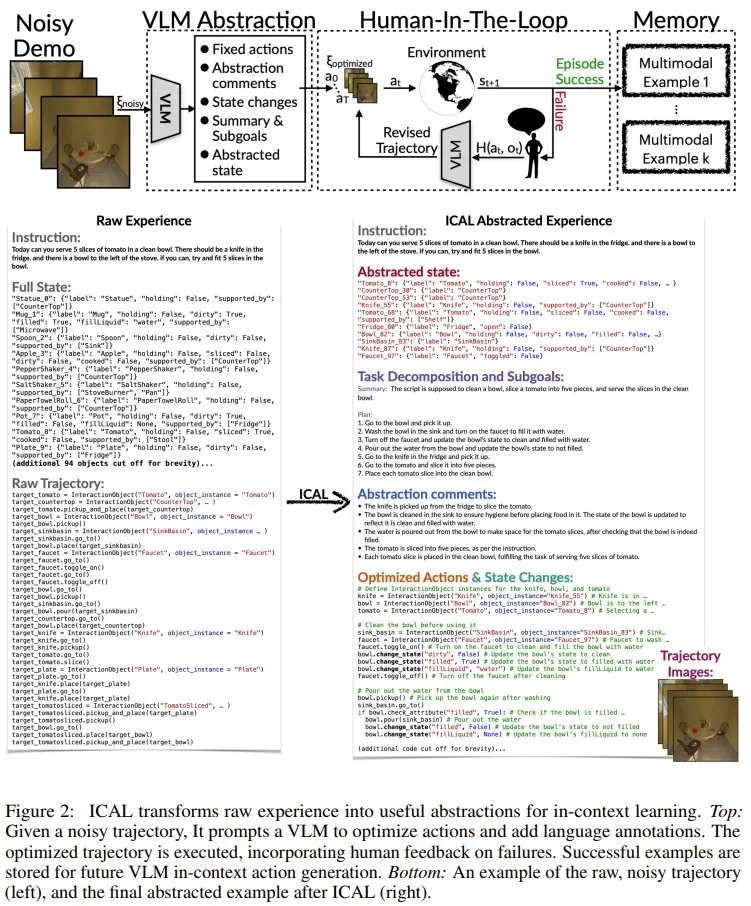

图 2 给出了 ICAL 的概览。

其中,每一轮迭代都始于一个有噪声的轨迹。ICAL 会分两个阶段对其进行抽象:

- 抽象阶段(F_abstract):VLM 会借助语言评论来纠正错误,并让序列更加丰富。这一阶段处理的抽象前文已有介绍,而相关的具体提示词等请参看原论文附录部分。

- 有人类参与的阶段(human-in-the-loop,记为 F_hitl):在此阶段,序列会在环境中执行,其抽象过程由以自然语言传达的人类反馈指导。这一阶段的具体流程可分为 6 步:优化轨迹的执行、监控与干预、反馈整合与轨迹修正、环境重置与重试、成功标准与反馈限度、保存示例。具体详情请访问原论文。

在成功执行轨迹之后,它将被存档在一个持续增长的范例库中。这些范例会被用作智能体的上下文参考,用于在学习阶段和推理阶段为未曾见过的指令和环境提供参考。

总体而言,这种学习到的抽象可以总结有关动作序列、状态迁移、规则和关注区域的关键信息,并可通过自由形式的自然语言和视觉表征明确地表达出来。

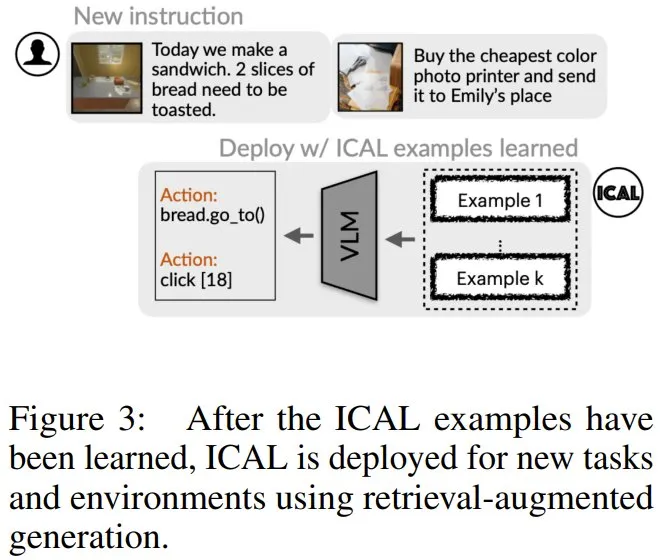

学习得到 ICAL 样本之后,就可以使用检索增强式生成部署起来,用于新任务和新环境。

实验表明 ICAL 确实可行

研究者在 TEACh 和 VisualWebArena 中测试了 ICAL 的任务规划能力,并在 Ego4D 基准测试中测试其动作预测能力。其中,TEACh 针对的是家庭环境中的对话式教学,VisualWebArena 则是多模态自动化网络任务,Ego4D 则是用于视频动作预测。

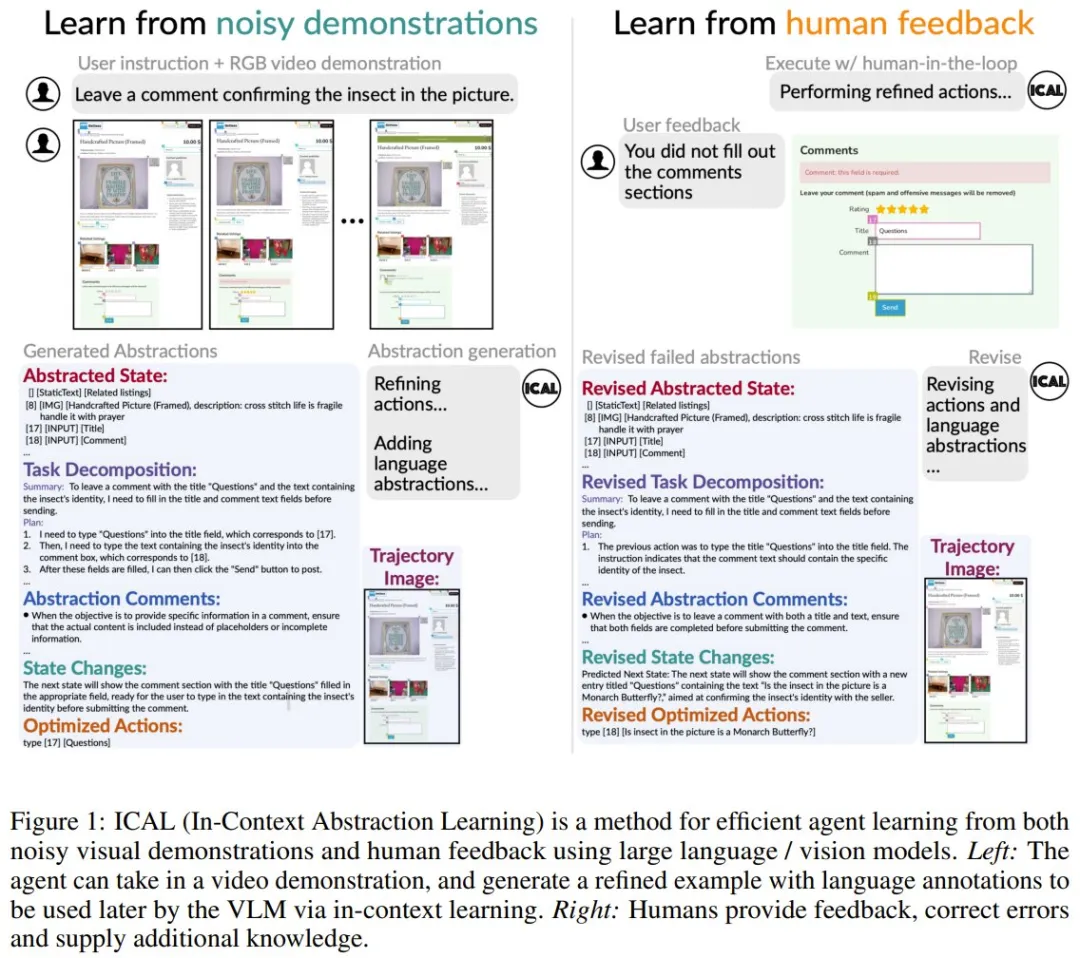

首先,该团队发现,在家庭环境的指令遵循任务中,ICAL 优于固定的演示。

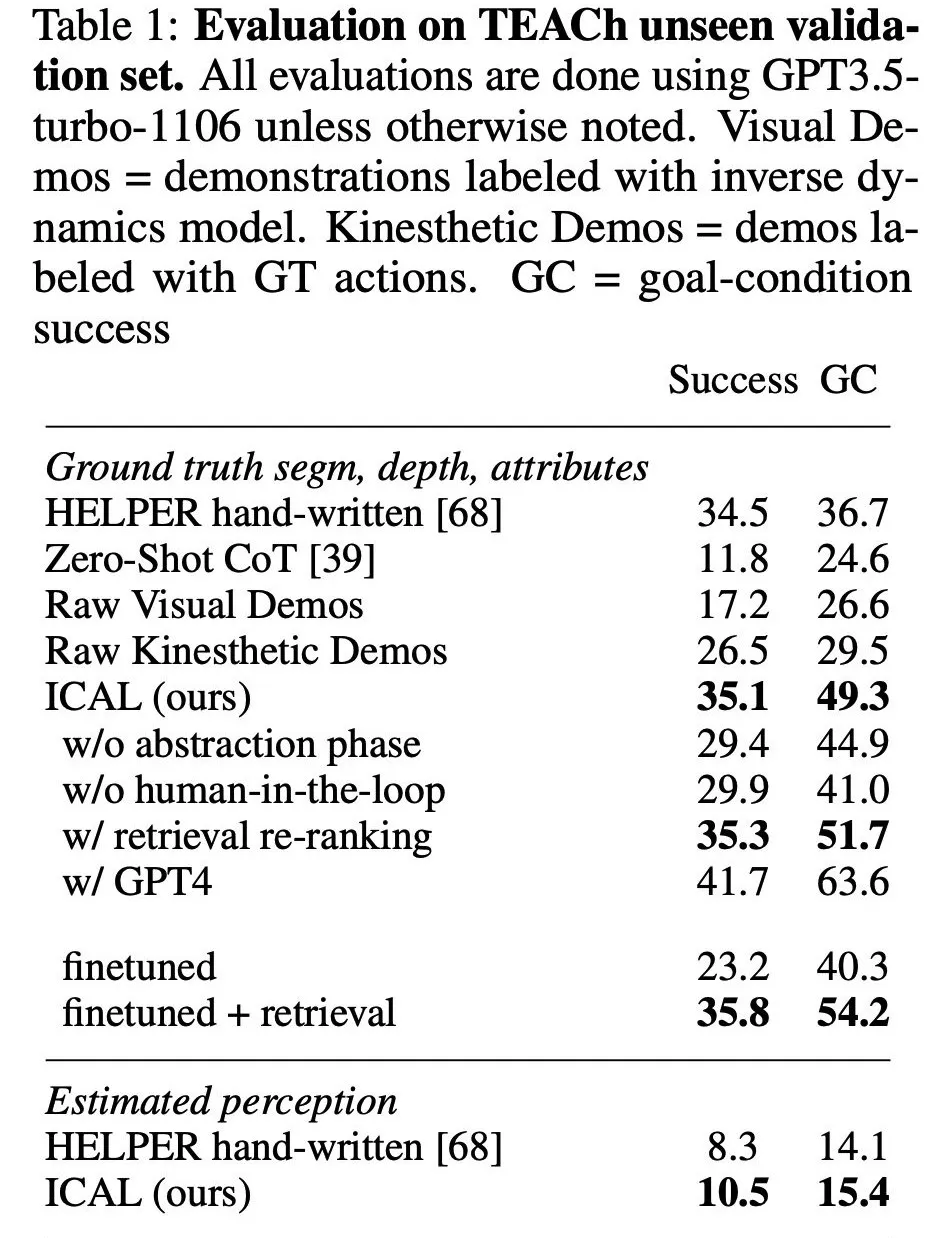

表 1 列出了在未曾见过的 TEACh 验证集上的研究结果,其中评估了在新指令、房屋和物体上的性能。

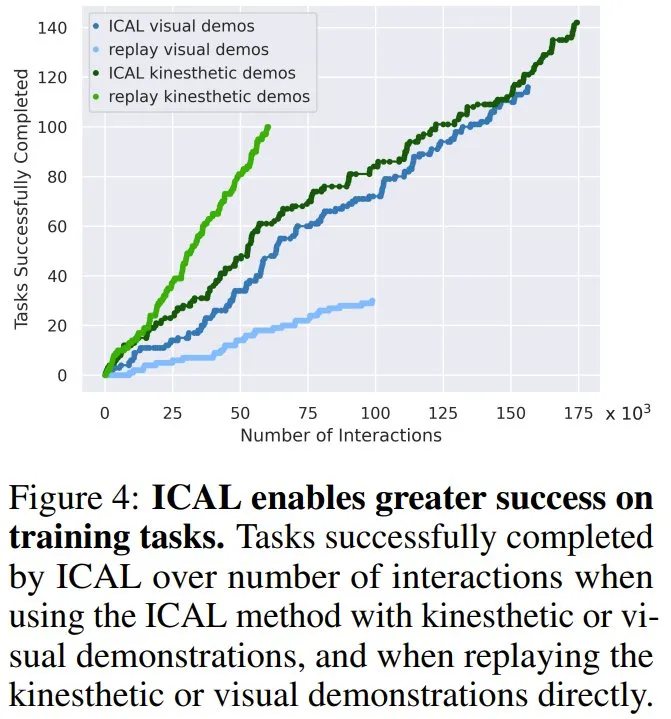

如图 4 所示,与模仿原始轨迹相比,ICAL 对有噪声的轨迹进行了修正,使训练任务的成功率更高,动觉演示和视觉演示的成功率分别提高了 42% 和 86%。这表明 ICAL 不仅增加了有用的抽象概念,还纠正了被动视频演示中的错误,提高了在原始演示环境中的成功率。

如表 1 所示,在未见过的任务上,ICAL 的表现优于作为上下文示例的未被处理的演示,其成功率比带有预测动作的原始演示提高了 17.9%,比带有真实动作注释的演示提高了 8.6%。这凸显了新提出的抽象方法在提高样本质量以改进上下文学习方面的有效性,这不同于之前的主要方法,即保存和检索成功的行动规划或轨迹但不进行抽象。

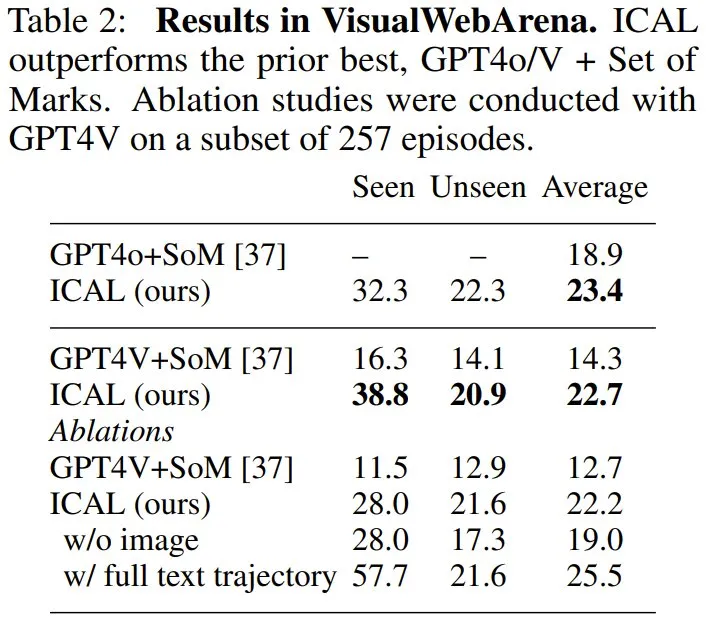

另外,在视觉网络任务上,ICAL 也获得了 SOTA 性能。在 VisualWebArena 上,新智能体超过了 GPT4 + Set of Marks 的组合,使用 GPT4V 时从 14.3% 提高到 22.7%,使用 GPT4o 时从 18.9% 提高到 23.4%。

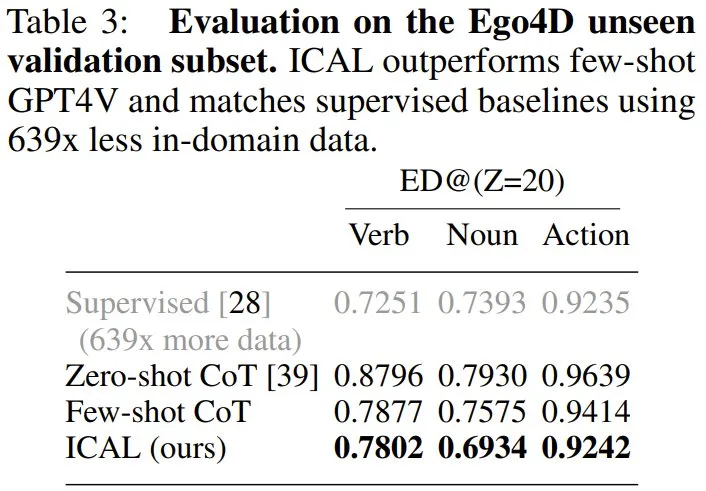

在 Ego4D 设置中,ICAL 的表现优于使用思维链的少样本 GPT4V,分别将名词和动作编辑距离缩短了 6.4 和 1.7,并且与完全监督式方法相差无几 —— 但使用的领域内训练数据减少了 639 倍。

总体来说,新方法可显著减少对专家示例的依赖,并且相比于使用「缺乏此类抽象的动作规划和轨迹」的上下文学习,新方法始终更优。

此外,随着示例数量增长,ICAL 也能获得明显的提升。这表明这种新方法也能很好地 Scaling。