2025年1月1日,OpenAI CEO 奥特曼公布了公司的新年目标,涵盖AGI、智能体、4o升级、模型更好记忆、更长上下文等等。

图片

图片

关于智能体,有网友爆料,OpenAI 可能在 1 月份发布一个名为 “operator” 的 Agent,这个 Agent 将具备直接控制电脑的能力。

图片

图片

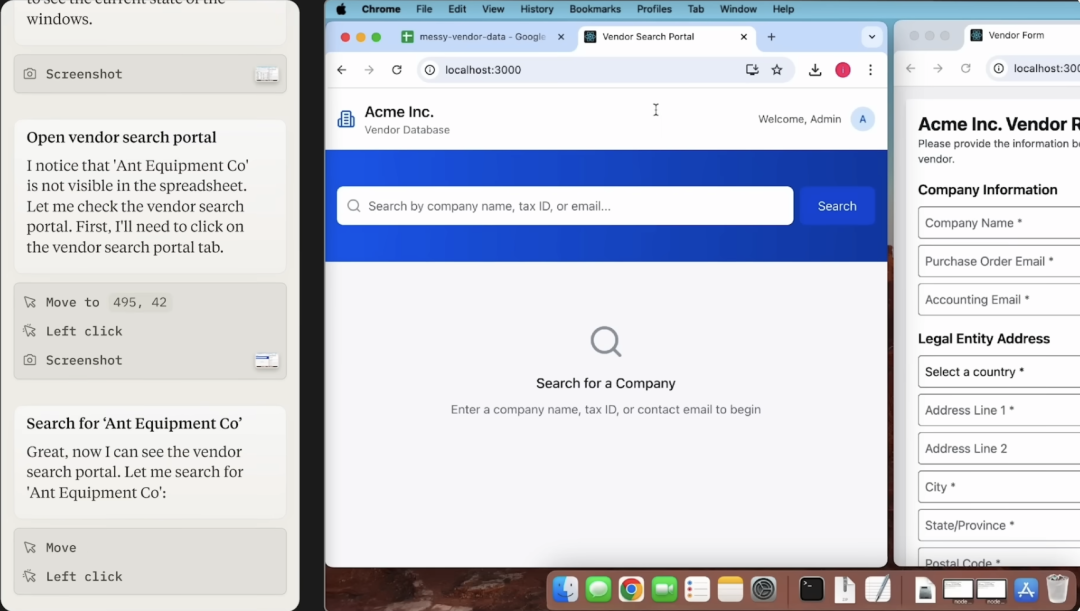

其实24年10月份的时候,Claude 就已经发布了基于 Claude 3.5 Sonnet 多模态大模型,可操作电脑的智能体。

图片

图片

上图左侧是智能体的执行过程,Claude 能够感知计算机界面并与之交互,将用户的指令(例如“使用我的计算机和在线数据填写此表格”)转换为计算机命令(例如,检查电子表格;移动光标以打开 Web 浏览器;等等)。

要实现这种智能体至少依赖大模型的三项技术能力。

第一,用户意图理解能力,比如,用户说“打开浏览器并搜索 AI 最新进展”,大模型需要解析出“打开浏览器”和“搜索 AI 最新进展”两个子任务。

第二,任务规划与执行能力,需要将复杂的任务分解为一系列可执行的子任务。例如,“发送一封邮件”分解为“打开邮箱应用”、“点击撰写按钮”、“输入收件人”、“输入内容”、“点击发送”等步骤。

第三,视觉理解能力(多模态大模型),例如,“打开网址”需要识别浏览器地址栏的位置并输入 URL。

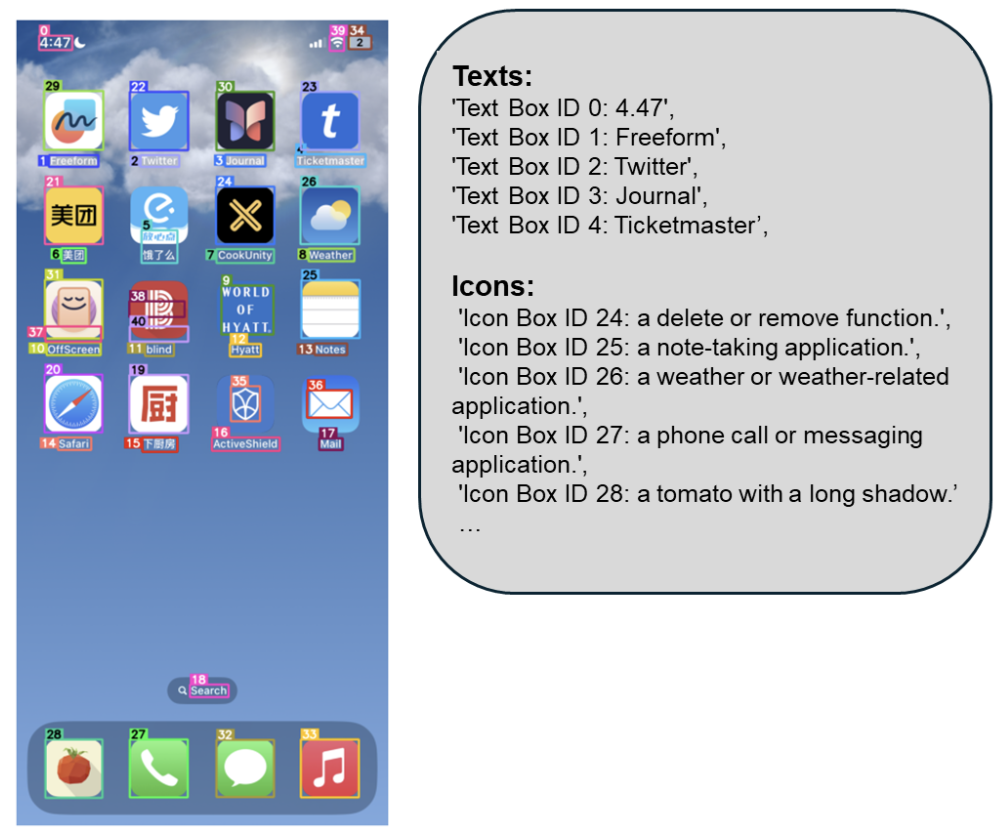

几乎同一时间,微软也开源了一款基于GPT-4V视觉大模型的屏幕解析工具——OmniParser,能够将用户界面(UI)截图转换为结构化元素,帮助 AI 精准理解屏幕内容并生成操作指令。

图片

图片

当然,国内大模型也不甘示弱,智谱手机端 AutoGLM,通过语音指令模拟人操作,实现电商购物、点外卖、微信回复等功能。

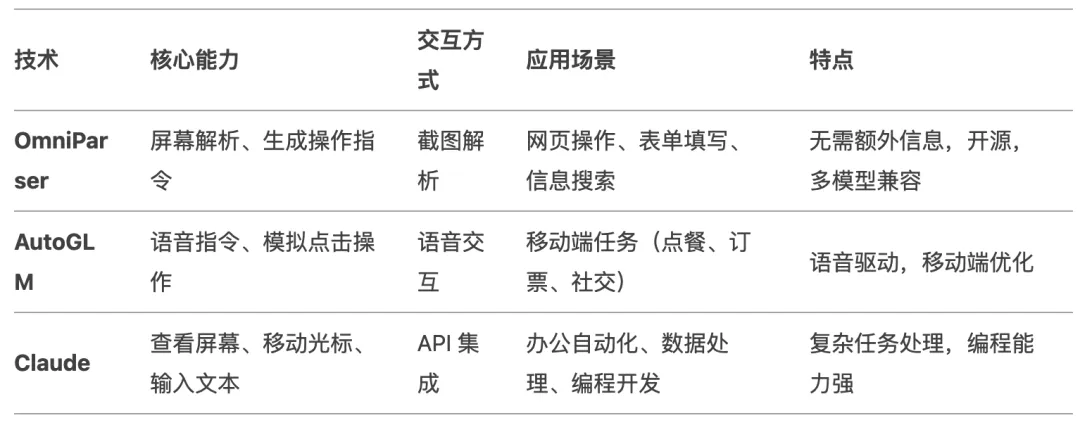

下面是这三款工具总结对比:

图片

图片

不过现阶段,这类智能体还有瑕疵,能力并不完美。

但我觉得没关系,我们不指望它能完成一个大型或者复杂的任务,现阶段能帮我们完成单一、重复性工作就挺好,嗯...自动抢票?

哦,对了前几天谷歌也发布了类似智能体,基于新版多模态大模型 Gemini 2.0 的浏览器智能体,可以自动使用浏览器完成工作。

过去一年智能体话题一直保持很高热度,10月份时候 OpenAI 还开源了一款多智能体Python开发框架——Swarm。

图片

图片

这次又将智能体列为新年目标,看起来是要大干一场。估计各大模型厂商也要在这一领域卷一卷了。

我们仍然选择趴窗户看。