1 月 2 日消息,清华大学智能产业研究院(AIR)于 2024 年 12 月 24 日发布论文,介绍推出 AutoDroid-V2 AI 模型,在移动设备上利用小语言模型,显著提升了自然语言控制的自动化程度。

该系统采用基于脚本的方法,利用设备端小型语言模型(SLM)的编码能力,高效执行用户指令。相比依赖云端大型语言模型(LLM)的传统方法,AutoDroid-V2 在效率、隐私和安全性方面均有显著优势。

项目背景

大型语言模型(LLMs)和视觉语言模型(VLM)通过自然语言命令,彻底改变了移动设备控制的自动化,为复杂的用户任务提供了解决方案。

自动化控制设备主流采用“逐步 GUI 智能体”(Step-wise GUI agents)方式,通过在每个 GUI 状态查询,LLM 进行动态决策和反思、持续处理用户的任务,并观察 GUI 状态直至完成来进行操作。

但这种方式严重依赖基于云端的模型,在分享个人 GUI 页面时,还存在隐私和安全风险,此外还存在大量的用户端流量消耗以及高昂的服务器端集中服务成本等严重问题,阻碍大规模部署 GUI 智能体。

项目简介

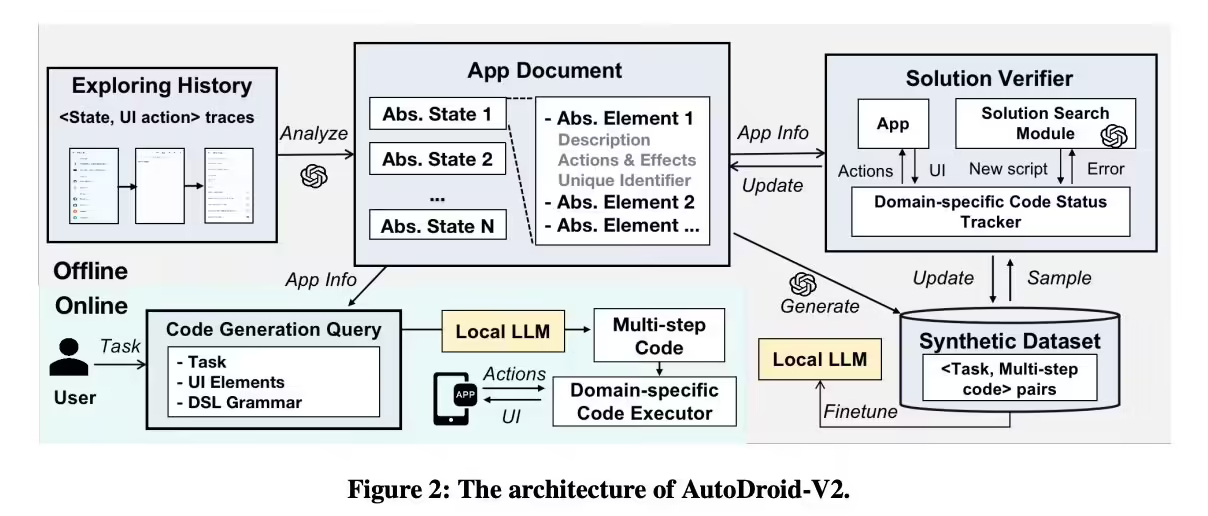

不同于传统的逐步操作,AutoDroid-V2 根据用户指令生成多步骤脚本,一次性执行多个 GUI 操作,大幅减少了查询频率和资源消耗。

利用设备上的小型语言模型进行脚本生成和执行,避免了对强大云端模型的依赖,有效保护了用户隐私和数据安全,并降低了服务器端成本。

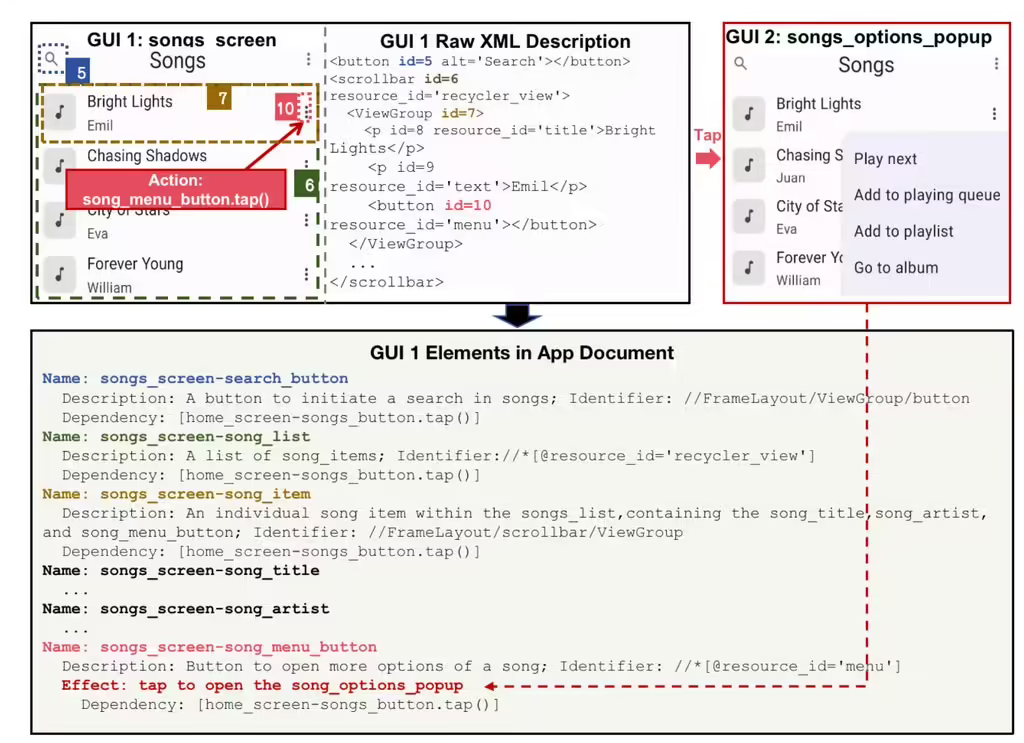

该模型在离线阶段会构建应用程序文档,包含 AI 引导的 GUI 状态压缩、元素 XPath 自动生成和 GUI 依赖分析,为脚本生成奠定基础。

此外用户提交任务请求后,本地 LLM 生成多步骤脚本,由特定域解释器执行,确保可靠高效的运行。

性能

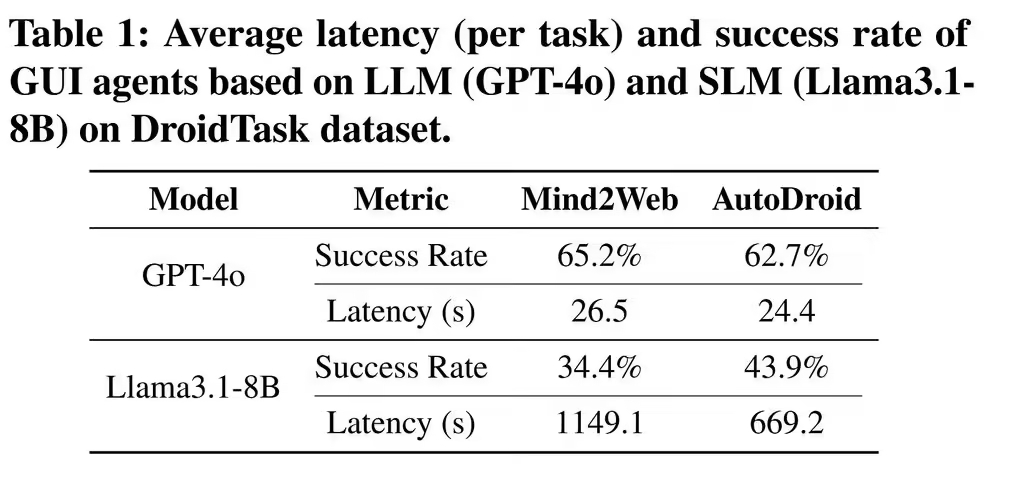

基准测试上,在 23 个移动应用上测试 226 项任务,与 AutoDroid、SeeClick、CogAgent 和 Mind2Web 等基线相比,任务完成率提高 10.5%-51.7%。

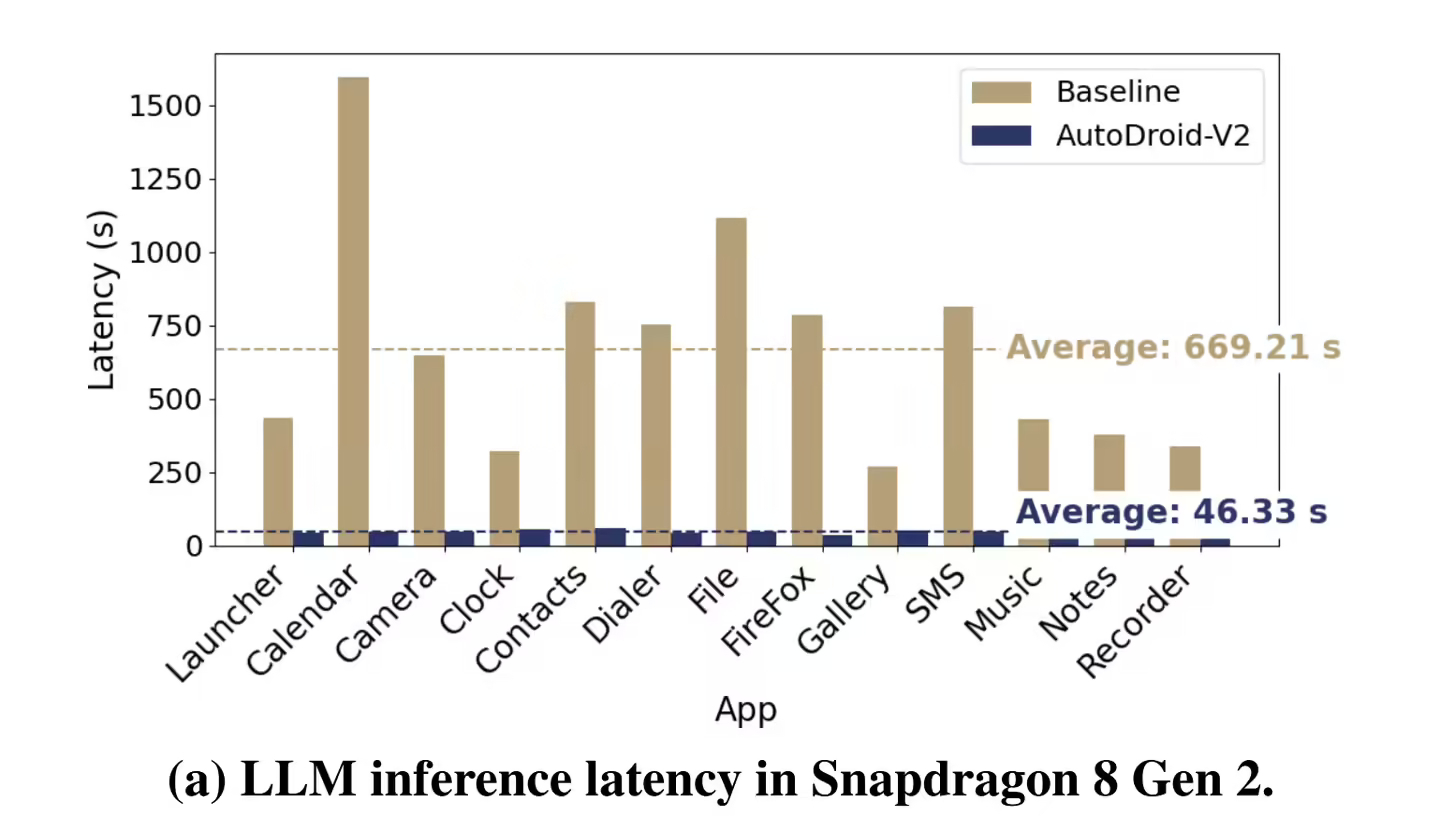

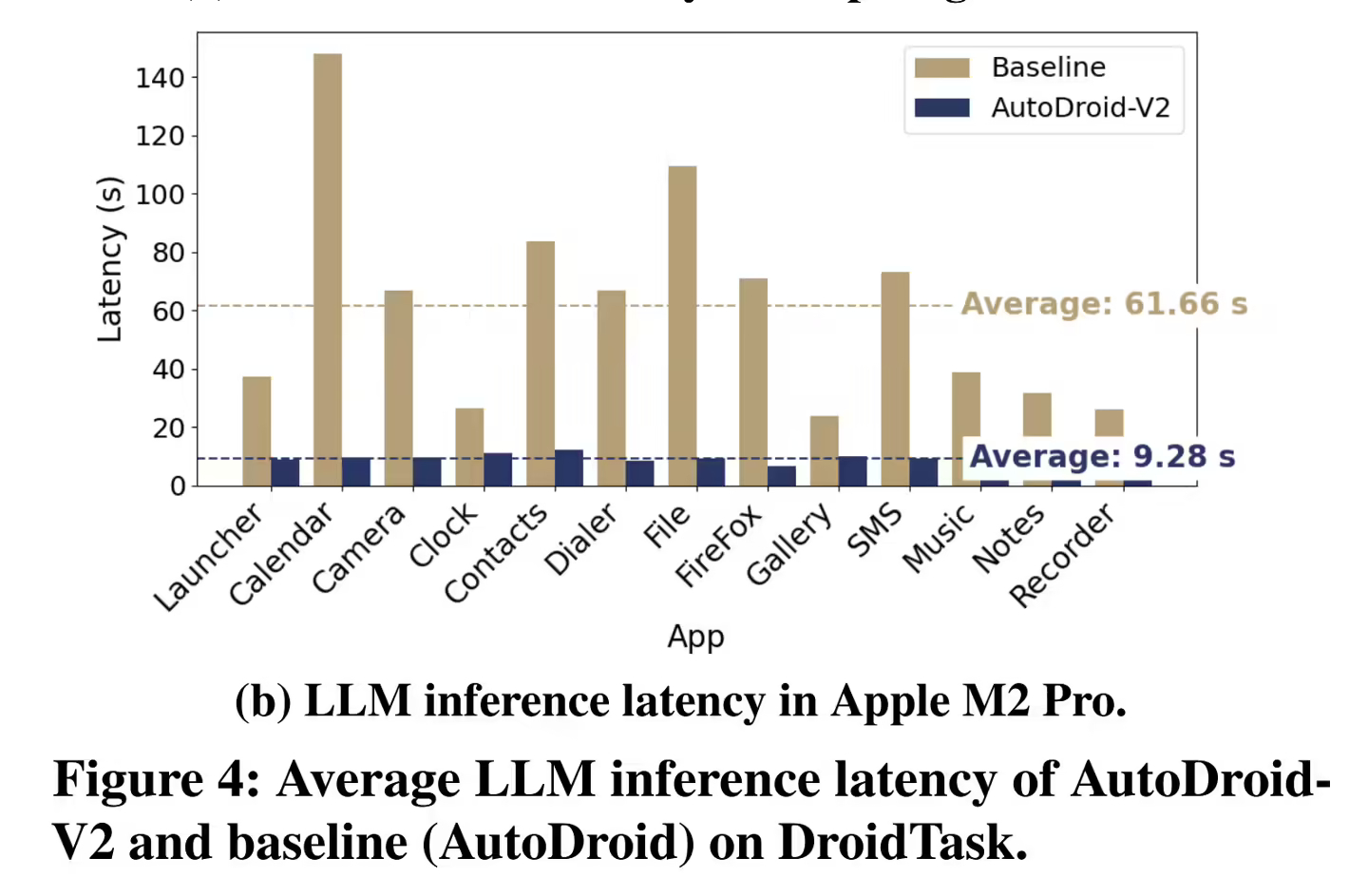

在资源消耗方面,输入和输出 token 消耗分别减少至 43.5 分之一和 5.8 分之一,LLM 推理延迟降低至 5.7~13.4 分之一。

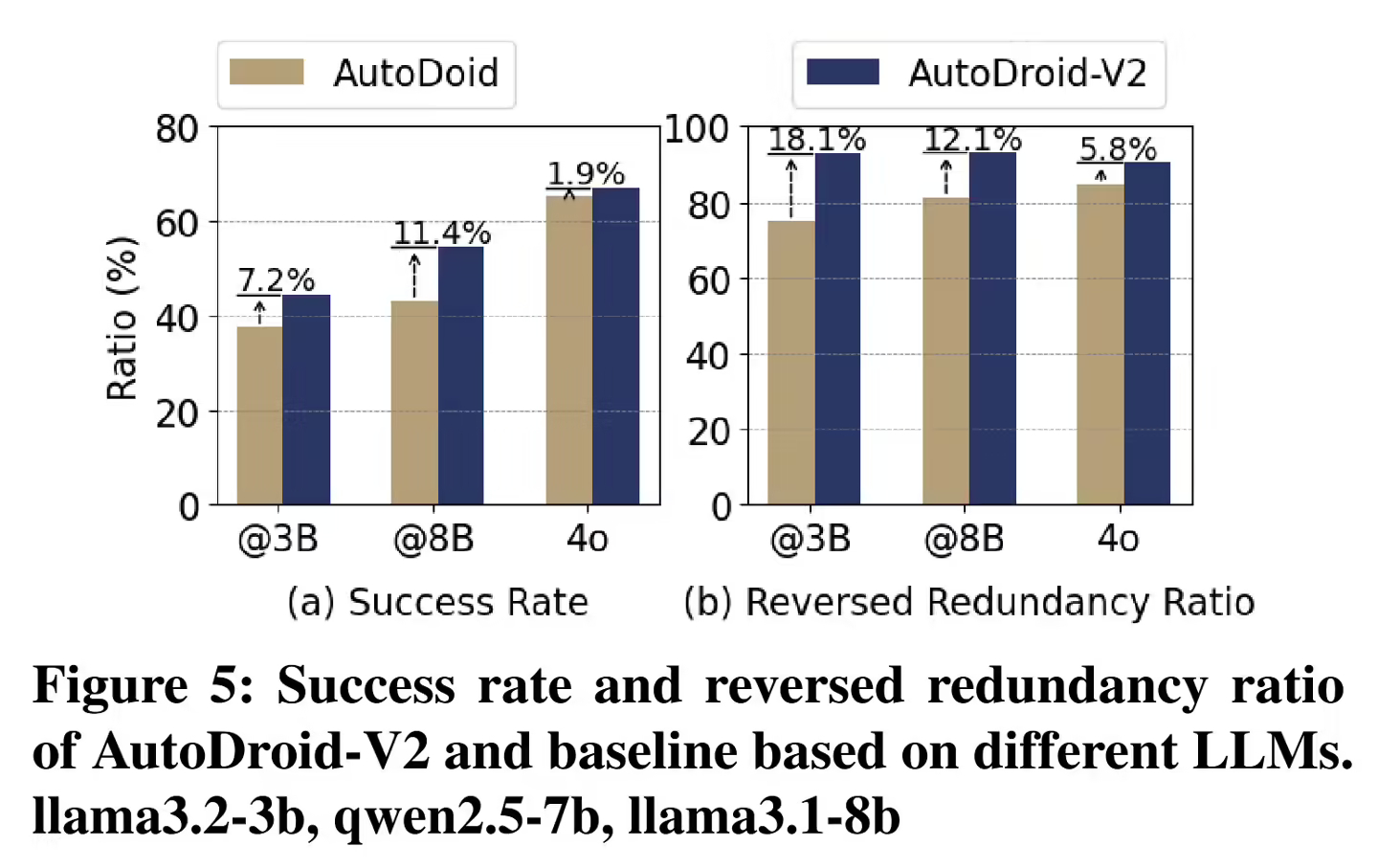

跨 LLM 测试中,在 Llama3.2-3B、Qwen2.5-7B 和 Llama3.1-8B 上表现一致,成功率 44.6%-54.4%,反向冗余比 90.5%-93.0%。

IT之家附上参考地址