写在前面&笔者的个人理解

目前,驾驶世界模型已获得了来自工业界和学术界的广泛关注,因为基于模型的搜索和规划被广泛认为是实现人类级智能的重要途径。这些模型有多种用途,包括训练数据增强、稀有场景生成。大多数当前世界模型都是通过微调现有的扩散模型来开发的,利用视频生成基础模型的泛化能力。控制信号(如文本、布局和驾驶操作)通过两种主要方法整合:扩散模型的空间特征与控制信号特征之间的交叉注意,或通道级特征调制技术。

尽管驾驶世界模型取得了非常不错的研究进展,但一个根本挑战仍然存在:在可微分框架中无缝集成世界建模和规划仍未得到很大程度的解决,从而限制了可微分模型规划的全部潜力。世界模型目前主要基于视频扩散架构,限制了它们生成多种模态(如文本和动作序列)的能力。因此,在扩散模型框架内实现驾驶规划和世界建模的真正端到端集成仍然是一项重大的技术挑战。这些限制促使我们探索能够自然处理多模态输入和输出并实现端到端可微分规划的替代架构。

与扩散模型相比,具有下一个Token预测训练目标的自回归Transformer在包括语言建模、视觉问答、图像生成、视频预测、顺序决策和机器人操作在内的广泛任务中表现出卓越的建模能力。自回归Transformer处理顺序数据和多种模态的天生能力使其特别有希望成为基于模型的集成驾驶规划器。

基于上述的讨论,在这项工作中,我们旨在利用自回归Transformer的建模能力来进行驾驶任务中的世界建模和轨迹规划,提出的算法模型称为DrivingGPT。在具有挑战性的 NAVSIM 基准上进行的实验进一步证明了所提出的多模态驾驶语言作为规划训练目标的有效性。我们的 DrivingGPT 在驾驶得分方面优于流行的带有 MLP 轨迹解码器规划器的视觉编码器。

- 论文链接:https://arxiv.org/pdf/2412.18607

网络模型结构&技术细节

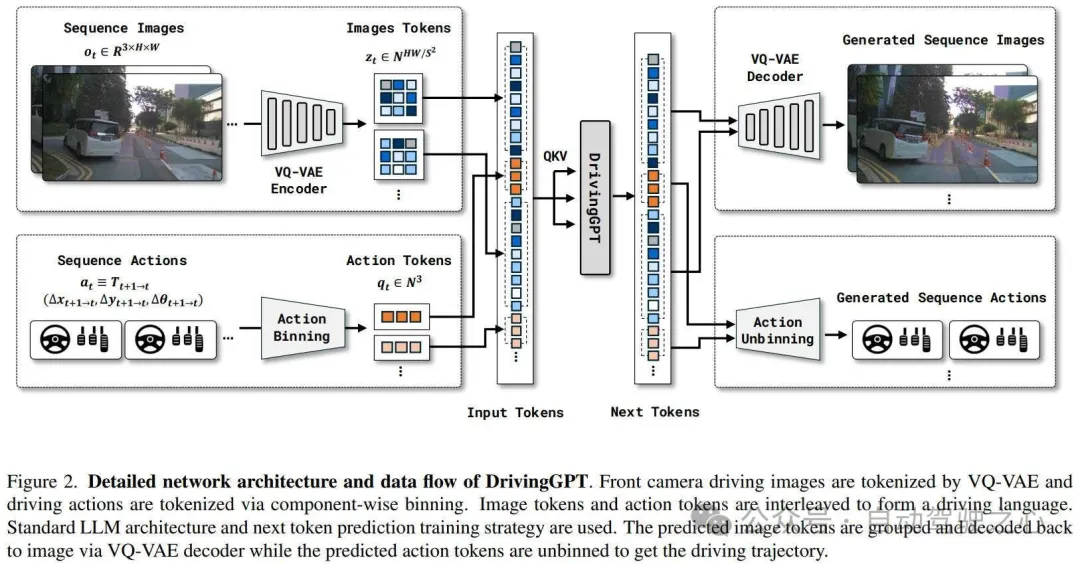

经过训练用于下一个Token预测的自回归Transformer已在不同领域展现出卓越的能力。在这项工作中,我们通过结合世界模型和轨迹规划,利用自回归Transformer的强大功能实现自动驾驶。我们的方法将视觉输入和驾驶动作转换为离散驾驶语言,从而通过自回归Transformer实现统一建模,其整体的网络结构图如下图所示。

问题表述

与许多其他任务一样,驾驶问题可以表述为马尔可夫决策过程,这是一种在具有部分随机结果的环境中做出决策的通用数学框架。MDP 包含一个状态空间,它反映了自车和环境的所有状态;一个动作空间;一个随机转换函数,它描述了给定时间的状态和动作的所有可能结果的概率分布;以及一个标量奖励函数,它决定了在特定状态下应采取的最佳动作。在大多数实际应用中,我们只能感知到噪声观测,而无法感知底层状态。因此,引入了观测概率函数,MDP 变为部分可观测的 MDP。预测未来轨迹的端到端策略和模拟驾驶世界动态的观察空间随机转换函数在自动驾驶中都非常重要。我们寻求将这两个挑战统一为一个序列建模任务。

多模态驾驶语言

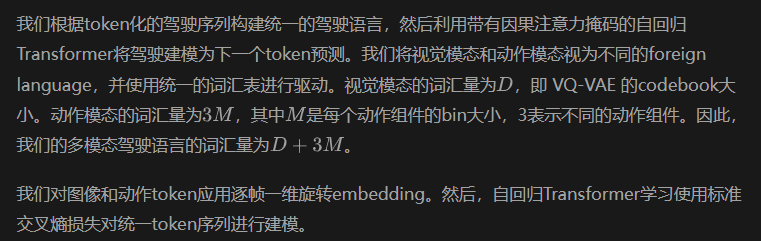

一般的驾驶序列可以表示为一系列时间同步的观察-行动对,时间范围为T。在这里,我们需要将观察和动作标记为离散token,并形成多模态驾驶语言,然后才能利用自回归Transformer进行下一个token预测。

Observation Tokenization

为了简化我们的方法,我们只将前置摄像头图像包含在观察空间中,而将更先进的传感器设置(如周围的 cemaras、LiDAR 和 IMU)留待将来探索。为了将更多帧纳入我们的序列建模,我们利用 VQ-VAE 将图像下采样为图像token。

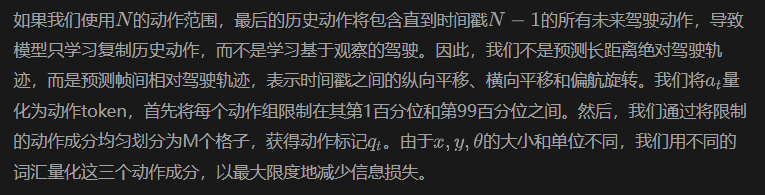

Action Tokenization

我们的方法与现有的驾驶世界建模方法的不同之处在于,它能够生成未来的驾驶行为。与大多数的端到端驾驶规划器不同,可以预测未来的整个驾驶轨迹。我们的下一个 token 预测公式的因果性质禁止我们构建具有较长动作范围的驱动序列。未来的观察和行动都从历史行动中获取了太多特权信息。

Unified Visual Action Sequence Modeling

虽然驾驶语言模型形式看起来很简单,但它明确地将驾驶世界建模和端到端驾驶作为其子任务。

Integrating Action into Trajectory

由于我们在驾驶语言中使用了帧与帧之间的相对动作,因此我们需要将它们整合起来以获得绝对驾驶轨迹。我们首先将预测的动作转换为二维变换矩阵,然后进行整合。

然后,我们通过连续乘以这些相对位姿矩阵来获得绝对位姿,并将其相应地转换回绝对动作。

实验结果&评价指标

视频生成的实验结果

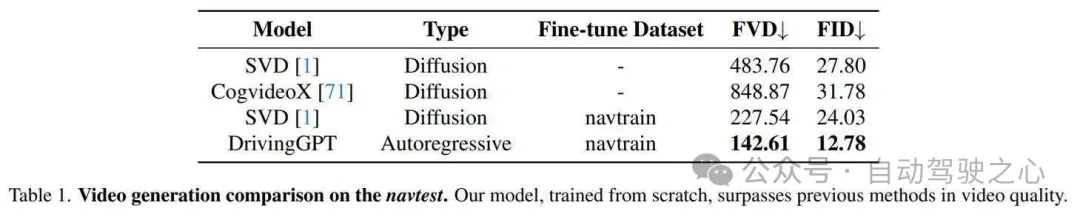

我们对navtest数据集上的几种方法进行了定量比较,相关的实验结果汇总在下表当中。

由于许多视频模型仅发布模型权重,我们将我们的方法与它们公开可用的模型进行比较。我们发现 SVD 和 CogvideoX 都倾向于产生细微的动作,这导致驾驶场景中的表现不佳。为了确保公平比较,我们在 navtrain 集上微调了 SVD 模型。以前的视频模型通常依赖于基于扩散的方法,而我们的方法是自回归视频生成的先驱。值得注意的是,我们从头开始训练的模型在视频生成质量方面超越了以前的方法。

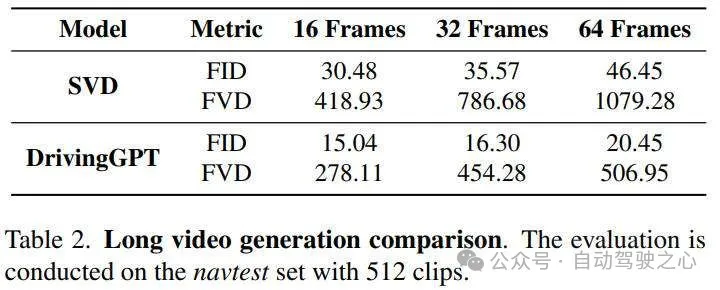

自回归模型的一个关键优势是能够通过有效利用历史信息来生成长时长视频,从而生成更连贯的视频。在这个实验中,我们从 navtest 数据集中选择了 512 个视频片段(每个片段包含超过 64 帧)进行评估。而 SVD 方法在生成较长的序列时很难保持质量,相关的实验结果如下表所示。

通过上表的实验结果可以看出,我们的方法表现出了生成高质量长期序列的卓越能力。SVD的固定帧数训练限制导致较长序列的图像和视频质量显着下降。相比之下,我们的方法始终如一地生成高质量图像并获得较低的 FVD 分数,表明性能更稳定和更优越。

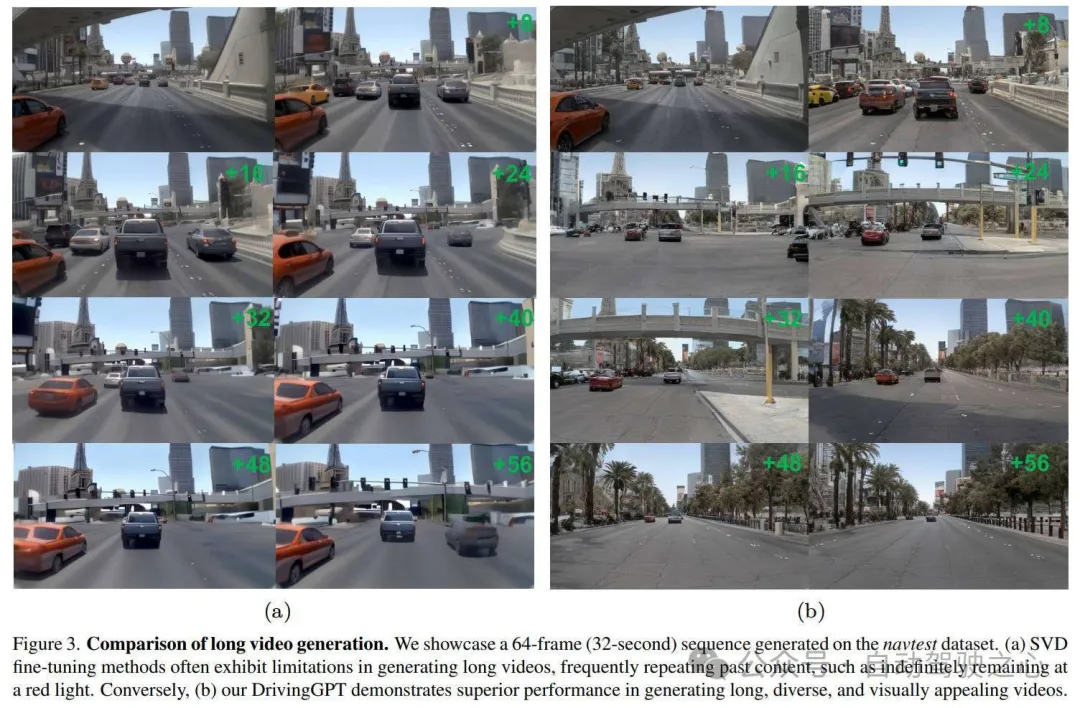

此外,与以往基于扩散的方法相比,我们的方法可以生成更加多样化和合理的场景。如下图所示,SVD 微调方法在生成较长的视频时经常会陷入重复过去内容的困境,例如长时间被困在红灯下。相比之下,自回归方法在生成长视频方面表现出显着的优势,从而显着改善了场景内容和视频质量。

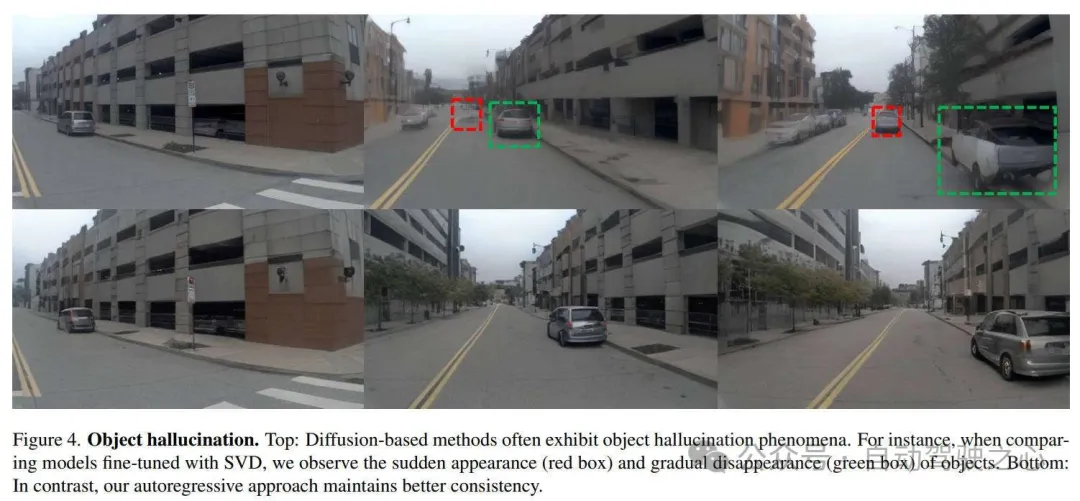

除了长视频生成之外,我们方法的另一个优势在于它能缓解物体幻觉现象。如下图所示,基于扩散的方法由于缺乏历史信息,经常会遭遇物体突然出现(红色框)和逐渐消失(绿色框)的情况。相比之下,我们的自回归方法保持了卓越的一致性。

端到端规划的实验结果

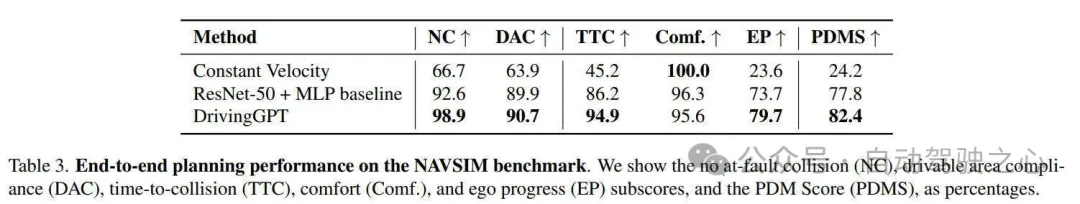

我们的 DrivingGPT 能够联合预测未来图像和驾驶行为,从而实现端到端的规划性能评估。为了严格评估我们的规划器的性能,我们选择了更具挑战性的 NAVSIM 基准,该基准旨在提供比以前的 nuScenes 和 nuPlan 基准更多样化的驾驶操作。此外,鉴于最近关于使用自车状态将为规划者提供过多特权信息的讨论,我们故意选择将其排除在我们的驾驶语言之外。按照 NAVSIM 设置,我们根据过去 2 秒的观察和行动来预测未来 4 秒的轨迹。相关的实验结果如下表所示。

与恒定速度和恒定速度恒定偏航率的基线相比,我们提出的 DrivingGPT 实现了不俗的表现性能。此外,我们的 DrivingGPT 与使用 ResNet-50 视觉编码器和 MLP 轨迹解码器实现的简单但可靠的端到端规划器基线相比更具优势。该基线仅使用前置摄像头图像,也不使用自车状态。考虑到我们提出的 DrivingGPT 只能通过重建驾驶环境的高度压缩图像token来学习表示,结果突出了联合学习世界建模和给定规划的潜力。下图展示了我们提出的DrivingGPT 在具有挑战性的驾驶场景下生成的轨迹。

消融实验分析

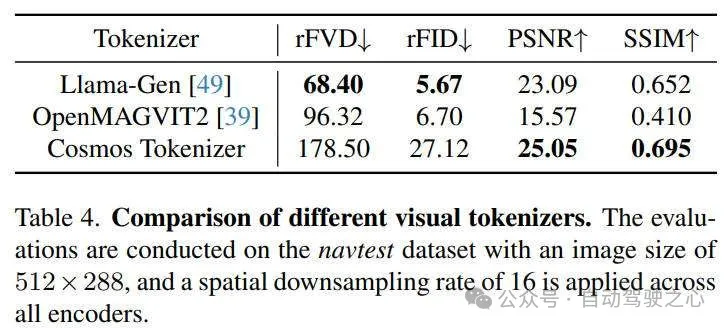

如下表所示,视觉标记器的质量显著影响世界模型视觉预测质量的上限。我们在navtest数据集上评估了几种最先进的离散视觉标记器,该数据集包含 12,146 个视频样本。根据我们的评估,我们选择 Llama-Gen 作为我们世界模型的最佳视觉标记器。

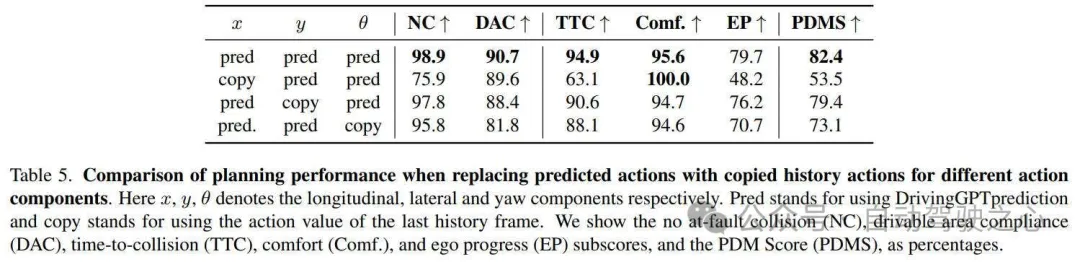

此外,自回归Transformer是众所周知的强大拟合机器。因此,我们试图回答一个问题:DrivingGPT 是否真正学会了驾驶,还是只是通过复制或推断历史驾驶动作来偷工减料。我们逐渐用仅从历史动作估计的未来动作替换 DrivingGPT 的预测动作。我们只是复制最后的历史动作,因为一般的驾驶轨迹不涉及任何动作输入变化。相关的实验结果如下表所示。

我们的 DrivingGPT 始终优于所有简单复制横向、纵向和历史动作的变体。可能会注意到,复制之前的纵向动作会产生最差的规划结果,这是因为 NAVSIM 基准包含许多场景,其中自车刚刚开始从停止和启动加速。实验结果表明,我们的 DrivingGPT 真正学会了如何驾驶,而不仅仅是复制历史动作。

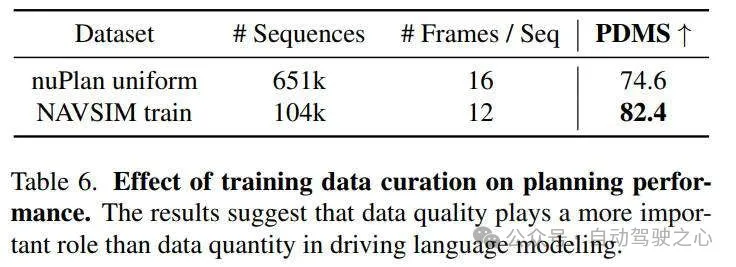

同时,我们发现数据质量在语言建模等其他任务上训练自回归Transformer时起着核心作用。因此,我们研究驱动数据质量和数量对端到端规划性能的影响,相关的实验结果如下表所示。

使用NAVSIM等高质量数据训练的模型(仅包含 100k 个驾驶序列)优于使用 650k 个 nuPlan 驾驶序列训练的模型。结果表明,在驾驶语言建模中,数据质量比数据数量更重要。

结论

在本文中,我们提出了一种新颖的多模态驾驶语言,该语言有效地将视觉世界建模和轨迹规划统一到序列建模任务中。我们设计的算法框架称为DrivingGPT,可以联合学习为这两个任务生成图像和动作token。在nuPlan 和 NAVSIM 基准上进行的实验和消融研究证明了所提出的 DrivingGPT 在动作条件视频生成和端到端规划方面的有效性。