英伟达老黄,成了今年的圣诞老黄。

AI芯片大礼包刚刚曝光:

GPU新核弹B300,以及附带CPU的超级芯片GB300。

高算力,在产品层面上相比B200在FLOPS上提高50%

大显存,从192GB提升到288GB,也是提高了50%。

△Grok AI绘图

△Grok AI绘图

包含72块GB300的“新一代计算单元”GB300 NVL72,更是被评价为“能让OpenAI o1/o3推理大模型的思维链长度,在高batch size下达到10万tokens的唯一方案”。

这与今年3月份“AI春晚”发布的B200系列只隔了几个月。

根据SemiAnalysis爆料,从第三季度开始,许多AI巨头已经将订单从B200转移到了B300(只有微软还在第四季度继续购买了部分B200)。

有不少网友感叹,更新速度实在太快了!

既是解决了此前传闻中B200因设计缺陷被迫推迟的问题,又是对隔壁AMD MI300系列后续产品将在2025年提升显存容量的回应。

又一款AI核弹

既然都是Blackwell架构没有跨代,B300的算力提高来自哪里呢?

根据这次爆料,主要有三部分:

- 工艺节点,与B200使用同样的台积电4NP,但是全新流片

- 增加功率,GB300和B300 HGX的TDP分别达到1.4KW、1.2KW,相比之下B200系列分别提高0.2KW

- 架构微创新,例如在CPU和GPU之间动态分配功率

除了更高FLOPS之外,B300系列的显存也做了升级:

- 从8层堆叠的HBM3E升级到12层(12-Hi HBM3E)

- 显存容量从192GB升级到288GB

- 显存带宽保持不变,仍为8TB/s

此外产品交付层面还有一个大变化:

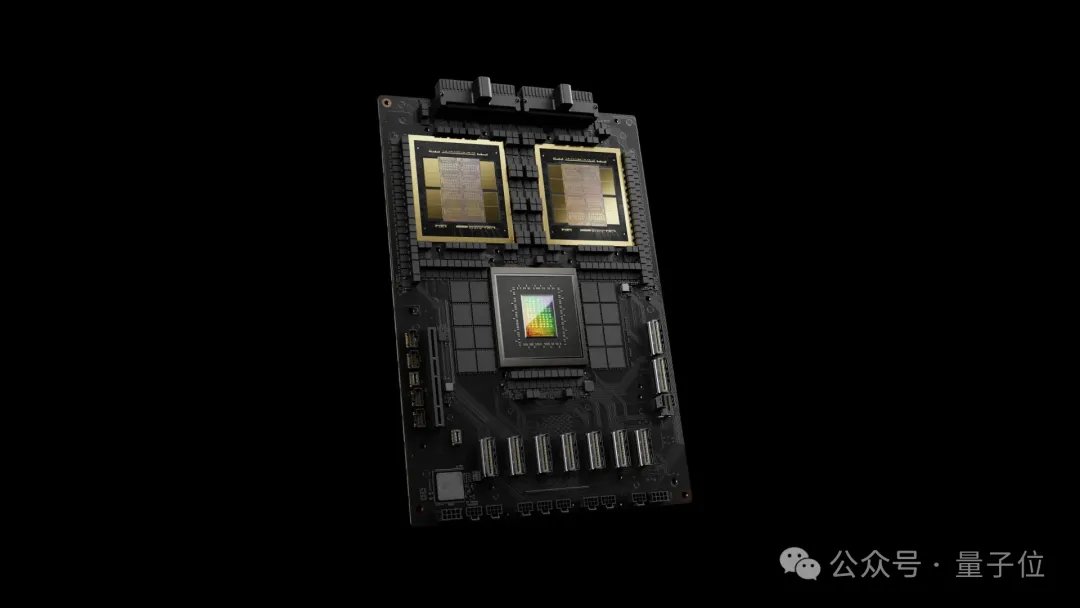

GB200系列提供整个Bianca Board,也就包括两颗GPU、一颗CPU、CPU的内存等所有组件都集成在一块PCB版上。

△GB200概念图

△GB200概念图

GB300系列将只提供参考板(Reference Board),包括两颗B300 GPU、一颗Grace CPU、HMC(Hybrid Memory Cube),LPCAMM内存模块等组件将由客户自行采购。

这给供应链上的OEM和ODM制造商带来了新的机会。

为推理大模型打造

显存的升级对OpenAI o1/o3一类的推理大模型至关重要,因为推理思维链长度会增加KVCache,影响batch size和延迟。

以一个GB300 NVL72“计算单元”为单位考虑时,它使72个GPU能够以极低的延迟处理相同的问题,并共享显存。

在此基础上从GB200升级到GB300,还可以带来许多好处:

- 每个思维链的延迟更低

- 实现更长的思维链

- 降低推理成本

- 处理同一问题时,可以搜索更多样本,最终提高模型能力

为了解释这些提升,SemiAnalysis举了个更为直观的例子。

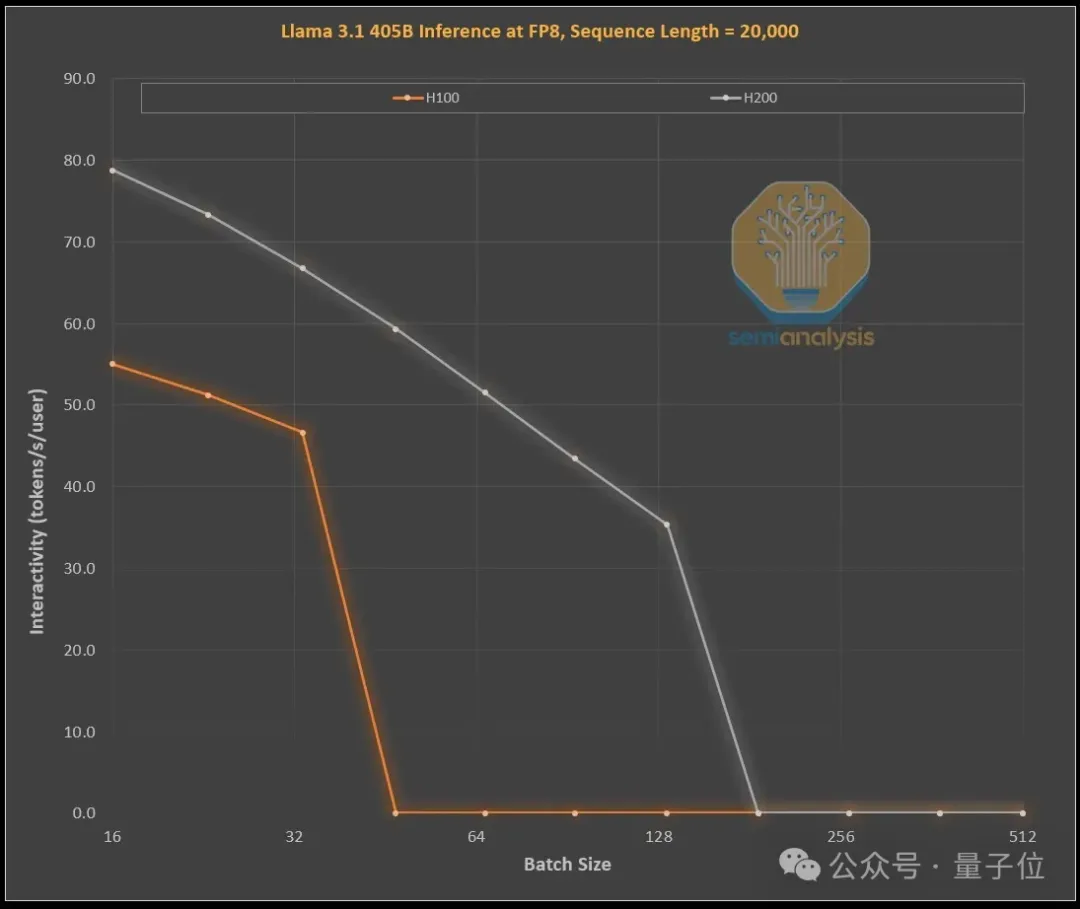

下图是在不同批处理大小下,使用H100和H200两种GPU处理长序列时,Llama 3.1 405B在FP8精度下的处理速度。

输入设置为1000个token、输出19000个token,由此模拟OpenAI o1和o3模型中的思维链。

从H100升级到H200,有两个显著改进。

一是在所有可比较的batch size中,H200的内存带宽更大(H200 4.8TB/s,H100 3.35TB/s),从而使得处理效率普遍提高了43%。

二是H200可运行更高的batch size,这使得其每秒可以生成的token数量增加了3倍,相应地,成本也减少了约3倍。

内存增加所带来的效益远不止表面上的这些。

众所周知,推理模型响应时间一般更长,显著缩短推理时间可以提高用户体验和使用频率。

而且内存升级实现3倍性能提升,成本减少3倍,这一提升速度也远超摩尔定律。

除此之外,SemiAnalysis还分析观察到,能力更强和具有明显差异化的模型能收取更高的溢价——

前沿模型毛利率超70%,而还在与开源模型竞争的次一级模型毛利率不足20%。

当然,英伟达并不是唯一一家能增加内存的芯片公司,但奈何英伟达还有杀手锏NVLink。

One More Thing

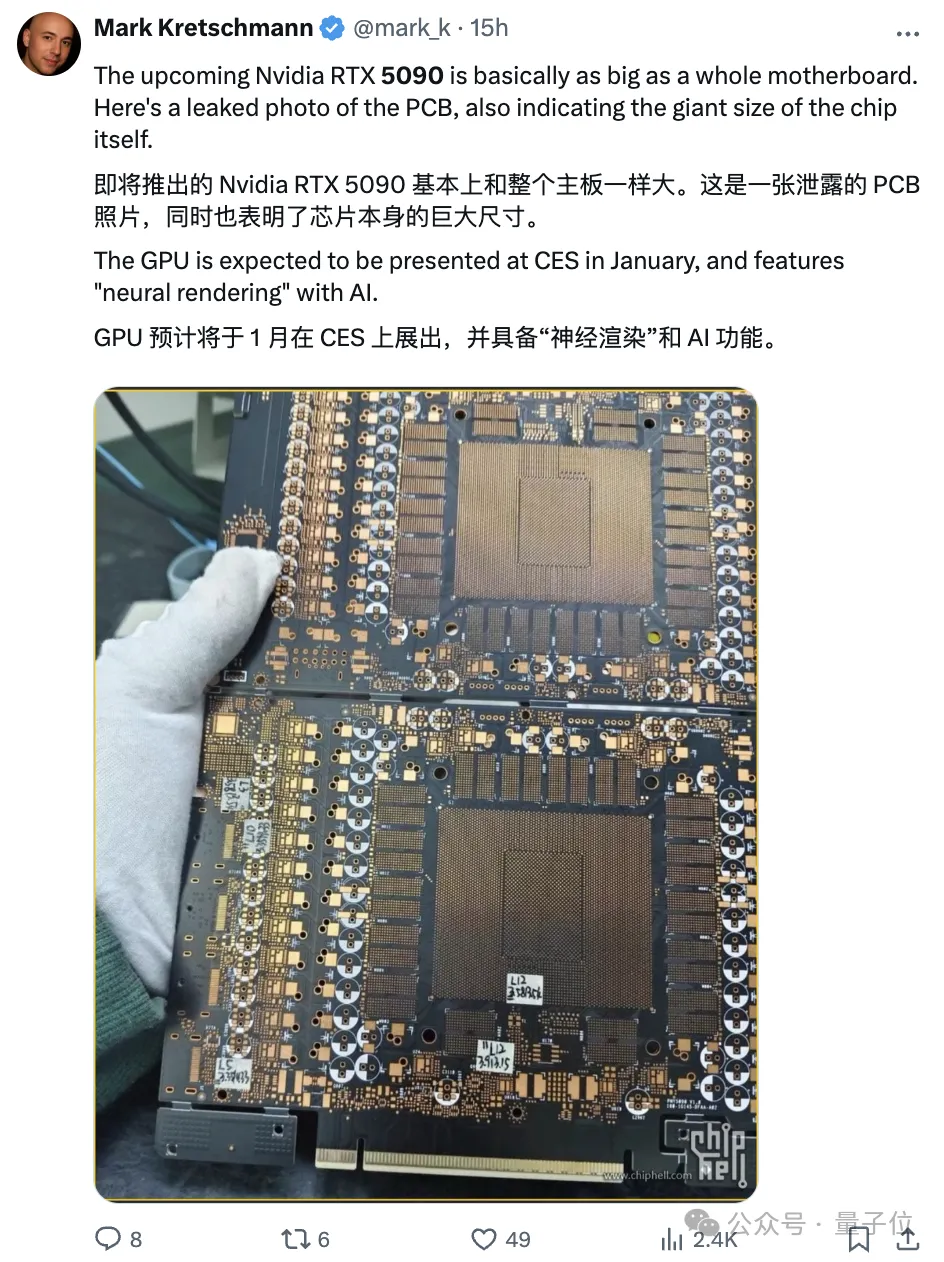

英伟达消费级显卡方面,RTX5090的PCB板也首次曝光了~

就在昨天,一张RTX 5090 PCB照片在网上疯转。

特点就是超超超大号。

结合此前爆料称5090有可能会配备32GB大显存,有望支持8K超高清游戏,实现60fps的流畅游戏体验。

网友们直接坐不住。

关于5090的发布时间,大伙儿猜测大概会是1月6日老黄CES演讲的时候。

参考链接:

[1]https://semianalysis.com/2024/12/25/nvidias-christmas-present-gb300-b300-reasoning-inference-amazon-memory-supply-chain/。

[2]https://x.com/mark_k/status/1871864813913330003。

[3]https://www.gamesradar.com/platforms/pc-gaming/rtx-5090-will-seemingly-come-armed-with-32gb-vram-and-id-be-surprised-if-8k-gaming-isnt-a-thing-this-generation/。