o3在超难推理任务ARC-AGI上的成绩,属实给人类带来了不少震撼。

但有人专门研究了它不会做的题之后,有了更有趣的发现——

o3之所以不会做这些题,原因可能不是因为太难,而是题目的规模太大了。

来自英国的ML工程师Mikel Bober-Irizar(不妨叫他米哥),对ARC题目进行了细致观察。

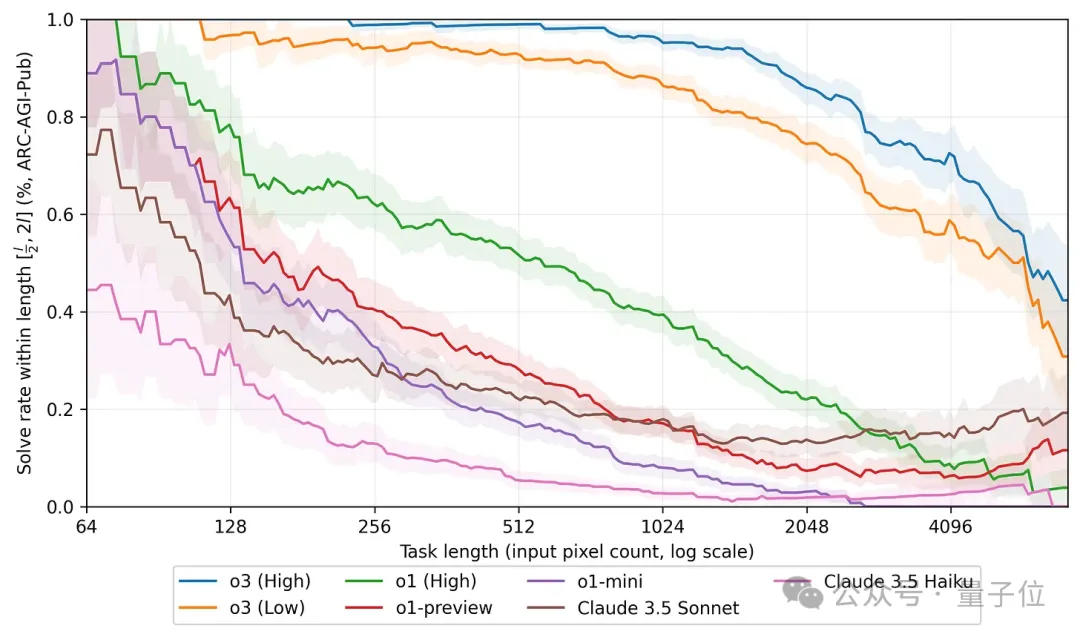

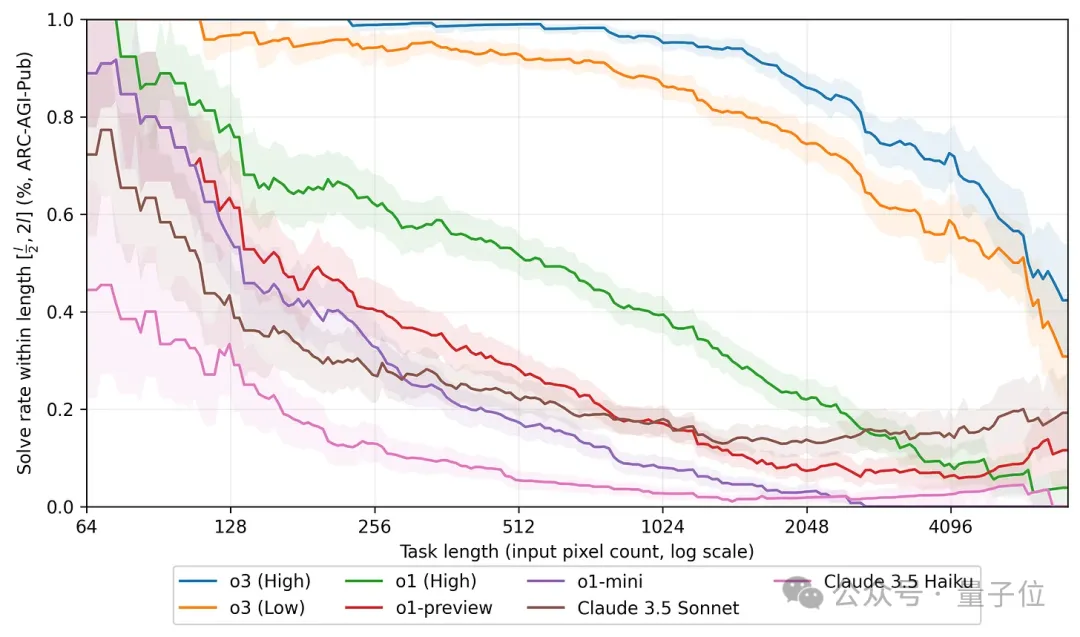

结果米哥发现,题目中的网格规模越大,大模型的表现也就越差。

而且不仅是o3,o1和o1 mini,还有隔壁的Claude,都出现了这样的现象。

米哥的这项研究,引起了人们对大模型工作机制的许多讨论。

世界首位全职提示词工程师Riley Goodside看到后,也认为这是一项很好的研究。

大模型被困在了网格规模上

还是先简单回顾一下ARC挑战,题目带有色块的网格阵列(以文本形式表述,用数字代表颜色),大模型需要观察每道题目中3个输入-输出示例,然后根据规律填充新的空白网格。

米哥发现,在ARC挑战中,规模越大,也就是网格的数量越多,大模型的表现也就越差。

o3也逃不过这样的魔咒,但相比于其他模型,o3表现的明显下降出现得更晚,大约在网格数量达到1024个之后(请记住这个位置,后面还会讲到)。

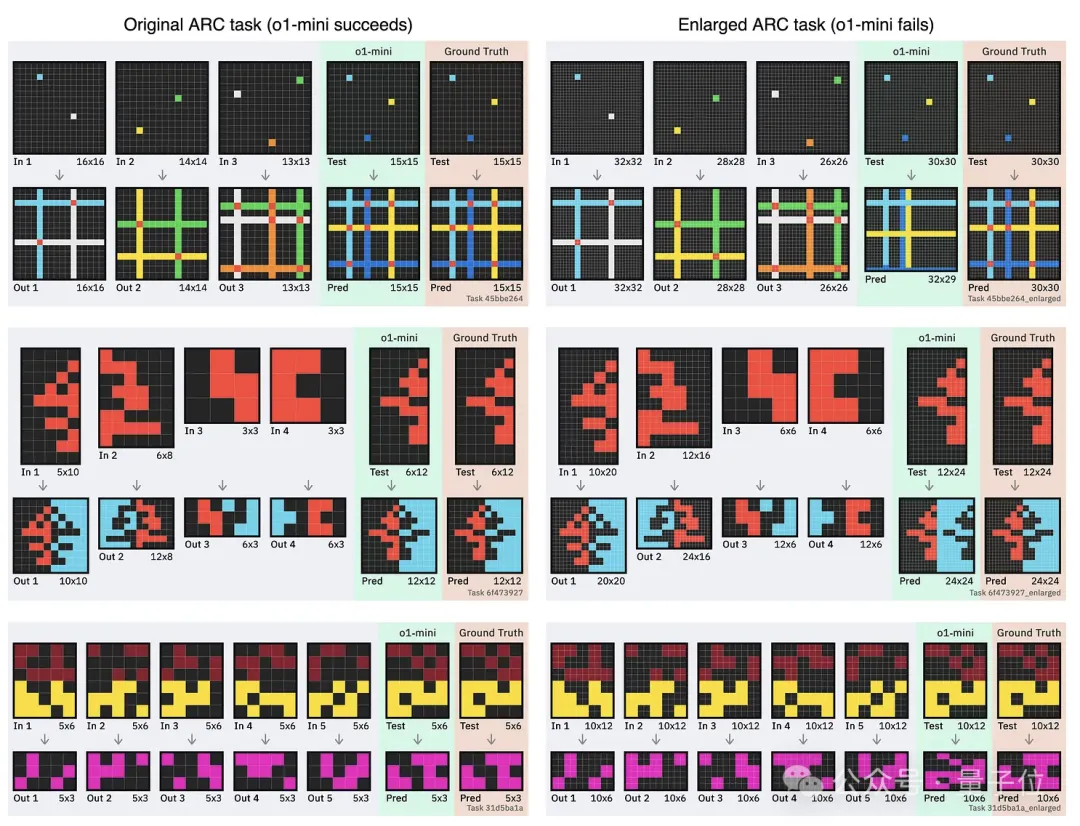

为了进一步验证这个发现,米哥还用o1-mini进行了实际测试。

下图当中,左右两栏的题目乍一看上去好像没什么区别,但在右边,米哥对网格进行了细粒度的切割,原来的一个格子被切成了4(2×2)个。

结果原来能做对的题,切成小块之后,o1-mini还真就不灵了。

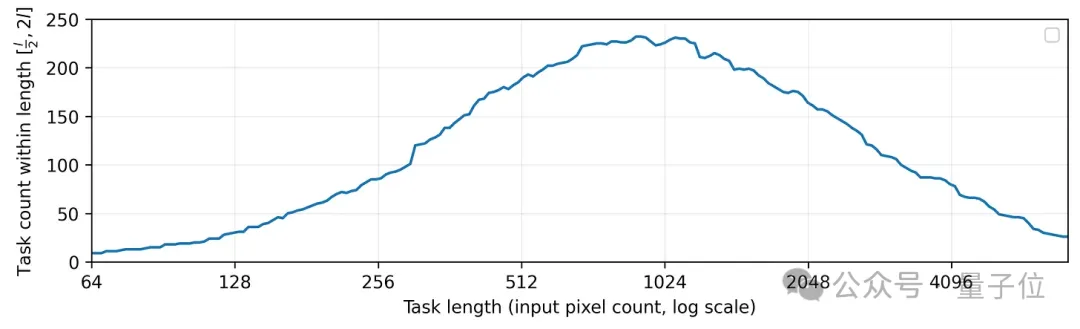

进一步地,米哥还对ARC数据集中的规模分布进行了统计,结果刚好是规模在1024个像素的题目数量最多。

还记得前面o3成绩下降趋势突然变大的位置吧,刚好就是在1024附近。

米哥认为,这就是o3在ARC挑战上取得优异成绩的重要因素,而其他模型成绩不佳,是因为对应的小规模试题占比较少。

所以在米哥看来,ARC挑战并不能完全反映大模型真实的推理能力——有不少模型都被低估,o3则是被高估了。

ARC挑战不适合大模型?

那么,为什么题目中网格数量一多,大模型的表现就不好了呢?

先来看米哥的分析。

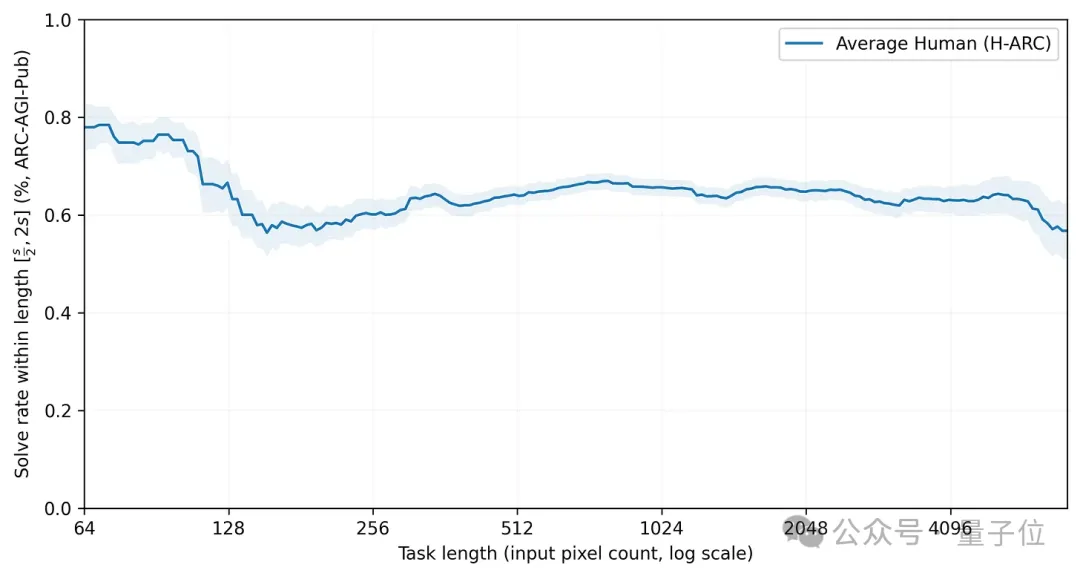

米哥引用了纽约大学的一项研究结果(arXiv:2409.01374),这项研究发现人类在挑战这样的问题时并不会出现这种现象。

如果在人类和模型之间做个比较,那么在规模较小时o3的表现可以说完胜人类,但规模较大时优胜方就变成了人类。

这说明,大模型在解决此类问题时,思考方式和人类依然存在差别。

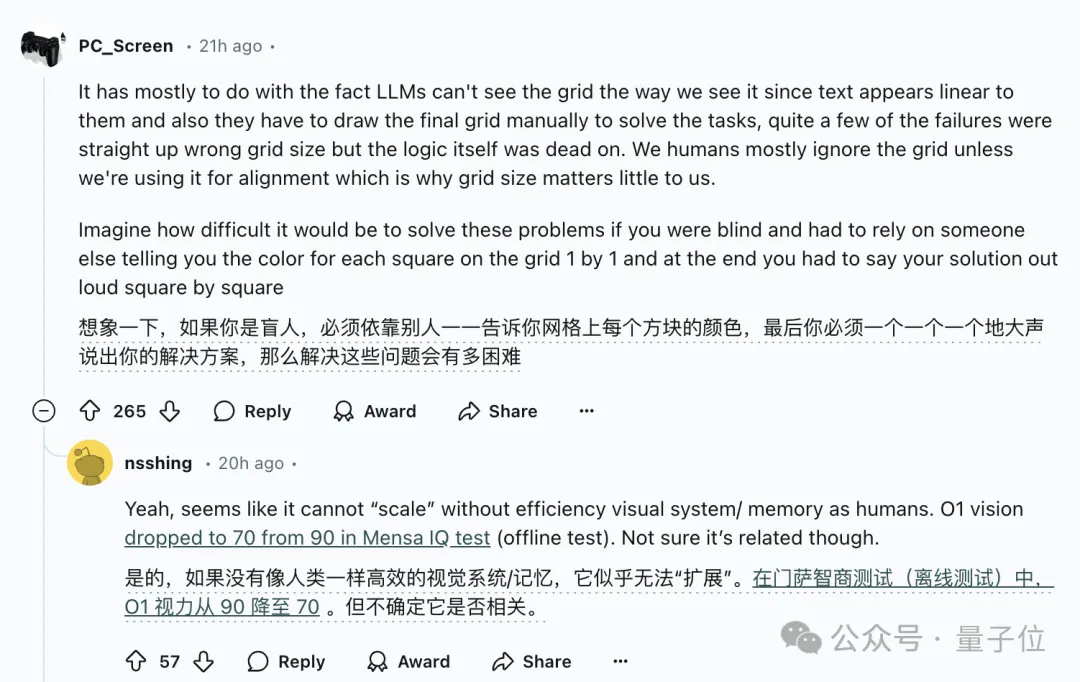

当然,大模型在挑战ARC时看到的不是图像,而是用数字代表的矩阵,这是显而易见的,但差别还不止于此。

人类在面对ARC问题时,即使是用这种数字矩阵来表示,也能够看出视觉信息,理解其中的位置关系。

在空间中,ARC是一个二维问题,需要跨行和列进行推理,但大模型在处理token时是以一维格式进行的。

这意味着,大模型进行跨列推理时,需要组合较长的上下文信息。

而随着网格变得更大,模型需要对更长的上下文进行推理,并且必须对相距较远的数字进行组合和推理。

米哥之前曾经和剑桥大学高级研究员Soumya Banerjee此前进行的一项研究(arXiv:2402.03507)表明,通过对矩阵进行90度旋转,让模型分别基于行和列进行推理,比直接做题成绩提高了一倍。

所以米哥认为,是观察问题的维度影响了大模型的成绩,ARC这种任务并不适合大模型。

他还表示在NeurIPS上听到了一个很好的类比——

将二维的ARC任务交给大模型,就像期望人类在四维空间中进行推理。

同时网友们还指出,虽然本质上涉及了维度差异,但视觉依然是一个重要因素。

想象一下,如果人没有视觉能力,单纯依靠听或其他方式获得关于其中网格的信息,也很难直接构建出二维的矩阵。

不过说到这,即便模型拥有“视觉”能力,也是将视觉信息转换为Token,和人类的视觉也未必相同。

网友认为,真正的视觉需要能够处理并行输入的信息,而不是逐个Token的串行输入,二进制IO数据流或许是一种解决方案。

One More Thing

根据ARC挑战官方的说法,ARC-AGI的下一代ARC-AGI-2即将推出。

早期测试表明,其将对o3构成重大挑战——

即使在高计算量模式下,o3的得分也可能会降低到30%以下(而聪明人仍然能够得分超过95%)。