今天要跟大家分享一个来自Meta AI的重磅消息:他们开发了一种全新的语言模型——大型概念模型(LCM),它有可能会彻底改变我们对语言模型的理解!

现在市面上的语言模型,比如大家熟悉的GPT,虽然能写诗、写代码、聊天,但它们本质上还是一个字一个字地“猜”出来的。想象一下,就像一个只会背诵但不懂意思的鹦鹉,虽然能流利地说话,但缺乏真正的理解。LCM的出现,就是要打破这个局面

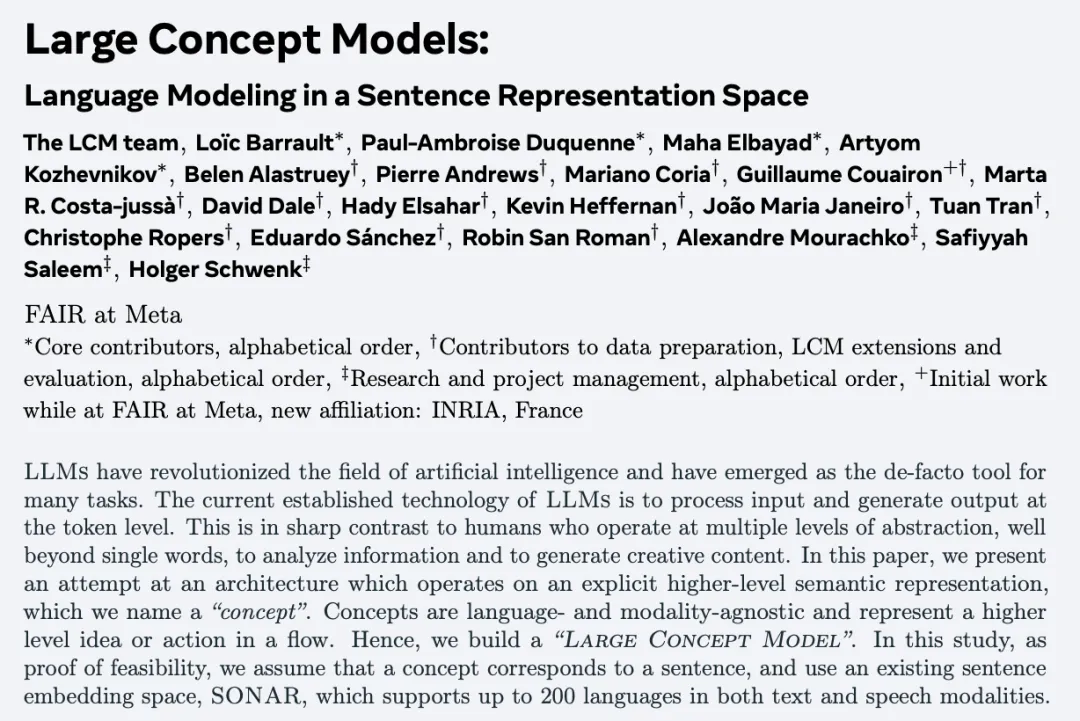

LCM的核心在于它不再执着于预测下一个词,而是在更高的语义层级——“概念”上进行思考。它把句子看作一个概念单元,并用一种叫做SONAR的句子嵌入技术来表示这些概念。这意味着LCM处理的不再是单个的词语,而是整句话的含义

Meta整的新活,我们来看看究竟是什么

核心创新:概念空间中的语言建模

LCM的最大特点在于,它不再像传统语言模型那样逐词预测,而是在句子表征空间中进行建模。这意味着,LCM将句子视为一个概念单元,并利用句子嵌入(sentence embeddings)来表示这些概念。LCM的目标是预测下一个句子的嵌入向量,也就是下一个“概念”。这种方法能够更好地捕捉文本的整体语义结构,使模型能够在更高的抽象层面上进行推理

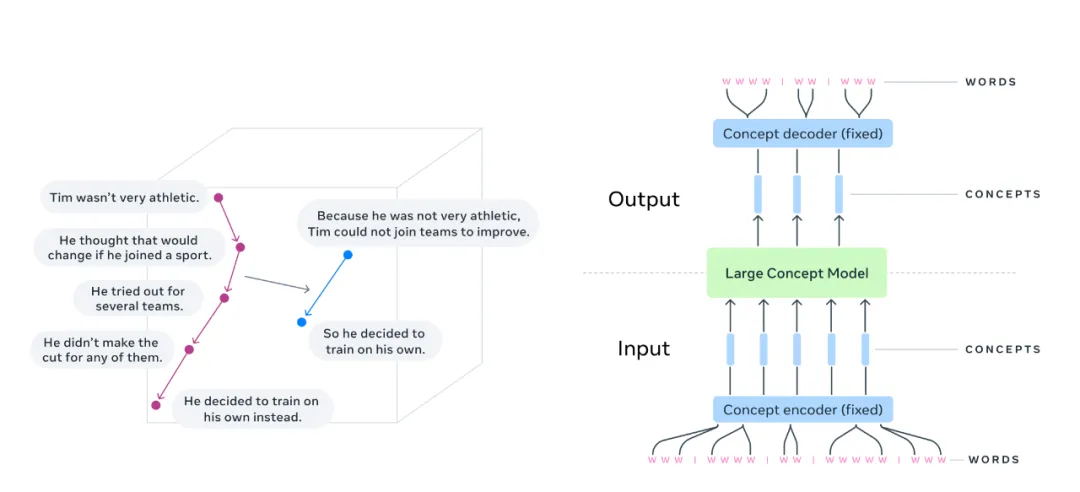

SONAR:LCM的基石

LCM的核心组件是句子嵌入模型SONAR。SONAR是一个强大的多语言、多模态句子表征模型,支持超过200种语言和语音输入。LCM在SONAR嵌入空间中进行操作,这意味着LCM的输入和输出都是SONAR嵌入向量,而不是离散的词语。这种基于连续向量空间的建模方式,为LCM带来了诸多优势,例如:

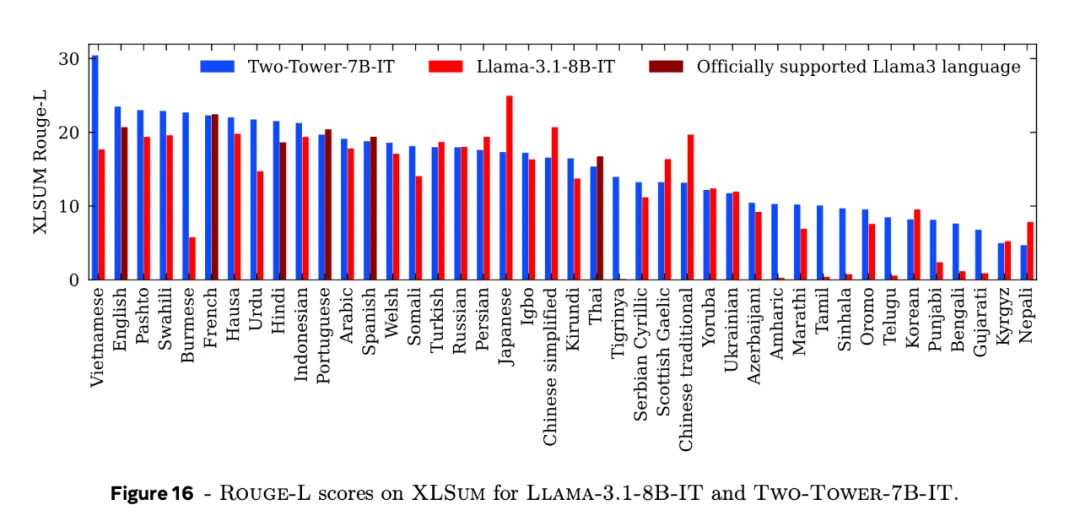

• 跨语言泛化: 由于SONAR本身的多语言特性,LCM可以在未经专门训练的情况下处理不同语言的文本

• 多模态融合: SONAR支持语音输入,未来还可以扩展到图像和视频等其他模态,为LCM的多模态应用奠定了基础

• 语义相似度计算: 在SONAR嵌入空间中,可以直接计算句子之间的语义相似度,这对于文本摘要、信息检索等任务非常重要

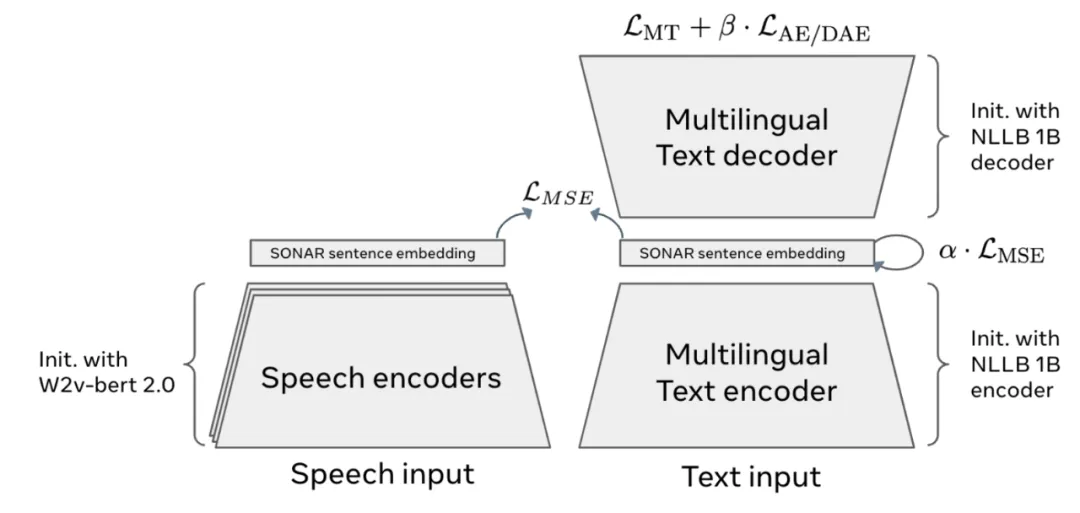

LCM架构的多样性:从基础模型到扩散模型

为了探索在SONAR空间中进行语言建模的最佳实践,Meta AI的研究人员设计了多种LCM架构变体:

1. Base-LCM: 这是一个基于Transformer解码器的基础模型。它将前一个句子的SONAR嵌入作为输入,并预测下一个句子的嵌入。这种架构简单直接,易于理解和实现

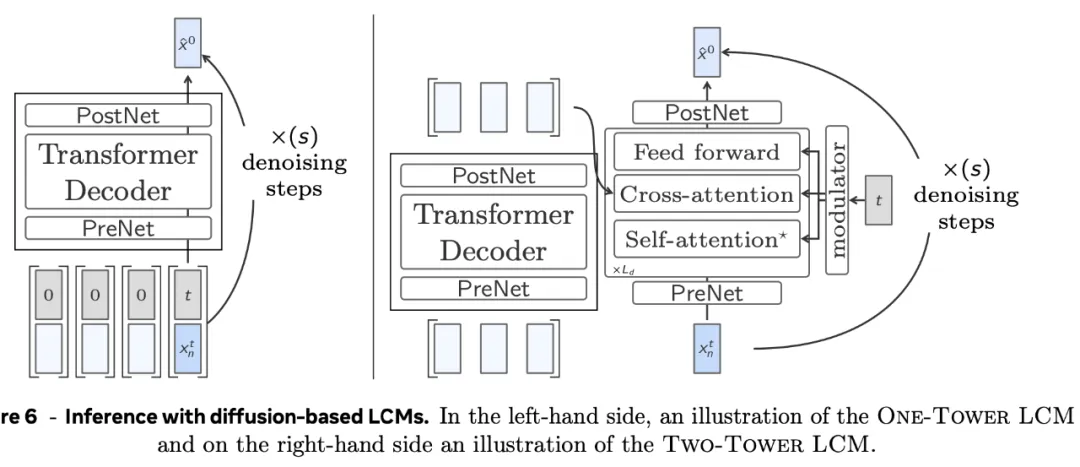

2. One-Tower Diffusion LCM: 该模型引入了扩散模型(Diffusion Model)的思想,通过逐步添加噪声然后去噪的方式来生成下一个句子的嵌入。这种方法可以生成更具多样性和创造性的文本

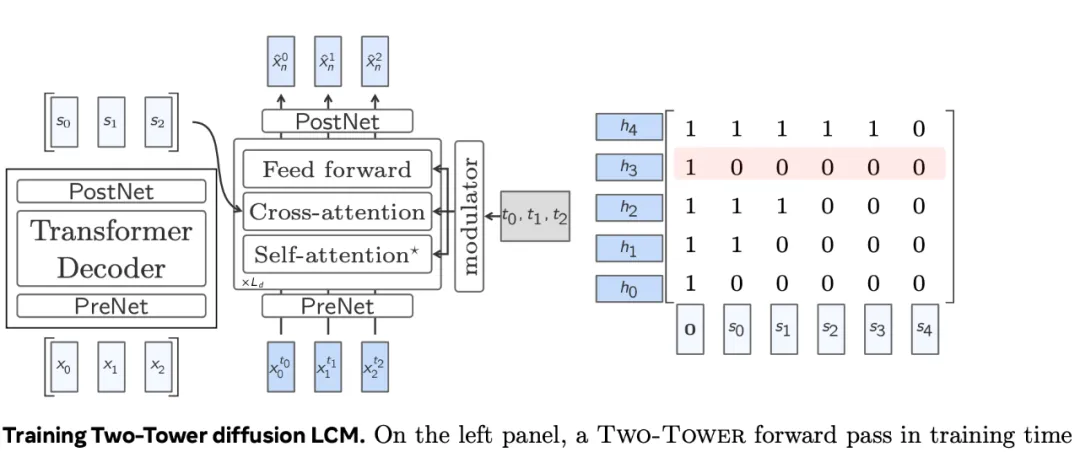

3. Two-Tower Diffusion LCM: 该模型将编码器和解码器分离,编码器负责处理上下文信息,解码器负责生成下一个句子的嵌入。这种架构更类似于传统的序列到序列模型,可以更好地捕捉长距离依赖关系

4. Quant-LCM: 为了提高计算效率,该模型对SONAR空间进行量化,将连续的嵌入向量转换为离散的码本。这种方法可以在不损失太多性能的情况下显著降低计算成本

训练与评估:30亿文档的庞大数据集

LCM在包含30亿个文档的庞大数据集上进行了预训练,这保证了模型的泛化能力。研究人员使用多种指标对LCM进行了评估,包括:

• 预训练评估: 使用L2距离、Round-trip L2距离、对比准确率、互信息等指标,评估模型在SONAR空间中预测下一个句子嵌入的准确性

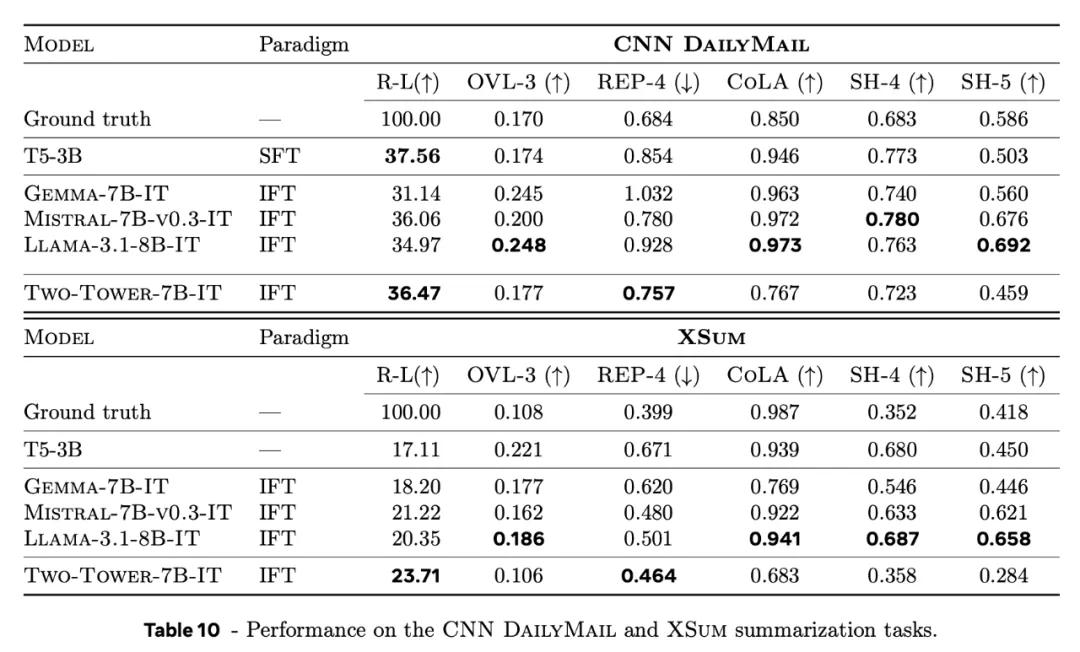

• 摘要生成: 使用ROUGE、OVL、BEP-1、CoLA等指标,评估模型生成摘要的质量

• 长上下文摘要: 评估模型在处理长文本时的性能

• 文本扩展: 评估模型扩展文本的能力

• 零样本跨语言泛化: 评估模型在未经专门训练的情况下处理不同语言文本的能力

实验结果:超越传统LLM的性能

实验结果表明,LCM在多项任务上取得了令人瞩目的成绩,尤其是在处理长上下文信息和跨语言泛化方面,表现优于传统的LLM。这证明了LCM在概念层级进行语言建模的有效性

概念层级建模的无限可能

LCM的出现,为语言模型的研究开辟了一个全新的方向。未来,可以进一步探索以下方向:

• 更丰富的概念表征: 探索结合句法、语义、知识等信息的更丰富的概念表征方式

• 更精细的句子分割: 研究更精细的句子分割技术,以更好地处理复杂的文本结构

• 更高效的训练和推理算法: 开发更高效的训练和推理算法,降低计算成本,提高模型的实用性

• 更广泛的应用场景: 探索LCM在问答、机器翻译、对话系统等更多自然语言处理任务中的应用

LCM的局限性

虽然LCM展现了巨大的潜力,但也存在一些局限性:

• 对SONAR的依赖: LCM的性能很大程度上依赖于SONAR嵌入的质量。

• 句子分割的挑战: 准确的句子分割对于LCM至关重要,但目前的技术还无法完美地处理所有情况

• 概念粒度的选择: 如何选择合适的概念粒度是一个开放性问题