写在前面&笔者的个人理解

近年来,随着自动驾驶在感知、预测和规划方面取得的重大进步,端到端算法网络也取得了重大进展。随着现如今这些技术的飞速进步,自动驾驶汽车的全面测试和验证也变得越来越重要。然而,真实世界的车辆测试仍然耗时、费用昂贵,并且场景的覆盖范围也非常有限。

现在,主流研究越来越依赖仿真软件进行广泛的算法测试和验证。然而,基于 3D 建模的仿真难以准确复制真实的驾驶场景,从而导致合成环境与现实世界之间存在巨大的差距。为了解决这个问题,当前的自动驾驶测试解决方案力求构建高度逼真的场景来验证驾驶算法。随着文本到图像和文本到视频生成模型的快速发展,一些研究集中于生成轨迹可控的图像或视频来模拟自动驾驶场景,并以地图和周围车辆位姿为指导,以提高场景的准确性。然而,现实世界的驾驶涉及不断移动的行人、车辆和物体,这些都会给环境带来结构性的变化。视频生成方法通常难以捕捉这些动态变化或元素之间的密切相互作用,从而导致场景连续性不一致,例如背景和车辆类型变化,这使保持时序一致性变得非常复杂。

最近,基于 NeRF 和 3DGS 的方法旨在通过渲染和建模 3D 场景来更精确地捕捉动态元素。尽管如此,这些方法在从任意视角重建 4D 场景、处理具有显著相机移动的广泛动态视图变化以及管理静态视图下的长期时序变换方面仍然面临挑战。

针对上述提到的相关挑战,为了实现更真实的自动驾驶测试,我们提出了一个基于真实世界自动驾驶场景的可控 4D 模拟框架,称之为Stag-1。

经过大量的多级场景训练后,我们提出的Stag-1可以从任何需要的视角进行仿真,并且可以在静态的时间和空间条件下实现对于场景演变的深入理解。与现有方法相比,我们的方法在多视角场景一致性、背景连贯性和准确性方面表现出色,并为现实自动驾驶模拟的持续进步做出了贡献。

论文链接:https://arxiv.org/pdf/2412.05280

网络模型的结构&技术细节

4D Autonomous Driving Simulation

生成式4D自动驾驶仿真旨在解决传统自动驾驶仿真场景缺乏真实感的问题,并克服图像生成模型在场景质量和控制能力方面的限制。

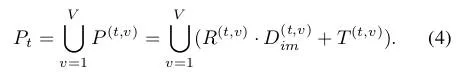

形式上来看,生成式 4D 自动驾驶仿真会根据真实世界场景和一组控制信号生成一个场景,如下公式所示。

然而,传统的方法往往不能有效捕捉场景中真实的时间和空间关系,导致生成的场景出现时间跳跃和可控性不足的问题。因此,我们需要探索4D场景点云重建,以便使用生成模型实现真实的场景理解和高质量的图像生成。该方法结合4D点云、相机参数和时间信息,利用生成框架有效捕捉时间和空间的独立变化,实现更自然、更精确的自动驾驶仿真,可表示为如下的公式形式:

通过上述的这种方式,我们就可以生成与控制信号一致的逼真的模拟场景。

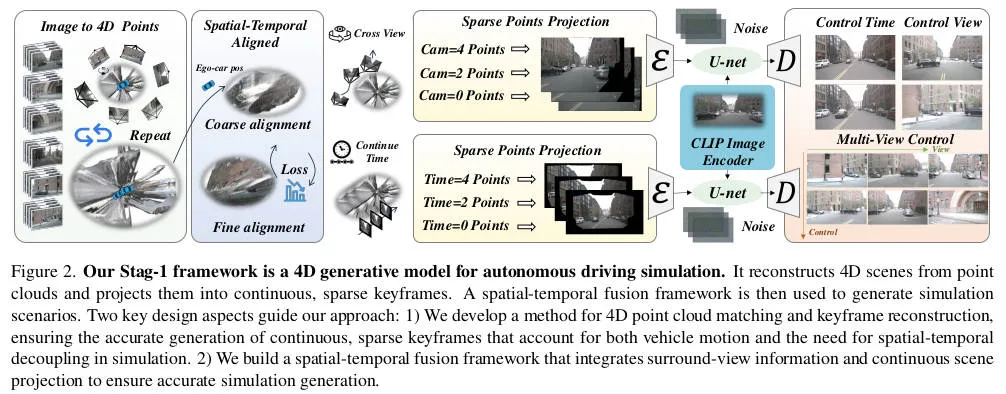

为了准确控制场景,我们从当前场景中提取 4D 点云信息,并将点云投影到连续的 2D 图像上从而形成一组关键帧视频。然后,我们使用视频生成网络生成连续、准确、可控的4D自动驾驶仿真场景。

Spatial-Temporal Aligned Reconstruction

生成式4D自动驾驶仿真场景的构建依赖于精确的4D点云数据信息。根据自动驾驶的实际需求,我们采用了如下的三种原则来定义点云的形式。

- 真实性:4D点云数据必须用真实的参数进行构建,需要知道准确的场景大小和范围,而不仅仅是相对的比例大小。

- 准确性:场景应精确估计物体的位置和距离,以提高 3D 点云的精度。

- 一致性:每个场景帧应与车辆或相机的参数保持一致,以保持一致性。

遵循以上提到的这些原则,我们首先估计并使用环视摄像头参数来生成环视 3D 点云数据信息。我们进一步使用自车参数进行点云对齐,并对其进行迭代细化,以构建精确的 4D 点云场景。

单帧的3D点云重建

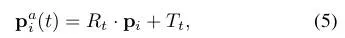

为了从单帧当中重建3D场景,我们对每一幅图像进行了处理。然后,我们使用相应的相机位姿来获得准确的环视点云。通过组合所有视角的点云,我们得到 了在时刻t的环视点云,其整体流程可以用如下的公式进行表述。

连续帧4D点云的粗糙对齐

对于每一个时刻的点云数据信息,我们还会采用如下的公式实现连续帧的4D点云对齐。

然后,为了构建完整的4D点云数据,我们在时间戳上对齐4D 点云序列,记作如下的形式。

连续帧4D点云的精修对齐

鉴于3D点云是通过深度估计的方式得到的,缺乏精确的真值,仅基于参数的对齐方式并不能保证完全的对齐精度。因此,我们引入了一种精细对齐方法,该方法通过多次迭代来完善对齐过程。在每次迭代的过程中,旋转和平移都会根据点云对齐误差进行更新,该误差测量了变换点与参考对齐点之间的差异。通过最小化对齐误差来更新变换参数。

通过将此过程迭代应用于每一帧,我们生成一系列的3D点云数据。最后,我们获得对齐的点云 ,用于支持后续的时空场景解耦。

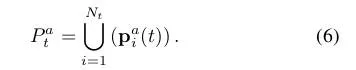

Point-Conditioned Video Generation

实现时空解耦是自动驾驶模拟的关键方面。然而,现有模型由于结构限制,在单独捕捉场景中的空间和时间变化方面存在着不少的挑战,因此很难在同一环境中将空间和时间进行解耦。为了解决这个问题,我们提出的Stag-1 处理一系列连续的 4D 稀疏点云数据以生成 2D 稀疏关键帧视频,如下公式所示。

时间解耦关键帧

在固定相机位姿的情况下,我们提出了一种有效的时空解耦关键帧建模方法,通过提取每个关键帧的 3D 点云数据并将其投影到 2D 图像中。具体来说,对于每个时间戳,我们选择与当前帧对应的 3D 点云。随后,我们使用相机矩阵以及当前时间戳的旋转矩阵和平移向量来投影每个关键帧的3D点云数据,用于实现获取图像中的稀疏二维点云。

通过这种方法,动态点云数据可以从固定的视点准确地投影到二维图像中。

空间解耦关键帧

在空间解耦关键帧建模中,我们使用对齐的空间信息将当前帧的 3D 点云投影到 2D 图像平面上。通过透视投影,我们将 3D 点云映射到 2D 图像平面。

通过使用对齐的空间信息,我们精确地将当前帧的 3D 点云转换为其 2D 投影。该方法有效地利用了空间信息,将其转换为 2D 点云表示,同时减轻了时间变化对关键帧提取的影响。

4D Spatial-Temporal Simulation

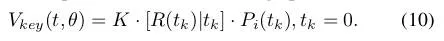

下图展示了我们提出的自动驾驶 4D 生成仿真模型的整体训练框架。具体而言,我们的训练整体过程遵循两阶段的方法:Time-Focused Stage阶段在时间背景下训练单视图场景,而The Spatial-Focused Stage阶段整合环视信息来捕捉空间和时间关系。

The Time-Focused Stage

我们使用奇数帧连续图像作为真值数据,并根据奇数帧的位姿和相机内参将偶数帧 3D 点云投影到图像平面上。

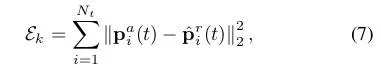

我们通过创建投影的 3D 点云序列及其对应的真实图像来生成配对训练数据。为了提高训练效率,我们将条件信号编码到潜在空间中,并在其中进行优化。为了确保准确对齐和有效的模型学习过程,我们定义了一个自定义损失函数来指导优化过程。损失函数定义如下。

The Spatial-Focused Stage

我们使用与Time-Focused Stage阶段相同的输入方法。为了利用自动驾驶中环视图像之间的重叠信息和交互,我们引入了一种用于跨图像信息交换的注意机制

,如下图所示。

我们的方法捕捉了每帧内不同视角的空间关系,同时也考虑了连续时间步骤之间的时间联系。

实验结果&评价指标

4D重建与合成效果分析

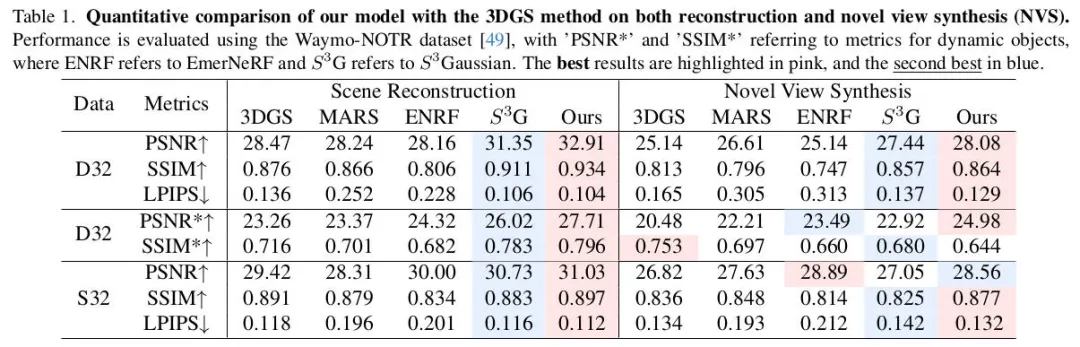

为了评估我们的方法在 4D 重建方面的能力,我们在 Waymo-NOTR 数据集上进行了零样本评估的相关实验,实验结果如下表所示。

通过相关的实验结果可以看出,与现有方法相比,我们的方法在场景重建和新颖视图合成方面表现出色。

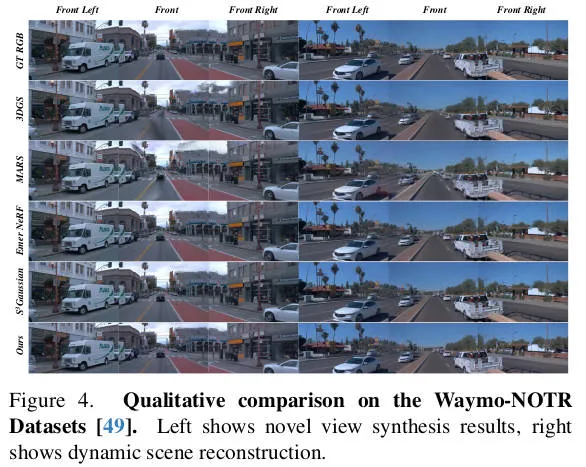

对于static-32数据集,我们遵循传统指标,使用 PSNR、SSIM 和 LPIPS 来评估渲染质量,对于动态数据,我们使用 PSNR* 和 SSIM* 来关注动态对象。我们的结果优于其他方法,展示了该模型在零样本条件下的泛化能力及其对静态场景和动态对象进行建模的能力。为了更加直观的展现我们算法的效果,我们也对相关的实验结果进行了可视化,如下图所示。从质量上讲,我们的方法在单目场景重建和多视图合成方面表现出色。

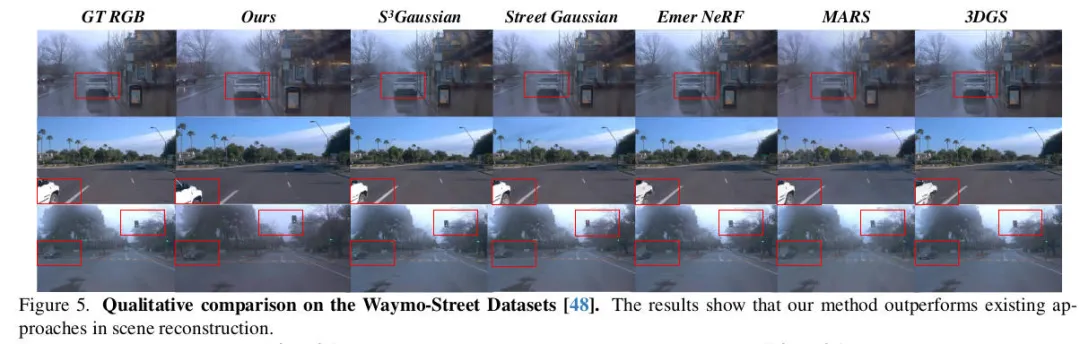

此外,我们对Street Gaussian数据集上的场景重建进行了定量和定性评估,其中相关的实验结果如下表。

更加直观的可视化效果如下图所示。

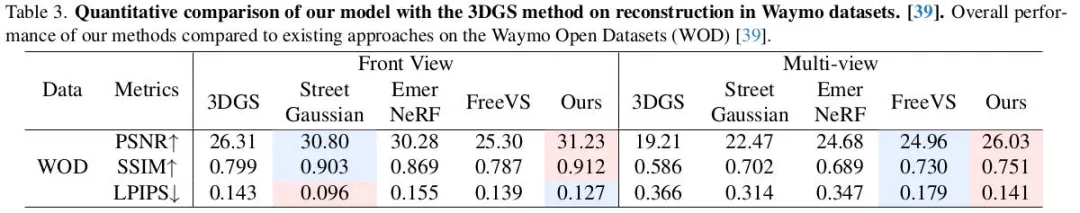

为了准确地将我们的方法与最新方法进行比较,我们Waymo Open Dataset数据集下进行了定量分析。相关的实验结果如下表所示,我们的方法在重建方面优于其他方法。因此,在三种不同实验条件下的定量比较结果表明,我们提出的重建和新颖的视图合成方法优于其他相关方法。

4D驾驶仿真

基于真实场景的自动驾驶生成式 4D 仿真需要能够解耦时空关系。这涉及根据当前时间状态从不同的摄像机视角观察场景,或根据固定的空间状态分解时间运动。我们在 NuScenes 和 Waymo 数据集上进行了定量和定性比较实验,以证明所提方法的能力和有效性。

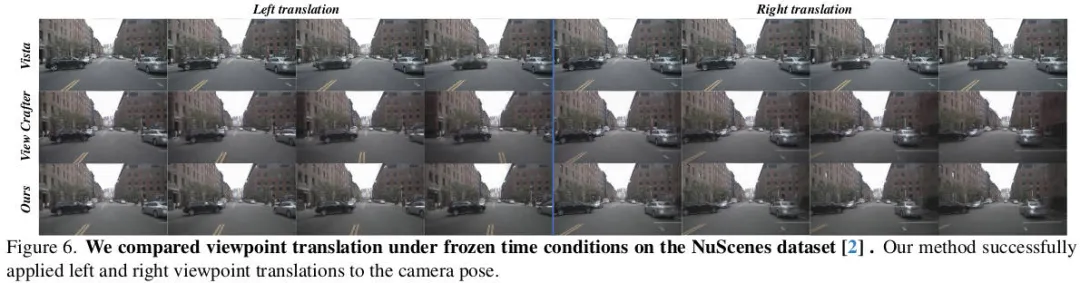

自动驾驶 4D 仿真的一个关键方面是在冻结时间条件下实现动态视角变化的能力。我们将我们提出的方法与现有方法进行了比较,可视化结果表明我们的方法成功实现了所需的任务,如下图所示。

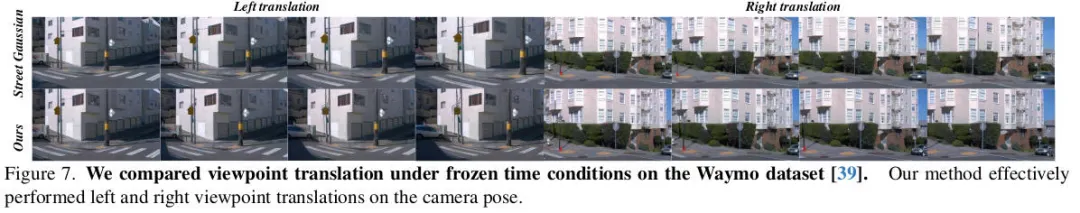

可视化的相关结果表明我们的方法可以实现准确的变换。为了与基于 3DGS 的方法进行公平的比较,我们在 Waymo 数据集上进行了类似的测试。如下图所示,我们的方法在图像精度方面优于其他方法。

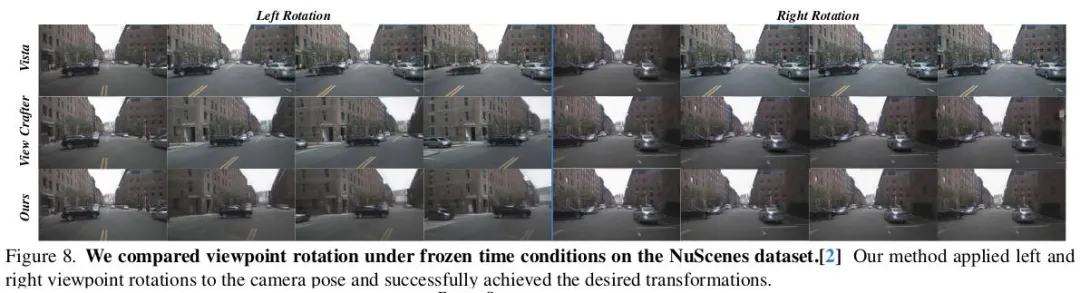

此外,我们也实现了视角的转换以测试模型处理各种相机变换的能力。相关的可视化结果如下图所示,通过可视化的结果可以看出,我们的模型成功完成了这项任务。

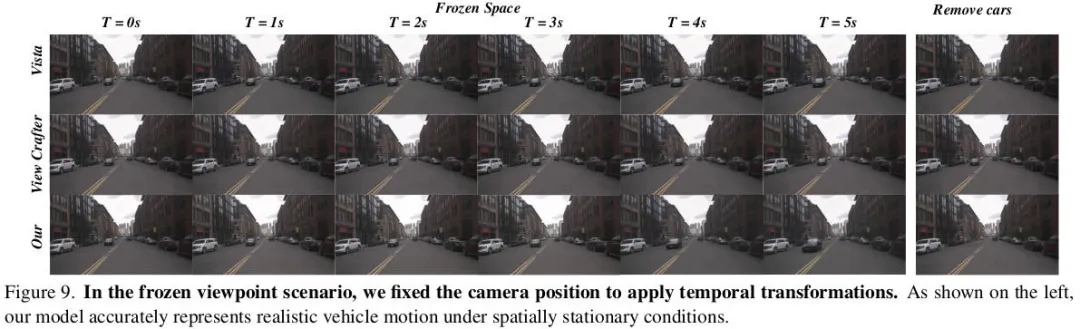

4D仿真的另一个关键方面是它能够在保持相机位置固定的同时改变时间范围,从而实现多种功能。我们通过在冻结空间的条件下模拟时间运动来展示这种能力,如下图的左侧所示。该图显示了相对于真值的移动车辆,而背景保持稳定,验证了该方法在固定空间环境中模拟时间变化的能力。

结论

本文提出了一种用于自动驾驶的生成式 4D 仿真模型,旨在编辑真实场景以实现可控的自动驾驶仿真。可视化和定量结果均表明,所提出的方法可以提取真实场景中的关键元素以进行可控仿真,为自动驾驶测试和验证提供了可行的解决方案。