import tensorflow as tf

from tensorflow.keras import layers, models

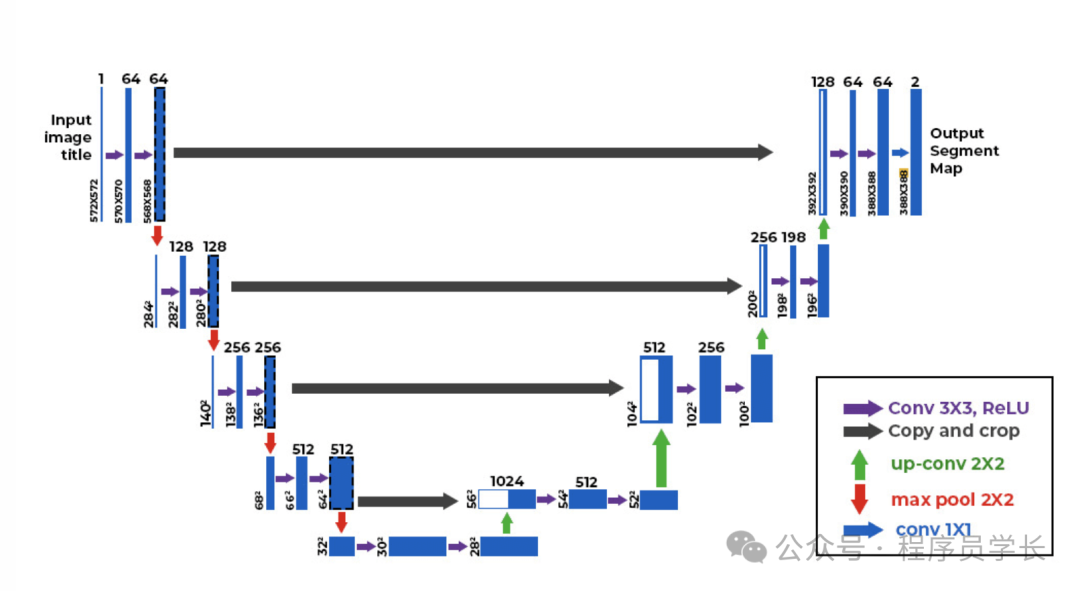

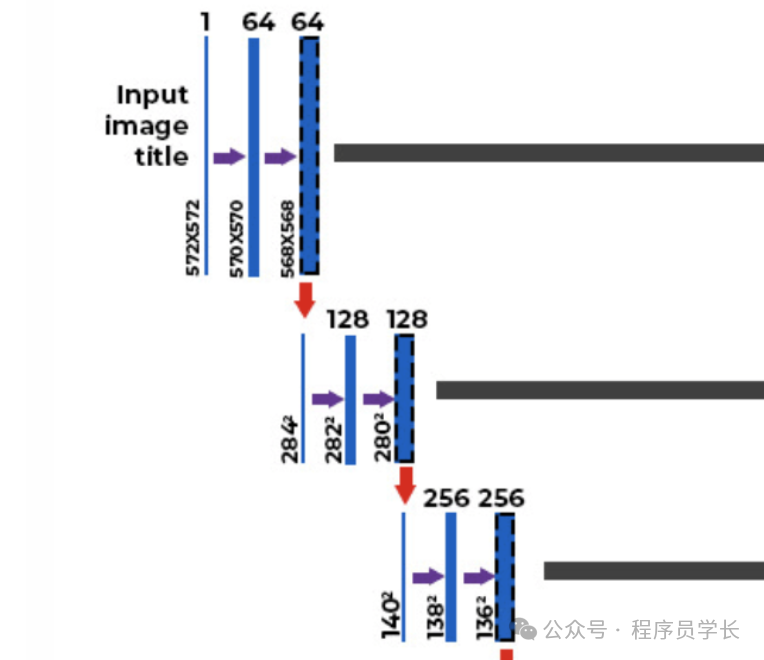

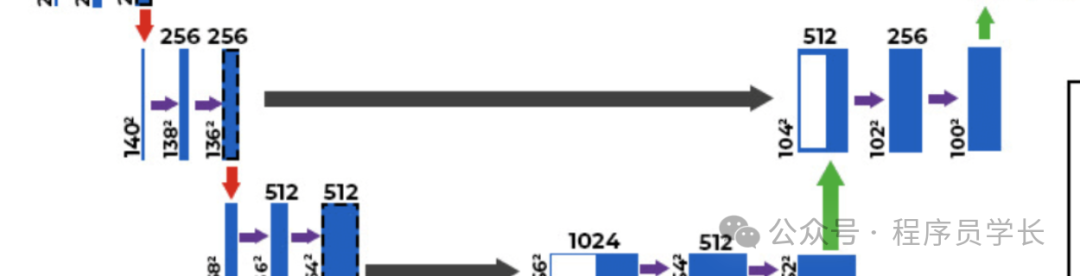

def unet_model(input_size=(128, 128, 3)):

inputs = layers.Input(input_size)

c1 = layers.Conv2D(64, (3, 3), activatinotallow='relu', padding='same')(inputs)

c1 = layers.Conv2D(64, (3, 3), activatinotallow='relu', padding='same')(c1)

p1 = layers.MaxPooling2D((2, 2))(c1)

c2 = layers.Conv2D(128, (3, 3), activatinotallow='relu', padding='same')(p1)

c2 = layers.Conv2D(128, (3, 3), activatinotallow='relu', padding='same')(c2)

p2 = layers.MaxPooling2D((2, 2))(c2)

c3 = layers.Conv2D(256, (3, 3), activatinotallow='relu', padding='same')(p2)

c3 = layers.Conv2D(256, (3, 3), activatinotallow='relu', padding='same')(c3)

p3 = layers.MaxPooling2D((2, 2))(c3)

c4 = layers.Conv2D(512, (3, 3), activatinotallow='relu', padding='same')(p3)

c4 = layers.Conv2D(512, (3, 3), activatinotallow='relu', padding='same')(c4)

p4 = layers.MaxPooling2D(pool_size=(2, 2))(c4)

c5 = layers.Conv2D(1024, (3, 3), activatinotallow='relu', padding='same')(p4)

c5 = layers.Conv2D(1024, (3, 3), activatinotallow='relu', padding='same')(c5)

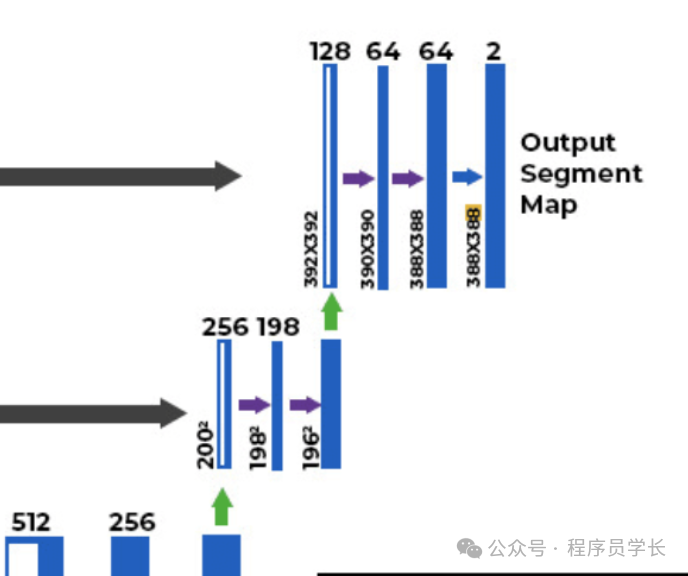

u6 = layers.Conv2DTranspose(512, (2, 2), strides=(2, 2), padding='same')(c5)

u6 = layers.concatenate([u6, c4])

c6 = layers.Conv2D(512, (3, 3), activatinotallow='relu', padding='same')(u6)

c6 = layers.Conv2D(512, (3, 3), activatinotallow='relu', padding='same')(c6)

u7 = layers.Conv2DTranspose(256, (2, 2), strides=(2, 2), padding='same')(c6)

u7 = layers.concatenate([u7, c3])

c7 = layers.Conv2D(256, (3, 3), activatinotallow='relu', padding='same')(u7)

c7 = layers.Conv2D(256, (3, 3), activatinotallow='relu', padding='same')(c7)

u8 = layers.Conv2DTranspose(128, (2, 2), strides=(2, 2), padding='same')(c7)

u8 = layers.concatenate([u8, c2])

c8 = layers.Conv2D(128, (3, 3), activatinotallow='relu', padding='same')(u8)

c8 = layers.Conv2D(128, (3, 3), activatinotallow='relu', padding='same')(c8)

u9 = layers.Conv2DTranspose(64, (2, 2), strides=(2, 2), padding='same')(c8)

u9 = layers.concatenate([u9, c1], axis=3)

c9 = layers.Conv2D(64, (3, 3), activatinotallow='relu', padding='same')(u9)

c9 = layers.Conv2D(64, (3, 3), activatinotallow='relu', padding='same')(c9)

outputs = layers.Conv2D(1, (1, 1), activatinotallow='sigmoid')(c9)

model = models.Model(inputs=[inputs], outputs=[outputs])

return model

model = unet_model()

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

model.summary()

- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

- 7.

- 8.

- 9.

- 10.

- 11.

- 12.

- 13.

- 14.

- 15.

- 16.

- 17.

- 18.

- 19.

- 20.

- 21.

- 22.

- 23.

- 24.

- 25.

- 26.

- 27.

- 28.

- 29.

- 30.

- 31.

- 32.

- 33.

- 34.

- 35.

- 36.

- 37.

- 38.

- 39.

- 40.

- 41.

- 42.

- 43.

- 44.

- 45.

- 46.

- 47.

- 48.

- 49.

- 50.

- 51.

- 52.

- 53.

- 54.

- 55.

- 56.

- 57.

图片

图片 图片

图片 图片

图片 图片

图片 图片

图片