写在前面 & 笔者的个人理解

基于视觉的自动驾驶因其令人满意的性能和低成本而显示出巨大的潜力。大多数现有方法采用密集表示(如鸟瞰图)或稀疏表示(如实例框)进行决策,这会在全面性和效率之间进行权衡。本文探索了一个以高斯为中心的端到端自动驾驶(GaussianAD)框架,并利用3D语义高斯来广泛而稀疏地描述场景。我们用均匀的3D高斯分布初始化场景,并使用环视图像逐步细化它们,以获得3D高斯场景表示。然后,我们使用稀疏卷积来有效地执行3D感知(例如,3D检测、语义图构建)。我们用动态语义预测高斯模型的3D流,并相应地规划自我轨迹,以预测未来的场景。我们的GaussianAD可以通过可选的感知标签以端到端的方式进行训练。在广泛使用的nuScenes数据集上进行的广泛实验验证了我们的端到端GaussianAD在各种任务上的有效性,包括运动规划、3D占用预测和4D占用预测。

- 论文链接:https://arxiv.org/abs/2412.10371v1

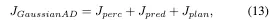

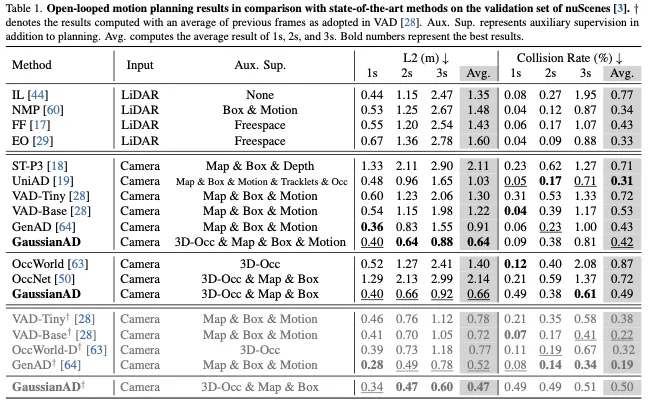

本文提出了一个以高斯为中心的自动驾驶(GaussianAD)框架作为肯定答案,如图1所示。我们使用来自2D图像的稀疏3D语义高斯集作为场景表示。尽管存在稀疏性,但它受益于高斯混合的通用近似和显式3D结构带来的细粒度建模,这有助于各种下游任务。我们进一步从3D高斯表示中探索感知、预测和规划。对于感知,我们将3D高斯视为语义点云,并采用稀疏卷积和稀疏预测头来有效地处理3D场景。我们提出了3D高斯流来全面明确地仿真场景演变,我们预测每个高斯流的未来位移。然后,我们整合所有可用信息,相应地规划自我轨迹。由于3D高斯表示的明确性,我们可以使用仿射变换直接计算自车观察到的预测未来场景。我们将预测场景与地面实况场景观测进行比较,作为预测和规划的明确监督。据我们所知,GaussianAD是第一个探索以视觉为中心的端到端自动驾驶显式稀疏点架构的公司。我们在nuScenes数据集上进行了广泛的实验,以评估所提出的高斯中心框架的有效性。实验结果表明,我们的GaussianAD在高效的端到端运动规划方面取得了最先进的结果。

相关工作回顾

自动驾驶感知。从传感器输入中准确感知周围环境是自动驾驶的基本步骤。作为两个主要的传统感知任务,3D目标检测旨在获得周围场景中每个代理的3D位置、姿态和类别,这对轨迹预测和规划非常重要。语义图重建旨在恢复鸟瞰图(BEV)中的静态图元素,为进一步推理提供额外信息。这两个任务都可以在BEV空间中有效地执行,但它们无法描述周围场景和任意形状对象的细粒度3D结构。这促使最近的方法探索其他3D表示,如体素和三视角视图(TPV),以执行3D占用预测任务。3D占用提供了对周围场景的更全面的描述,包括动态和静态元素,可以从稀疏的激光雷达或视频序列中有效地学习。Gaussianformer提出使用3D语义高斯来稀疏地表示3D占用场景。然而,目前尚不清楚3D高斯表示是否可用于一般的自动驾驶。

自动驾驶预测。预测场景演变对自动驾驶汽车的安全性也至关重要。大多数现有方法侧重于根据交通代理的过去位置和语义地图信息预测其移动。早期的方法将智能体和语义图信息投影到边界电动图像上,并采用二维图像主干对其进行处理,以推断未来的智能体运动。随后的方法采用了更有效的动态代理的标记化表示,并使用图神经网络或变换器来聚合信息。最近的工作开始以端到端的方式直接从传感器输入探索运动预测。他们通常首先执行BEV感知以提取相关信息(例如,3D代理框、语义图、轨迹),然后利用它们来推断未来的轨迹。与仅对动态对象运动进行建模的现有方法不同,我们提出了高斯流来预测包括动态和静态元素在内的环视场景演变。

规划自动驾驶。规划是自动驾驶系统的重要组成部分,可分为基于规则的和基于学习的方法。虽然传统的基于规则的方法可以获得令人满意的结果,并且具有很高的可解释性,但基于学习的方法近年来受到了越来越多的关注,因为它们具有扩展到大规模训练数据的巨大潜力。作为简单而有效的基于学习的解决方案,基于模仿的规划者一直是端到端方法的首选。作为早期的尝试,LBC和CILRS采用卷积神经网络(CNN)从专家驾驶数据中学习。以下方法结合了更多的数据或提取了更多的中间特征,为规划者提供了更多的信息,取得了显著的效果。尽管如此,大多数现有的端到端自动驾驶方法采用高级场景描述(例如3D框、地图)进行下游预测和规划,并可能省略某些关键信息。本文提出了一种以高斯为中心的自动驾驶流水线,并使用3D高斯作为稀疏但全面的信息载体。

GaussianAD方法详解

3D Scene Representation Matters for Driving

自动驾驶旨在根据一系列场景观察{o}产生安全一致的控制信号(例如加速器、制动器、转向)。虽然场景观测可以从多个传感器(如摄像头和激光雷达)获得,但由于其高信息密度和低传感器成本,我们主要针对周围摄像头的基于视觉的自动驾驶。

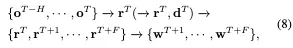

假设控制器性能良好,大多数自动驾驶模型主要侧重于学习从当前和历史观测值{o}到未来自车轨迹{w}的映射f:

传统的自动驾驶方法将f分解为感知、预测和规划模块,并在连接之前分别对其进行训练:

这些模块的单独训练进一步加剧了这个问题,因为不同的任务侧重于提取不同的信息。提供给规划模块的不全面信息可能会影响自动驾驶模型的决策过程。这推动了从模块化框架到端到端框架工作的转变,该框架可区分地连接并共同学习感知、预测和规划模块:

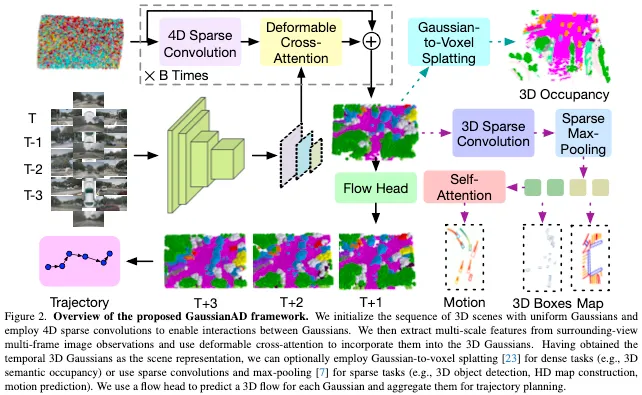

场景表示r在整个模型中传递信息,因此r的选择对端到端系统的性能至关重要。由于自动驾驶需要在3D空间中做出决策,场景表示应该是3D结构的,并包含从输入图像推断出的3D结构信息。另一方面,3D空间通常是稀疏的,导致在设计r时在全面性和效率之间进行权衡。为了全面性,传统的鸟瞰图(BEV)表示在地图视图中使用密集的网格特征,并压缩高度维度以减少冗余。后续方法进一步探索更密集的表示,如体素或三视角视图(TPV),以捕获更详细和细粒度的3D信息。为了提高效率,最近的方法采用了稀疏查询,并专注于对实例框和映射元素进行建模,这是决策中最重要的因素。尽管如此,被丢弃的信息仍然很重要(例如,不规则的障碍物、交通灯、人体姿势),并且与端到端自动驾驶的理念(即全面的信息流)相矛盾。本文探讨了3D高斯分布作为一种全面而稀疏的场景表示,并提出了一个用于端到端感知、预测和规划的完全稀疏框架,如图2所示。

Gaussian-Centric Autonomous Driving

3D高斯表示**。现有的方法通常构建一个密集的3D特征来表示周围环境,并用相等的存储和计算资源处理每个3D体素,这通常会导致难以处理的开销,因为资源分配不合理。同时,这种密集的3D体素表示无法区分不同尺度的对象。与这些方法不同,我们遵循GaussianFormer,它表示一个具有许多稀疏3D语义Gaussian的自动驾驶场景。每个高斯分布都实例化了一个语义高斯分布,其特征是均值、协方差和语义逻辑。这种稀疏显式特征表示对下游任务更有利。

图像中的Gaussians。我们首先将3D高斯分布及其高维查询表示为可学习向量。然后使用高斯编码器迭代地增强这些表示。每个高斯编码器块由三个模块组成:一个促进高斯人之间交互的自编码模块,一个用于聚合视觉信息的图像交叉注意力模块,以及一个用于微调高斯属性的细化模块。与GaussianFormer不同,我们利用由4D稀疏卷积组成的时间编码器将前一帧的高斯特征与当前帧中的相应特征进行整合。

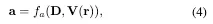

高斯稀疏3D检测。由于3D高斯表示是一种稀疏场景表示,我们遵循VoxelNeXt,它直接基于稀疏体素特征预测3D对象。特别地,我们进行了一个3D稀疏CNN网络V来编码3D高斯表示r。根据GenAD,我们使用V(r)上的一组代理令牌D来解码3D对象a:

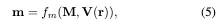

Gaussians的稀疏地图构建。与高斯的3D检测表示类似,我们采用一组映射标记M来表示语义建图。我们关注三类地图元素(即车道分隔线、道路边界和人行横道)。

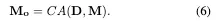

运动预测。运动预测模块通过预测其他交通参与者的未来轨迹来辅助自车轨迹规划。我们通过使代理令牌D通过交叉关注层CA与地图令牌M交互来获得运动令牌Mo:

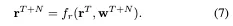

高斯流用于场景预测。此外,它表明中间表示r的场景预测在端到端自动驾驶中起着重要作用。我们根据当前的高斯表示$r^T$和预测的自车轨迹$w^{T+N}$,将未来的高斯表示预测为高斯流$r^{T+N}$:

对中间高斯表示的未来占用的监督保证了场景预测能力,最终提高了自车轨迹预测的性能。

End-to-End GaussianAD Framework

本节介绍GaussianAD的整体端到端框架。我们首先用一组均匀分布的3D高斯G0初始化场景,然后通过合并周围视图图像o的信息来逐步细化它们,以获得高斯场景表示r。然后,如果相应的标注可用,我们可以从r中提取各种场景描述d作为辅助任务。具体来说,我们使用高斯到体素飞溅来获得密集描述的密集体素特征(例如,3D占用预测),并使用完全稀疏卷积来获得稀疏描述的稀疏查询(例如,三维边界框、地图元素)。辅助感知监督的使用引入了场景表示r的额外约束和先验知识,以指导其学习过程。尽管如此,我们还是直接在3D高斯模型上预测未来的演变,以减少信息损失,并相应地规划自车轨迹{w}。GaussianAD通过稀疏但全面的3D高斯表示在整个模型中传递信息,为决策过程提供更多知识。我们的GaussianAD的总体框架如下:

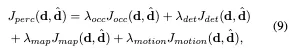

对于训练,我们自适应地对从r中提取的场景描述d施加不同的感知损失:

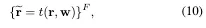

由于3D高斯分布的显式表示,我们可以使用全局仿射变换来模拟在某个给定的自车位置w处观察到的场景表示r。在用提出的高斯流获得预测的未来场景表示后,我们使用计划的航路点来模拟未来的自车场景表示:

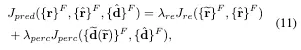

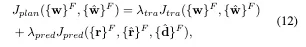

预测的未来自车场景表示也取决于计划的轨迹${w}^F$如(10)所示。因此,除了传统的轨迹损失外,我们还采用预测损失(11)进行规划:

所提出的GaussianAD是一个灵活的框架,可以适应具有不同可用监督的各种情况,如图3所示,总体目标如下:

对于推理,GaussianAD使用3D高斯表示实现端到端驱动,以在整个流水线中有效地传递信息。它为决策过程提供了全面的知识,并通过稀疏计算保持了高效率。

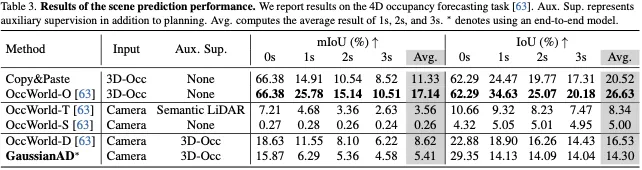

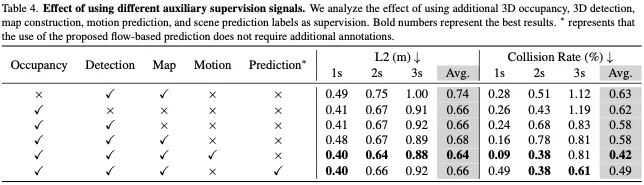

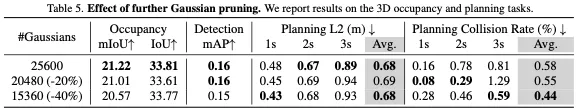

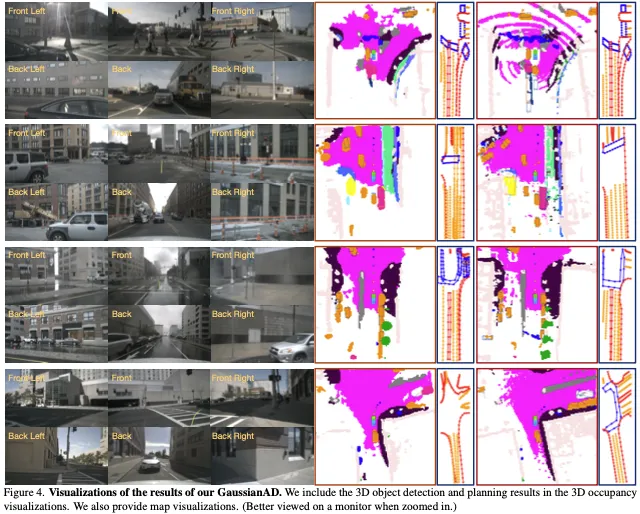

实验

结论

本文基于视觉的端到端自动驾驶提出了一个以高斯为中心的框架。为了保留更全面的信息,我们采用3D高斯作为场景表示,并采用高斯流来有效地预测未来的演变。我们的框架提供了灵活性,可以容纳具有各种注释的不同训练数据。我们对广泛使用的nuScenes进行了广泛的实验,并在各种任务上展示了具有竞争力的性能,包括端到端规划和4D占用预测。探索基于用更多样化数据训练的3D高斯场景表示的大规模端到端模型是很有趣的。