刚刚由清华大学本科生伍垟圳为一作的论文《推理Scaling Laws:面向语言模型问题求解的计算最优推理实证分析》在顶级AI学术会议NeurIPS 2024 Math-AI上荣获杰出论文奖(Outstanding Paper Award)。这项研究不仅刷新了人们对推理阶段计算优化的理解,还为如何在有限计算资源下实现更高效的大语言模型(LLM)推理提供了全新的思路

论文亮点:推理阶段的计算优化新突破

1. 小模型也能打败大模型:重新定义推理阶段的效率

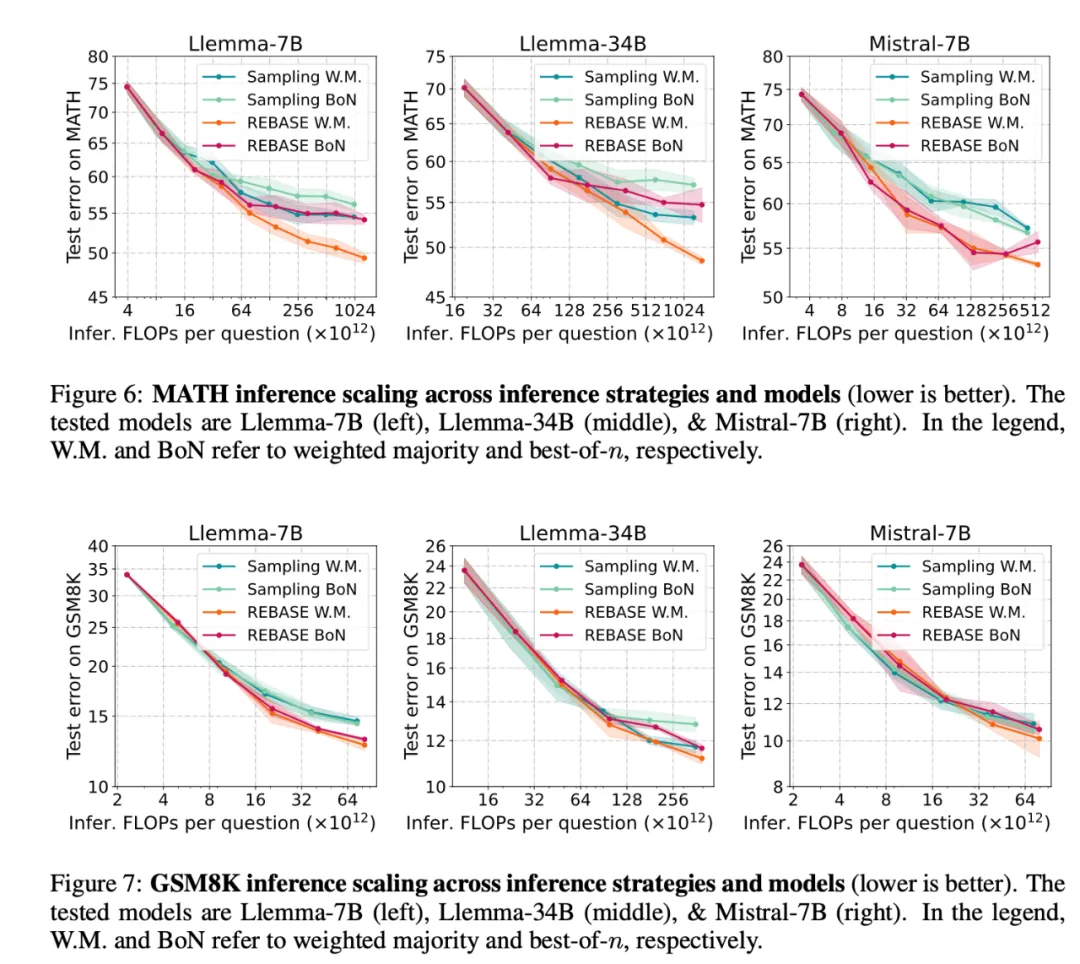

论文系统性地研究了不同模型大小和推理策略在固定计算预算下的表现,发现小模型(如Llemma-7B)在结合高级推理算法后,能够实现比大模型(如Llemma-34B)更优的成本性能平衡。例如,在数学推理任务中,Llemma-7B通过生成更多候选解并使用优化的投票策略,可以在计算量减半的情况下达到甚至超越Llemma-34B的准确率。这一发现颠覆了“大模型总是更好”的传统认知,为实际应用中的资源受限场景提供了新思路

2. REBASE算法:推理策略的革新

推理阶段的一个关键问题是如何在有限计算预算下高效搜索高质量解答。论文提出了一种名为REBASE(奖励平衡搜索,REward BAlanced SEarch) 的新型树搜索算法

- 与传统算法的对比:传统的蒙特卡洛树搜索(MCTS)虽然能提升推理性能,但计算开销巨大,常常需要生成大量冗余解。而REBASE通过奖励机制智能控制搜索节点的扩展,避免了不必要的计算浪费

- 性能表现:在所有测试的计算预算范围内,REBASE都实现了帕累托最优的成本性能平衡。例如,在MATH数据集上,REBASE使用7B模型的表现优于34B模型搭配传统推理策略。这表明通过设计更高效的推理算法,可以显著提升推理性能而无需依赖更大的模型

3. 推理性能的理论与实践结合

论文不仅通过实验验证了推理阶段的规模律,还在理论层面对采样与投票策略的表现进行了深入分析:

- 采样策略的极限:论文证明了,传统的采样方法(如加权多数投票)在采样次数无限增加时,其性能会逐渐饱和,达到由模型生成概率分布决定的上限

- 新策略的优势:相比于单纯增加采样次数,设计能够智能选择高质量解的推理算法(如REBASE)能突破这一瓶颈,延迟性能饱和点并提高最终准确率

4. 实验覆盖广泛,结果具有普适性

论文的实验覆盖了多种数据集(如MATH和GSM8K)以及多种模型架构(如Pythia、Mistral、Llemma),验证了结论的广泛适用性:

- 数据集层面:在简单的数学推理任务(GSM8K)和复杂的数学竞赛问题(MATH)上,REBASE都表现出显著优势

- 模型层面:无论是7B的小模型还是34B的大模型,REBASE均能提升推理效率,其中性能较弱的小模型获益更大

5. 实用性强:为工业应用提供指导

论文的研究对实际应用场景具有重要意义。现代AI应用中,推理阶段的计算成本往往是模型部署的瓶颈。研究表明,通过选择合适的模型大小并搭配高级推理策略,可以在有限资源下实现更优性能。这一发现为低成本部署高性能模型提供了新的思路,尤其适用于资源受限的设备(如手机端、边缘设备)和云计算场景

为什么这项研究重要?

随着大语言模型的规模不断扩大,其推理阶段的计算成本也随之飙升。如何在有限计算资源下实现最优性能,成为实际应用中亟待解决的问题

具体而言,这项研究对未来的AI模型部署和优化有以下几点启示:

1. 成本优化:在计算资源有限的场景(如手机端或嵌入式设备)中,小模型搭配高级推理策略可能比大模型更具实际价值

2. 算法创新:REBASE的成功表明,推理阶段的算法设计仍有巨大潜力。这为开发更高效的推理算法开辟了新方向

3. 学术突破:论文首次系统性地研究了推理阶段的规模律,为后续研究奠定了理论基础

清华本科生的国际舞台崛起

论文一作伍垟圳是清华大学交叉信息研究院的一名本科生。值得一提的是,这项研究是在其访问卡内基梅隆大学期间完成的,充分体现了清华学子的国际学术竞争力

在这项研究中,伍垟圳与来自卡内基梅隆大学的研究者共同合作,将理论分析与实验验证相结合,揭示了小模型在推理阶段的巨大潜力

伍垟圳个人简介

伍垟圳(Yangzhen Wu),清华大学交叉信息研究院(IIIS)计算机科学专业三年级本科生,隶属于由图灵奖得主姚期智教授指导的“姚班”。

目前,在卡内基梅隆大学(CMU)进行实习访问,导师为Yiming Yang教授和Sean Welleck教授

研究兴趣主要集中在以下领域:

• 面向代码和数学的机器学习;

• 大语言模型的推理能力;

• 推理算法及其可扩展性。

获奖经历

• AI数学奥林匹克 - 进步奖1(第二名,奖金$65536)Kaggle,2023年6月(共1161名参赛者,第2名)

• 第35届中国数学奥林匹克金牌。中国数学会,2019年11月