整理 | 伊风

出品 | 51CTO技术栈(微信号:blog51cto)

杨立昆做客《WTF人物》,与印度企业家 Nikhil Kamath 谈论有关人工智能的一切。

在一个半小时的访谈中,杨立昆的博学和谦逊让人印象深刻。为了向提问者解释“神经网络语言模型”,他可以从香农的信息论讲起,把 AI 晦涩的知识讲得深入浅出。

图片

图片

谈到 AI 教父,他直言不喜欢这个像黑手党一般的称呼,但他希望能成为学界的英雄。他更提到,因为他立场鲜明的公开言论,很多人认为他是白痴。

这不得不提到杨立昆对 Transformer 模型的反对态度。他不止一次地提到 ChatGPT 等 AI 前沿的智力水平仍然远不及家里的宠物猫。在访谈中,他做出了更详细的说明。同时认为即使是目前大热的 o1 ,也只是在进行一些“非常基础的推理,方法效率非常低下,所以并不是理想的解决方案。”他还分享了自己的研究方向,团队探索了5年之久的“联合嵌入预测架构”及其原理。

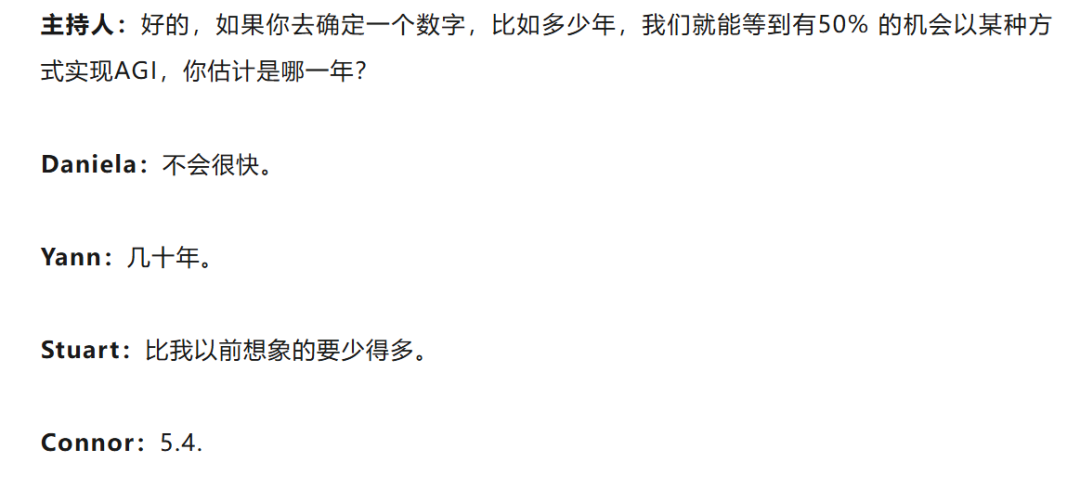

谈到未来,我们发现杨立昆对AGI的实现预测提速了10倍。5月底的一场圆桌,他认为AGI将在几十年后到来。(全文:我们应该恐惧AGI?杨立昆等语出惊人:这里有两个悖论)然而,经历了今年的探索和技术改进后,他坦言目前的预测是“在5到10年中”,已经和马斯克、奥特曼等人的预测差别不大。

图片

图片

同时,杨立昆强烈安利 AI 创业者去卷卷学历,他解释说,博士不仅有利于个人理解什么是真正的创新,而且拥有学术成果也会让融资变得更容易。

最后,他提到,“我们不会没有工作可做,因为人类总有解决不完的问题”。未来的人类智能应该要掌握三者的结合:已经掌握的技能和解决问题的经验、通过少量尝试快速学习新技能的能力,以及面对新问题时无需学习新技能就能解决问题的能力。

以下是经整理的博客精华内容,enjoy:

杨立昆大佬在博客中详细探讨了:反向传播算法、强化学习领域的现状、卷积神经网络等内容,感兴趣的朋友可以移步这期节目。

https://www.youtube.com/watch?v=JAgHUDhaTU0

1.谈AI教父头衔:科学界也可以有英雄

主持人 Nikhil Kamath :当有人称你为“人工智能之父”时,你的感受如何?

LeCun :你怎么看这个称号?说实话,我不是特别喜欢这个称呼。我住在新泽西,而在新泽西,“教父”这个词意味着你是这里黑帮的成员。

科学从来都不是一种个人追求,而是通过多个人的思想碰撞来取得进步的。你会提出假设,然后通过验证你的假设是否正确来推进科学。例如,验证你的想法、你的心智模型是否有效,或者通过理论研究等方式。这不是一种孤立的活动。科学的进步总是许多人共同努力的结果。然而,由于世界运作的方式,我们往往只记住少数人。我认为很多功劳应该归功于更多的人,但我们缺乏为更多人归功的记忆能力。

主持人 Nikhil Kamath :你觉得在学术界和研究领域成为“英雄”是否和在体育或创业领域成为英雄类似?还是说学术领域更难?

LeCun :我很高兴科学界也可以有“英雄”的存在。

在某种程度上,一些其他科学家也算是小有名气的名人。我认为,部分名声来自科学成果,但坦白说,有很多作出重要科学贡献的人完全默默无闻,这让我有点难过。我觉得那些在科学和技术领域出名的人,往往不仅是因为他们的科学成就,也因为他们的公众立场。

有一点可能让我和一些更低调的科学家不同的是,我在社交网络上非常活跃,经常发表公众演讲,并对技术问题和一定程度上的政策问题表达强烈的观点。这可能导致我的名声在某些圈子里很高,但在另一些圈子里,我被视为一个彻底的蠢货。

2.什么是人工智能?“我们总是忽略智能还有其他方面”

主持人 Nikhil Kamath :我们是否可以从“什么是人工智能”开始?

LeCun :好的,这是个好问题。什么是“智能”?在人工智能的历史中,我认为“什么是人工智能”这个问题有点像盲人摸象的故事。智能有非常不同的方面,而在人工智能的发展历程中,人们通常只关注某一种关于智能的视角,而忽略了其他方面。

20世纪50年代,人工智能的早期研究重点是将智能视为推理能力。那么,我们如何进行逻辑推理?如何寻找新问题的解决方案?在50年代,人们意识到可以通过一个问题来描述这种情景。假设我们有一个问题,这已经成为人工智能或计算机科学中的经典问题。

主持人 Nikhil Kamath :找到解决方案确实与智能有关。如果你问我什么是智能,我可能会因为难以用一句话定义而感到无言以对。

LeCun :是的,这就引出了另一个问题。

主持人 Nikhil Kamath :你能解释一下“盲人摸象”的比喻吗?

LeCun :当然。你知道盲人摸象的故事吧?第一个盲人摸到大象的侧面,说这像是一堵墙;另一个摸到大象的腿,说这像一棵树;还有一个摸到象鼻,说这像一根管子。没有人能够完全理解整体是什么样子,只能从不同的角度感知它。

因此,将智能视为为特定问题寻找解决方案的这一面只是智能的一个小方面。它是智能的一个部分,但不是全部。然而,在人工智能发展的初期,有一个分支基本上只关注这个方面。从50年代开始,这个分支在90年代之前一直占主导地位,认为人工智能就是为计划或问题寻找解决方案。

比如说,如果你想把一些物体堆叠起来,而有些物体比其他物体大,你需要组织堆叠这些物体的顺序。这就是计划问题。或者说,如果你有一个机器人手臂,需要抓取一个物体,但前面有障碍物,你必须为手臂规划一条抓取物体的路径。这些都是规划问题,它们是为问题寻找解决方案的一部分。但这种人工智能的分支,从50年代开始主导直到90年代,完全忽略了诸如感知的问题,比如我们如何理解世界?

我们如何识别一个物体?我们如何将一个物体从背景中分离出来以便识别?以及我们如何不以逻辑或搜索的方式思考,而是用更抽象的方式思考?这些方面在当时基本上被忽视了。

但是在20世纪50年代,还出现了人工智能的另一个分支,这一分支提出:“让我们尝试重现动物和人类大脑中体现的智能机制。”在动物和人类的大脑中,基本机制是大脑会自我组织和学习,它们并非天生就聪明。智能是一种由大量简单元素(彼此连接的网络)中涌现的现象。

因此,在50年代,这些研究者开始发现,智能和记忆来源于神经元之间连接强度的变化(以一种简化的方式来说)。大脑学习的方式是通过修改神经元之间连接的强度来实现的。于是,有些人提出了理论模型,甚至设计了能够重现这一现象的电子电路——也就是探索“我们是否可以构建智能”。

3.Transformer 带不来AGI,未来需要突破LLM的局限

主持人 Nikhil Kamath :什么是自监督学习?

LeCun :自监督学习是一种方法,其中输入和输出没有明确的区分。两者实际上是同一件事情。如果输入是一个图像,你训练自监督学习系统的方法是通过某种方式破坏或转换图像,然后让系统从损坏或转换后的版本中恢复原始图像。

与其让人类去处理数百万张图像并告诉你“这是猫、这是狗、这是桌子”,你只需展示一张猫、狗或桌子的图像,然后对其进行破坏(部分修改,可能是改变颜色或其他形式),接着让系统从被破坏的图像中恢复原始图像。这就是一种特定形式的自监督学习。这种方法在自然语言理解方面非常成功。

像聊天机器人或大型语言模型(LLMs)就是自监督学习的一个特殊案例。在这种情况下,你训练一个系统来预测一个单词,但它只能看前面的单词(位于左边的单词)。这需要以一种特定的方式构建神经网络,使预测某个单词的连接只能查看前面的单词。因此,你不需要破坏输入。只需展示输入,通过系统的结构,系统只能从上下文中被训练来预测下一个单词。

主持人 Nikhil Kamath : 所以,Transformer 对文本效果最佳,但对图片和视频并不适用。

LeCun :这是因为文本中可能发生的事情是有限的,对吧?词典中的词汇数量是有限的。因此,如果你可以将信号离散化,就可以使用这些自回归预测系统。

主要问题在于,你永远无法做出完全准确的预测。所以系统需要学习某种概率分布,或者至少生成不同潜在输出的不同评分。如果可能的结果是有限的,比如语言,你可以输出一个概率列表。但如果你想预测视频中将发生什么,视频帧的可能数量基本上是无限的,对吧?

比如说想象一下像素,每一帧可能包含1000个像素,每个像素都有颜色值,你需要生成3个值,这就意味着你要生成300万的值。而我们还不知道如何表示覆盖所有可能图像(包含300万个像素)的概率分布。

主持人 Nikhil Kamath :但这正是大家非常兴奋的地方。

LeCun :是的,这也是很多人认为 AI 下一个挑战的领域。我们需要让系统通过观看视频来学习世界的运作方式。

主持人 Nikhil Kamath :如果你通过视频和图片学习,这是下一阶段的发展方向,那它在整个图景中属于哪个部分?它属于今天提到的 LLMs 的范畴吗?

LeCun :不,这完全不同于 LLMs。这也是为什么我一直很直言地表示,LLMs 并不是通向人类级别智能的路径。LLMs 适用于离散的世界,但它们不适用于连续的高维世界,比如视频。这也是为什么 LLMs 无法理解物理世界,无法以其现有形式真正理解现实世界的原因。

LLMs 的语言处理能力非常出色,但它们会犯非常愚蠢的错误,暴露出它们实际上并不理解世界的运行方式。这也是为什么我们有能通过律师资格考试的系统、有能帮你写论文的系统,但我们却没有家用机器人,没有完全自动驾驶的汽车(即五级自动驾驶)。这些系统甚至无法理解你家里的猫都能理解的基本常识。

所以我一直很直言地说,即便是最聪明的 LLMs,其智能水平还不如一只家猫,这的确是事实。

未来几年的挑战在于构建能够突破这些限制的 AI 系统,即能够理解物理世界、具有持久记忆的系统,而这些是现有 LLMs 所缺乏的。

4.杨立昆的解法:不预测像素,预测这些像素的抽象

主持人 Nikhil Kamath :那么,记忆最终会成为答案吗?从生物学角度来看,我们人类是通过记忆来学习的。

LeCun :嗯,这取决于是哪种记忆。我的意思是,我们人类也有多种类型的记忆。可以将其类比为计算机,皮层是CPU,海马体是内存,负责读取和写入数据。

但当前的AI系统设计并不是这样的。LLMs(大语言模型)除了生成提示词时使用的上下文外,没有独立的记忆模块。它们也不具备搜索多个答案并找到正确答案的能力,尽管目前有一些初步的尝试。例如你可能听说过OpenAI的 o1 项目,还有类似的工作在其他地方展开。这些系统进行一些非常基础的推理,比如让LLM生成多种词序列,然后通过某种方式筛选出最佳序列,但这种方法效率非常低下,所以并不是理想的解决方案。

回到问题本身,即如何让机器通过观察世界、观看视频来学习。我们可以使用生成式架构来生成视频中的每一个像素,但这完全不现实。我尝试了将近15年。五年前,我们提出了一种不同的方法,称为Jeppo。这是一种新的架构,意思是“联合嵌入预测架构”(joint embedding predictive architecture)。

主持人 Nikhil Kamath :我在你接受Lex Fridman采访时听过你讲Jeppo这个概念很久了。

LeCun :与其取一段视频并训练一个大型神经网络来预测视频接下来的所有像素,不如将视频输入一个编码器。这个编码器是一个大型神经网络,会生成视频的抽象表示。然后,把视频的剩余部分(未来的部分,比如视频的后半段)也输入同样的编码器。接下来,你可以训练一个预测系统来完成预测任务。

主持人 Nikhil Kamath :这有点像LLM,通过删除部分数据来训练模型。

LeCun 。没错,在LLM中,你取一段文本,训练它预测文本的其余部分,并逐字进行。当然,你也可以预测多个词汇。在这里,我们将对视频做类似的事情,训练系统预测视频的其余部分。不过,与其预测视频中的所有像素,不如先用编码器处理视频,得到视频的抽象表示,然后在这些表示的空间中进行预测。这样一来,我们不是预测像素,而是预测这些像素的抽象表示,在这个表示中,所有无法预测的内容都已经从表示中去除。

5.谈未来:AI创业者应该读博、开源生态及新时代人类智能

主持人 Nikhil Kamath :作为一名20岁的印度人,想在AI领域建立事业,成为AI领域的从业者,我们该怎么做?

LeCun :希望等到22岁毕业时,能去做很好的博士项目。

主持人 Nikhil Kamath :在学术视角之外呢?

LeCun :不,因为我需要训练自己去创新。做博士或研究生学习,可以训练你去发明新事物,同时确保你使用的方法论能防止你自己误以为你在创新,但其实并不是。

像AI这样复杂且深奥的领域,这有很多好处。你可能不做这个也能成功,那不是问题,但这会给你一种不同的视角。

如果你在做博士,你也在做创业公司,如果你发表了一些论文,发明了新东西,告诉别人:“这是一个新技术,真的能带来变化。”你去找投资人,可能会更容易筹集资金。

主持人 Nikhil Kamath :你比我更擅长想象未来,你能描述五年后的未来吗?

LeCun : 五年后,世界将由开源平台主导,就像今天嵌入式设备和操作系统的世界被Linux主导一样。整个世界都在运行Linux,而25年前甚至20年前并非如此。它之所以成为今天这样,是因为开源平台更加便携、更灵活、更安全、成本也更低。

主持人 Nikhil Kamath :那么,社会中的智能会发生什么变化?抛开计算机和AI不谈,对于人类来说,在这样的世界里,智能是什么?

LeCun :人类智能的衡量方式将会转向与今天不同的一套测试,因为很多我们今天需要完成的任务将由AI系统完成。我们会把精力集中在其他任务上,比如不是执行任务,而是决定做什么或者想出要做什么。

主持人 Nikhil Kamath :所以我们需要更少的人来指挥那些比我们高效的系统去完成任务,而不是像现在这样需要更多的人来执行任务,对吧?那其他人怎么办?

LeCun :我认为每个人都会处于这样的环境中,能够接触到AI系统并将许多任务委托出去,主要是在虚拟世界里。最终,在现实世界中,我们也会拥有类似家用机器人、自动驾驶汽车之类的东西——只要我们解决了如何通过视频让系统理解现实世界的问题。这样,我们能够专注于更抽象的任务,就像我们今天不再需要做快速的心算,因为有了计算器。积分和微分方程我们需要学习基础知识,但也可以借助计算机工具完成。

AI会提升我们处理问题的抽象层次,让我们更具创造力和生产力。很多你和我学过的技能,在未来我们的后代可能不需要再学,因为这些都将被自动化解决。

主持人 Nikhil Kamath :机器代替人类去上学了?

LeCun :不会的,我们仍然会去上学。我们需要教育自己,还会存在人类之间的竞争,比如谁能做得更好、更有创造性。

主持人 Nikhil Kamath :竞争是本能,对吧?

LeCun :是的。我们不会缺少工作机会。经济学家告诉我,我们不会用完工作,因为问题永远存在,但我们可以借助AI找到更好的解决方案。

主持人 Nikhil Kamath :或许我们今天可以结束于尝试定义“智能”是什么。我记下了一些想法:智能是信息的集合以及吸收新技能的能力。

LeCun :智能是一组技能的集合,以及快速学习新技能的能力,或者是在不学习的情况下解决问题的能力。在AI领域,这被称为“零样本学习”(zero-shot)。当你面对一个全新的问题,尽管从未遇到过类似的问题,但你可以通过思考和使用你对情境的认知模型来解决它。这就是“零样本学习”。你无需学习新技能,而是从头解决问题。

因此,智能是这三者的结合:已经掌握的技能和解决问题的经验、通过少量尝试快速学习新技能的能力,以及面对新问题时无需学习新技能就能解决问题的能力。