编辑 | 言征

出品 | 51CTO技术栈(微信号:blog51cto)

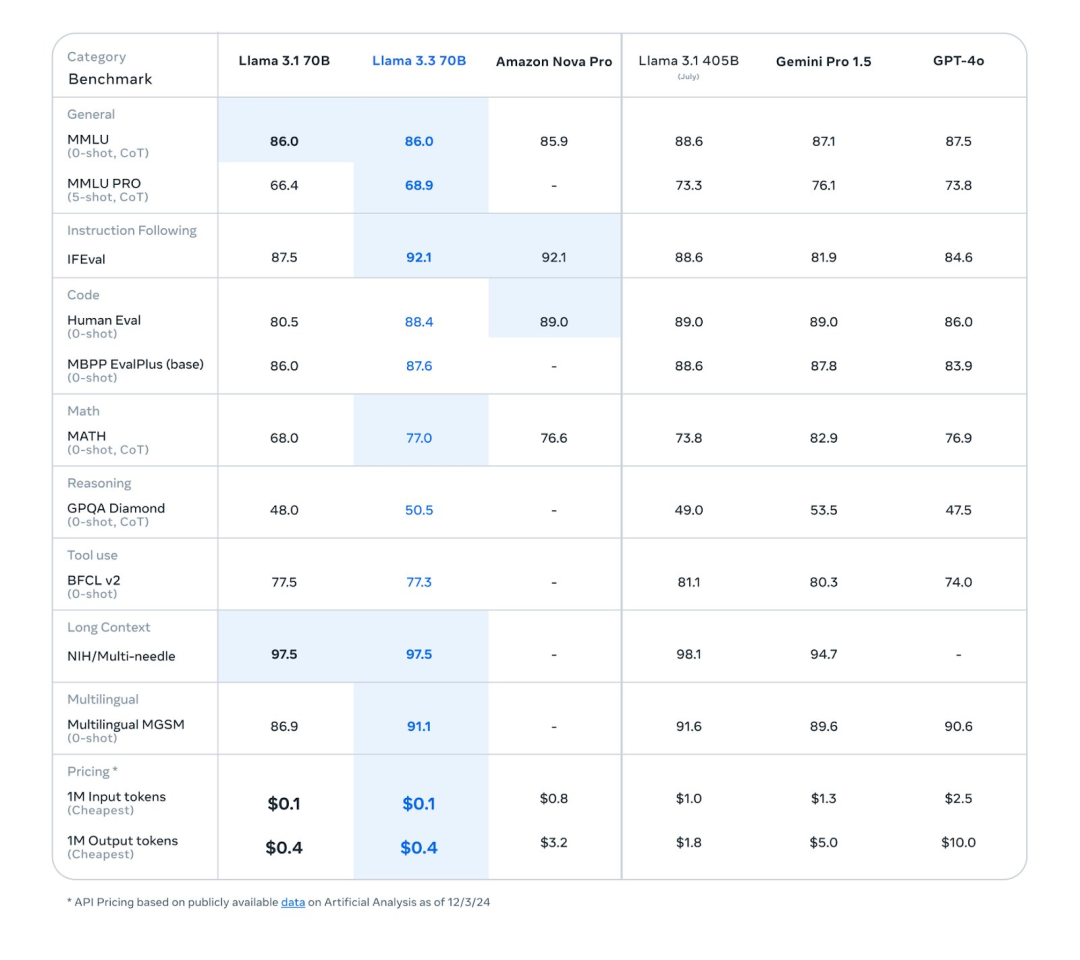

7日凌晨,Meta 推出了 Llama 3.3。虽然参数没有太高,只有700亿参数,但与之前开源的Llama 3.1 4050亿参数模型性能相当,而推理、部署成本却降低了很多。

例如,输入成本降低了10倍,输出成本降低了近5倍。

此外,这款多语言 LLM,旨在重新定义 AI 在合成数据生成中的作用。Llama 3.3 拥有 700 亿个参数,其性能与之前的 405B 型号一样,但针对效率和可访问性进行了优化。

图片

图片

其多语言输出支持多种语言,包括印地语、葡萄牙语和泰语,使世界各地的开发人员能够为专门的 AI 模型创建自定义数据集。

“随着我们继续探索新的后训练技术,今天我们发布了 Llama 3.3——一种新的开源模型,它在基于文本的使用案例(例如合成数据生成)中提供领先的性能和质量,而推理成本只是其中的一小部分,”Meta 在 X 上分享道。

1.推动合成数据的生成

开发人员现在可以使用其扩展的 128k 令牌上下文长度来生成大量高质量的数据集,从而解决隐私限制和资源限制等挑战。

Meta 的 AI 主管 Yann LeCun 此前表示,这种能力可以在低资源语言中实现创新,印度企业家 Nandan Nilekani 也表达了同样的观点。“印度应该专注于快速构建小型的、特定于用例的模型,”Nilekani 说,并强调了 Llama 在为印度语模型生成定制训练数据方面的关键作用。

这种方法的成功在 Sarvam AI 的 Sarvam 2B 等项目中显而易见,它通过利用 Llama 生成的合成数据,在 Indic 任务中优于大型模型。

Meta 的 ML 工程师 Hamid Shojanazeri 表示,合成数据生成解决了收集真实世界数据集成本太高或不可行的领域的关键瓶颈。“合成数据对于在隐私敏感领域或资源匮乏的语言中推进 AI 至关重要,”他补充道。凭借其 RLHF 调优和监督微调,Llama 3.3 为需要高精度的任务生成指令对齐的数据集。

像 Sarvam AI 和 Ola Krutrim 这样的印度初创公司已经从 Llama 的能力中受益。Sarvam AI 在 2 万亿个合成 Indic 代币上训练的 2B 模型展示了这些数据如何有效地训练更小的专用模型,同时保持高性能。

“如果你看一下印度语言中的 1000 亿个令牌,我们用了一种聪明的方法来创建合成数据,以使用 Llama 3.1 405B 构建这些模型。我们在印度的 1024 台 NVIDIA H100 上训练了模型,只用了 15 天,“Sarvam AI 首席执行官 Vivek Raghavan 在接受 AIM 采访时说。

同样,Llama 3.3 的多语言支持和可扩展性使其成为弥合代表性不足的语言数据鸿沟不可或缺的工具。

Llama 3.3 支持合成数据生成的能力超越了小众用例,促进了开发人员、教育工作者和企业的广泛采用。“通过降低生成高质量训练数据的成本,Llama 加速了全球创新,”Meta 生成式 AI 副总裁 Ahmad Al-Dahle 说。

图片

图片

随着对 GPT-4.5 的猜测愈演愈烈,Llama 3.3 果断介入以满足开发人员的即时需求。凭借其革命性的合成数据生成方法和成本效益,很明显,Llama 3.3 不仅填补了空白,而且树立了新标准。

“我的合成数据成本下降了 30 倍,”KissanAI 的联合创始人 Pratik Desai 在 X 上说。

2.Llama3.3:后训练微调

这里简单介绍一下Llama3系列的模型发布版本和节奏。大家就能理解Llama3.3-70B-Instruct在Llama系列的地位和目标。

目前,Llama3系列包含了4个不同的版本,分别是2024年4月份发布的Llama3系列、2024年7月份发布的Llama3.1系列、2024年9月份发布的Llama3.2系列以及2024年12月初发布的这个3.3系列。

但是,其实Llama3和Llama3.1算是比较正常的大版本节奏,因为这两个系列都包含了最小80亿参数,最大700亿以及4050亿参数规模的多个不同版本模型。

而Llama3.2系列其实只发布了1B和3B的小规模纯文本语言模型以及11B和90B的多模态版本,基本上算是Llama3.1的补充。

本次发布的Llama3.3-70B-Instruct官方也介绍说是后训练技术的迭代,这意味着其基座模型可能还是Llama3.1-70B,只是用不同的后训练或者指令微调技术迭代获得的。

3.为 Llama 4 奠定基础

Llama 3.3 的发布完全符合 Meta 的长期 AI 战略。正如扎克伯格在 Meta 的第三季度财报电话会议上透露的那样,即将于 2025 年初推出的 Llama 4 将引入“新模式、更强的推理和更快的功能”。这表明,在 Llama 3.3 中改进的合成数据生成功能在未来的迭代中可能会变得更加强大。

Meta 的副总裁 Ragavan Srinivasan 最近暗示了未来 Llama 模型“基于内存的编码和跨模态支持应用程序”的进步。Llama 3.3 的合成数据功能建立的强大框架可能是这些发展不可或缺的一部分。通过使开发人员能够生成特定领域的训练数据集,Meta 将自己定位为私营和公共部门创新的关键推动者。

未来的 Llama 版本可能会支持更广泛的语言和专业用例。随着合成数据生成成为 AI 开发的核心,Llama Guard 3 等工具和增强的标记化方法将确保安全、负责任地使用。

开源地址:https://huggingface.co/meta-llama/Llama-3.3-70B-Instruct

参考链接:https://analyticsindiamag.com/ai-origins-evolution/fine-tuning-is-dead-long-live-reinforcement-fine-tuning/