人工智能顶会NeurIPS 2024大会公布了本年度最佳论文奖,今年大会共收到15671篇论文,最终接收率只有25.8%,其中两篇文章获得最佳论文奖

一是由北大与字节跳动团队共同完成的《Visual AutoRegressive Modeling: Scalable Image Generation via Next-Scale Prediction》(VAR)获得(尴尬的是论文一作田柯宇被字节起诉,我们这里就不八卦了,网上有很多瓜,还是专注于解读技术)。这篇论文提出了一种颠覆性的新型图像生成框架,不仅首次让自回归模型超越扩散模型,还开创了“逐尺度预测”的全新范式,为视觉生成领域开辟了全新的方向

另一篇是由新加坡国立大学、 Sea AI Lab 研究者共同完成的《Stochastic Taylor Derivative Estimator: Efficient amortization for arbitrary differential operators》论文一作为 Zekun Shi

北大与字节的获奖论文推出的模型VAR是首个在视觉领域验证“规模化定律”的模型,个人认为这是中国本土从0到1的生成式人工智能基础研究重大突破

paper:https://openreview.net/pdf?id=gojL67CfS8

paper:https://openreview.net/pdf?id=gojL67CfS8

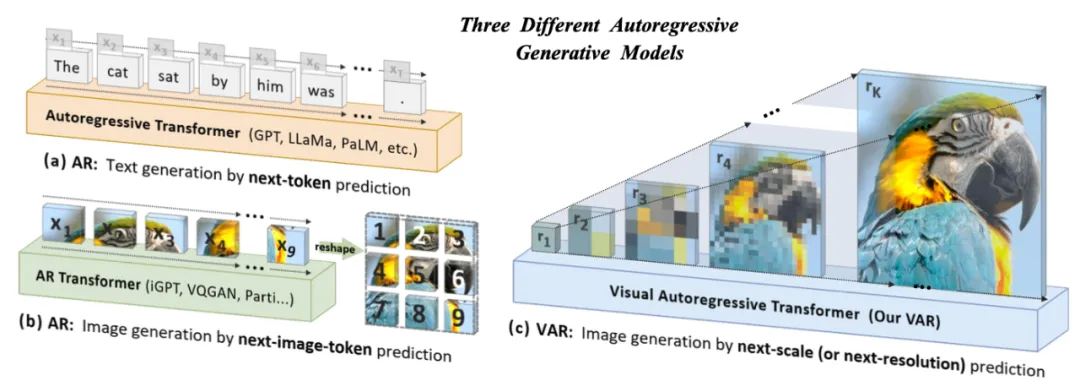

从“逐像素”到“逐尺度”

VAR模型最核心的创新在于重新定义了图像生成的过程,将传统的逐像素生成方式彻底颠覆:

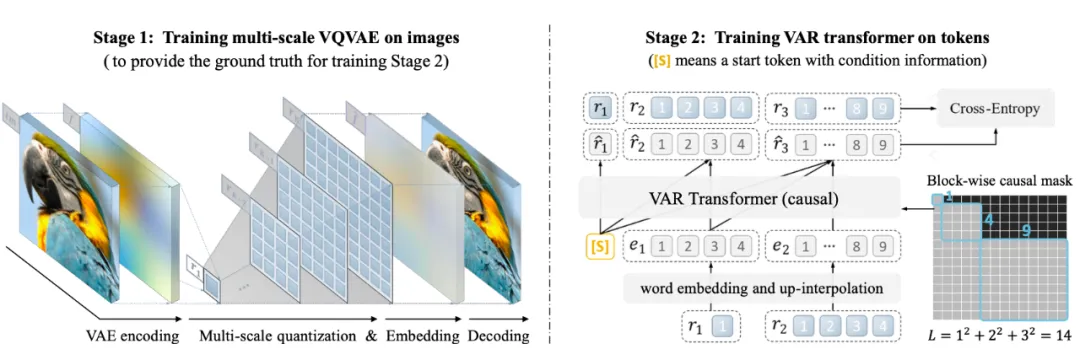

1. 多尺度预测的新范式

传统自回归方法采用“逐像素”的方式,即从图像的左上角逐行生成,依赖每个像素的前置依赖。这种方法不仅效率低,还容易丢失图像的全局结构感。而VAR模型则通过引入多尺度VQVAE,将图像分解为从粗到细的多层次token。生成时,VAR从最低分辨率的全局token开始,逐层生成更高分辨率的细节,从而实现了对图像的“逐尺度预测”

实现细节:

• 首先通过多尺度VQVAE将原始图像编码为多层分辨率token

• 在每一层分辨率上,自回归模型并行生成token,并利用上下文信息预测更高分辨率的细节

这种方式不仅保留了图像的空间局部性,还避免了传统方法中将图像展平成一维序列所引入的空间破坏

2. 效率的极大提升

传统自回归模型需要逐像素生成,每个步骤依赖所有前置像素,时间复杂度高达

VAR则通过“逐尺度并行”的方式,将复杂度降低至

这一优化使VAR在推理速度上比扩散模型快20倍,同时接近于GAN的实时生成速度

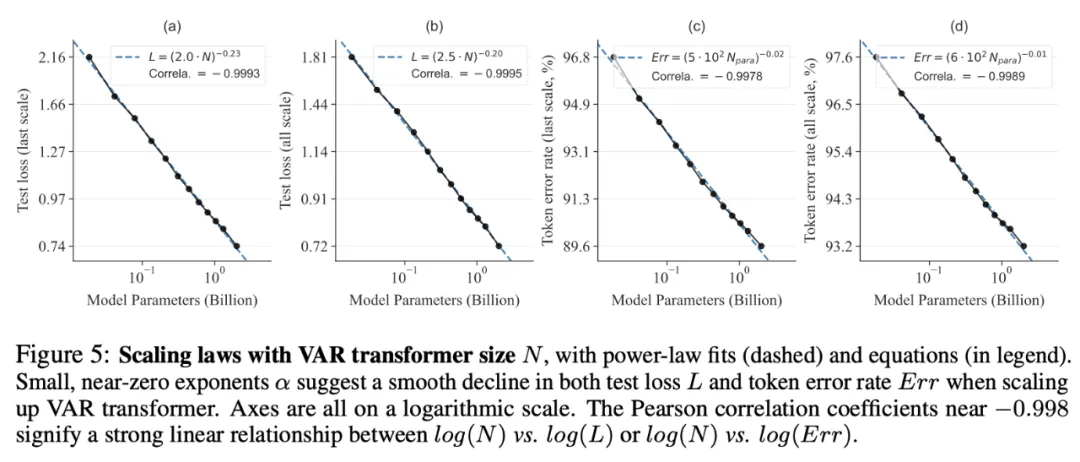

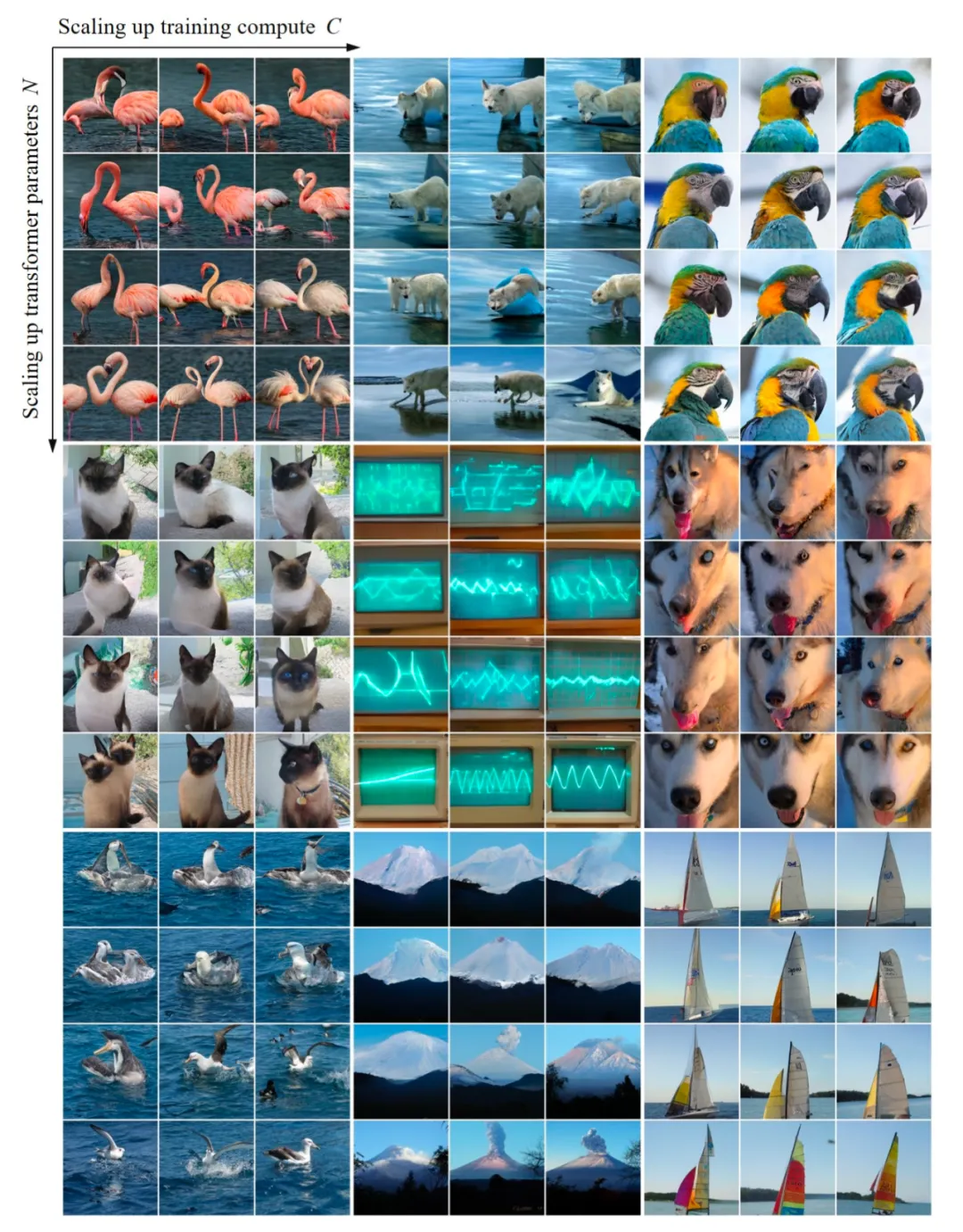

3. 视觉生成的“Scaling Law”

VAR模型首次在视觉领域系统性地验证了‘规模化定律’,展示了模型参数和训练计算量与性能提升之间的强线性关系。团队通过实验发现,VAR模型的性能随着参数规模的增加呈现出线性提升,与大语言模型的扩展性相似。这种特性不仅使VAR在图像生成中具备更强的性能预测能力,还为更高效的资源分配提供了理论依据

通过实验对VAR模型进行规模化(即增大模型参数和计算量)时的学习效果进行可视化分析,并验证了规模化定律的有效性

首度击败扩散模型

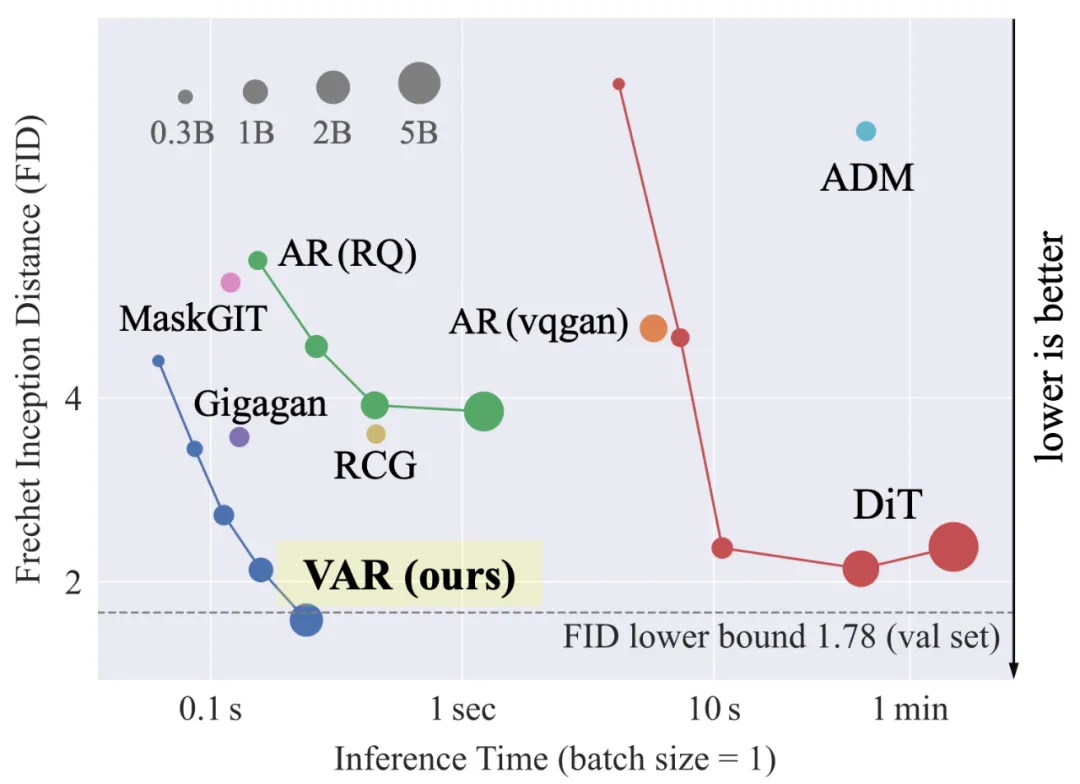

在ImageNet 256×256基准测试中,VAR的表现堪称惊艳:

1. 生成质量

VAR的FID分数达到1.73(分数越低越好),显著超越扩散模型(如DiT-XL/2的2.27)和传统自回归方法(如VQGAN的15.78)

在IS(生成图像多样性)指标上,VAR也达到了350.2的高分

2. 推理速度

VAR比扩散模型快20倍,并且在计算资源消耗上更高效。它仅需10步推理即可生成高质量图像,而扩散模型通常需要250步以上

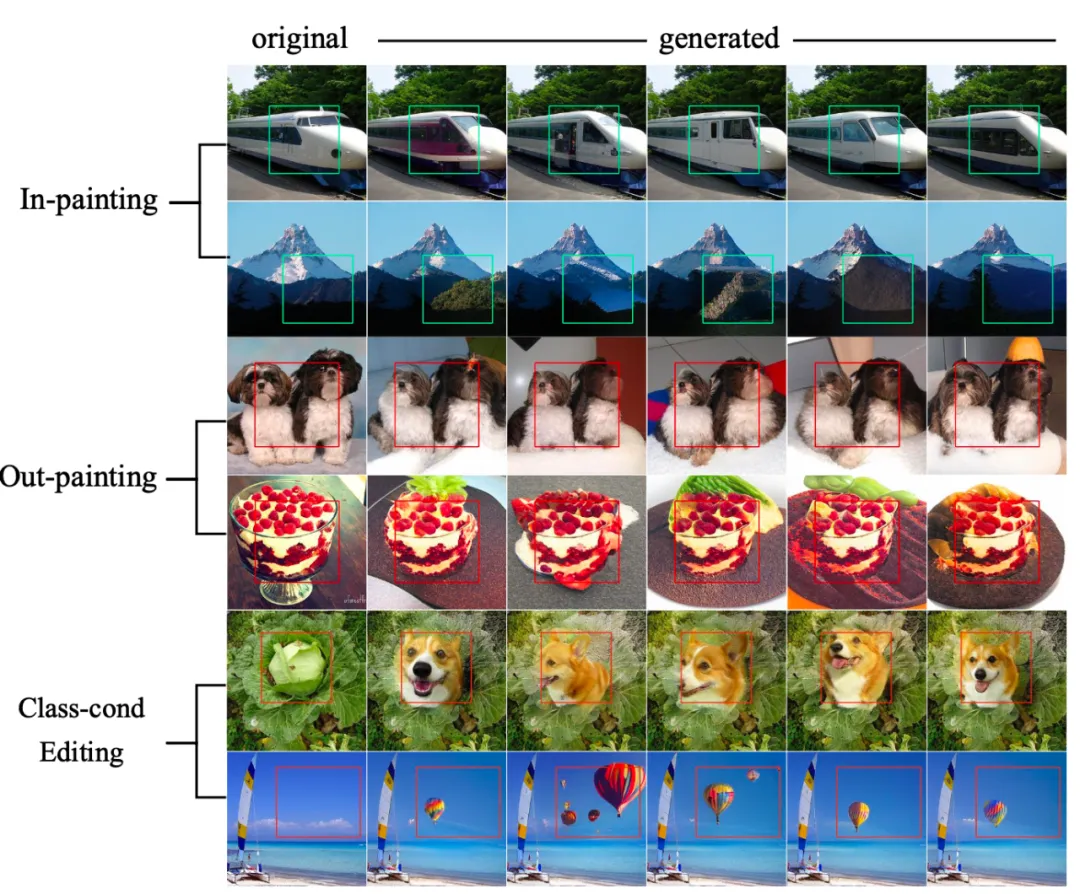

3. 零样本泛化能力

VAR无需额外训练即可胜任多种任务,包括图像修复(in-painting)、扩展(out-painting)以及条件编辑。这一能力得益于VAR对图像多尺度结构的深度建模,使其在陌生任务中也能展现出惊人的灵活性

从图像到多模态智能

VAR的潜力不仅局限于图像生成,其应用场景和未来发展方向同样令人期待:

- 1. 文本到图像生成:团队计划将VAR与大型语言模型结合,实现更强大的文本到图像生成能力,例如通过提示生成高质量的插画或艺术作品

- 2. 视频生成的革命:VAR天然支持视频生成的扩展,通过将“逐尺度预测”应用于时间维度,VAR有望解决传统视频生成方法在时间一致性上的难题,为影视制作和虚拟现实领域注入新活力

- 3. 产业应用:在游戏开发、电影特效、教育可视化等领域,VAR模型将为用户提供更快、更高效的视觉生成解决方案

结语:

VAR模型的成功不仅是技术上的突破,更是一种范式转变。它让我们看到,大语言模型的成功经验可以移植到视觉领域,从而激发出更强大的多模态智能。随着更多模型代码和数据的开源,VAR有望成为视觉生成领域的开山之作,推动下一代AI技术的发展

VAR项目地址:

https://github.com/FoundationVision/VAR