爆炸消息——

ViT三大核心作者集体离职谷歌DeepMind。下一站:OpenAI!

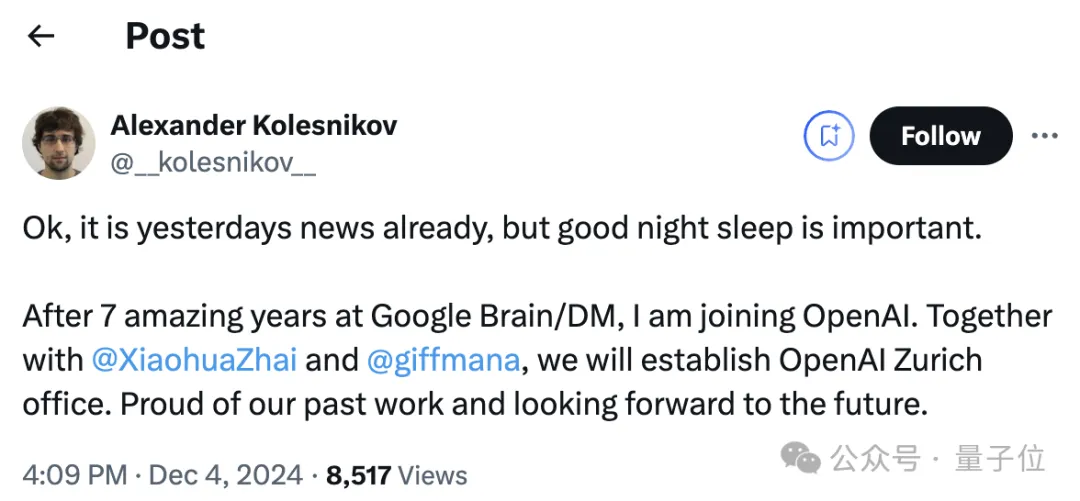

他们分别是翟晓华(Xiaohua Zhai)、卢卡斯·拜尔(Lucas Beyer)、亚历山大·科列斯尼科夫(Alexander Kolesnikov)。

相关消息已被本人证实,三人均官宣了新动向。

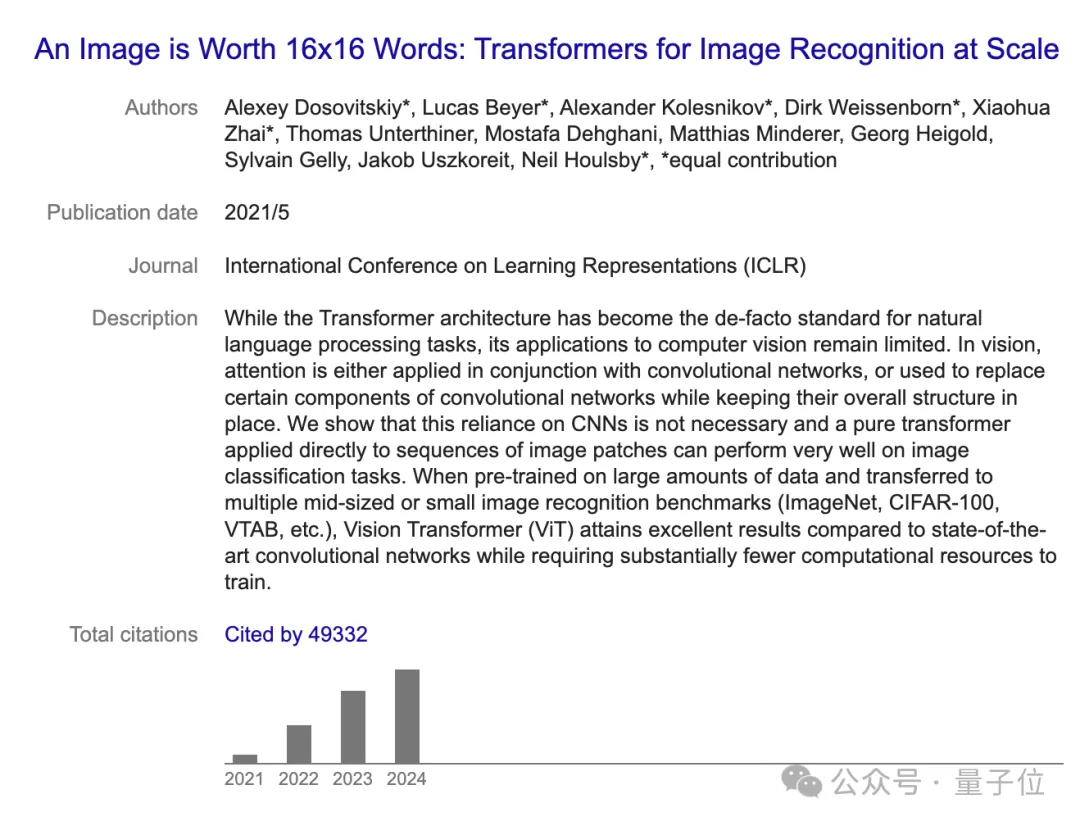

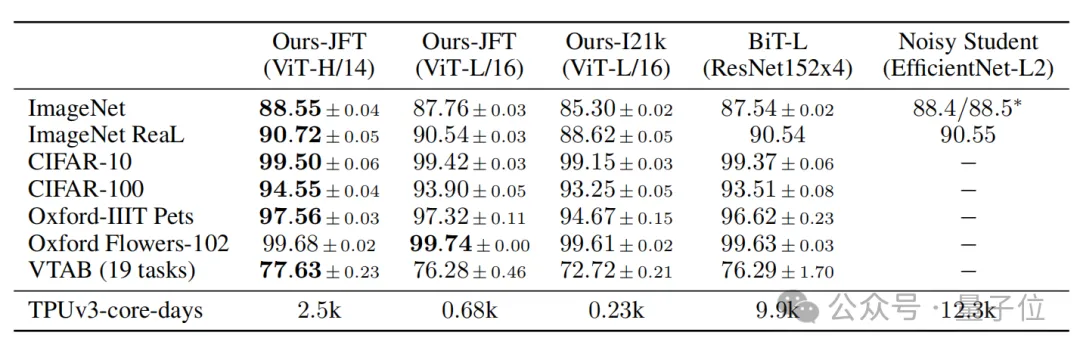

2021年,他们三人作为共同一作的计算机视觉领域神作ViT发布即刷新ImageNet最高分。

这项研究证实了CNN在CV领域不是必需的,Transformer从NLP跨界,一样可以取得先进效果。开创了Transformer在CV领域应用的先河。

目前这篇论文被引用量已超过4.9万。

此外,他们还共同提出了SigLIP、PaliGamma等SOTA级工作。

几周后,他们将正式加入OpenAI苏黎世实验室。

值得一提的是,Wired方面消息称,三人是被OpenAI挖走的。

网友评论:能撬动这一“铁三角”黄金组合,OpenAI真的太幸运了。

ViT三大核心作者投奔OpenAI

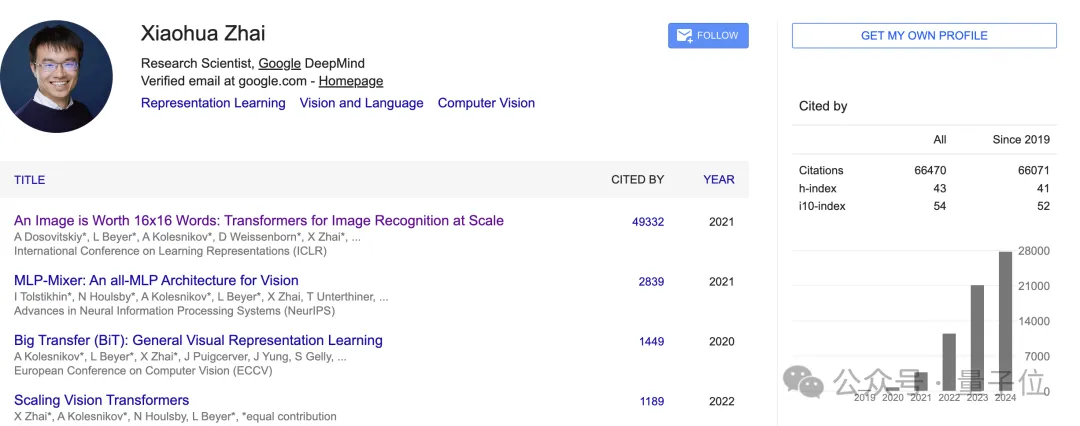

Xiaohua Zhai(翟晓华)

此前他是Google DeepMind 的高级研究员,领导着苏黎世一个多模态研究小组。重点研究多模态数据(WebLI)、开放权重模型 ( SigLIP、PaliGemma )以及文化包容性。

目前谷歌学术引用数超六万多。

2014年他毕业于北京大学,获得计算机系博士学位;本科毕业于南京大学。一毕业就前往谷歌苏黎世工作。

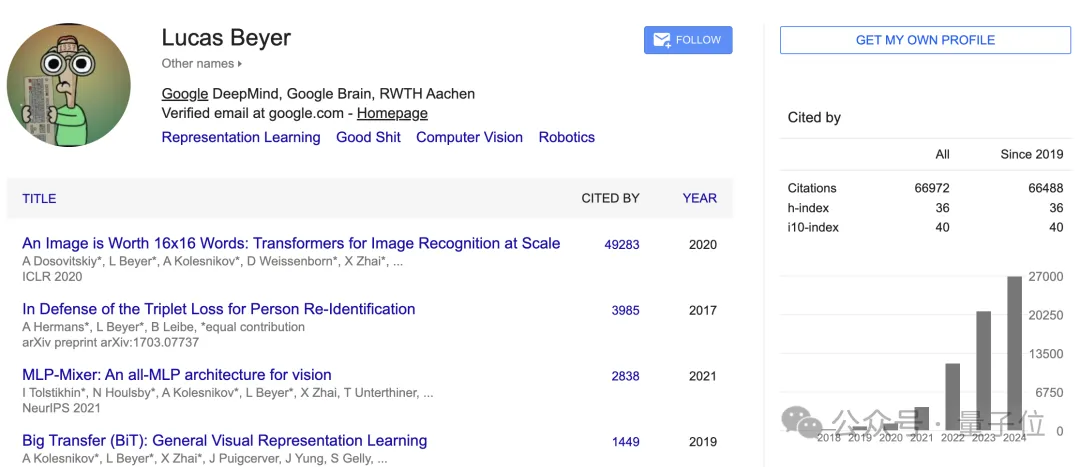

Lucas Beyer

这位同样也是谷歌DeepMind苏黎世小组的一位成员,共同领导着DeepMind的多模态研究团队和基础设施。

目前已经撰写超50篇论文,被CVPR、NeurIPS、ICCV 等这些顶级会议接收。

据他个人官网中介绍,他在比利时长大,曾梦想制作电子游戏以及从事AI研究。自我认定为「自学成才的黑客和研究科学家,致力于创造飞凡实物」。

他在德国亚琛工业大学学习机械工程,并在那里获得了机器人感知和计算机视觉博士学位。2018年加入谷歌。

Alexander Kolesnikov

2018年以来,他就在谷歌大脑,现为DeepMind团队工作。之前主要成就包括训练SOTA视觉模型*(从2019年到2021年都实现了ImageNet SOTA);开放权重模型(SigLIP和PaliGemma),以及神经架构方面的工作:BiT、ViT、MLP-Mixer和FlexiViT。

除此之外,编写灵活、高性能的研究基础设施,尤其是Jax。

此前,他在奥地利科学技术研究所(ISTA)攻读博士学位,研究方向是弱监督学习和图像生成模型。

曾是谷歌CV的“黄金铁三角”

在谷歌任职期间,三人多次合作并带来了影响领域发展的重要工作。

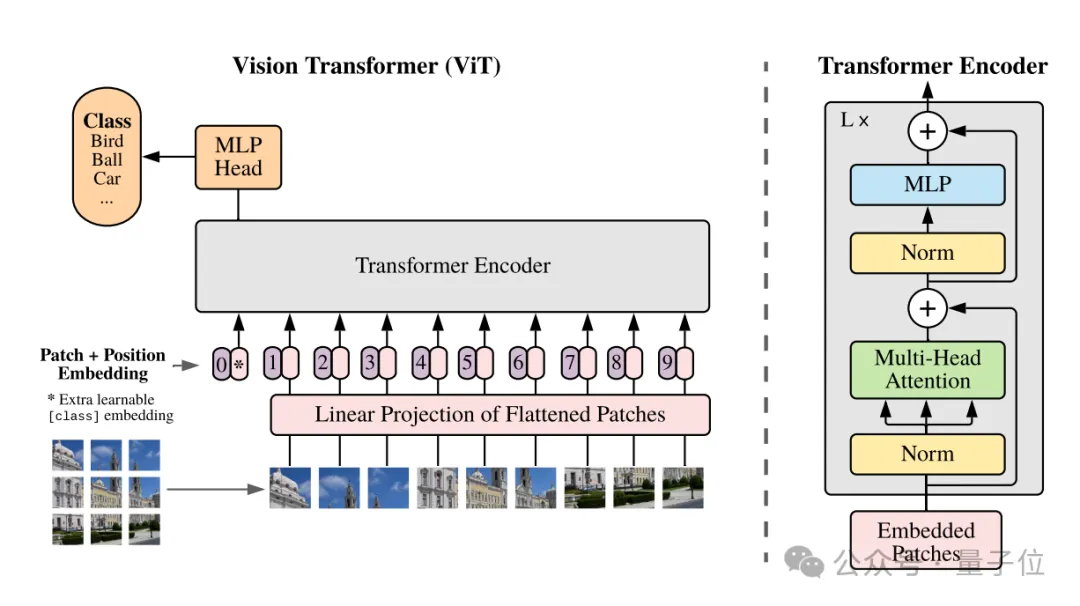

其中最重要的一篇莫过于ViT。

这篇研究验证了Transformer架构在计算机视觉领域的通用性。在它的基础上衍生出了Swin Transformer、DeiT(Data-efficient Image Transformers)等。

它创新性提出将图像分割成固定大小的块(patches),并将每个块视为一个序列元素,与NLP中的单词类似。然后,这些块通过变换器进行处理。

在许多视觉任务中,ViT在性能上超过了传统的CNN模型,尤其是在大规模数据集上进行训练时表现尤为突出。例如,在ImageNet分类任务中,ViT取得了与最先进的CNN模型相当甚至更好的结果。

此外他们还合作推出了MLP-Mixer、BiT(CV界的BERT)等领域内知名工作。

参考链接:

[1]https://www.wired.com/story/openai-hires-deepmind-zurich/。

[2]https://kolesnikov.ch/。

[3]https://sites.google.com/view/xzhai。

[4]https://lucasb.eyer.be/。