编辑 | 伊风

出品 | 51CTO技术栈(微信号:blog51cto)

AI视频领域持续不断有新玩家入局!

12月3日,腾讯出手了,不仅在元宝APP里上线AI视频功能,还直接开源了混元视频模型!

图片

图片

(打开元宝APP,若没有找到入口的话,可以检查是否更新到了最新版本,目前可能会有排队时间。)

腾讯一来就干了票大的:直接开源了AI视频里最大的模型——130 亿参数!

开源地址:https://github.com/Tencent/HunyuanVideo

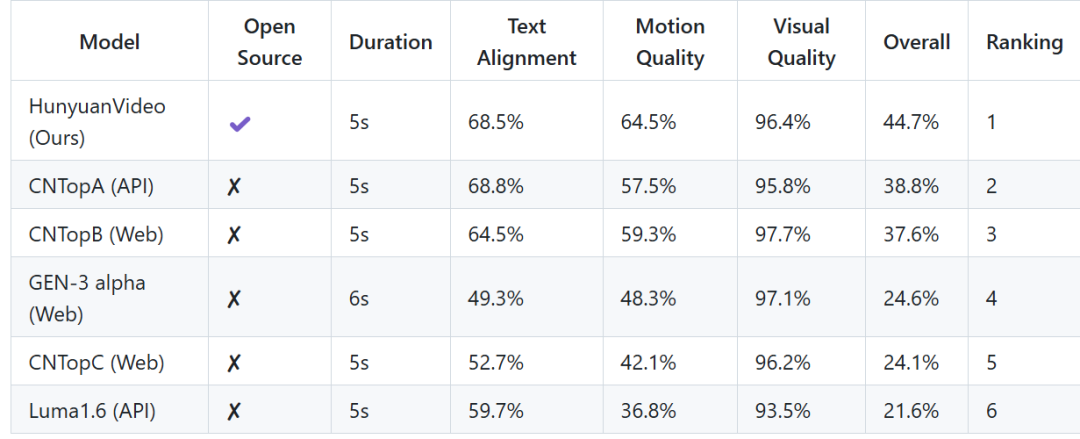

混元团队对HunyuanVideo的性能也很有信心,“其视频生成性能可与领先的闭源模型媲美,甚至在某些方面更胜一筹”。

这源于背后能打的战绩,混元一挑5个闭源模型,排位第一!(注:GEN-3来自Runway 公司;Luma 1.6来自 Luma AI,CNTop系列来自系列腾讯旗下的映技派)

图片

图片

AI视频生成的文本对齐、动作质量和视觉质量没有统一的“题库”,需要人的判断。

我们先来看看腾讯自己的demo。

然后小编又用Sora经典的Prompt测试了一下,大家来看看效果如何:

电影预告片,讲述了一位30岁的太空人的冒险故事。他戴着一顶红色羊毛针织摩托车头盔,背景是蓝天和盐碱沙漠。影片采用电影化风格,使用35毫米胶片拍摄,色彩鲜艳。

一段超真实的特写视频,展示了两艘海盗船在一杯咖啡中激烈交战,咖啡的液面如同海洋,船只在其中航行,波涛汹涌,炮火四射。

看完了视频生成效果,我们来看看HunyuanVideo的4个技术层面的特点!

1.统一图像和视频生成架构

HunyuanVideo 采用的也是 Transformer 设计,使用了全注意力机制来实现统一的图像和视频生成。

具体而言,混元采用了“从双流到单流”的混合模型设计进行视频生成。在双流阶段,视频和文本标记通过多个 Transformer 块独立处理,使每种模态能够学习其适当的调制机制,而不相互干扰。在单流阶段,我们将视频和文本标记连接起来,并将它们输入到后续的 Transformer 块,以有效地融合多模态信息。

这一设计捕捉了视觉和语义信息之间的复杂交互,增强了整体模型性能。

2.MLLM 文本编码器

不同于文本到视频模型通常使用预训练的 CLIP 和 T5-XXL 作为文本编码器(其中 CLIP 使用 Transformer 编码器,而 T5 使用编码器-解码器结构。)

混元采用了预训练的多模态大型语言模型(MLLM)。

根据他们的技术报告,采用解码器-only 结构作为文本编码器,有以下优点:

(i) 与 T5 相比,经过视觉指令微调后的 MLLM 在特征空间中具有更好的图像-文本对齐性,从而缓解了扩散模型中指令跟随的难度;(ii) 与 CLIP 相比,MLLM 在图像细节描述和复杂推理上表现出了更强的能力;(iii) MLLM 可以通过跟随系统指令来作为零样本学习者,帮助文本特征更好地关注关键信息。此外,MLLM 基于因果注意力,而 T5-XXL 使用的是双向注意力,后者为扩散模型提供了更好的文本指导。因此,我们引入了额外的双向标记细化器来增强文本特征。

3.3D VAE

HunyuanVideo 使用 CausalConv3D 训练 3D VAE,将像素空间的视频和图像压缩到紧凑的潜在空间中。

HunyuanVideo设置了视频长度、空间和通道的压缩比分别为 4、8 和 16。这可以显著减少后续扩散 Transformer 模型所需的标记数量,使我们能够以原始分辨率和帧率训练视频。

4.提示重写

为了应对用户提供的提示在语言风格和长度上的差异,团队对 Hunyuan-Large 模型进行了微调,作为我们的提示重写模型,将原始用户提示转换为模型偏好的提示。

混元提供了两种重写模式:普通模式和大师模式,可以通过不同的提示进行调用。普通模式旨在增强视频生成模型对用户意图的理解,促进更准确地解释用户提供的指令。大师模式则增强了构图、照明和镜头运动等方面的描述,更倾向于生成具有更高视觉质量的视频。然而,这种侧重点有时可能导致某些语义细节的丧失。