LobeChat与Oallam整合

随着人工智能技术的不断发展,聊天机器人已经成为许多企业和个人用户的得力助手。LobeChat作为一款开源、高性能的AI会话应用框架,提供了丰富的功能和灵活的扩展性。而Oallam作为一个开源的大模型托管和服务平台,为开发者提供了便捷的模型下载和推理服务。本文将详细介绍如何将LobeChat与Oallam进行整合,以打造一个功能强大的聊天机器人。

LobeChat简介

LobeChat是一个基于Next.js框架构建的AI会话应用,旨在提供一个AI生产力平台,使用户能够与AI进行自然语言交互。其核心组件包括前端、EdgeRuntime API、Agents市场和插件市场等。LobeChat支持多种模型服务提供商,如OpenAI、Claude、Gemini等,并提供了视觉识别、语音合成、文本到图片生成等功能。

Oallam简介

Oallam是一个开源的大模型托管和服务平台,支持在Windows、macOS、Linux或Docker中安装。它提供了便利的模型下载和推理功能,使得大模型的落地变得简单易行。Oallam支持多种大模型,如llama3.1、gemma2等,并允许用户通过简单的命令来启动和管理模型服务。

整合步骤

1. 安装Oallam

首先,需要在本地安装Oallam。根据操作系统选择合适的安装包进行下载和安装。安装完成后,可以通过命令行启动Oallam服务,并下载所需的大模型。

# 下载并安装Oallam

curl -fsSL https://ollama.com/install.sh | sh

# 启动Oallam服务

ollama serve

# 下载大模型(以gemma2为例)

ollama run gemma2:27b2. 安装LobeChat

LobeChat支持多种部署方式,包括Docker容器化部署和Vercel自托管版本。

- 基于docker安装

# 拉取LobeChat Docker镜像

$ docker pull lobehub/lobe-chat

# 创建并启动LobeChat容器

$ docker run -d -p 3210:3210 \

-e OPENAI_API_KEY=sk-xxxx \

-e OPENAI_PROXY_URL=https://api-proxy.com/v1 \

-e ACCESS_CODE=lobe66 \

--name lobe-chat \

lobehub/lobe-chat- 本地安装

$ git clone https://github.com/lobehub/lobe-chat.git

$ cd lobe-chat

$ pnpm install

$ pnpm dev3. 配置LobeChat以使用Oallam模型

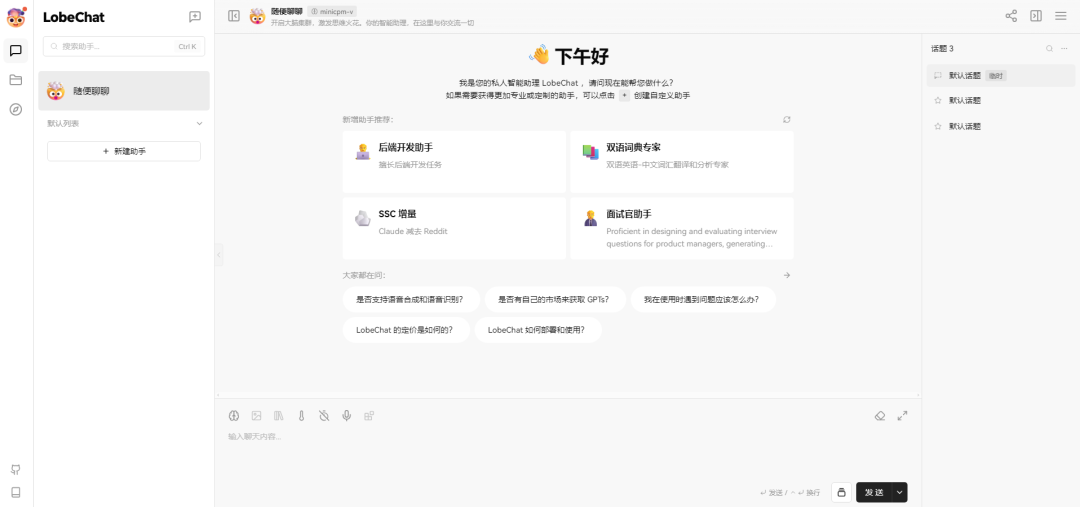

启动LobeChat容器后,需要在浏览器中访问http://localhost:3210来打开LobeChat的WebUI。首次打开时,如果提示登录,请输入安装命令中设置的ACCESS_CODE访问密码。

接下来,进行以下配置步骤:

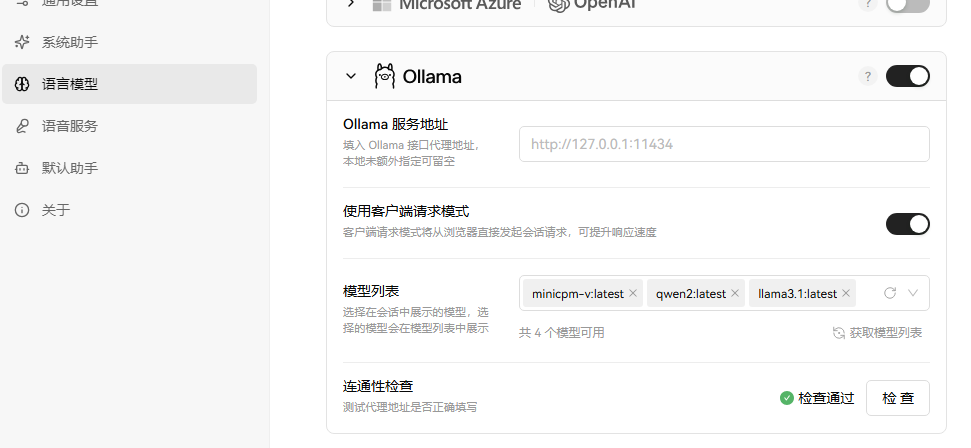

- 点击左上角的头像,在菜单中选择应用设置。

- 切换到语言模型,找到Oallam,并打开右侧的开关。

- 配置Oallam服务地址:如果是本地部署的,直接填写http://127.0.0.1:11434。

- 使用客户端请求模式:打开此选项,否则Oallam服务地址的配置可能会比较复杂。

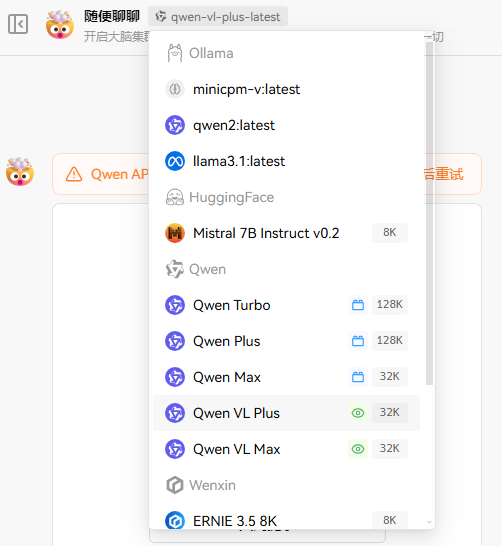

- 配置模型列表:配置好Oallam服务地址后,模型列表会自动显示可用的模型,选择所需的模型即可。

4. 测试整合效果

配置完成后,回到LobeChat的主页面,打开一个新的聊天界面,选择配置好的Oallam模型,即可开始与聊天机器人进行对话。此时,聊天机器人将使用Oallam模型进行自然语言处理和回复生成。^[6]^

- 进入系统

图片

图片

- 选择模型

图片

图片

可以在终端通过oallam下载模型:

# 查看可用模型 https://ollama.com/library

# 下载并运行模型

ollama run qwen2在lobe中启用模型:

图片

图片

聊天界面中选择模型即可:

图片

图片

整合优势

- 灵活性:通过整合LobeChat和Oallam,开发者可以灵活选择和使用不同的大模型,满足不同场景下的需求。

- 可扩展性:LobeChat的插件系统和Agents市场使得功能扩展变得简单易行,开发者可以根据需要添加新的功能和模块。

- 高性能:Oallam提供的高效模型推理服务结合LobeChat的优化设计,可以确保聊天机器人的快速响应和高性能表现。

- 易用性:LobeChat和Oallam都提供了简单易用的安装和配置流程,降低了开发者的使用门槛。^

结论

通过整合LobeChat和Oallam,我们可以打造出一个功能强大、灵活可扩展的聊天机器人。这种整合不仅提高了聊天机器人的智能水平和响应速度,还为开发者提供了更多的选择和可能性。未来,随着人工智能技术的不断发展,我们有理由相信这种整合将会带来更加丰富的应用场景和更加出色的用户体验。