写在前面 & 笔者的个人理解

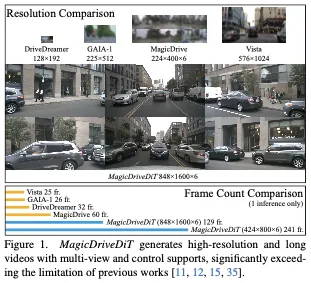

扩散模型的快速发展极大地改善了视频合成,特别是在可控视频生成方面,这对自动驾驶等应用至关重要。然而,现有的方法受到可扩展性和控制条件集成方式的限制,无法满足自动驾驶应用对高分辨率和长视频的需求。本文介绍了一种基于DiT架构的新方法MagicDriveDiT,并解决了这些挑战。我们的方法通过流匹配增强了可扩展性,并采用渐进式训练策略来管理复杂的场景。通过结合时空条件编码,MagicDriveDiT实现了对时空延迟的精确控制。综合实验表明,它在生成具有更高分辨率和更多帧的逼真街道场景视频方面具有优越的性能。Magic-DriveDiT显著提高了视频生成质量和时空控制,扩大了其在自动驾驶各种任务中的潜在应用。

- 项目主页:https://gaoruiyuan.com/magicdrivedit/

总结来说,本文的主要贡献如下:

- 本文设计了一个高效的框架MagicDriveDiT,利用渐进式引导来实现高质量的高分辨率长视频生成。

- 为目标位置、道路语义和相机轨迹开发了新的时空控制,同时保持了多帧、多视图的一致性。

- MagicDriveDiT通过混合分辨率和持续时间训练,从图像到视频生成都得到了很好的推广,具有外推能力,大大超过了之前工作中的分辨率和帧数。

相关工作回顾

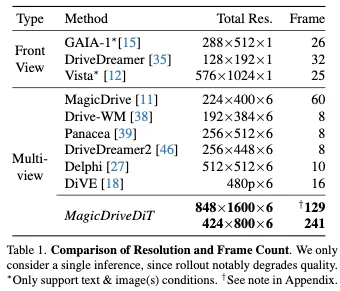

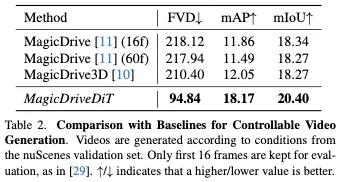

自动驾驶中的视频生成。视频生成对于自动驾驶至关重要,可应用于训练感知模型、测试和场景重建。它需要广阔的视野和动态目标运动处理,需要生成模型可控性和具有更多帧和多相机视角的高分辨率视频制作。扩散模型改进了可控多视图视频生成,但现有模型缺乏足够的分辨率和帧数,无法用于数据引擎应用和策略测试。如表1所示,我们的工作MagicDriveDiT在自动驾驶视频生成方面实现了前所未有的分辨率和帧数。

扩散模型和DiT架构。扩散模型通过学习从高斯噪声到样本的去噪步骤来生成数据,广泛应用于图像和视频生成。从建模的角度来看,流匹配简化了扩散模型的建模,提高了训练和推理的效率。从实现的角度来看,由于更好的可扩展性,扩散模型的架构从UNet转变为DiT,特别是对于高分辨率任务。我们的MagicDriveDiT还利用流匹配和DiT来扩展到高分辨率和长视频生成。

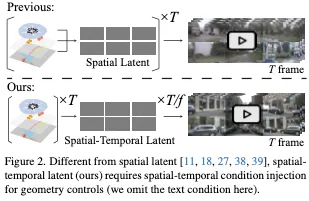

有条件生成。条件生成对于使用生成模型的各种应用程序至关重要。LDM和ControlNet的网格形控制信号加性编码的交叉关注层是可控扩散生成的领先方法。在街景生成中,MagicDrive和MagicDrive3D集成了3D边界框、BEV地图、自车轨迹和相机姿态,用于多视图街景合成。然而,这些方法仅限于空间编码,并不直接适用于时空VAE延迟,如图2所示。MagicDriveDiT为时空压缩的VAE延迟提供了一种新的控制范式,使高分辨率长视频的生成可控。

MagicDriveDiT方法详解

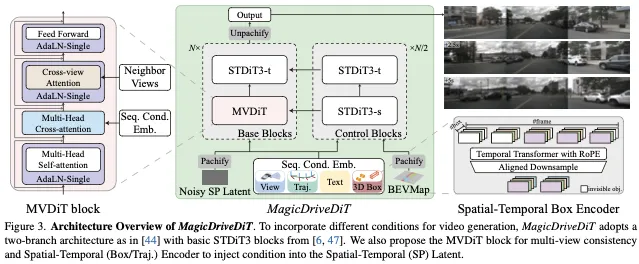

对于图3所示的模型架构,MagicDriveDiT引入了一种基于DiT的新型扩散模型,用于可控街景生成,,该模型利用STDiT-3块。这些块具有单独的空间和时间模块,以增强信息处理。

架构设计包含两个重大修改。首先为了促进多视图生成,多视图DiT(MVDiT)块集成了一个跨视图注意力层,如图3左侧所示。其次,考虑到需要处理多个控制元素,MagicDriveDiT对文本、框、相机视图和轨迹采用交叉注意力,同时对地图采用额外的分支来输入控制信号。

然而如图2所示,控制信号的空间编码与时空潜伏期不兼容。因此,每个控制信号的编码器都被重新制定,如图3右侧的时空框编码器所示。

此外,MagicDriveDiT采用渐进式引导训练策略,从图像过渡到低分辨率和短视频,最终过渡到高分辨率和长视频,以增强扩散模型的收敛性。最后的训练阶段包含可变长度和分辨率的视频,使模型能够生成不同分辨率的图像和视频,并推断出训练设置之外的更长帧数。

Design for High-Resolution Long Video

DiT和3D VAE。用于高分辨率和长视频生成的训练扩散模型是计算密集型的,需要大量的GPU内存。DiT和3D VAE在这些方面对扩散模型的缩放至关重要。

正如Peebles和Xie所指出的那样,模型Gflops和FID之间存在很强的负相关关系,这使得DiT在计算效率方面优于UNet等架构。对于GPU内存,3D VAE提供时间降采样。典型的2D VAE在高度和宽度上都将图像压缩8倍,达到64倍的压缩比。相比之下,3D VAE将时间信息压缩了4倍,得到了256倍的压缩比,显著减少了压缩后的潜在序列长度和内存消耗,这对转换器特别有利。此外,架构统一的趋势允许DiT利用先进的并行化方法,例如序列并行,来克服单个GPU内存的限制,从而促进更高的分辨率和更长的视频生成。

采用3D VAE的一个主要挑战是几何控制。如图2所示,几何控制在空间上管理每帧内容。使用2D VAE,T帧被编码为T延迟。使用T几何描述符,视频几何控制降级为对图像的空间控制,因为控制信号和延迟在时间上是对齐的。然而,3D VAE会产生T/f延迟(其中f是时间压缩比),使控制信号与延迟不匹配,并使之前的控制技术无效。

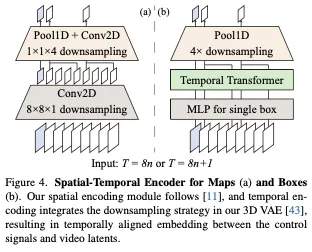

Spatial-Temporal Conditioning Techniques。对于MagicDriveDiT中的几何控制,我们引入了时空编码来将控制信号与时空延迟对齐。这涉及重新对齐场景描述符中的贴图、框和轨迹。以网格数据表示的地图易于管理。通过扩展ControlNet的设计,我们利用3D VAE中具有新可训练参数的时间下采样模块来对齐控制块和基块之间的特征,如图4(a)所示。

对于3D框,填充应用于不可见的框,以保持视图和帧之间框序列长度的一致性,如图3右侧所示。我们使用带有时间变换器和RoPE的下采样模块来捕获时间相关性,创建与视频延迟对齐的时空嵌入,如图4(b)所示。通过用相机姿势的MLP替换盒子的MLP,盒子的时空编码器也可以适应自车轨迹。所有下采样比都与采用的3D VAE对齐,即分别以8n或8n+1作为输入,2n或2n+1作为输出。

Progressive Bootstrap Training

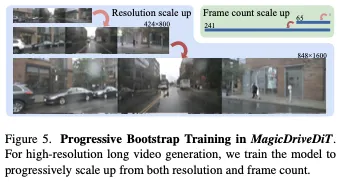

为了在训练过程中加快模型收敛,我们根据单次训练迭代的持续时间来调度训练数据。具体来说,我们采用三阶段训练方法:最初使用低分辨率图像进行引导训练,过渡到低分辨率短视频,最终采用高分辨率长视频训练。

这种训练策略基于两个观察结果。首先,在可控生成中,我们注意到,在学习可控性之前,该模型最初会针对更高的内容质量进行优化,Gao等人也观察到了这种模式。从头开始训练模型需要多次迭代才能收敛。我们的渐进过渡方法使模型能够更快地获得可控性。其次,在阶段转换期间,我们发现与长视频可控性相比,该模型更快地适应高分辨率。因此,我们从第一阶段开始训练可控性,并专注于用(短)视频而不是图像优化更多的迭代。

Variable Length and Resolution Adaptation

如前文所述,我们采用三阶段训练流程。在最后两个阶段,我们将不同分辨率和长度的视频用于训练。具体来说,在第二阶段,我们使用长度不超过65帧、最大分辨率为424×800的视频混合进行训练。在第三阶段,我们混合了高达241帧(数据集的最大帧数)和高达848×1600(数据集最大分辨率)的视频。

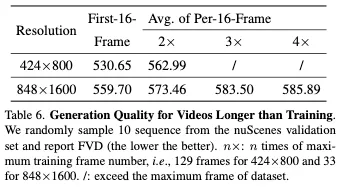

与单一分辨率和长度的训练相比,这种混合方法使模型能够快速理解分辨率和帧数维度的信息。因此,我们的最终模型支持生成各种分辨率(224×400、424×800、848×1600)和帧数(1-241帧)。它还支持跨两个维度的外推,允许在训练配置之外进行采样,例如129帧时的848×1600或241帧时的424×800。

实验

结果和分析

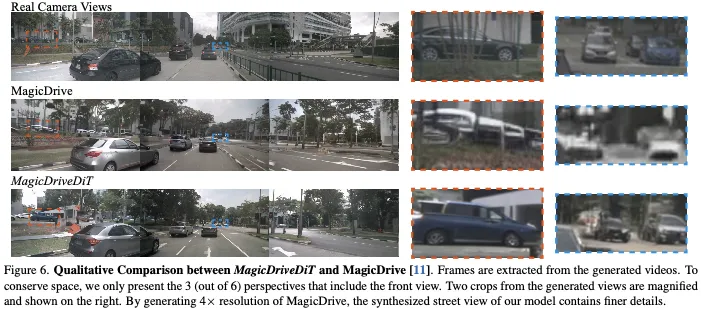

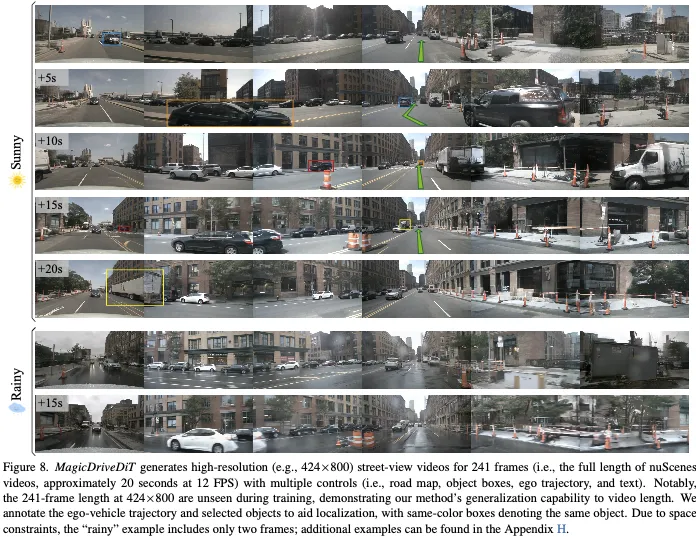

生成质量。MagicDriveDiT在视频和图像生成任务方面都表现出色。在视频任务中,与MagicDrive相比,它显著降低了FVD(表2),这是由于DiT架构增强了帧间一致性和时空条件编码,用于精确控制目标运动和定位。如图6所示,MagicDriveDiT生成的高分辨率视频不仅可以提高质量,还可以包含更复杂的细节,与真实相机拍摄的镜头非常相似。这一增强是通过我们对可变长度和分辨率的高级训练实现的,可以实现更真实和详细的输出。

MagicDriveDiT也受益于混合训练方法,能够生成图像。如表3所示,MagicDriveDiT在多视图街景任务中与基线性能相匹配,在车辆分割mIoU和目标检测mAP中超越了基线。这展示了我们时空条件编码的强大泛化能力。

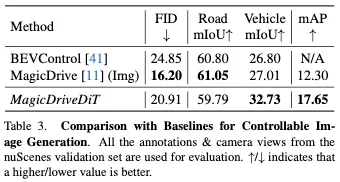

可控性。表2和表3中的定量结果表明,MagicDriveDiT生成的图像和视频有效地反映了控制条件。此外,图8提供了可视化结果,表明多个控制条件可以独立影响生成的内容。例如,天气可以通过文本输入(从晴天到雨天)来改变,同时保持道路结构以及其他车辆和自车的轨迹。通过改变条件的组合,MagicDriveDiT能够制作各种高质量的街景视频。

消融实验

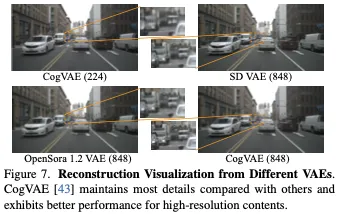

街道景观的VAE比较。在训练扩散模型之前,我们评估了开源3D VAE(即CogVAE和Open Sora)在街景上的性能,并与2D SD VAE进行了比较。如图7所示,CogVAE在重建能力方面始终优于同行。此外,如附录E所示,CogVAE在较长的视频序列上表现出最小的性能下降,使其特别适合长视频生成任务。此外,我们发现所有VAE都表现出随着分辨率的提高而提高的重建能力。这种见解有助于通过专注于更高分辨率的输出来提高我们的模型生成高质量图像和视频的能力。

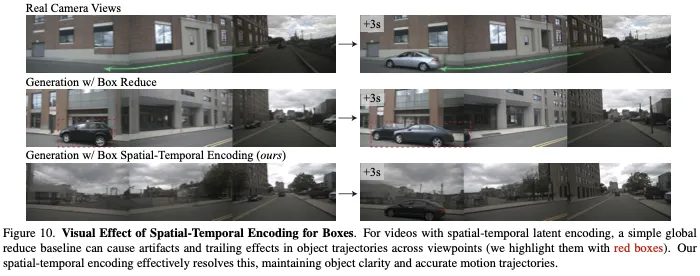

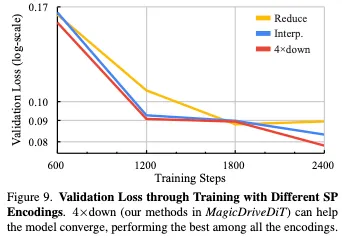

时空Conditioning。我们通过过拟合实验中的验证损失(图9)和可视化比较(图10)证明了时空编码器的有效性。我们比较了两种基线:全局时间维度缩减(Reduce)和时间维度插值(Interp.)进行对齐。在16个样本的过拟合训练中,4×下采样技术(我们的4×下)加速了收敛,并实现了最低的最终验证损失,如图9所示。此外,图10显示,与全局缩减基线不同,4×down可以减少伪影并保持精确的运动轨迹。这些结果证实了时空编码器利用时空延迟增强数据编码和提高视频生成性能的能力。

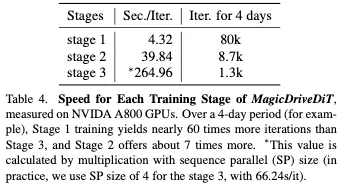

渐进式Bootstrap训练。与直接的第3阶段训练相比,三阶段渐进训练方法显著提高了模型训练效率。表4显示,例如,在4天内,阶段1执行的迭代次数比阶段3多约60倍,阶段2实现的迭代次数多约7倍。渐进式训练对于受控生成模型至关重要,可控生成模型需要大量迭代才能有效收敛。渐进式策略能够快速获得高质量的视频生成能力,在早期阶段利用更快的迭代来增强收敛性和加快学习速度。

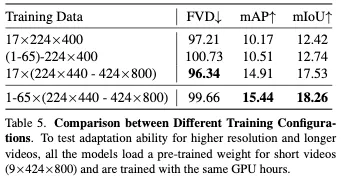

可变长度和分辨率训练。MagicDriveDiT采用了一种混合不同长度和分辨率视频的训练策略。我们的消融研究证明了这一策略的有效性。如表5所示,当仅使用低分辨率视频(17×224×400)时,VAE的局限性是显而易见的,与其他设置相比,FVD较差,mAP和mIoU评分较低。合并较长的视频可以提高模型的可控性(mAP和mIoU都更高),而合并高分辨率视频可以提高整体质量(所有三个指标都得到了显著改善)。

尽管混合不同的帧长度会略微降低FVD,但这对于使模型能够生成各种长度的视频并推断出看不见的长度至关重要(见第6节)。因此,我们结合了分辨率和帧长,有效地平衡了视频质量、可控性和模型功能之间的权衡。

结论和讨论

在这篇论文中,我们介绍了MagicDriveDiT,这是一个具有精确控制的高分辨率和长视频合成的创新框架,专门为自动驾驶等应用量身定制。通过利用DiT架构和流匹配,MagicDriveDiT有效地解决了视频生成中可扩展性和几何控制的挑战。我们的方法引入了新颖的时空条件编码和具有可变长度和分辨率自适应的渐进自举策略,增强了模型的泛化能力。大量实验表明,MagicDriveDiT可以生成保持空间和时间连贯性的逼真视频,在分辨率和帧数方面大大超过了以前的方法。这项工作推进了视频合成,并为自动驾驶中的模拟和其他应用开辟了新的可能性。